spark安装是在之前安装好的hadoop之上进行安装的,之前的hadoop安装地址:Haoop , Spark安装实例教程--Hadoop安装

平台:RHEL6,RHEL6,ubuntu14.04

scala:scala-2.10.4

Spark:spark-1.5.0-bin-hadoop2.6.tar.gz

第一步:

安装,配置Scala路径:

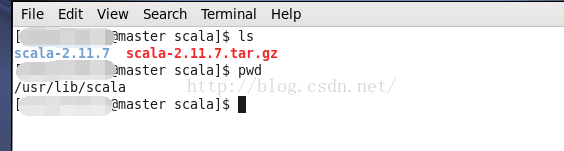

将scala存放在/usr/lib/scala/目录下:

设置环境变量PATH

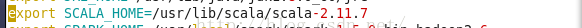

之后在.bashrc中添加环境变量

测试scala是否安装成功:

第二步:安装Spark

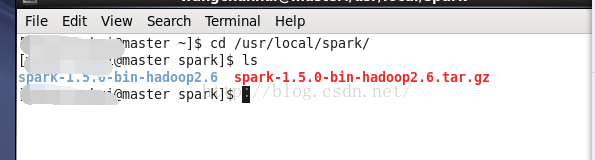

这里统一安装在/usr/local/spark/目录下:

之后配置spark的环境变量:

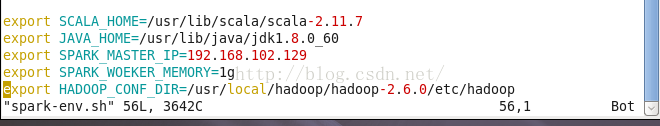

之后修改/usr/local/spark/spark-1.5.0-bin-hadoop2.6/conf目录下的spark-env.sh文件:

增加如下信息:

其中:

HADOOP_CONF_DIR是之前的hadoop的配置

SPARK_WOEKER_MEMORY:工作内存大小

SPARK_MASTER_IP:这是master的IP

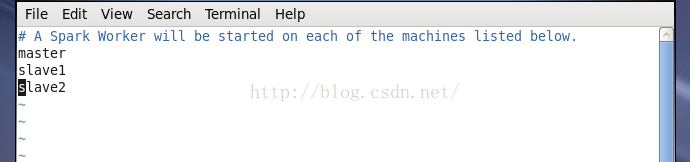

同时还要将同样是这个目录下将slaves.template更改成slaves同时添加:

同时对其他两台机器进行同样的配置。

运行:这里认为已经将三台机器配置了同样的配置

进入sbin目录运行:

之后在浏览器查看是否配置成功:

这样的话就算是配置成功了

839

839

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?