点击上方“Python爬虫与数据挖掘”,进行关注

回复“书籍”即可获赠Python从入门到进阶共10本电子书

今

日

鸡

汤

问客何为来,采山因买斧。

大家好,我是皮皮。

一、前言

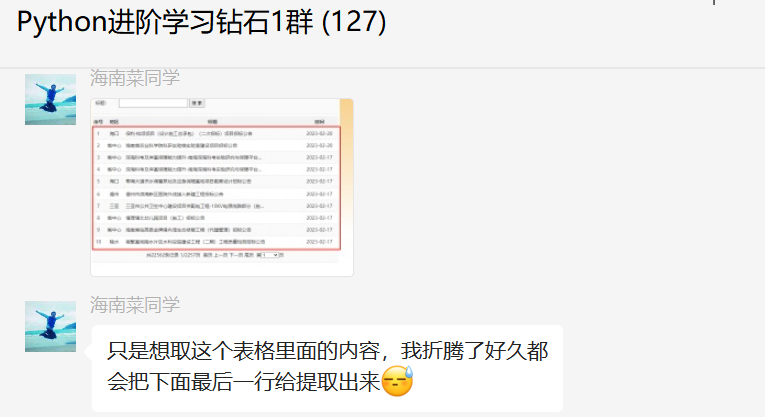

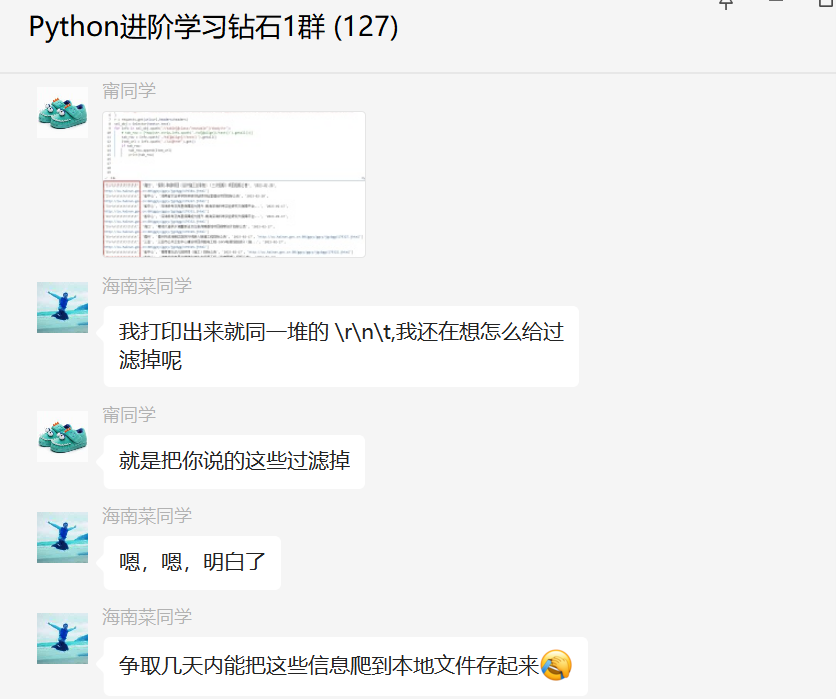

前几天在Python钻石交流群【海南菜同学】问了一个Python网络爬虫的问题,这里拿出来给大家分享下。

下图是他获取到的内容:

下图是他获取到的内容:

其实就是多提取了这一行,提到了这个表格内容后,把下面的页码也一同提取了,然后那个页码很多,就显示一堆无用的信息。

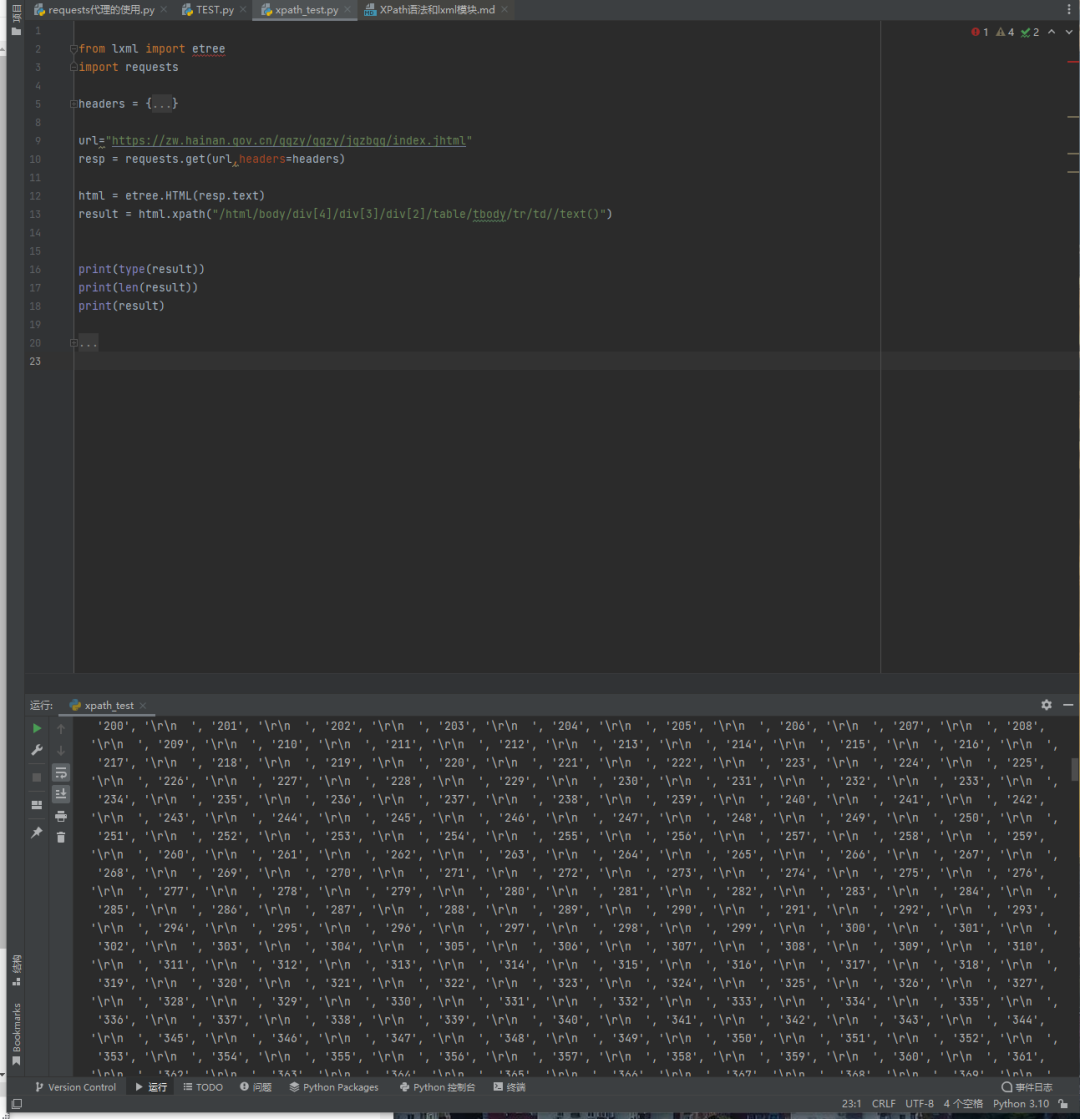

二、实现过程

这里【瑜亮老师】给了一个思路,使用pd.read_html进行提取的,事半功倍,代码如下所示:

import requests

import pandas as pd

url = "https://zw.hainan.gov.cn/ggzy/ggzy/jgzbgg/index.jhtml"

resp = requests.get(url, headers=headers, cookies=cookies)

df = pd.read_html(resp.text)[0]

df.drop([len(df)-1], inplace=True)

print(df)顺利地解决了粉丝的问题:

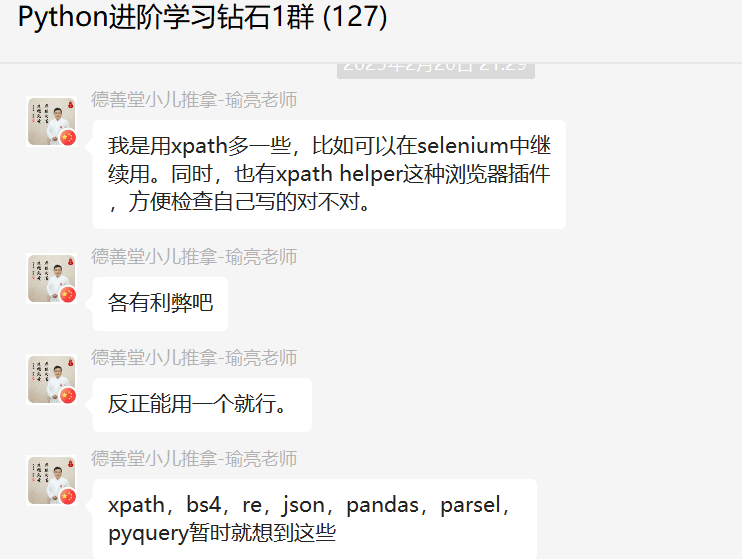

提取网页信息的方法还是挺多的。

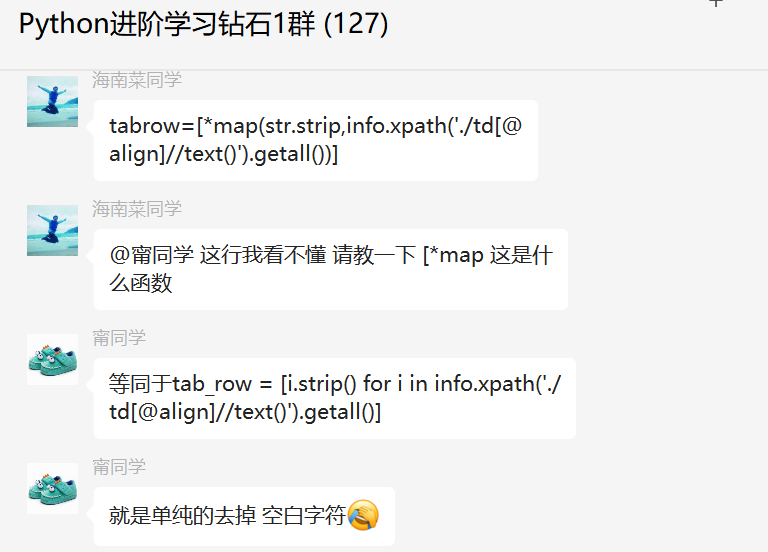

后来【甯同学】也给了一个方法,使用xpath方法解决的,代码如下:

里边有个匿名函数可能不太好理解,这里也给予说明了。

直接在代码中将空白字符、换行符什么的都清除掉了。

后来代码稍微优化了下,健壮性更强了。

三、总结

大家好,我是皮皮。这篇文章主要盘点了一个Python网络爬虫的问题,文中针对该问题,给出了具体的解析和代码实现,帮助粉丝顺利解决了问题。

最后感谢粉丝【海南菜同学】提问,感谢【瑜亮老师】、【甯同学】给出的思路和代码解析,感谢【eric】等人参与学习交流。

大家在学习过程中如果有遇到问题,欢迎随时联系我解决(我的微信:pdcfighting),应粉丝要求,我创建了一些高质量的Python付费学习交流群和付费接单群,欢迎大家加入我的Python学习交流群和接单群!

小伙伴们,快快用实践一下吧!如果在学习过程中,有遇到任何问题,欢迎加我好友,我拉你进Python学习交流群共同探讨学习。

------------------- End -------------------

往期精彩文章推荐:

欢迎大家点赞,留言,转发,转载,感谢大家的相伴与支持

想加入Python学习群请在后台回复【入群】

万水千山总是情,点个【在看】行不行

/今日留言主题/

随便说一两句吧~~

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?