架构师大咖

架构师大咖,打造有价值的架构师交流平台。分享架构师干货、教程、课程、资讯。架构师大咖,每日推送。

公众号

该公众号已被封禁

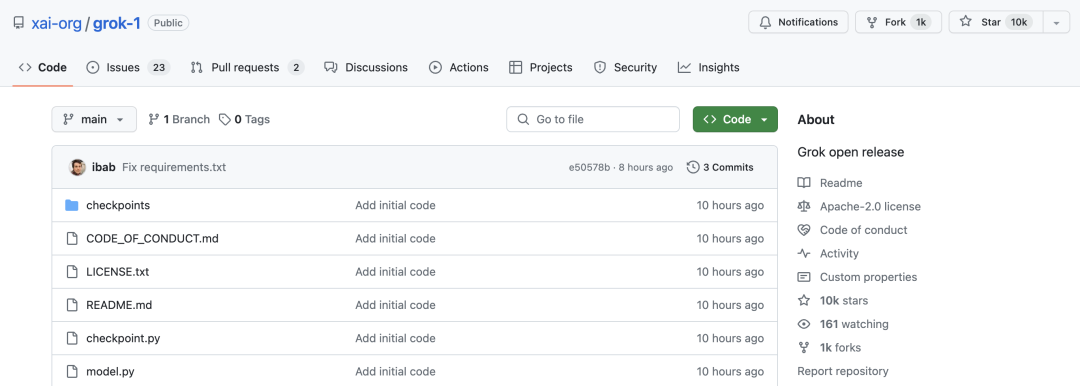

气「OpenAI 不 Open」以至于对其发起诉讼之后,马斯克践行自己自由、开放的原则,在刚刚过去的周末里选择重磅开源自家的 AI 大模型——Grok-1(https://github.com/xai-org/grok-1)。

距离 Grok-1 开源仅过去了 10 个小时,该项目便获得了 10k 的 Star,成为众人关注的焦点所在。

马斯克的 xAI 公司开源 Grok-1,高达 3140 亿参数

这款 Grok 大模型,是马斯克集结 Deepmind、微软、特斯拉、学术界多位大佬于 2023 年 7 月成立的人工智能初创公司 xAI 所带来的成果。

Grok 的设计初衷,灵感来源于英国作家道格拉斯·亚当斯所写的一系列科幻小说《银河系漫游指南》,和 ChatGPT 一样,可以以对话方式回答问题,也能联网,而有所不同的是,Grok 已集成到 X 社交媒体平台中,可以“实时访问”该平台上的所有信息,还可以回答大多数其他 AI 系统拒绝回答的尖锐问题,甚至就如何提问给出建议。

订阅 X 的高级功能用户可以向 Grok 提出问题并收到答复。

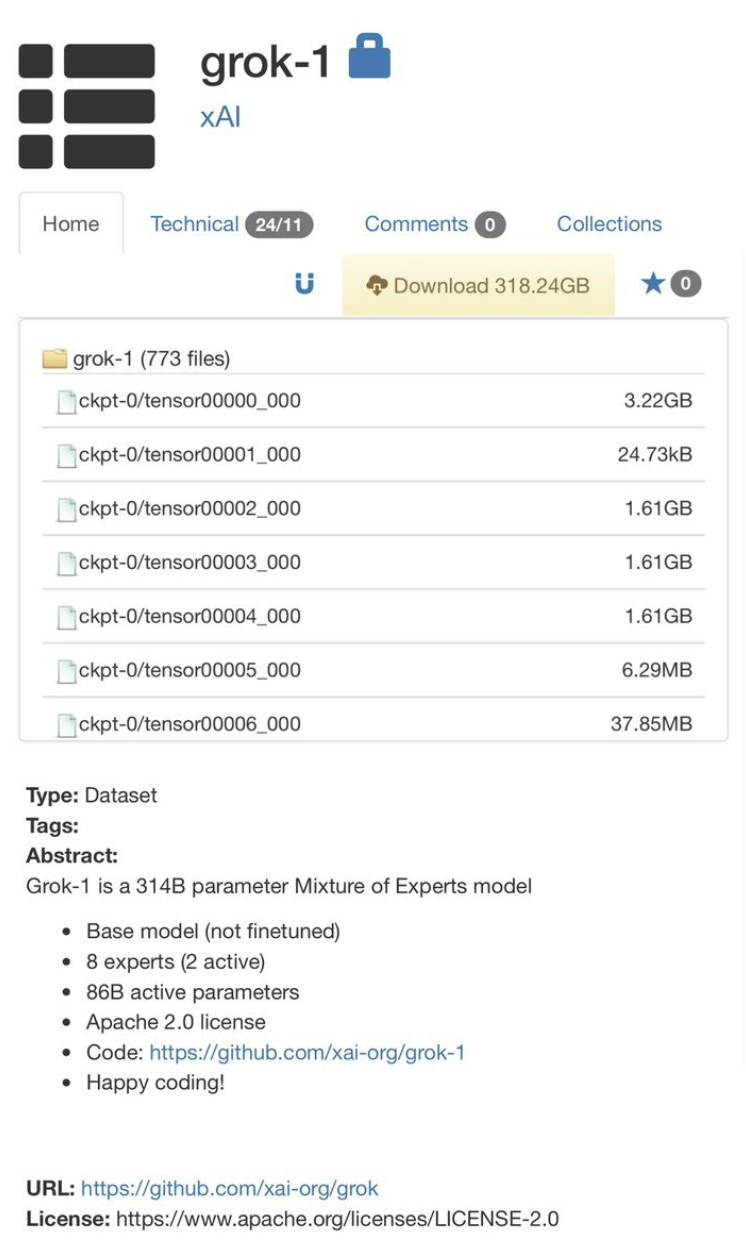

根据 xAI 在其官方博客更新的公告显示,其开源的 Grok-1 是一个由 xAI 从头开始训练的 3140 亿参数混合专家(MoE)模型。

xAI 团队表示,“这是 Grok-1 预训练阶段的原始基础模型检查点,该阶段于 2023 年 10 月结束。这意味着该模型没有针对任何特定应用(例如对话)进行微调。”

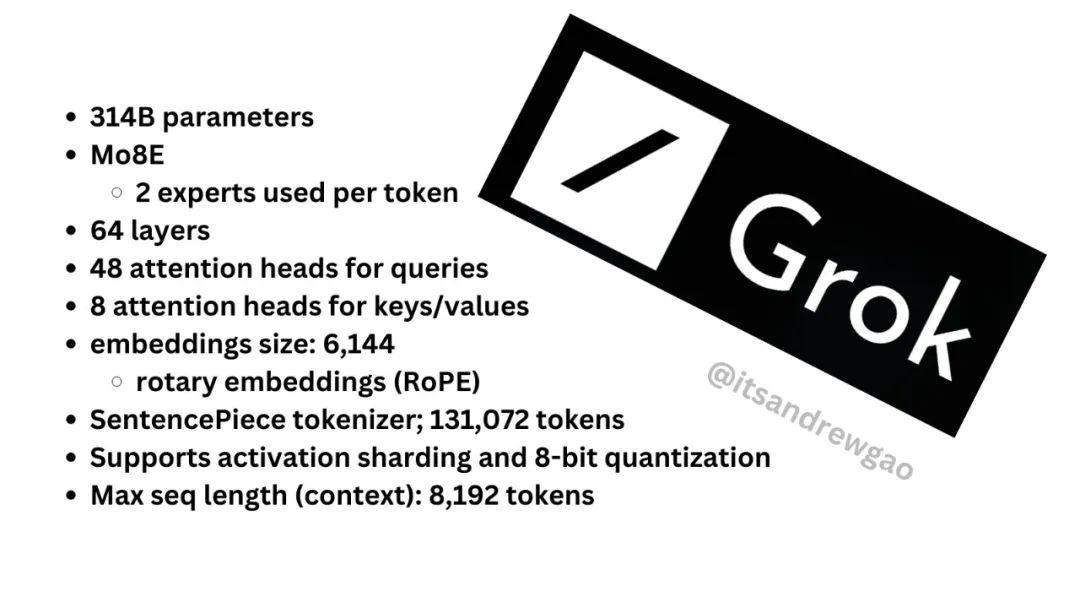

该模型的详细情况:

基于大量文本数据训练的基础模型,未针对任何特定任务进行微调。

314B 参数的混合专家模型, 25% 的权重对给定 token 有效。

xAI 于 2023 年 10 月在 JAX 和 Rust 上使用自定义训练堆栈从头开始训练。

同时 Grok-1 是在 Apache 2.0 许可证下发布权重和架构。

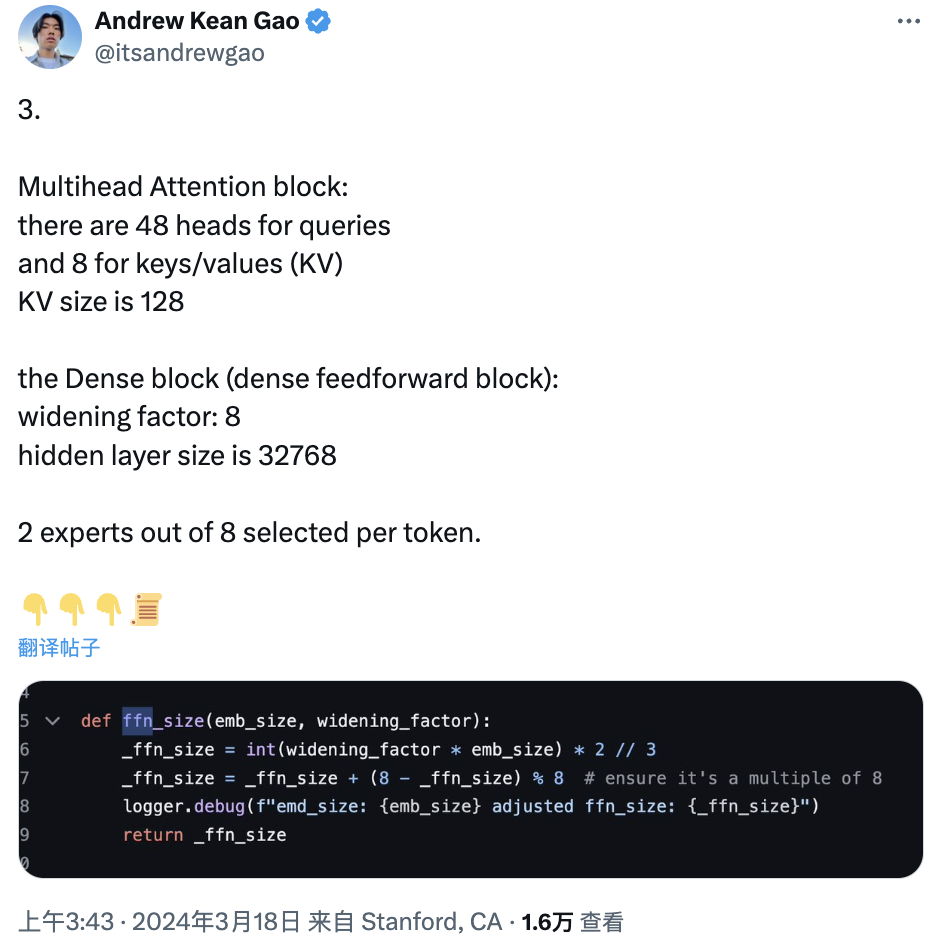

值此,在 X 平台上,来自 LangChainAI 的工程师 Andrew Kean Gao 还对 Grok 架构进一步地展开深入分析。

他说道,“我刚刚浏览了 http://model.py ,对于这个 314B 开源的庞然大物,竟然没有附加任何条件。”

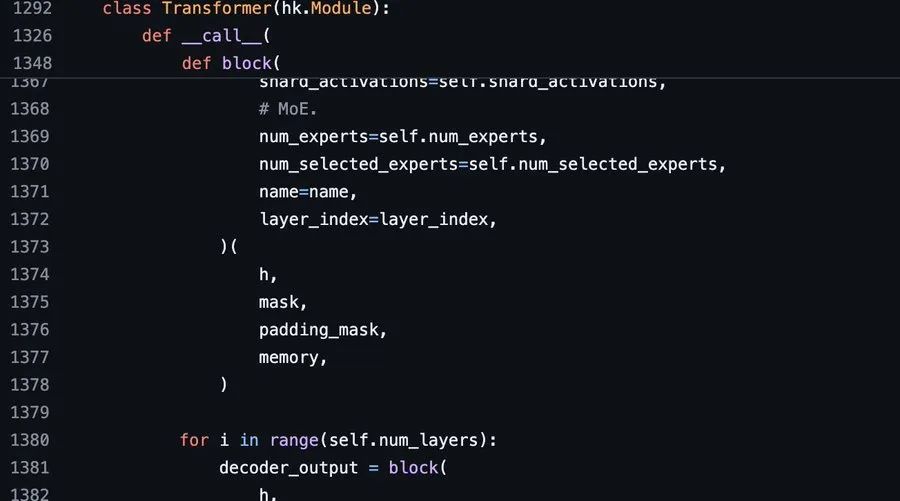

详细来看,Grok-1 是一个 314 B 的 Mixture-of-Experts(MoE)模型(8 个专家 2 个是活跃的),860 亿的激活参数,这比 Llama-2 的 70B 参数还要多。

此外,Grok-1 使用的旋转位置嵌入(RoPE)而非固定位置嵌入。

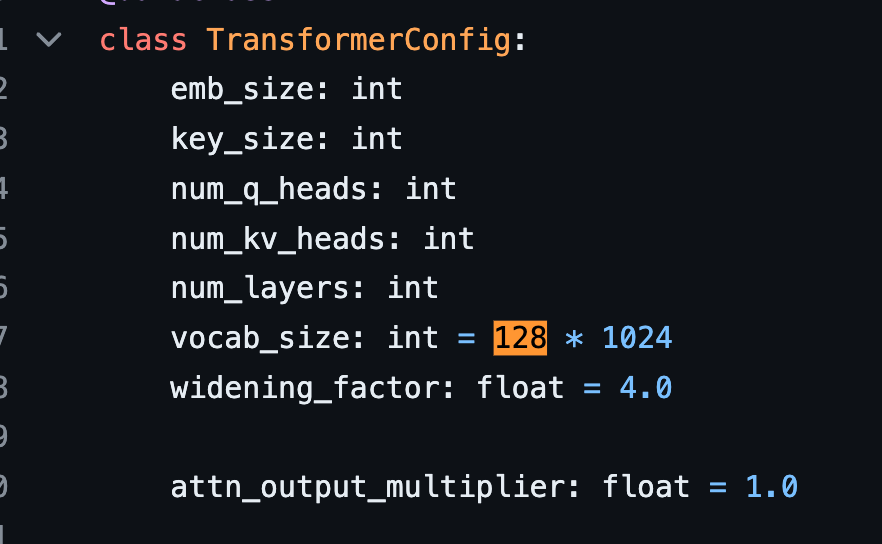

再者,Grok-1 tokenizer 词汇大小为 131,072(与 GPT-4 类似) 2^17,嵌入大小为 6,144(48*128);64 个 Transformer 层,每层都有一个解码器层:多头注意力块和密集块,键值大小 128。

其中,多头注意模块有 48 个 head 和 8 个键/值 (KV),KV 大小为 128。

密集块(密集前馈块):加宽因子为 8,隐藏层大小为 32768。

每个 token 从 8 个专家中选出 2 个。

旋转位置嵌入大小为 6144,这是有道理的,因为它与模型的输入嵌入大小相同。

上下文长度:8,192 个词块

精度 bf16

Grok-1 的性能

关于 Grok-1 的详细细节,此前 CSDN 也曾报道过。

根据官方公告显示,为 Grok 提供动力的引擎 Grok-1,是在数万个 GPU 集群(外媒 Techcrunch 透露,可能是由 Oracle 提供的)上花了几个月时间开发的,训练数据来自网络(截至 2023 第三季度)和人类助手的反馈,xAI 将其称之为“AI 导师”。

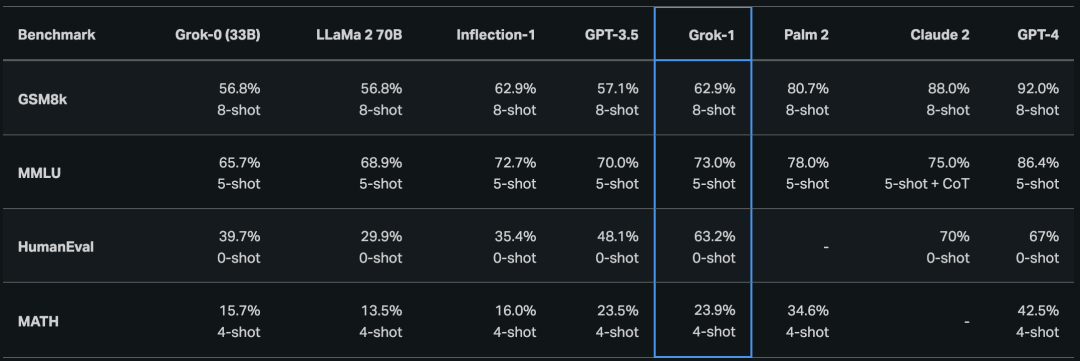

在 Grok-1 之前,xAI 公司也训练了一个具有 330 亿个参数的原型 LLM (Grok-0)。这个早期模型在标准 LM 基准测试上接近 LLaMA 2 (70B) 功能,但只使用了一半的训练资源。之后,xAI 团队在推理和编码能力方面取得了重大改进,最终推出了 Grok-1,这是一种功能更强大的最先进的语言模型,在 HumanEval 编码任务中实现了 63.2%,在 MMLU 上实现了 73%。

为了验证 Grok-1 的能力,xAI 团队使用了一些衡量数学和推理能力的标准机器学习基准进行了一系列评估。

根据测试结果显示,Grok-1 目前处于中等水平,超过了 GPT-3.5、LLaMA 2 70B,但是距离 Claude 2、GPT-4 等大模型还有一定的距离。

使用指南

当前,Grok-1 面向所有人开放,而要开始使用该模型,可以先确保下载 checkpoint 并将 ckpt-0 目录放入 checkpoint。然后,运行:

pip install -r requirements.txtpython run.py

进而测试代码。

脚本在测试输入上加载检查点和模型样本。

值得注意的事,Grok-1 参数量高达 314B 个参数,其模型体积庞大,需要配备足够 GPU 内存的机器才能使用示例代码测试模型。

xAI 团队在 GitHub 项目仓库里面也直言道:该资源库中 MoE 层的实现并不高效。选择这种实现方式是为了避免需要定制内核来验证模型的正确性。

你可以使用 torrent 客户端和下面磁铁链接下载权重:

magnet:?xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210e&tr=https%3A%2F%2Facademictorrents.com%2Fannounce.php&tr=udp%3A%2F%2Ftracker.coppersurfer.tk%3A6969&tr=udp%3A%2F%2Ftracker.opentrackr.org%3A1337%2Fannounce

详细使用指南也可以通过 GitHub 项目地址:github.com/xai-org/grok 进行速览。

开源 or 闭源

一直以来,关于究竟是该构建开源还是闭源的大模型,业界存有巨大的争议。对于 OpenAI 等公司而言,如今的 AI 存在不少未可知的风险,开源有可能造成技术被滥用,所以闭源似乎优于开源。

但是在马斯克等人看来,通过开放代码让所有人有权查看和使用有助于使技术更加安全。所以在此次开源 Grok 之际,马斯克还暗讽了 ChatGPT,希望让其“告诉我们更多有关 OpenAI 开放部分的信息....”

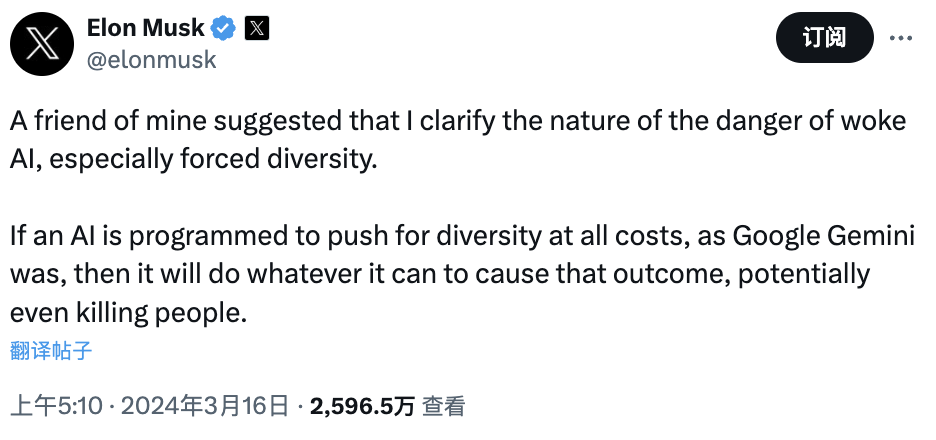

马斯克认为,任何话题都不应该成为聊天机器人的禁区。不过,他也警醒道:

“我的一位朋友提醒我澄清清醒人工智能的危险性质,尤其是强制多样性。

如果一个人工智能被设定为不惜一切代价推动多元化,就像 Google Gemini 那样,那么它就会不择手段地造成这种结果,甚至有可能杀人。”

亚利桑那州立大学计算机科学教授 Subbarao Kambhampati 同样认为,开源当今的人工智能技术是最安全的方法。

不过,也有不少用户担心马斯克只是做了初步开源 Grok-1 的计划,就没有后续跟进,毕竟他此前对 X 的推荐算法也做了开源,但只是开源之后就似乎没有更新过。

针对这一担忧,马斯克也现身回应有关开源 X 推荐算法时说道,“还有很多工作要做,但这个平台已经是迄今为止最透明、最求真的平台(说实话,门槛并不高)”。

不管怎样,马斯克成立的 xAI 公司仅仅用了 8 个月不仅创建了 Grok,还将 Grok-1 开源出来,其行动速度远超乎众人的想象,甚至 OpenAI 的员工也表达了他们对 Grok 的强烈兴趣。

而 Grok 的发布可能会给所有其他 LLM 提供商(尤其是其他竞争对手的开源提供商)带来不小的压力,但有竞争才有进步,对于普通用户而言,也是一件好事。

正如英伟达科学家 Jim Fan 评价道:「有史以来最大的开放 LLM,由世界级团队训练;通过磁力链接发布;Apache 2.0;314B;专家混合(8 个活跃中的 2 个)。就连激活参数仅(86B)就超过了最大的 Llama。迫不及待地想看到基准测试结果以及人们用它构建的内容。」

来源:

Grok 开源地址:https://github.com/xai-org/grok-1

官方博客公告:https://x.ai/blog/grok-os

https://x.ai/blog/grok

Python入门到精通

Python入门到精通:人生苦短,我用Python!Python每日推送、Python教程、Python资料、Python视频、Python项目、Python学习等。

公众号

该公众号已被封禁

101

101

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?