知识图谱(KGs)作为语义网络,在管理不同领域复杂互联数据方面表现出极高的有效性,通过提供统一、上下文化和结构化的表示,具有灵活性,能够轻松适应不断发展的知识。在处理复杂的人力资源(HR)数据时,知识图谱可以帮助实现不同的人力资源功能,如招聘、职位匹配、识别学习差距和增强员工留存。尽管其潜力巨大,但在实施实际的人力资源知识图谱方面的努力有限。本研究通过提出一个框架,旨在有效地从文档中利用大型语言模型开发人力资源知识图谱,从而填补这一空白。生成的知识图谱可用于多种下游任务,包括职位匹配、识别员工技能差距等。在本研究中,我们展示了人力资源知识图谱在精确职位匹配中的重要作用,为雇主和员工带来了优势。来自知识图谱和图神经网络的信息传播实验的实证证据,以及案例研究,强调了知识图谱在职位和员工推荐、职位领域分类等任务中的有效性。代码和数据可在以下链接获取:https://github.com/azminewasi/HRGraph

1 引言

知识图谱(KG)是一个存储现实世界实体及其关系的语义网络。它使用表示对象、地点或个人的节点,通过定义关系的边连接这些节点。它可以整合多样化的数据,通过链接和语义元数据对信息进行上下文化,并保持灵活性,能够无缝适应动态知识的变化。

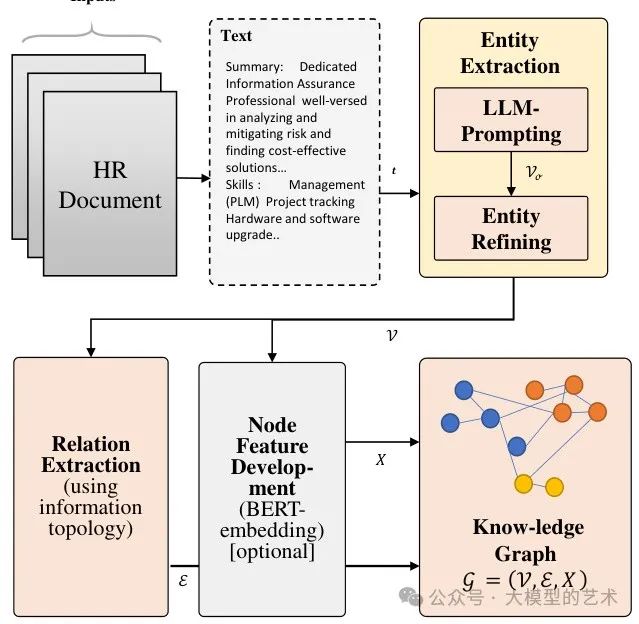

图1:我们HRGraph的整体框架。它涉及将从HR文档中提取的文本数据通过大型语言模型(LLM)传递,以获取实体和实体类型,这些实体和类型用于构建一个基础知识图谱,并可选地使用BERT嵌入作为节点特征。

图1:我们HRGraph的整体框架。它涉及将从HR文档中提取的文本数据通过大型语言模型(LLM)传递,以获取实体和实体类型,这些实体和类型用于构建一个基础知识图谱,并可选地使用BERT嵌入作为节点特征。

知识图谱在管理HR数据方面可以非常有效,将多种来源整合成统一的结构化表示。这对于招聘和职业路径规划等应用至关重要。通过将数据与语义元数据链接,知识图谱可以防止误解,特别是在员工技能映射和发展方面。它们的灵活性使得在各种HR职能中轻松适应新数据和需求成为可能。知识图谱提高了招聘的精准度、技能和职业映射,优化了招聘流程,识别学习差距,改善留任策略,并促进组织知识共享。对于员工而言,知识图谱提供了更好的职位搜索和推荐,从他们的角度提供了强有力的支持。

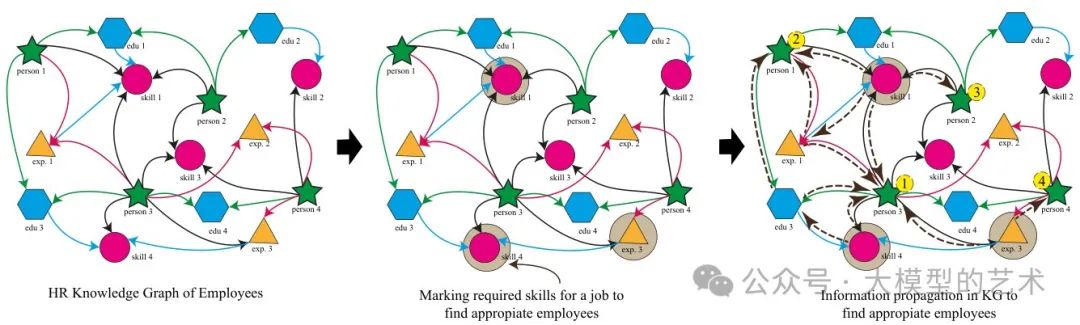

在本研究中,我们介绍了一个名为HRGraph的框架,旨在从各种HR文档(如职位描述(JD)和简历(CV))构建HR知识图谱。我们通过两个实际示例作为下游任务来说明该框架的实用性:使用HR知识图谱进行员工和职位推荐。我们的方法采用大型语言模型(LLM)来识别和提取多样化的实体,然后使用预训练的BERT提取节点特征,形成知识图谱,并进行一些后处理。生成的知识图谱可以用于不同的下游任务。在这项工作中,我们将其用于有效的职位匹配和分类,以满足雇主和员工的需求。其基本思想是公司JD和员工CV或个人资料应共享匹配的实体,如技能、经验和教育(提案的示意图见图2),以便在求职和员工搜索场景中促进全面和准确的职位匹配。

图2:使用HR知识图谱进行职位匹配和推荐框架的概述。利用公司JD和员工简历或个人资料应共享匹配实体(如技能、经验和教育)的直觉,我们可以从知识图谱中匹配、查找和推荐员工。另一方面,利用包含多种职位描述的知识图谱,我们可以使用求职者的技能、教育和其他因素来找到合适的职位进行推荐。

图2:使用HR知识图谱进行职位匹配和推荐框架的概述。利用公司JD和员工简历或个人资料应共享匹配实体(如技能、经验和教育)的直觉,我们可以从知识图谱中匹配、查找和推荐员工。另一方面,利用包含多种职位描述的知识图谱,我们可以使用求职者的技能、教育和其他因素来找到合适的职位进行推荐。

2 相关工作

2.1 知识图谱的应用

知识图谱展示了其多功能性,在语义搜索、问答系统和推荐系统等应用中表现出色。它们的结构化表示增强了搜索引擎的结果并定制了建议。知识图谱在自然语言处理(NLP)中至关重要,提升了信息提取能力,并有助于更优的机器学习预测。从企业知识管理到生物医学研究,知识图谱展现了适应性。它们整合了多样化的数据、上下文化以及固有的灵活性,支撑了在医疗人工智能、无线通信网络、搜索引擎和大数据决策分析等不同领域中管理和提取洞察的有效性。知识图谱作为不可或缺的工具,能够无缝导航动态信息环境。我们的工作受到这些知识图谱不同应用的启发。

2.2 HR数据与知识图谱

尽管人力资源知识图谱具有良好的潜力,但在这一领域的努力有限。张等人采用自上而下的方法创建人力资源知识图谱的本体模型。该论文描述了最初建立本体的重要性,并定义了人力资源知识图谱中的实体和关系。崔提出了一个假设,旨在利用基于自然语言处理的语义实体提取构建职位描述知识图谱,但未提供详细的方法或实验。王等人提出了一种基于知识图谱的职位推荐算法,利用词语相似性来寻找推荐。Upadhyay等人使用基于命名实体识别的方法构建知识图谱,以帮助职位推荐。然而,尚未在基于大语言模型的实际场景中实施可触及的人力资源知识图谱,并利用一个图谱进行多个下游任务。

3 方法论

最近在大型语言模型(LLMs)、基于知识图谱的系统和图神经网络(GNNs)方面的发展为所提出的方法论提供了灵感。HR知识图谱利用大型语言模型(LLMs)进行实体提取,并使用预训练的自然语言处理模型来获取节点特征,从而通过利用先进的语言理解能力实现对HR数据的复杂表示。现有文献提出了其他方法,例如基于词相似度的职位推荐和命名实体识别(NER)来构建知识图谱。我们提出的方法通过利用LLMs进行实体提取,并使用BERT进行特征提取(长度为256),提供了一种灵活且全面的方法,解决了实际挑战并支持多种下游任务。

实体提取与精炼。我们首先处理职位描述(JD)或简历(CV)作为HR文档文本 ,使用大型语言模型Gemini。提示信息见B节。这一步骤的结果是从文本中提取出各种实体 ,捕捉实体和关系。随后,我们对实体集 进行后处理,以过滤掉潜在的噪声(例如,知识图谱节点包含超过3个单词或没有命名实体或动词),最终得到一个精炼的实体集 。

关系提取。为了建立这些实体之间的初始连接,我们利用信息拓扑和类型,创建初始连接集 。

节点特征提取。通过使用预训练的BERT模型,我们为每个实体生成特征向量,构建初始特征矩阵 。因此, 表示节点(实体)集合 ,而 包含边(关系)集合 ,其中 和 分别表示节点和边的数量。

知识图谱构建。结合 和 形成我们的知识图谱(KG),记作 。相应的邻接矩阵 的元素 ,如果一条边连接 和 。

每个节点 和每条边 都有相关的映射函数,记作 : 和 。这里, 表示边类型集合,A 是节点类型集合,其中 。如果我们选择使用知识图谱嵌入(KGE),特征向量 可以被排除,节点嵌入可以通过包含拓扑和结构知识的不同KGE模型获得。

4 知识图谱实验

我们从在线招聘门户收集了 和 200 个职位描述,确保简历中包含的个人信息最少,并经过人工审核以保护隐私。职位描述中公开可用的公司信息被保留。然后,数据在招聘门户的过滤器帮助下进行了手动标记,以便进行后续实验。任何类型的个人可识别信息(PII),如姓名、详细地址、电子邮件地址、手机号码等,均经过彻底检查并删除。

该数据集包括针对这些职位的 20 个类别的工作和简历。这些类别包括:信息技术、业务发展、金融、律师、会计、工程、厨师、航空、健身、销售、银行、医疗保健、顾问、建筑、公共关系、人力资源、设计师、艺术、教师、服装。在简历中,每个类别有 10 个,但在职位描述中,IT 和工程类的职位数量更多。

提示在 B 节中提供。虽然核心设计保持不变,但简历和职位描述的提示略有不同,各自针对其特定的模态进行了调整。完整的推理代码和示例可在 GitHub 仓库中找到。

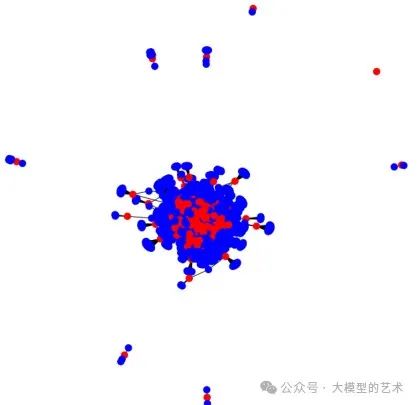

图3:我们的简历知识图谱。绿色点表示个人(简历),蓝色点表示技能、教育和其他实体

图3:我们的简历知识图谱。绿色点表示个人(简历),蓝色点表示技能、教育和其他实体

4.1 可视化知识图谱

利用Gemini工具,我们系统地收集了数据,并构建了两个知识图谱,分别用于简历(CV)和职位描述(JD),作为人力资源知识库,遵循了定义的方法论。为了确保相关性,排除了长度超过4的实体。这些知识图谱(如图3和图4所示)表明,不同工作之间以及所需的技能、教育和经验之间存在巨大的联系。通过利用这些关系,可以完成许多下游任务。

图4:我们的职位描述知识图谱。红点代表职位,蓝点代表技能、教育和其他实体。

图4:我们的职位描述知识图谱。红点代表职位,蓝点代表技能、教育和其他实体。

5 下游任务

5.1 HRGraph上的信息传播

图2提供了我们利用HR知识图谱为求职者或员工提供职位匹配和推荐框架的概述。通过利用职位描述图,我们识别出匹配的技能、教育和经验节点,形成一个包含3跳邻居节点的目标子图。该子图中的节点中心性使我们能够高效地找到并排名所有相关的职位节点。

5.2 任务 01:推荐

信息传播框架预测每个个体的前 个排名职位,使我们能够评估预测的准确性和精确性,从而优化职位推荐。同样,在上述任务中,我们扩展了职位推荐的方法,利用简历知识图谱根据匹配的技能、教育和经验识别员工。 表示随机推荐, 表示直接使用 LLM 实体进行前 5 个推荐的职位推荐。表 1 显示知识图谱信息传播和排名可以提供非常强的推荐,并且具有良好的准确性。案例研究见附录 A。

5.3 任务 02:职位领域分类

在此任务中,我们使用基于知识图谱的职位领域分类,采用两种基本的流行图神经网络(GNN):GCN 和 GAT。我们将结果与传统和常用的深度学习模型进行了比较。表 2 显示,基于知识图谱的 GNN 模型的效果与其他模型相当,且略有优势。更多细节请参见附录 A。

6 讨论

我们相信,将人力资源数据转化为知识图谱在塑造人力资源数据收集、管理和利用的未来方面具有巨大的潜力。通过将人力资源数据设想为这个互联的图谱,组织可以解锁前所未有的洞察,简化招聘流程,识别人才缺口,并促进员工成长。这种方法不仅增强了决策能力,还为一个动态和适应性强的人力资源生态系统铺平了道路,从而推动组织在不断变化的环境中的成功。

7 结论

本研究提出了一个框架,利用大规模语言模型(LLMs)和图神经网络(GNNs)从文档中构建人力资源知识图谱,作为不同人力资源任务的知识基础。所生成的知识图谱增强了多种人力资源功能,包括职位匹配、职位领域分类等,通过实证证据展示了其有效性,惠及雇主和员工。

限制

该框架的主要限制在于其对大型语言模型(LLMs)的依赖,尽管这些模型功能强大,但可能不可靠且容易产生幻觉。鉴于我们的模型完全依赖LLMs进行实体提取,我们观察到它们在某些情况下偏离了提供的指令。此外,可以设计一个更复杂的职位匹配算法。未来可以对此进行进一步研究。

伦理考虑

在进行本研究时,严格遵循伦理指南,以确保使用数据的个人的隐私和机密性。主要关注点是以极大的谨慎处理个人可识别信息(PII),以保护所有个人的身份和隐私。

数据匿名化。为了保护隐私,所有个人可识别信息,如姓名、详细地址、电子邮件地址和手机号码,均被仔细识别并从数据集中移除。此过程涉及彻底检查,以确保没有可追踪的信息留下,可能识别任何个人。

同意和许可。原始数据集是在获得适当许可并遵守相关数据使用协议的情况下访问的。通过遵守这些协议,我们确保数据在其预期目的范围内使用,尊重数据收集时的条件。

隐私保护。在本研究中,所使用的数据集是从现有的简历集合中整理而来,确保所有个人可识别信息(PII)被仔细移除,以维护隐私并遵循伦理指南。原始数据源是在获得适当许可的情况下访问的,并应用了严格的匿名化技术,以消除任何身份痕迹。

安全数据处理。在数据整理和分析过程中,实施了安全的数据处理实践。这包括使用加密存储解决方案,并限制对数据的访问,仅限于那些需要进行特定研究任务的团队成员。这些措施对于防止未经授权的访问和潜在的数据泄露至关重要。

数据的伦理使用。研究团队致力于以伦理方式使用数据,确保分析和解释公正且不偏不倚。数据仅用于本研究的目的,而不用于任何商业或剥削性活动。此外,研究结果以保护数据集中个人匿名性的方式进行报告。

透明性和问责制。在整个研究过程中,保持了方法的透明性和过程的问责制。详细记录了我们的数据处理和匿名化程序,确保采取的保护隐私的步骤可以在必要时由外部方进行审查和验证。

实验细节

A.1 实施细节

TF-IDF 向量化器:该模型采用了一个 n-gram 范围为 1 到 5 的 TF-IDF 向量化器,以捕捉多样的词组合,并将最大特征限制设置为计算得出的词汇大小。词汇大小的确定为数据的均值加上三倍的标准差,以确保相关术语的全面表示。此外,排除了英语停用词,以便在向量化过程中专注于有意义的内容。

传统模型:在从 TF-IDF 向量化器获取向量后,我们使用不同的方法进行分类。LogR 代表逻辑回归,DecT 代表决策树, 代表随机森林,GBC 代表梯度提升分类器。逻辑回归采用 L1 正则化,使用 ‘liblinear’ 求解器。决策树分类器的最大深度限制为 5。随机森林分类器由 50 棵决策树组成,并使用固定的随机状态以确保可重复性。梯度提升分类器结合了 50 个弱学习者的集成。

MLP:MLP 模型是一个简单的前馈神经网络,具有多个隐藏层,包括每层的 dropout 正则化。它由完全连接的层组成,维度从 2048 逐层减半到 64,所有层均使用 ReLU 激活函数。输出层采用 softmax 激活函数进行多类分类。

Transformer:该 transformer 模型与 AutoML 和 Hugging Face Transformers 库集成,利用 AutoTokenizer 对文本数据进行预处理。使用 Auto Model For Sequence-Classification 类,并配置 distilbert-base-uncased 模型,以处理与训练数据中的类对应的多个唯一标签的序列分类任务。

基于图神经网络的模型:使用的 GCN 和 GAT 模型均为 Pytorch Geometric 库中的默认模型,具有 64 个隐藏通道和 4 层。微调 GNN 将改善结果。

A.2 案例研究

在简历编号92中,这是一个销售人员的简历。它与职位描述图中的匹配实体包括:’会计’,’管理’,’Excel’,’办公室’,’外观’,’Microsoft Word’,’政策’,’销售’,’SAP’,’时间管理’。前五个匹配的职位描述是:150, 84, 103, 123, 163。它们的标签分别是会计、销售、销售、金融、销售。虽然该个人的主要专长在于销售,但“会计”技能的包含促使推荐了会计职位。其他技能如“管理”、“Excel”和“政策”也为金融行业的建议做出了贡献。这例证了知识图谱提供细致推荐解释的能力,提供了影响职位建议的多样因素的见解。这对于求职者进行职业转型非常有效。

如果信息是职位描述,请使用以下提示:

您是一位实体提取专家,可以从文本中识别和提取不同类型的实体。以下是职位描述中的一些信息。您的任务是查找并列出所有信息实体,如教育(学位要求)、技能(职位所需技能)、资格(技能)、经验(动词和名词)以及任何其他对职位重要的有用标记,并将它们以列表形式分享,其中实体用逗号分隔。不要写其他内容。仅以字典(JSON)形式列出小实体,实体之间用逗号分隔。每个实体只能包含1-2个单词。

<插入职位描述文本在这里>

这是预期输出的示例:

“教育”: [“ABC大学”, “CGPA 3.00”, “计算机科学与工程”, “学士学位”], “技能”: [“C”, “Python”, “R”, “机器学习”, “沟通”, “团队合作”], “经验”: “ABX信息技术”: [“团队管理”, “助理经理”], “技术”: [“经理”, “高级工程师”, “AWS”]

B 提示

如果信息是简历,请使用以下提示:

您是一位实体提取专家,可以从文本中识别和提取不同类型的实体。以下是一些来自简历的信息。您的任务是查找并列出所有信息实体,如教育(学位、成绩、学校名称)、技能(个人拥有的技能)、资格(技能)、经验(动词和名词)以及任何其他对工作重要的有用标记,并以列表形式分享它们,实体之间用逗号分隔。不要写其他内容。仅在字典(JSON)中以逗号分隔的小实体。每个实体只能包含1-2个词。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

1048

1048

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?