前言

嗨喽~大家好呀,这里是魔王呐 !

环境介绍:

-

python 3.6

-

pycharm

爬虫部分使用模块:

-

csv

-

requests >>> pip install requests

-

parsel

如何安装python第三方模块:

- win + R 输入 cmd 点击确定, 输入安装命令 pip install 模块名 (pip install requests) 回车

- 在pycharm中点击Terminal(终端) 输入安装命令

数据可视化使用模块:

-

pyecharts

-

pandas

本节课程的案例流程思路:

一. 网站数据来源查询:

-

确定一下目标需求: 爬取猫咪交易网站数据 做一个数据可视化图

-

去网站 : 地区 …

-

如果想要在网页上抓包 找一些数据来源 都是要通过开发者工具 F12/ 鼠标右键点击检查

- 可以直接复制想要数据内容在开发者工具进行搜索

二. 代码实现步骤

-

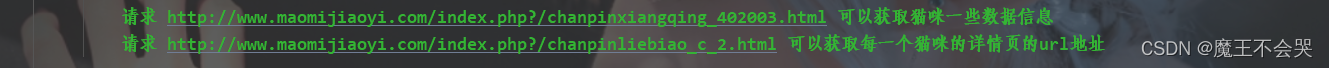

请求 http://www.maomijiaoyi.com/index.php?/chanpinliebiao_c_2.html 获取 猫咪的详情页url地址以及地区

-

请求 猫咪的详情页url地址 获取猫咪详情信息数据

-

保存数据 到CSV文件

-

数据可视化

采集代码

获取源码链接点击

import requests # 第三方模块 需要 pip install requests 发送请求

import parsel # 解析模块 pip install parsel

import csv # 内置模块 不需要大家安装

f = open('猫咪.csv', mode='a', encoding='utf-8', newline='')

csv_writer = csv.DictWriter(f, fieldnames=['地区', '店名', '标题', '价格', '浏览次数', '卖家承诺', '在售只数',

'年龄', '品种', '预防', '联系人', '联系方式', '异地运费', '是否纯种',

'猫咪性别', '驱虫情况', '能否视频', '详情页'])

# 写入表头

csv_writer.writeheader()

for page in range(1, 21):

print(f'===========================正在爬取第{

page}页的数据内容==================================')

请求头: 把python代码伪装成 浏览器对服务器发送请求

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.114 Safari/537.36'

}

response = requests.get(url=url, headers=headers)

获取网页的文本数据 response.text json() 获取json字典数据

# print(response.text)

# 解析数据 获取 猫咪的详情页url地址以及地区

# 要把 网页文本数据转换成 parsel 解析的 对象

selector = parsel.Selector(response.text)

href = selector.css('div.content:nth-child(1) a::attr(href)').getall()

areas = selector.css('div.content:nth-child(1) .area .color_333::text').getall()

# 列表推导式

areas = [i.strip() for i in areas]

# 需要把两个列表合成一个列表 遍历循环提取每一个元素

zip_data = zip(href, areas)

for index in zip_data:

css选择器: 根据标签提取数据内容

getall() 返回的是列表

get() 是返回的字符串

response_1 = requests.get(url=index_url, headers=headers)

selector_1 = parsel.Selector(response_1.text)

area = index[1]

# get() 取一个 返回是字符串 strip() 字符串的方法

title = selector_1.css('.detail_text .title::text').get().strip() # 标题

shop = selector_1.css('.dinming::text').get().strip() # 店名

price = selector_1.css('.info1 div:nth-child(1) span.red.size_24::text').get() # 价格

views = selector_1.css('.info1 div:nth-child(1) span:nth-child(4)::text').get() # 浏览次数

# replace() 替换

promise = selector_1.css('.info1 div:nth-child(2) span::text').get().replace('卖家承诺: ', '') # 浏览次数

num

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?