背景

随着电子商务的发展,历史最终选择了三足鼎立的格局去稳定市场,产生了传统电子商务三强:阿里,京东,苏宁易购(阿里,京东日均PV早已是亿级别以上,苏宁易购日均PV也至少应该五千万级左右)。显然这些数据中蕴藏着无情无尽的财富,如何利用这些数据便是当下大数据开发工程师们首先需要解决的问题~既然有大数据,那必然会牵扯到集群数据的迁移,同步等类ETL工作。本文主要介绍博主最近一周实现的利用spark同步关系型数据库数据至HDFS,并实现配置化。

场景

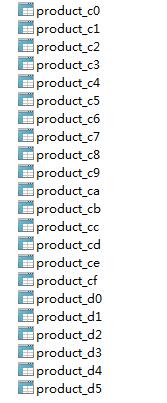

电子商务网站对商品库存,价格等核心指标必然会采用分库分表的策略去存储,大体上都是通过itemcode取模进行存储。

例:

product是表头,十六进制0~f循环

配置文件设置

<table>

<name>product</name>

<isAble>2</isAble>

<partitions>15</partitions>

<fileds>*</fileds>

<relyOn></relyOn>

<datasources username="test"

passwd="test"

url="jdbc:mysql://test:3388/prodb01"

prefix="0,1,2,3"

suffix="0,1,2,3,4,5,6,7,8,9,a,b,c,d,e,f"

prdeicates="istate = 1"

driver="com.mysql.jdbc.Driver"/>

<datasources username="test"

passwd="test"

url="jdbc:mysql://test

本文介绍了如何使用Spark进行大数据同步,从关系型数据库到HDFS,涉及配置文件设置、动态读取数据库、分区策略以及输出文件格式。讨论了在处理分库分表策略下的数据同步问题,特别是应对A/B表策略时的挑战,强调了DB承载能力和Spark读写线程数的平衡。此解决方案适用于大部分日常需求,可作为进一步复杂业务场景的基础。

本文介绍了如何使用Spark进行大数据同步,从关系型数据库到HDFS,涉及配置文件设置、动态读取数据库、分区策略以及输出文件格式。讨论了在处理分库分表策略下的数据同步问题,特别是应对A/B表策略时的挑战,强调了DB承载能力和Spark读写线程数的平衡。此解决方案适用于大部分日常需求,可作为进一步复杂业务场景的基础。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

8656

8656

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?