对于经常用windows不想直接用ubuntu的同学来说,有福啦!!!

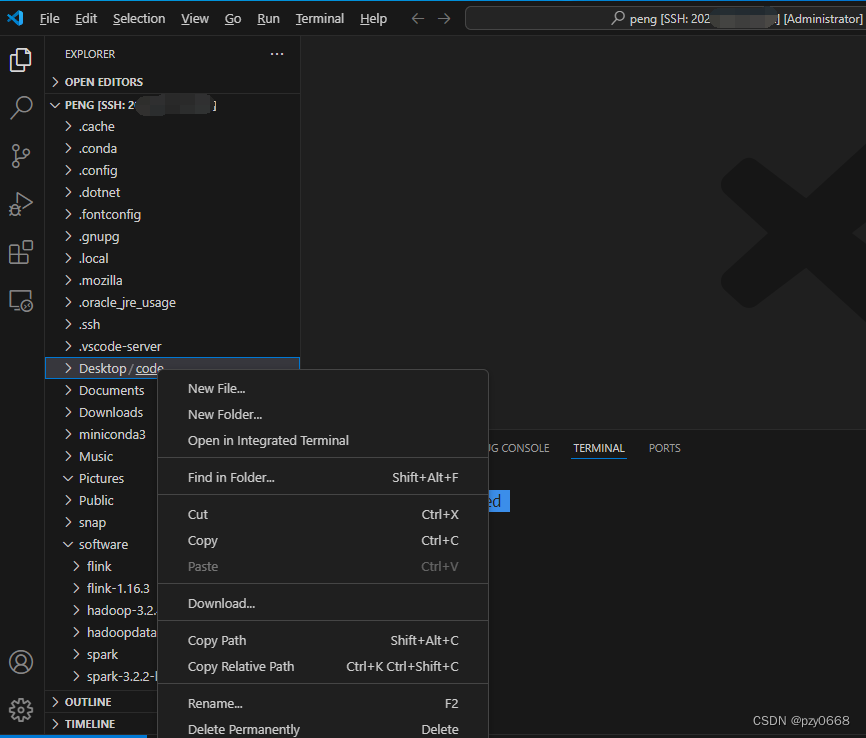

vscode先配好解释器环境,我前一篇博客配置了ssh连接Ubuntu,由于提前用ssh连接了Ubuntu,可以先本地这样操作Ubuntu了

上图,添加文件夹和文件都非常方便。

如新建test_pyspark.py代码

from pyspark import SparkContext,SparkConf

if __name__ == '__main__':

conf = SparkConf().setMaster("local").setAppName("myapp_01")

sc = SparkContext(conf=conf) #Driver端

fileRDD = sc.textFile("hdfs://master:9000/input/word.txt")

fileRDD.foreach(print)

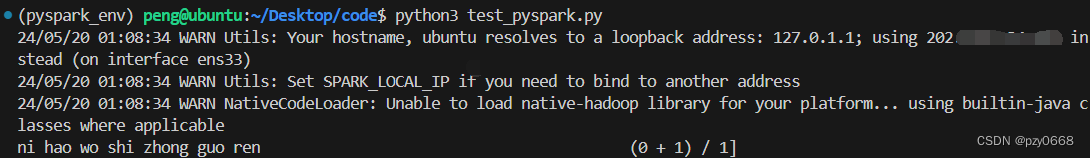

先上传word.txt到hdfs的/input目录中,然后在终端执行代码

第一步确保进入pyspark_env虚拟环境,conda activate pyspark_env ,之前spark安装的博客有配置。

第二部执行:python3 test_pyspark.py,结果如下:

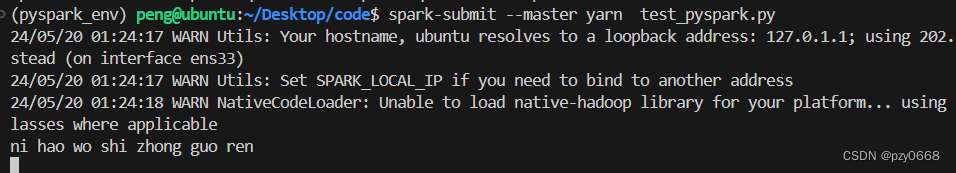

没问题了,可以尝试集群提交:

spark-submit --master yarn test_pyspark.py

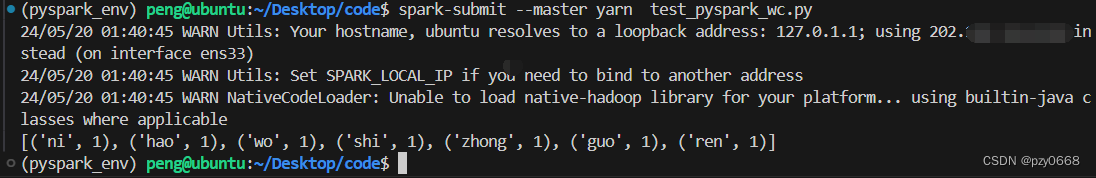

大数据得来个单词数数才算入门,词频统计代码test_pyspark_wc.py如下:

# coding:utf8

from pyspark import SparkConf, SparkContext

if __name__ == '__main__':

conf = SparkConf().setMaster("local").setAppName("my app")

sc = SparkContext(conf=conf)

lines = sc.textFile("hdfs://master:9000/input/word.txt")

wordcount = lines.flatMap(lambda x: x.split(" ")).map(lambda x: (x, 1)).reduceByKey(lambda a, b: a + b)

print(wordcount.collect())python3 test_pyspark_wc.py 没问题,可以通过集群提交

至此,完成的简单的pyspark代码编写与执行。

363

363

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?