requests库

公认的爬取网页最好的库

安装方法

用cmd打开控制台,输入

pip install requests

测试

抓取百度的网页代码。

打开IDLE输入一下代码

import requests

r = requests.get("http://www.baidu.com")

r.status_code

r.encoding = "UTF-8"

r.text

状态码为200即为成功,否则失败。

7个主要方法

requests.requests()

构造一个请求,支撑所有方法的基础。

requests.requests(method,url,**kewargs)

- method:请求方式,对应get/put/post等七种

- url:获取页面的url链接

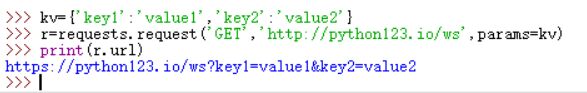

- **kwargs:13个控制访问参数。其中params的使用方法:

**kwargs的13个参数

- params:字典或字节序列,作为参数增加到url中

- data:字典、字节序列或文件对象,作为Request的内容

- json:JSON格式的数据,作为Request的内容

- headers:字典,HTTP定制头

- cookies:字典或CookieJar,Request中的cookie

- auth:元组,支持HTTP认证功能

- files:字典类型,传输文件

- timeout:设定超时时间,单位为秒

- proxies:字典类型,设定访问代理服务器,可以增加登录认证

- allow_redirects:True/False,默认为True,重定向开关

- stream:True/False,默认为True,获取内容立即下载开关

- verify:True/False,默认为True,认证SSL证书开关

- cert:本地SSL证书路径

requests.get()

获取HTML网页的主要方法,对应于与HTTP的GET方法。

r= requests

本文详细介绍了Python爬虫中常用的requests库,包括安装方法、7个主要的HTTP请求方法(如get、post、put、delete等)及其参数、Response对象的属性,以及通用的代码框架。此外,还探讨了HTTP协议的基础知识和Requests库如何与之交互。重点讲解了requests.get()方法用于获取HTML网页内容和如何处理HTTP状态码。

本文详细介绍了Python爬虫中常用的requests库,包括安装方法、7个主要的HTTP请求方法(如get、post、put、delete等)及其参数、Response对象的属性,以及通用的代码框架。此外,还探讨了HTTP协议的基础知识和Requests库如何与之交互。重点讲解了requests.get()方法用于获取HTML网页内容和如何处理HTTP状态码。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4270

4270

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?