【2020】Regularizing Class-wise Predictions via Self-knowledge Distillation

问题: 具有数百万个参数的深度神经网络可能由于过拟合而泛化能力较差。本文通过自我蒸馏增加正则化(惩罚项),从而减轻过拟合。

具体: 取同一分类的不同样本进行分类预测,要求产生相似的错误分类,而传统分类未考虑预测分布的一致性。

结果: 防止过拟合+减少内部阶级差异。

1 模型:

传统正则化: 基于图像输出的正则化。

本文正则化: 基于类的输出正则化,即选取相同类别的不同图像。

传统知识蒸馏: 利用相同样本经过两个网络(老师和学生)的输出。

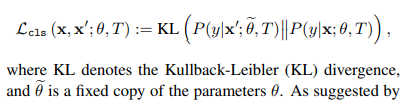

本文知识蒸馏: 利用相同类的不同样本经过相同网络的输出。

下图为本文整体模型概述:

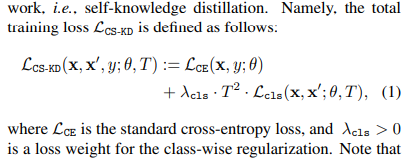

添加相同类不同样本输出的误差Lcls。

最终算法如下:

2 结果

如图,我们的方法CS-KD相比较交叉熵误差cross-entropy,对同样错误分类的样本,cross-entropy预测真实标签woman和otter的概率都很小,且错误的预测概率均相对较大。而CS-KD虽输出错误分类,但预测真实标签也不小。

figure2统计了所有错误分类,纵坐标是错误分类样本数量,横坐标是输出概率取对数,越接近0,对应概率越大。(a)图是对应输出top1的标签概率,(b)图是对应错误分类样本的真实标签的输出概率。可见,我们的方法虽输出分类错,但概率值相对不大,且真实概率相对cross-entropy较大。

769

769

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?