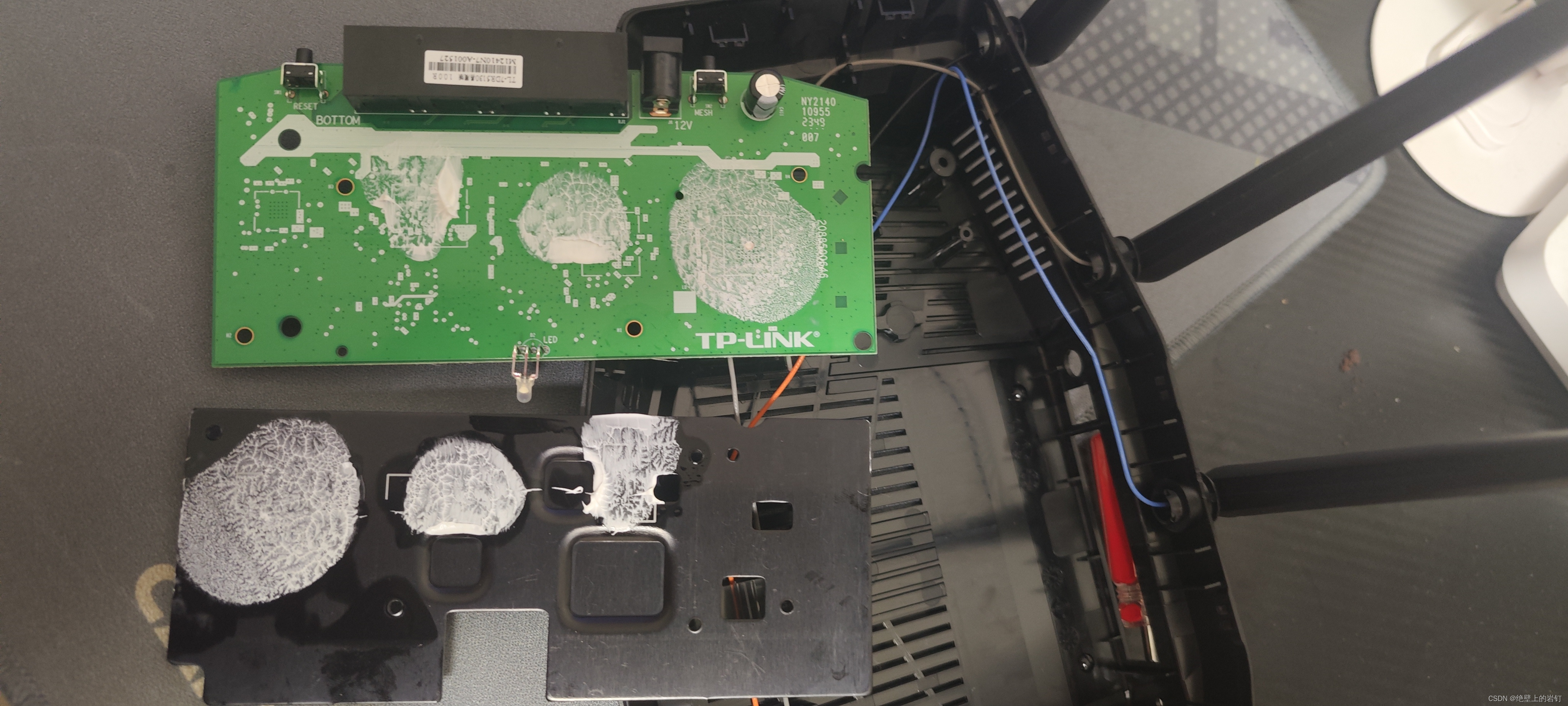

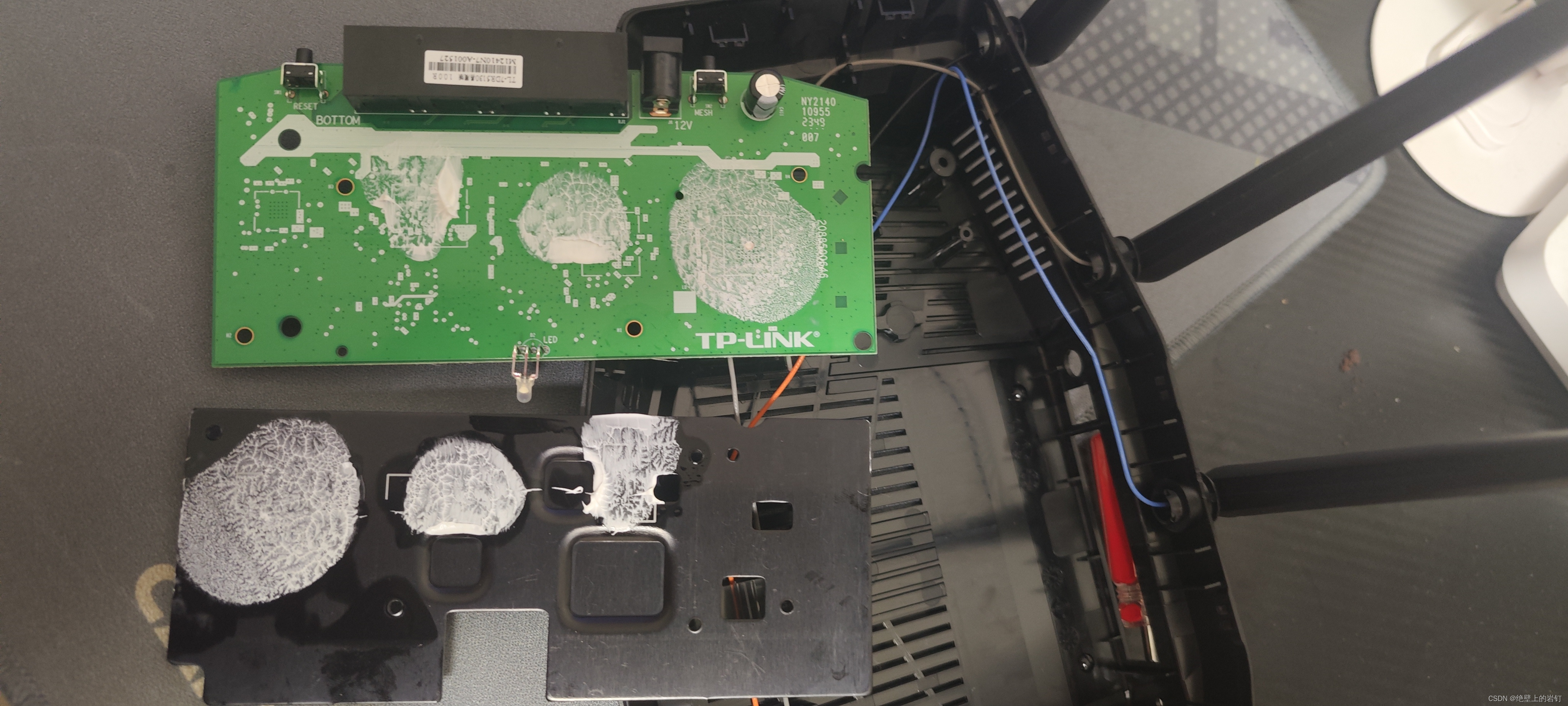

一如既往的熟悉感,额你懂得。背面很干净,涂着硅脂加铁片散热。

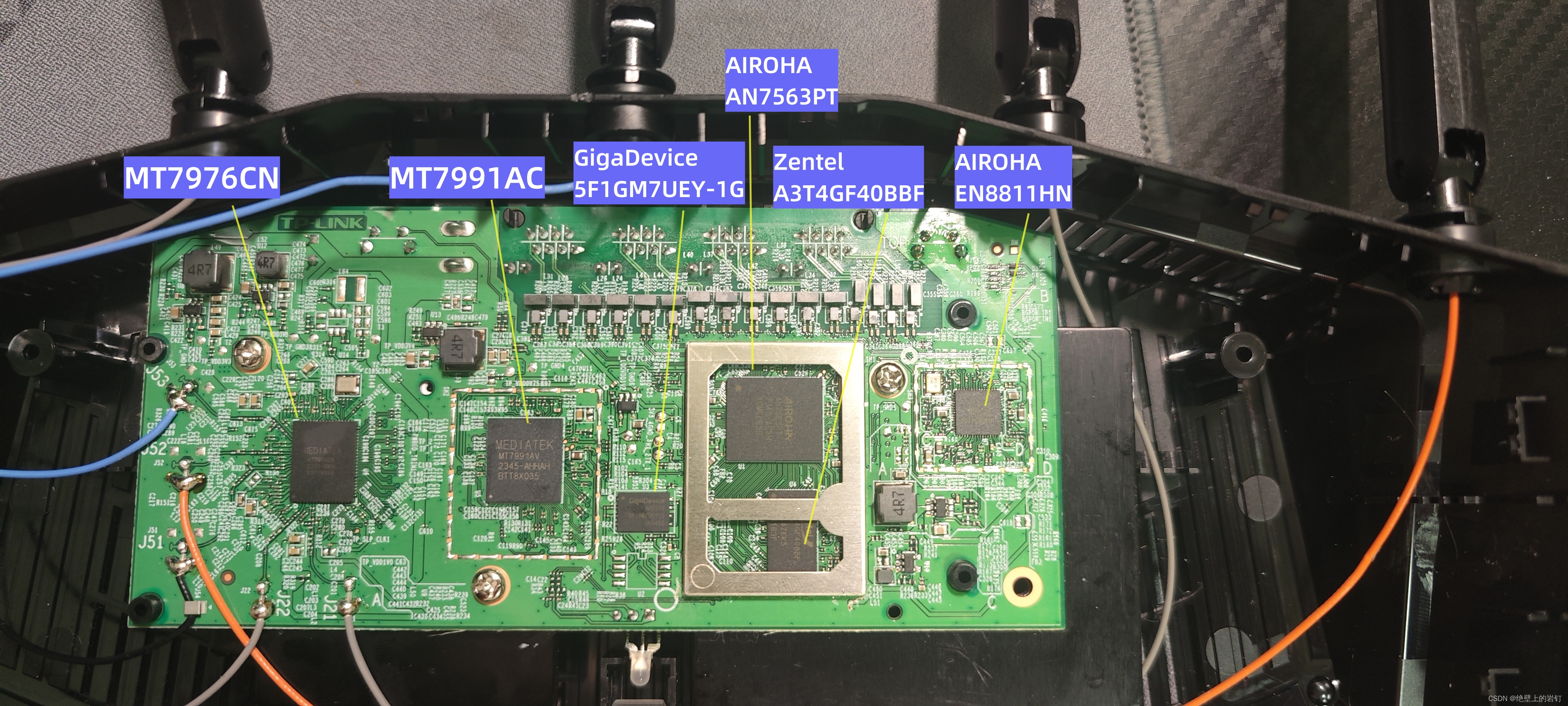

正面芯片方案:

AN7563PT(CPU)+MT7991AV(基带芯片)

+MT7976CN(射频芯片,2.4G*2,5G*3)

+ Zentel A3T4GF40BBF(内存DDR3 512M)

+ Gigo Device 5F1GM7UEY-1G(闪存128M)

+ EN8811HN(AIROHA的2.5G phy)

一如既往的熟悉感,额你懂得。背面很干净,涂着硅脂加铁片散热。

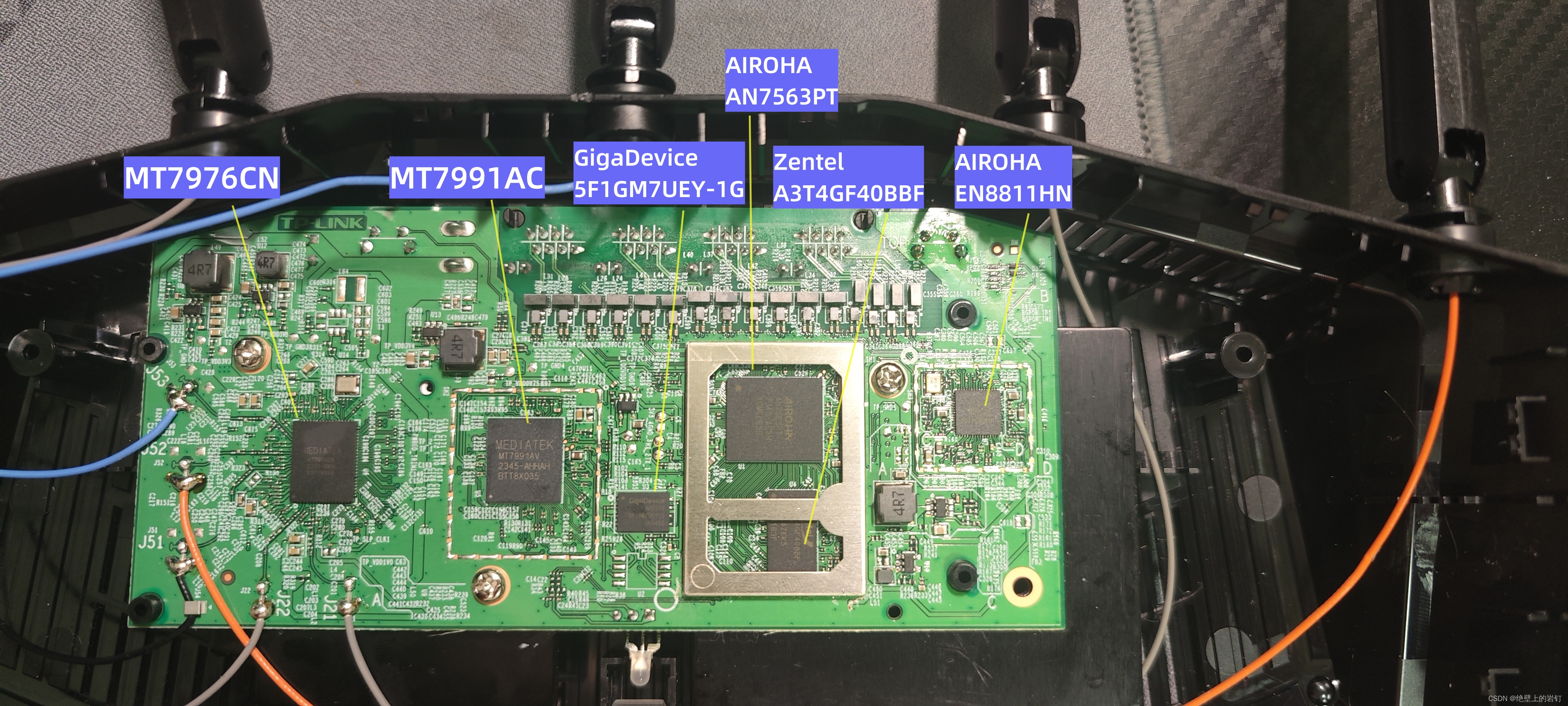

正面芯片方案:

AN7563PT(CPU)+MT7991AV(基带芯片)

+MT7976CN(射频芯片,2.4G*2,5G*3)

+ Zentel A3T4GF40BBF(内存DDR3 512M)

+ Gigo Device 5F1GM7UEY-1G(闪存128M)

+ EN8811HN(AIROHA的2.5G phy)

1682

1682

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?