期刊:IEEE Trans Med Imaging

Impact Factor: 6.1

时间:2019

研究背景

- 在临床中,对MRI多模态图(e.g.,T1-weighted, T2-weighted)的综合分析,有利于医生对病情的了解。

- 由于多模态图的缺失,或者不同机构影像设备不一致,使得MRI多模态图的合成成为热点。

- 以往的合成图像,更多的是追求像素值与真实数据相似,忽略其中的结构信息。

- 以往的合成,输入的是虚拟信号,所以合成过程的可控性不够,因此,作者选用的是输入一个模态的MRI图,合成另一个模态的MRI图。

- 因此作者想在合成阶段,增加结构信息合成的比重,采用的是Sober算子提取图像结构信息。

模型介绍

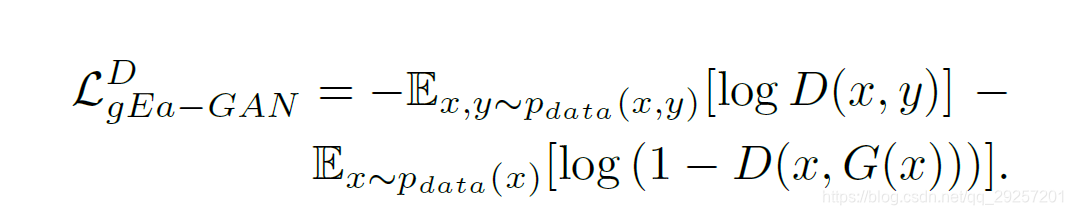

本文是基于cGAN构建的一个模型,模型分为三大块,包括:gEa-GAN、dEa-GAN、Edge Detector;

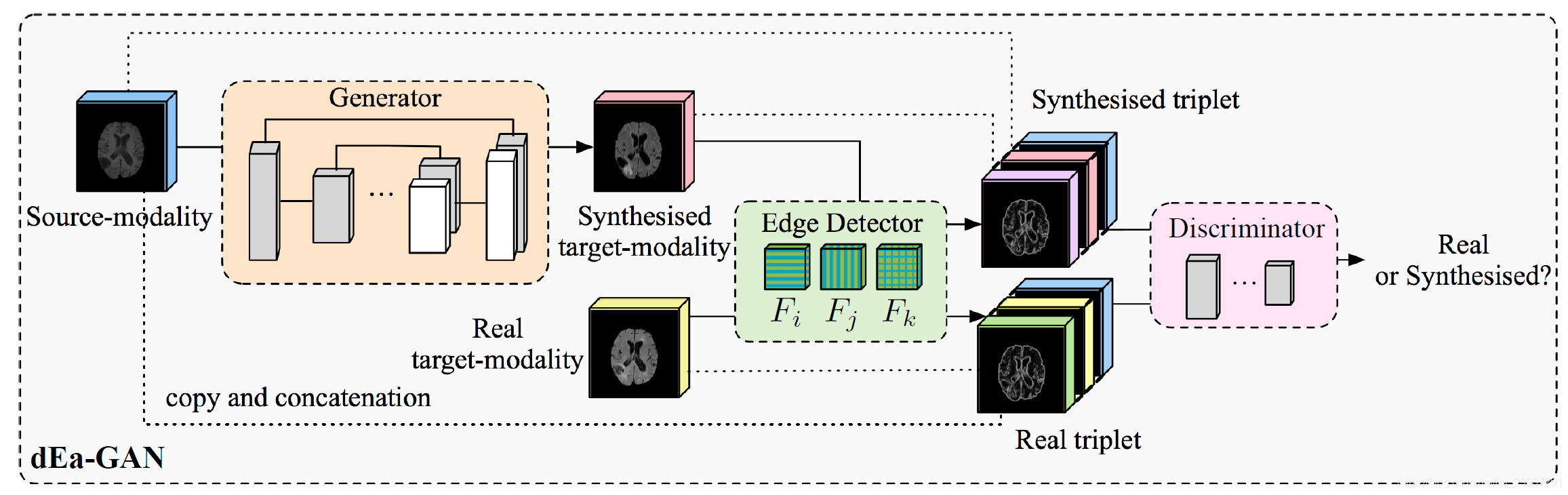

Edge Detector

- Edges反应的是像素值的变化,在MR图中,能够显示不同组织的边界,边界信息能够表达图像的结构信息,有利于MR图像的合成。

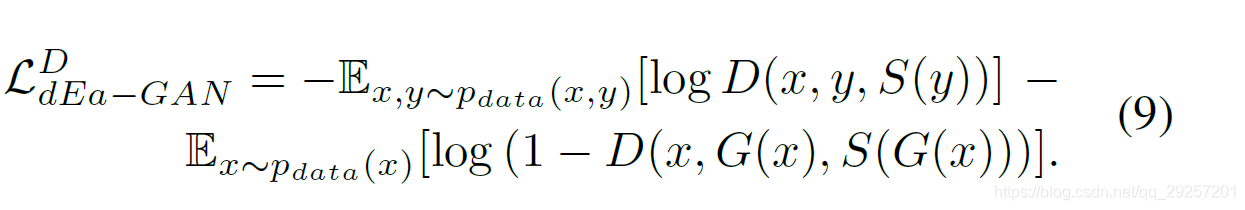

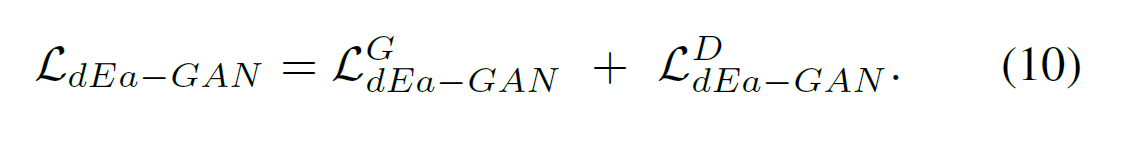

以下两个分别命名为gEa-GAN与dEa-GAN(作者提出的两个模型),但是每一模块均训练了Generator与Discriminator,不同的是训练gEa-GAN时输入的是pair【(x,G(x)),(x,y)】,训练dEa-GAN时输入的是triplet【(x,G(x)),S(G(x)),(x,y,S(y))】,两个的label规则是:synthesis组的label为0,真实组的label为1。

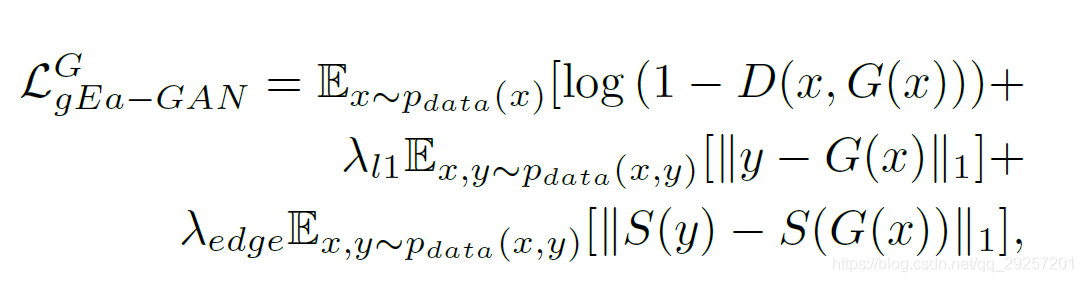

gEa-GAN

损失函数

机构图

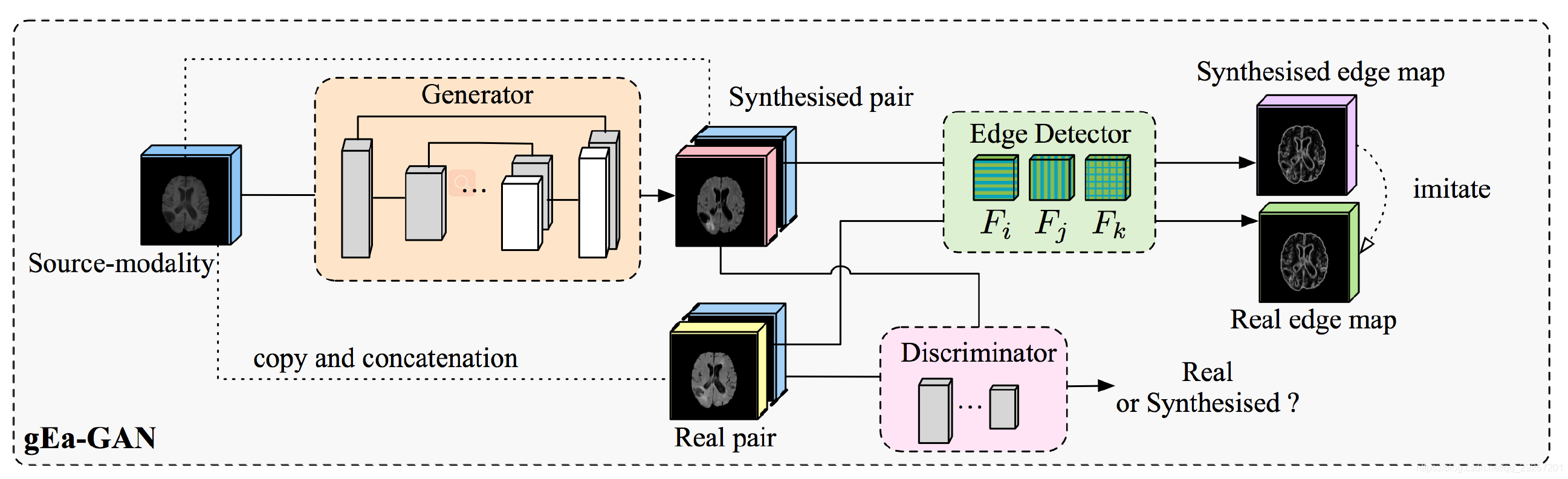

dEa-GAN

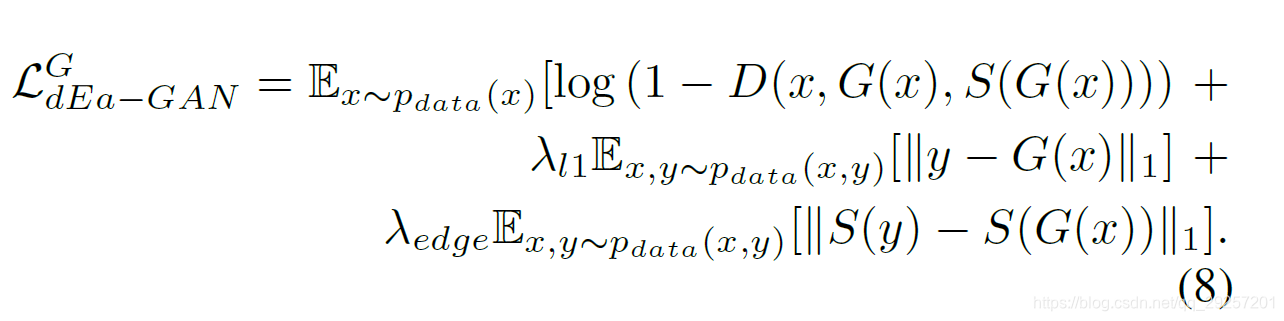

损失函数

结构图

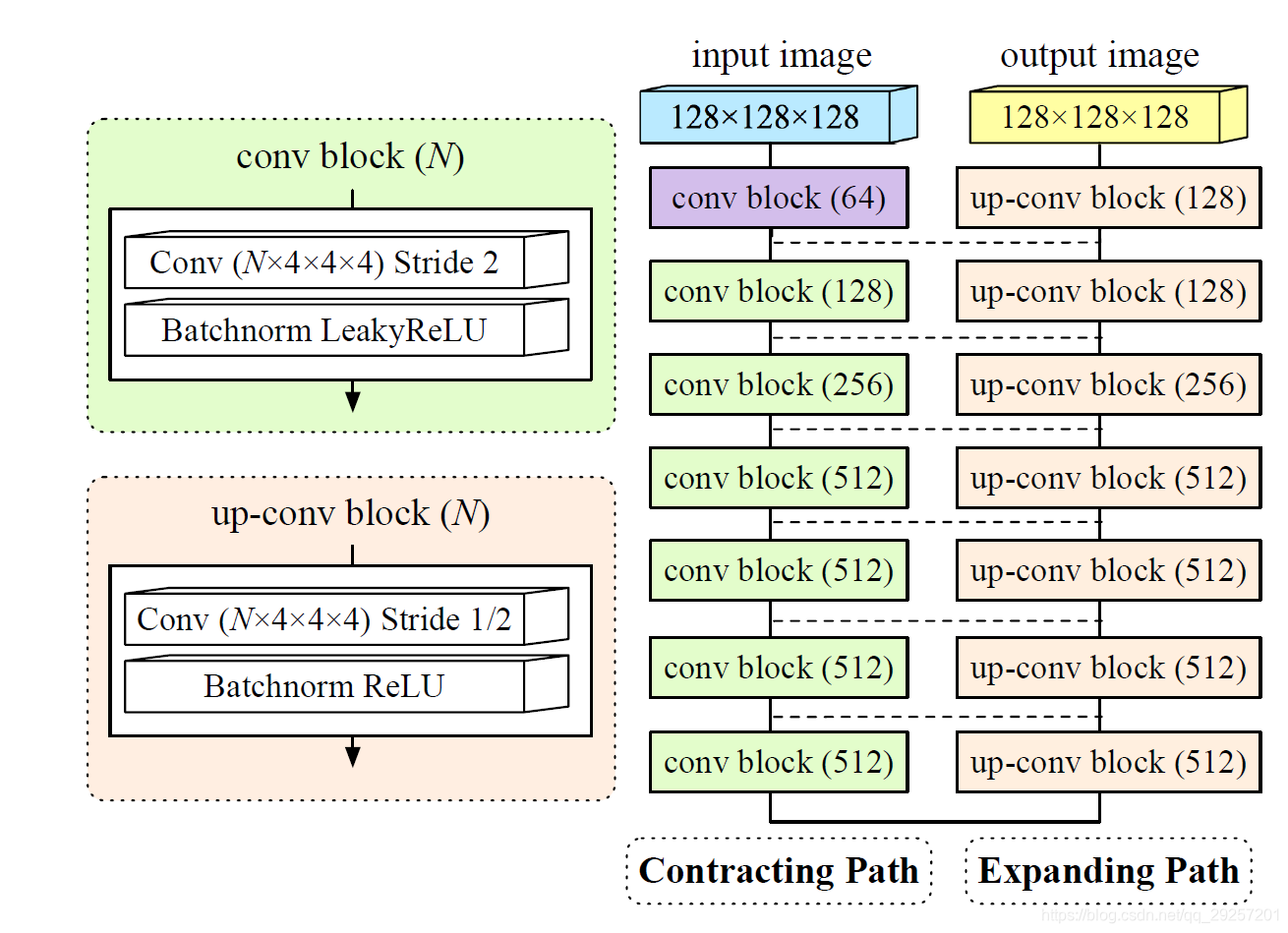

模型实现

generator 采用的是Unet网络:网络结构图如下图:

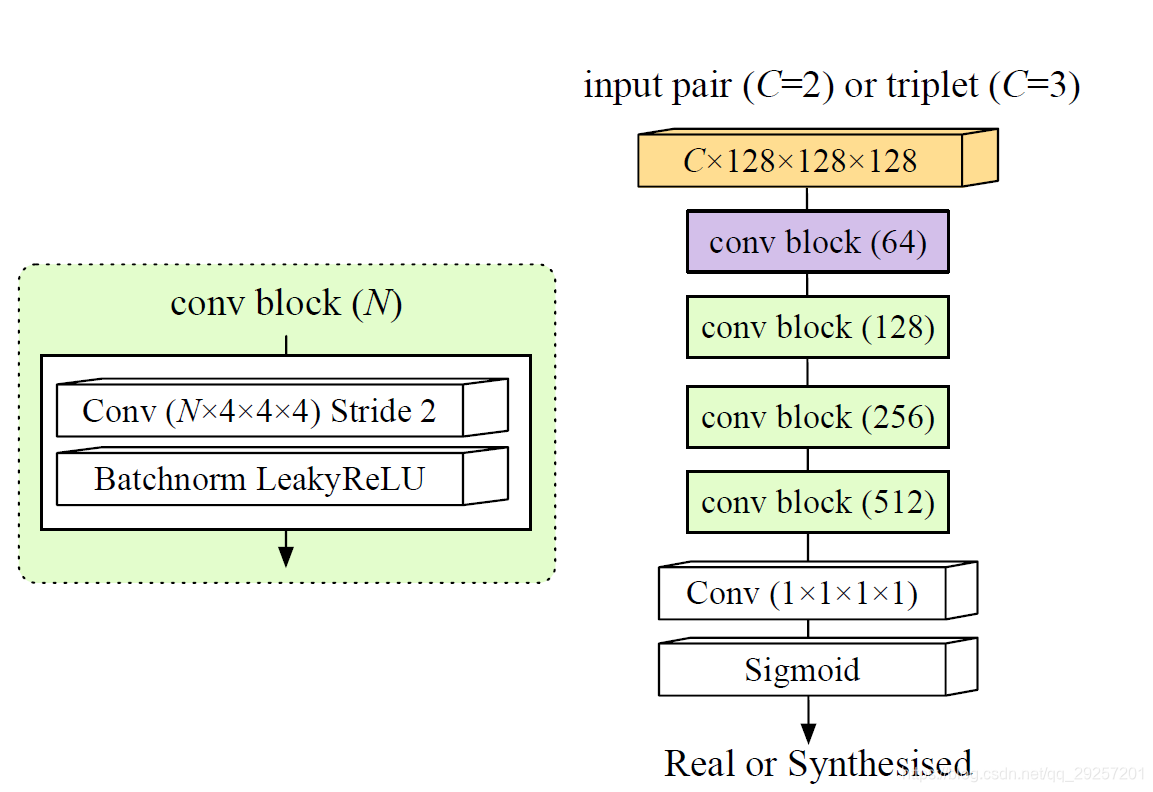

Discritimator 结构如下图所示(两个模型在第一层channel有区别,其他的一致):

评价标准与对比实验略

总结

这篇文章所提的模型,是cGAN + Unet + Sober的组合,最主要的创新点,是将Sober 算子取得 edge 作为输入,训练产生MR,其他的与传统的GAN差不多,模型构建后,最后选择了八个模型做对比实验~

这个模型最不能理解的是,为什么输入的triple和pari为什么要加上source image???(看过cGAN再回答)

4602

4602

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?