认识华为存储产品

通过3D体验中心认识硬件

通过仿真器认识GUI和CLI

默认用户名密码: admin *********

GUI登录:HTTPS协议,端口 8088

管理口:默认地址 192.168.128.101/102 (具体以实际型号产品文档为准)

维护口:默认地址 172.31.128.1.1/102 用户不可修改这个地址(具体以实际型号产品文档为准)

串口:可以实现CLI管理,波特率 115200 ,据说不可调整

通过串口使用根管理员用户可以修改admin用户的地址(可参见产品文档)

前端端口

后端端口

华为数据存储产品分类

不同系列支持的RAID也不一样

-

全闪存存储(支持NVMe和SAS两种 SSD硬盘) 中高端产品

OceanStor Dorado V6

5300/5500/5600、6800、18000

OceanStor F V5

-

混合闪存存储 (支持SSD和机械硬盘)中端入门、中端、高端

18510、18810、6800、5310、5510、5610、5810

-

分布式存储

OceanStor Pacific 海量存储 太平洋系列 分为性能型和高密型

OceanStor 9000 V5

OceanStor 100D(即 FusionStorage)

-

超融合 FusionCube

存储技术趋势

思考,什么是存储?

将不仅仅是提供空间用于数据存储,还要提供数据的保护。

数据存力:存储容量、性能表现、可靠程度、绿色低碳 的综合表休。

数据与信息

什么是数据? 数据是对所有事务的数字表示。狭义上讲,可理解为所有能被输入计算机并被计算机处理的符号。

数据的分类:

-

结构化数据

数据结构规则,通常表现为二维表,典型的代表就是关系型数据库(mysql、sql server、Oracle)

-

非结构化数据

数据结构不规则,文本、图片、音视频、报表等

-

半结构化数据

数据结构不那么规则,不符合结构化数据的形式,但又使用一些标记分隔的语义,网页HTML、XML、JSON 等

数据的处理周期

数据处理:人或机器对数据进行的重组或重新排序,以增加其特定的价值。

数据处理周期包含:输入 >>>> 处理 >>>> 输出

什么是信息?

已经被处理,具有逻辑关系的数据,是对数据的解释。

数据和信息的关系

数据经加工处理后,能够成为信息。

信息经过数字化处理转变成数据才能存储和传输。

信息生命周期管理

ILM(information life cycle management)

数据存储

什么是数据存储

-

狭义上

存储介质:光盘、硬盘、U盘、软盘、磁带等等

-

广义上

整体解决方案,包括存储设备和其它附件,计算、网络,连接线缆等

数据存储方法:各有一定优势

-

磁带存储 磁性粒子

-

存储密度高(单盘容量高,理论可达400TB)

-

扩容成本低,扩容时只需考虑介质成本即可,因为多用于离线存储

-

适合长久保存,尤其是WORM磁带,可以实现一次写入,多次读取,且数据不能被修改(理论上,硬盘不能长期断电保存,否则很可能导致数据丢失或硬盘故障)

-

缺点:怕潮、速度慢、物理故障、卡带、断带

-

-

机械硬盘 磁性粒子

-

SSD硬盘 电荷 cell 充放电 速度快

数据存储系统

硬件:存储设备(磁盘阵列、磁带库等)、HBA卡、交换机、线缆

软件:存储管理软件(device manager)、备份软件(BCManager)、多路径软件(华为UltraPath)、快照、镜像软件(BCManager)

方案:容灾方案、备份方案

存储的物理结构

一个单一的存储设备包括:硬盘子系统、控制子系统、连接子系统和存储管理软件子系统四大部分。

数据存储分类

-

内置存储 存储介质直接连接到主机总线

-

外置存储

-

DAS 直连式存储(Direct-Attached Storage,简称DAS)

主机里面的硬盘光驱U盘等,SCSI或者FC硬盘也是

通过SCSI等线缆连接到主机的磁盘柜

-

FAS 网络化存储(Fabric-Attached Storage,简称FAS)

-

SAN 存储区域网络(Storage Area Network,简称SAN)

存储设备通过交换机连接主机,共享服务

光纤交换机、FC交换机

IP SAN 通过以太网交换机提供(vlan)

FC SAN 通过光纤交换机提供(zone)

思考 FCoE 提供什么 SAN ?

-

NAS 网络接入存储(Network-Attached Storage,简称NAS)

一般是通过以太网实现

多提供数据共享服务,屏蔽操作系统差异

-

-

基于网络的存储,主要关注:主机侧、存储侧、网络侧

回头这里画个DAS、SAN、NAS的结构图

数据管理技术的演变

数据存储的应用

存储技术的发展

存储架构的发展

从硬盘到阵列

JBOD 主要解决容量扩展问题

存储阵列(RAID Redundant Arrays of Independent Disks) 可以解决简单的冗余问题了

从分离到融合

现在的存储设备基本都是统一存储,即可以同时提供NAS和SAN,2011年左右开始出现。【我觉得是行业内卷导致的】

分布式存储

相比传统存储设备扩展能力和灵活性更好。

- 通过软件将物理资源组织起来构成高性能逻辑存储池,在保证可靠性的同时提供多种存储服务;

- 通用硬件、架构统一、存储和网络解耦;

- 性能和容量容易扩展;

- 资源弹性伸缩,利用率高;

存储虚拟化

- 在物理存储系统和服务器之间增加一个虚拟层,它管理和控制所有存储并对服务器提供存储服务;

云存储

通过集群应用、网格技术或分布式文件系统等功能,将网络中不同类型的存储设备通过应用软件集合起来协同工作,共同对外提供数据存储和业务访问功能。

存储介质的发展

机械硬盘 容量越来越大,体积越来越小;

固态硬盘 成本不断降低,容量不断提升;

闪存介质 容量更大,速度更快,介质空间持续扩大;

SCM Storage Class Memory非易失性存储(读写快、能耗低、寿命长)

SLC、MLC、TLC、QLC 一个、两个、三个、四个 Cell

接口协议的发展

按传输方法分类

-

并行接口

距离越长,并行线缆的成本就越高;

由于线路间有电磁干扰,导致了:

虽然传输效率高,但距离不长,传输频率不能过高;

如果传输距离很长,那么除非所有八条并行线缆的数据都传输到目的地,才能进行下一次数据(8bit)传输;

因此线缆长度也势必受限。

-

串行接口

虽然看起来速度慢,但可通过不断提高传输频率来提高传输速度。事实上,串行传输的总体速率比并行传输高。

目前基本上都在使用串行传输方法。

按接口协议

SATA

FC

SAS

NVMe (Non-Volatile Memory Express) 非易失性存储标准,使用原生PCI-E通道,相比SAS省去了控制器等交互,使得SSD硬盘更加效率。

NVMe-oF •NVMe-oF规范发布于2016年,它支持通过光纤通道(Fibre Channel)和远程直接内存访问(RDMA),在RDMA协议框架下,InfiniBand支持融合以太网和广域Internet RDMA协议。

2018年11月发布的NVMe-oF1.1规范中,添加了TCP作为架构选项,即RoCE(RDMA over Converged Ethernet),不需要缓存,CPU可直接访问硬盘。

TCP/IP 是一个无孔不入的家伙,MPLS、iSCSI

这就像我们打过的所有游戏中的内容一样,中庸才是综合实力最厉害的。

存储产品的发展趋势

存储产品发展历程

智能时代对数据存储的新要求

- 高可靠 7x24业务不间断运行

- 高性能 微秒级高速业务处理

- 高容量 EB级存储量 数据资产化,存储智能分层

- 高效率 降低TCO(总体拥有成本),让数据的每个bit都达到晨报最低,价值最大 —— 人话:性价比。

智能时代数据存储的特征

-

智能时代数据存储要满足三个主要特征,即智能、融合、高效。

-

智能体现在实现数据全生命周期的智能管理,我们可以称之为Storage for AI和AI in Storage。

-

数据融合主要体现在多协议、多服务的融合,存储智能分级管理,实现数据免搬迁,以及对数据处理和分析的有效协同,采用专有硬件实现极简协议栈、让数据库与存储高效融合,对海量大数据分析进行计算与存储协同,按需扩容。

-

面向业务,要基于硬件+算法+架构,突破冯.诺依曼的瓶颈,利用最新的技术实现数据存储的极致可靠、极致性能以及极致的容量,满足智能时代全新业务的数据存储新需求。

数据存储发展趋势

-

从IBM大机时代,到x86时代,再到虚拟化时代,存储介质组件走向全闪存化,网络协议走向ALL IP化。

-

智能时代下,基于超高速互联新标准、新协议HCCS(Huawei Cache Coherence System,华为缓存一致性系统)/CXL(Compute Express Link)可以实现CPU、NPU(Neural Processing Unit,神经网络处理器)异构处理器高速互联,RoCE/NVMe支持高速数据传输,容器化技术,加上新的硬件,新的技术,为数据存储提供了丰富的选择。

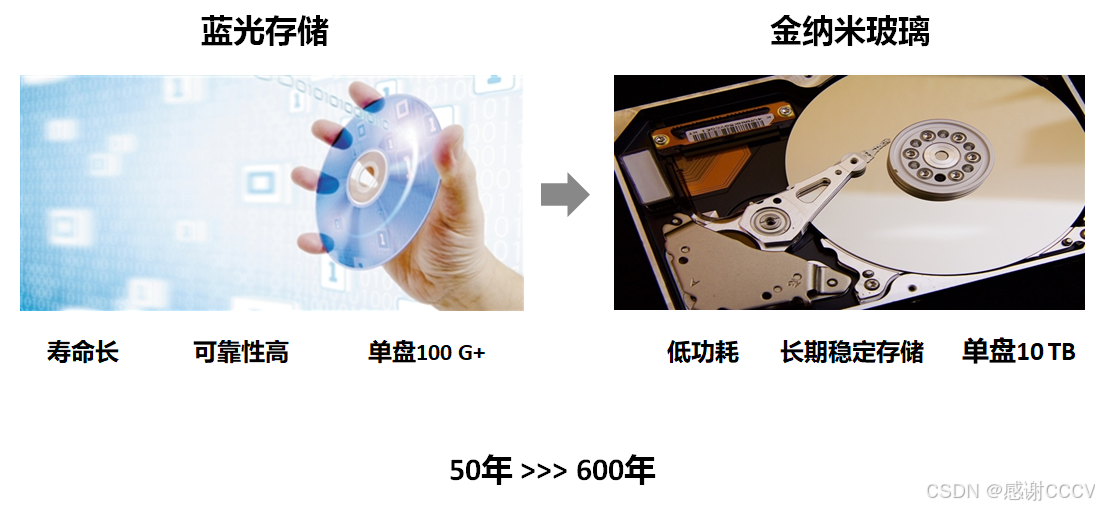

存储介质发展趋势

蓝光、金纳米玻璃、DNA存储、原子存储、量子存储

HDD、SSD、SCM、DRAM、SRAM 从左到右越来越快

Storage Class Memory 介质介绍当前主流的存储介质主要有SRAM,DRAM、SCM、Flash Memory,HDD,延迟依次从低到高,成本则从高到低。存储级存储器SCM介于传统DRAM和NAND Flash之间,相较普通的NAND拥有更快的速度、更低的延迟,较DRAM则容量更大,成本相对较低。SCM介质的使用将为大数据应用程序和复杂工作负载性提供变革和突破性存储解决方案。目前业界主流的Storage Class Memory介质主要有三种类型:XL-NAND,Intel PCM 3D Xpoint,Z-NAND。

华为ocean stor dorado v6全闪存存储里面用到SCM

存储网络发展趋势

华为存储产品发展历程

智能数据存储架构

存储基础技术

智能存储组件

存储产品形态:

2U盘控一体 控制框里面可以插硬盘

4U盘控分离 控制框里面不可以插硬盘

整机柜

查询华为存储产品规格的页面

https://info.support.huawei.com/storage/spec/#/home

结合PPT、Hedex、官网3D体验中心来了解各个存储产品的组件

https://info.support.huawei.com/storage/3d-center/#/detail?productId=product_0723388318&model=dorado_3000v6_nvme

控制框

承载了控制器的机框,对外提供存储服务,它是存储系统中的核心组件。

控制器

设备中的核心部件,主要负责处理存储业务、接收用户的配置管理命令、保存配置信息、接入硬盘和保存关键信息到保险箱硬盘。

控制器上的CPU和Cache共同实现对来自主机系统I/O请求的操作和对磁盘阵列的RAID管理。

每个控制器可内置多个硬盘,用于保存存储系统的数据和系统掉电后Cache中的数据。控制器间的硬盘互相冗余。

前端端口,FE(Front End):用于应用服务器和存储设备进行业务通信,即对主机I/O进行处理。

后端端口,BE(Back End):负责连接控制框和硬盘框,是数据从硬盘读写的通道。

缓存(Cache):是硬盘控制器上的一块内存芯片,具有极快的存取速度,它是硬盘内部存储和外界接口之间的缓冲器。

引擎(Engine):引擎(Engine)是电子平台上开发程序或系统的核心组件。通常是一个程序或一套系统的支持部分。

风扇模块

为系统提供散热功能,可以支持控制框在最大功耗下的正常运行。

BBU模块

BBU能够在系统外部供电失效的情况下,提供后备电源支持,以保证存储阵列中业务数据的安全性。(提供尽可能高的数据保护,即使所有外部电源断开包括UPS)

在系统电源输出正常时处于备份状态,当外部电源断开时,BBU能够继续给系统供电。BBU支持失效隔离,当BBU出故障时不会影响系统的正常运行。当系统掉电时BBU能确保系统将Cache数据写入控制器内置硬盘,保证数据不丢失。在系统外部电源故障恢复时,驱动软件将保存在控制器内置硬盘上的数据读出恢复至Cache中。使用锂电池备电的系统,都需要通过对电池进行充放电来刷新和检测电池容量,用于提前发现电池部件在网长时间不使用导致容量衰减,无法满足系统备电应用,导致数据备份失败的问题,提升系统掉电数据保护的可靠性。

知识点:

脏数据:在缓存中未写入硬盘的数据;

回写(在华为混合闪存存储上 默认)

为提升工作效率,存储系统先将数据写入缓存后,就会向主机返回写成功消息,缓存中的数据稍后写入硬盘框中的硬盘;

透写

数据直接写入底层,返回写成功。相比安全性较高,但性能稍差;

保险箱盘

用于保存存储系统的数据、系统配置信息和日志、系统掉电后Cache中的数据。

存储系统中存在两种保险箱盘:内置的保险箱盘和外置的保险箱盘。

内置的保险箱盘:Huawei OceanStor Dorado V6每个控制器内置1块或2块SSD硬盘作为保险箱盘,详细配置请参考产品文档。【脏数据保存在内置保险箱盘】

外置的保险箱盘:存储系统会自动选择系统中的4块硬盘规划为保险箱盘,每块硬盘各取2GB空间组成RAID1,保险箱盘上的其他容量可以用来存储业务数据。当保险箱盘故障时,为保障冗余性,系统会自动从其余硬盘中选择状态正常的盘来替代故障保险箱盘。

保险箱盘做RAID1,存储产品的RAID1和服务器RAID稍有不同,如果是4块盘的RAID1,可以坏三块,也就是说实际上数据每次是写入四份。(具体产品系列、型号、版本之间有所不同)

更多关于保险箱盘的内容,需要根据具体产品型号参考文档来确定。

电源模块

-

电源模块为交流电源模块,可以支持控制框在最大功耗模式下正常运行。

-

4控制器存储产品每个4U控制框有4个电源模块(PSU,Power Supply Unit),分别为PSU 0、PSU 1、PSU 2、PSU 3。分为两个电源平面,PSU 0与PSU 1为一个电源平面且互为冗余,为A、C控制器供电。PSU 2和PSU 3为另外一个电源平面且互为冗余,为B、D控制器供电。为保障电源模块供电的可靠性,建议PSU 0和PSU 2插入一个PDU,PSU 1和PSU 3插入另外一个PDU。

-

•2控制器存储产品每个控制框有2个电源模块(PSU,Power Supply Unit),分别为PSU 0、PSU 1,组成一个电源平面且互为冗余,为A、B控制器供电。为保障电源模块供电的可靠性,建议PSU 0和PSU 1分别插入不同的PDU。

硬盘框

硬盘框分为:

普通硬盘框:SAS硬盘框

智能硬盘框:智能SAS硬盘框、智能NVMe硬盘框

高密硬盘框:3.5英寸SAS硬盘(混合闪存)

智能在哪里?

通过自研RDMA 100G高速协议可级联华为自研的智能硬盘框,智能硬盘框内置一颗海思鲲鹏处理芯片,可卸载硬盘框内的硬盘管理和硬盘读写IO处理,释放控制框的CPU处理压力。

智能硬盘框内置CPU和内存,比如硬盘RAID数据重构就可以在硬盘框内完成;

普通和智能两种硬盘框不能混插,不同产品能够支持的硬盘框也不同;

-

系统插框:通过背板为各种接口模块提供可靠的连接,实现各个模块之间的信号互连与电源互连。

-

级联模块:通过级联端口来级联控制框和其他硬盘框,实现与控制框和其他硬盘框的通信,是控制框与硬盘框之间、硬盘框与硬盘框之间进行数据传输的连接点。

-

电源模块:可以支持硬盘框在最大功耗模式下正常运行。

-

硬盘模块:为存储系统提供存储容量,可作为系统保险箱,并且可以实现业务数据、系统数据和缓存数据的存储作用。

企业数据中心存储工具

https://support.huawei.com/enterprise/zh/tool/product/enterprise-storage

级联模块

2U SAS硬盘框中级联模块通过级联端口级联控制框;每个级联模块提供1个级联端口“P0”和1个级联端口“P1”。级联模块通过级联端口来级联控制框,实现与控制框的通信,是控制框与硬盘框之间进行数据传输的连接点。

2U 智能NVMe硬盘框中级联模块通过级联端口级联控制框与其他硬盘框;每个级联模块提供1个级联端口“P0”和1个级联端口“P1”。级联模块通过级联端口来级联控制框和其他硬盘框,实现与控制框和其他硬盘框的通信,是控制框与硬盘框之间、硬盘框与硬盘框之间进行数据传输的连接点。

CE交换机

华为CloudEngine 系列盒式交换机是面向数据中心推出的新一代高性能、高密度、低时延以太网交换机,采用灵活的前后/后前风道设计。

可以应用于IP SAN组网,分布式存储组网场景。

FC交换机

里面是博科

光纤交换机是一种高速的网络传输中继设备,它较普通交换机而言采用了光纤电缆作为传输介质。光纤传输的优点是速度快、抗干扰能力强。

可应用于FC SAN组网场景。

-

Zoning介绍

Zoning是基于Fabric的分区服务,可以将SAN划分为多个可以相互访问的逻辑设备组。

启用Zoning后,设备间的访问将遵循以下规则:

- Zone中的设备只能访问同一Zone中连接到Fabric的其它设备。

- 不在Zone中的设备不能被Fabric中的其他设备访问。

更深入的内容,将在更深入的课程中讲到。

设备线缆

电源线、接地线、网线、串口线缆、mini SAS HD线缆(电缆、光缆)、光纤、100G QSFP 28线缆

线缆功能可参考Hedex

机械硬盘

实现:机械硬盘HDD、固态硬盘SSD

尺寸:1.8、2.5、3。5、5.25

接口类型:IDE、SCSI、SATA、SAS、FC、NVMe

应用场景:企业、桌面

机械硬盘结构及工作原理

内部真空无尘,正常情况下不可拆开;

马达带动盘片,磁头利用气流漂浮在盘片上;

0磁道在最外圈;

寻址方式:现在使用LBA

数据在硬盘中的存储由元数据和实际数据组成。(相当于字典目录页和具体页面)

- CHS C(柱面)、H(磁道)、S(扇区) 比如 123,就是指1号柱面2号磁道3号扇区

- LBA Logical Block Addressing 逻辑块寻址,即线性寻址;LBA寻址不考虑磁盘的物理结构,直接将磁盘上的所有扇区依次从“0”开始进行编号,直到磁盘的最大扇区数减1。主机读写数据时仅需给出LBA即可,由硬盘驱动器将其转换为CHS;

盘面:硬盘的每一个盘片都有两个盘面,每个盘面都能存储数据,成为有效盘片。每一个有效盘面都有一个盘面号,按从上到小的顺序从0开始依次编号。在硬盘系统中,盘面号又叫磁头号,因为每一个有效盘面都有一个对应的读写磁头。

磁道(Track):磁道是在盘片上围绕在主轴周围的同心环,数据被记录在磁道上。磁道从最外圈向内圈从0开始顺序编号。硬盘的每一个盘面有300~1024个磁道,新式大容量硬盘每面的磁道数更多,通常用盘片上每英寸的磁道数(TPI,也称磁道密度)来衡量盘片上磁道排列的紧密程度。磁道是肉眼看不见的,只是盘面上以特殊形式磁化了的一些磁化区。

柱面(Cylinder):在同一个硬盘中所有盘片(包含上下两个盘面)具有相同编号的磁道形成一个圆柱,称之为硬盘的柱面。每个柱面上的磁头由上而下从0开始编号,数据的读写按柱面进行,即磁头读写数据时先在同一柱面内从0磁头开始进行操作,依次往下在同一柱面的不同盘面(即磁头)上进行操作。只有同一柱面所有的磁头全部读写完成后磁头才转移到写一个柱面,因为选取磁头只需通过电子切换即可,而选取柱面侧必须通过机械切换,即寻道。通常硬盘中磁头的位置由柱面号来说明,而不是用磁道号来说明。

扇区(Sector):每个磁道被分为更小的单位,称为扇区,划分扇区的目的是为了使数据存储更加条理化。扇区是硬盘中可以单独寻址的最小存储单元。不同硬盘磁道的扇区数可以不同。通常情况下,一个扇区可以保存512字节的用户数据,但也有一些硬盘可以被格式化为更大的扇区大小,如4KB扇区。

硬盘的容量:影响容量的因素有单碟容量和碟片容量;硬盘每个时刻只允许一个磁头来读写数据,因此盘片和磁头再多,也不能提高硬盘的吞吐量和IO性能,只能提高容量。

硬盘的缓存: 由于CPU和硬盘之间存在巨大的速度差异,为解决硬盘在读写数据时CPU的等待问题,在硬盘上设置适当的高速缓存,以解决二者之间速度不匹配的问题,硬盘缓存与CPU上的高速缓存作用一样,是为了提高硬盘的读写速度。

影响硬盘性能的主要因素

- 转速 连续IO是吞吐量性能

- 寻道速度 随机IO性能

- 单碟容量 影响硬盘性能的间接因素

- 接口速度 最不重要的因素

平均访问时间:平均寻道时间、平均等待时间

寻道时间 用于将磁头移动到要操作的数据所在磁道的时间;更深入一些:全程寻道时间、平均寻道时间、道间寻道时间;寻道时间越短,磁盘提供服务时间越短;

等待时间 又可以理解为旋转延迟;磁头寻道完成后,主轴旋转盘片盘片以使读写扇区旋转到磁头下的时间;如7200rpm的硬盘平均旋转延迟大约是60*1000/7200/2=4.17ms,而转速为15000rpm的硬盘其平均旋转延迟约2ms。

数据传输速率(Data Transfer Rate)

-

内部传输速率(Internal Transfer Rate)

-

外部传输速率(External Transfer Rate)/接口传输率

IOPS

IOPS (Input/Output Per Second) 每秒的输入输出量(或读写次数),是衡量硬盘性能的主要指标之一。

IOPS的计算:由寻道时间、旋转延迟和数据传输时间三部分组成。

-

寻道时间 通常可通过考题获得

-

旋转延迟 60*1000/转速/2 (旋转延迟通常使用硬盘旋转一周所需时间的1/2表示)

-

数据传输时间 单个IO大小/最大传输速率

1S = 1000ms

1M = 1000k

- IOTime = 寻道时间 + 旋转延迟 + 数据传输时间

- IOTime = 寻道时间 + 60000/转速/2 + IOChunkSize/最大传输速率

- IOPS = 1000ms/IOTime = 1000ms/(寻道时间 + 60S/转速/2 + IOChunkSize/最大传输速率)

HCIA4.5 官方PPT对于硬盘最大IOPS的说法

理论上可以计算出硬盘的最大IOPS,即IOPS=1000ms/(寻道时间+旋转延迟),忽略数据传输时间。如假设硬盘平均物理寻道时间为3ms,硬盘转速为7200,10K,15K rpm,则硬盘的IOPS理论最大值分别为:140、167和200。

假设磁盘转速15K RPM,平均寻道时间5ms,最大传输速率为40MB/S,在不同的IO大小时,IOPS?

| 单个IO大小 | 寻道时间(ms) | 旋转延迟(ms) | 传输时延(ms) | IO服务时间(ms) | IOPS |

|---|---|---|---|---|---|

| 4K | 5 | 2 | 4K/40MB = 0.1 | 7.1 | 1000/7.1 = 140 |

| 8K | 5 | 2 | 8K/40MB = 0.2 | 7.2 | 1000/7.2 = 139 |

| 16K | 5 | 2 | 16K/40MB = 0.4 | 7.4 | 1000/7.4 = 135 |

| 32K | 5 | 2 | 32K/40MB = 0.8 | 7.8 | 1000/7.8 = 128 |

传输带宽 单位时间内成功传输的数据数量,即传输数据流的速度。例如写入10000个1KB的文件需要10s,则此时传输带宽只达到1MB/s;若写入一个10MB的文件用了0.1s,则此时的传输带宽为100MB/s。

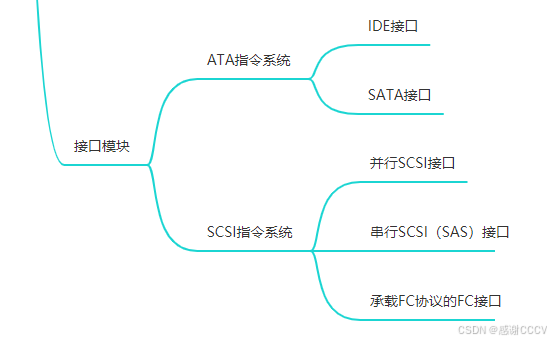

接口模块

l现在有8个数字从1到8,需要传送给对方。传输方式如下:

硬盘接口技术

-

IDE和SATA硬盘都采用ATA系的机械底盘,适用于单任务处理。

-

SCSI、SAS、FC硬盘都采用SCSI系的机械底盘,能更好地满足服务器多任务的需要。

-

两者对比:

- ATA系硬盘面对大数据吞吐量的服务时,速度不如SCSI系硬盘;

- 面对多任务数据读取,硬盘磁头频繁来回摆动,导致硬盘过热是ATA系硬盘比较严重的问题。

- SCSI系机械底盘可靠性比ATA系的机械底盘高。

-

IDE接口,也称为PATA接口(Parallel ATA,并行传输ATA)

-

SATA:Serial ATA ,串行ATA

-

SCSI (Small Computer System Interface ) 小型计算机系统接口

-

lSAS(Serial Attached SCSI) 串行连接SCSI

-

FC硬盘采用FC-AL( Fiber Channel Arbitrated Loop)光纤通道仲裁环

-

NL-SAS 近线SAS (NL-SAS盘——SAS接口、SATA盘体)

NL-SAS盘相比SAS盘旋转速度较慢,通常为7.2K RPM。它能够提供最大的容量空间和较低的性能,因此被作为分层存储中的容量层使用。统计显示,对于大部分应用来说,60-80%的容量空间只承载着较低的压力,此部分容量适合用容量大、价格低的NL-SAS盘来承担。除此之外,NL-SAS盘的功耗更低,对比SAS盘,每TB容量下NL-SAS盘能够节能约96%。

固态硬盘

相对于HDD而言,固态硬盘SSD在性能、可靠性、能耗、轻便性方面有着绝对的优势,目前已经在各领域得到广泛应用。

特点:

-

使用flash技术存储信息,数据传输速度比HDD快

-

内部没有机械结构因此耗电量更小、散热小、噪音小

-

SSD盘使用寿命受擦写次数影响

SSD硬盘架构

- SSD主要由控制单元和存储单元(当前主要是Flash闪存颗粒)组成。

- 控制单元:SSD控制器、主机接口、DRAM等;

- 存储单元:NAND FLASH颗粒。

-

主机接口:主机访问SSD的协议和物理接口,如SATA、SAS和PCIe。

-

SSD控制器:负责主机到后端介质的读写访问和协议转换,表项管理、数据缓存及校验等,是SSD的核心部件。

-

DRAM:FTL(Flash translation layer,闪存转换层)表项和数据的缓存,以提供数据访问性能。

-

NAND FLASH:数据存储的物理器件,是一种非易失性随机访问存储介质。

-

多通道并发,通道内Flash颗粒复用时序。支持TCQ/NCQ,一次响应多个IO请求。

NAND Flash

NAND Flash内部存储单元组成包括:LUN、Plane、Block、Page、Cell

NAND Flash存储原理:

- NAND Flash采用浮栅晶体管存储数据,其工作原理是利用浮栅上是否储存有电荷或储存电荷的多少来改变晶体管的阈值电压,通过读取到的晶体管阈值电压来实现数据信息的表征。

- LUN:能够独立封装的最小物理单元,通常包含多个plane。

- Plane:拥有独立的Page寄存器,通常LUN包含1K或2K奇数Block或偶数Block。

- Block:能够执行擦除操作的最小单元,通常由多个Page组成。

- Page:能够执行编程和读操作的最小单元,通常大小为16KB等。

- Cell:Page中的最小操作擦写读单元,对应一个浮栅晶体管,可以存储1bit或多bit。

- 编程和读的基本操作单位是Page,擦除的基本单位是Block。

- 擦写过程会对浮栅晶体管的绝缘层造成一定程度的损坏,在擦除失败或编程失败后会置操作的Block为坏块,厂商定义当坏块数量达到一定程度(4%以内)的时候,则认为NAND Flash达到使用寿命上限。

对NAND FLASH读写数据的操作主要涉及擦除(Erase)、编程(Program)和读(Read),其中编程和读的基本操作单位是Page,擦除的基本操作单位是Block。在写入一个Page之前,必须要擦除这个Page所在的整个Block。因此在写入某个Page时,需要把Block中其他有效的数据拷贝到新的存储空间,从而把原先的整个Block擦除,这一过程称为垃圾回收(Garbage Collection,简称GC)。每一次对Block的编程写入和擦除称为一次P/E(Program/Erase)。不同于机械硬盘HDD,SSD盘中对每个Block的擦写次数是有限制的。如果某些Block的擦写次数太多,将会导致该Block不可用。针对SSD的这些特点,

华为自研的HSSD盘采用了多项关键技术来保证SSD的可靠性和性能。

SLC、MLC、TLC和QLC

四种不同的类型的cell,虽然存储的数据量不同,但是成本却是大致相同的,这也是SSD的容量不断增大的一个原因。最初的SSD只有64GB或更小,而现在最大TLC型的SSD盘可以存储多达2TB的数据。不过,不同类型的SSD盘的抗磨损的能力不同,导致硬盘的可靠性不同。SSD盘的抗磨损能力也是选择SSD盘的一个重要参数。

地址映射管理

LBA:Logical Block Address,逻辑区块地址,可以指某个数据区块的地址或者某个地址上所指向的数据区块。

PBA:Physics Block Address,物理区块地址。

HDD:LBA和PBA一对一,不变更 覆盖写

SSD: LBA和PBA的关系不固定 不覆盖写:先擦除才能再写,异处更新

Host是通过LBA访问SSD的,每个LBA代表着一个Sector(一般为512B大小),操作系统一般以4K为单位访问SSD,把Host访问SSD的基本单元叫做用户页(Host Page)。

在SSD内部,SSD主控与Flash之间是Flash Page为基本单元访问Flash的,称Flash Page为物理页(Physical Page)。Host每写入一个Host Page,SSD主控会找一个Physical Page把Host数据写入,SSD内部同时记录了这样一条映射(Map)。【FTL闪存转换层】

有了这样一个映射关系后,下次Host需要读取某个Host Page时,SSD就知道从Flash的哪个位置把数据读取上来。

- FTL(Flash translation layer,闪存转换层) LBA—PBA的映射

SSD性能优势

-

响应时间短

传统硬盘的机械特性导致大部分时间浪费在寻道和机械延迟上,数据传输效率受到严重制约。而SSD硬盘内部没有机械运动部件,省去了寻道时间和机械延迟,可更快捷的响应读写请求。

-

读写效率高

-

机械硬盘在进行随机读写操作时,磁头不停地移动,导致读写效率低下。而SSD通过内部控制器计算出数据的存放位置,并进行读写操作,省去了机械操作时间,大大提高了读写效率。

-

较少的硬盘功耗优势不是很明显,但是当使用大量的硬盘数量的时候,功耗所产生的成本差别就比较大,也成为企业在选择方案时候的一个考虑因素。

SSD在存储中的应用

-

A级应用:以高并发随机读写为主,如数据库应用;

-

B级应用:顺序读写的大容量文件、图片、流媒体等;

-

C级应用:已备份数据为主,或极少使用的数据。

-

二八原则

用户需要频繁改动或读写的数据,一般占存储总量的20%,称为热数据,对应于A级应用。

-

分级存储

-

将热数据存放在SSD上,B级和C级应用的数据存放在高速HDD和一般HDD上,提升性能并减少投资。

接口模块

不同接口模块用途不一,详情可参考Hedex。

GE接口模块

SAS级联模块

RDMA接口模块

SmartIO接口模块

PEIe接口模块

56Gb IB模块

FC接口模块

FCoE接口模块

RAID技术

华为存储设备使用RAID2.0+技术。

-

RAID:Redundant Array of Independent Disks,独立硬盘冗余阵列,RAID技术将多个单独的物理硬盘以不同的方式组合成一个逻辑硬盘,从而提高了硬盘的读写性能和数据安全性。

-

实现方法:硬件RAID和软件RAID

RAID的数据组织形式

-

硬盘的条带化:将硬盘空间按照设定的大小分为多个条带,数据写入时也按照条带的大小来划分数据模块。

-

条带 (strip):硬盘中单个或者多个连续的扇区构成一个条带,是组成分条的元素。

-

分条 (stripe):同一硬盘阵列中的多个硬盘驱动器上的相同“位置”(或者说是相同编号)的条带。

-

分条宽度 指一个磁盘组在进行分条时所使用的磁盘的个数,例如一个由3个成员盘组成的磁盘组,其条带宽度为“3”。

-

分条深度 指一个条带的容量大小。

【注意,条带是RAID中单个磁盘上一次读写数据的最小单元】

分条深度对性能的影响

分条深度决定了主机I/O按照RAID算法处理后写入硬盘最大I/O的大小,因此对于不同特征的I/O,分条深度对性能会造成一定的影响。

- 随机小I/O:一般指的是小于16KB大小的I/O。由于I/O的随机性,在Cache中得不到聚合,写入硬盘时基本保持原始大小,因此当分条深度较大达到I/O大小的若干倍时(当前默认为128KB)时,小I/O跨分条单元的几率较低,即I/O被拆分的几率较低。随机小I/O的场景下,受分条深度的影响较小,建议保持默认分条深度128KB即可(具体以产品为准)。

- 顺序小I/O:由于I/O的顺序性,多个小I/O在Cache中会聚合成大I/O,在理想情况下会聚合成分条深度大小的I/O写入硬盘。因此,选择较大的分条深度有利于提升写入硬盘的效率、减少写入硬盘的I/O数量。建议选择大于128KB的分条深度。

- 顺序、随机大I/O:一般指大于256KB大小的I/O。此时如果选择小于I/O大小的分条深度,会导致在RAID层I/O被拆分,从而影响效率。因此,建议选择最大分条深度512KB。

分条深度在CLI模式下通过create storage_pool命令创建存储池时指定,并且指定后无法修改,系统默认值为128KB。

admin:/>create storage_pool name=Test002 disk_type=SAS capacity=100GB stripe_depth=256KB

Command executed successfully.

参考:Hedex Cache配置对写性能的影响

- Cache高低水位

Cache高低水位是指Cache中存储脏数据的最高限制值和最低限制值。如果Cache的高、低水位设置不合理,会影响Cache的写性能。

当Cache中脏数据容量达到最高限制值时,系统将Cache中的脏数据高速同步到硬盘中;当Cache中存储的脏数据容量小于最高限制值而大于最低限制值时,系统将Cache中的脏数据中速同步到硬盘中;当Cache中存储的脏数据容量小于最低限制值时,系统低速同步脏数据到硬盘中。

高低水位的设置建议:

- 高水位不宜设置的太高。如果高水位设置的值太高页面缓冲小,如果前端I/O数量突然增加,会产生I/O波动和时延增大的现象,从而影响写性能。

- 低水位不宜设置太低。如果低水位设置的值太低,会导致后端将缓存数据频繁写入磁盘,降低写性能。

- 高低水位的间距不宜太小。如果取值间距太小,不能很好的利用后端带宽。

- 系统推荐的Cache高水位和低水位的取值分别为80%和20%。

请用户检查当前的Cache高低水位是否符合配置建议。如果不符合请按照规则调整,再观察性能是否有好转。可以通过quota show pttinfo命令查看Cache高低水位配置的详细信息,也可以通过SystemReporter查看Cache相关的性能指标。

通过在CLI下执行change system cache命令可以对高低水位进行配置。关于命令的使用方法请参见对应版本的高级运维命令参考手册。

RAID的数据保护方式

-

方法一:镜像(Mirroring),在另一块冗余的硬盘上保存数据的副本。

-

方法二:奇偶校验算法 (XOR也称异或校验)。

- XOR运算广泛地使用在数字电子和计算机科学中。

- XOR校验的算法——相同为假,相异为真

RAID级别与分类标准

在做存储池的时候定义RAID。

华为存储产品在做RAID1的时候可以选2D或者4D,4D是4块盘组成RAID1,3块盘做镜像,允许同时故障3块。

N为参与阵列磁盘数。

mG为单盘可用容量。

| RAID级别对比项 | RAID 0 | RAID 1 | RAID 3 | RAID 5 | RAID 6 | RAID 10/01 | RAID 50 |

|---|---|---|---|---|---|---|---|

| 容错能力 | 无 | 有(?故障) | 有(1故障) | 有(1故障) | 有(2故障) | 有(?故障) | 有(?故障) |

| 冗余类型 | 无 | 镜像 | 奇偶校验 | 奇偶校验 | 奇偶校验 | 镜像 | 奇偶校验 |

| 热备盘选项 | 无 | 有 | 有 | 有 | 有 | 有 | 有 |

| 读性能 | 高 | 中 | 高 | 高 | 高 | 中 | 高 |

| 随机写性能 | 高 | 低 | 最低 | 低 | 低 | 中 | 中 |

| 连续写性能 | 高 | 低 | 中 | 中 | 低 | 中 | 中 |

| 最小磁盘数 | 2 | 2 | 3 | 3 | 4 | 4 | 6 |

RAID 3的“写惩罚”

RAID 5 四块及以上盘构成时,可以支持并发性能;

RAID 6 P+Q或者DP校验;

RAID2.0+

RAID技术的演变

- LUN虚拟化:在传统RAID基础上将RAID组进行更细粒度地切分,再将切分的单元进行组合,构建主机可访问的空间。(RAID1.5)

- 块虚拟化:将存储池中的硬盘划分成一个个小粒度的数据块,基于数据块来构建RAID组,使得数据均匀地分布到存储池的所有硬盘上,然后以数据块为单元来进行资源管理。【RAID2.0】

LUN虚拟化

LUN(Logical Unit Number)逻辑单元号。

- 存储设备通过块服务为主机提供LUN资源,对于主机来说,一个LUN就是一个磁盘,而无需关心底层是何种RAID技术实现;

- 逻辑卷管理器 LVM(Logical Volume Manager) 是一个将操作系统识别到的磁盘进行组合再分配的软件,LVM屏蔽了存储设备映射给主机的磁盘或LUN的复杂性,通过将这些磁盘或LUN做成卷,以逻辑卷的方式灵活地呈现给操作系统磁盘管理器;

- 物理卷PV(Physical Volume) 存储设备映射给主机的磁盘或LUN被操作系统识别为物理磁盘,通过LVM可以将整个磁盘创建为一个PV,也可以将磁盘的一个分区创建为一个PV;

- 卷组VG(Volume Group) 将多个PV组成一个逻辑上连续编制的卷组,能够屏蔽地城多个物理磁盘的差异,向上提供一个统一管理的磁盘资源池,实现存储空间的动态分配;

- 逻辑卷LV(Logical Volume) 是在VG中创建的最终可供操作系统使用的卷;

在逻辑卷上建立文件系统,这样做有如下好处:

- 存储容量:逻辑卷可以跨越物理磁盘甚至RAID卡,可随意扩容且过程简单。

- 访问性能:逻辑卷可以通过配置来根据应用程序提供优化的性能。

- 数据安全性:逻辑卷可以通过配置内部镜像来提高数据的安全性.

-

传统RAID环境下,一个LUN的读写只能在一个磁盘组中进行;

-

LUN虚拟化:在传统RAID基础上将RAID组进行更细粒度地切分,再将切分的单元进行组合,构建主机可访问的空间。(RAID1.5)

RAID 2.0+ 基本原理

RAID2.0+技术,把物理硬盘划分成很多数据块(chunk,CK),不同盘上的CK组成具备RAID关系的CKG(Chunk Group ),多个CKG组成庞大的存储资源池,主机所用的资源从资源池中获取。

相对于传统RAID机制,RAID2.0+具备如下优势:

-

业务负载均衡,避免热点:数据打散到资源池内所有硬盘上,没有热点,硬盘负荷平均,避免个别盘因为承担更多的写操作而提前达到寿命的上限。

-

快速重构,缩小风险窗口:当硬盘故障时,故障盘上的有效数据会被重构到资源池内除故障盘外的所有盘上,实现了多对多的重构,速度快,大幅缩短数据处于非冗余状态的时间。

-

全盘参与重构:资源池内所有硬盘都会参与重构,每个盘的重构负载很低,重构过程对上层应用无影响。

CK(chunk) 大小为64MB,硬盘域中的硬盘空间被划分为固定大小的CK,实现底层块级虚拟化;(CK类型根据物理硬盘类型不同:SAS、NL-SAS、SSD)

存储池 在硬盘域中创建存储池,而存储池由来自不同硬盘的CK组成;

CKG(Chunk Group) 相同类型的CK按照RAID策略组合为CKG;

Extent CKG被划分为比CK更小的Extent,可根据业务需求定义Extent大小(默认4MB),是存储池中申请空间、释放空间、数据统计、数据迁移的基本单位;

LUN 由多个Extent组成,可以包含一种或多种类型的Extent,当LUN的容量不够用时,可以申请增加Extent来增加容量;

Grain 在Thin LUN模式下,Extent按照固定大小被进一步划分为更细粒度的块,这些块称之为Grain。Thin LUN以Grain为粒度进行空间分配,Grain内的LBA是连续的。

Storage Pool & Tier

-

Storage Pool即存储池,是存放存储空间资源的容器,所有应用服务器使用的存储空间都来自于存储池。

-

Tier即存储层级,存储池中性能类似的存储介质集合,用于管理不同性能的存储介质,以便为不同性能要求的应用提供不同存储空间。

| 存储层级 | 层级名称 | 支持硬盘类型 | 应用 |

|---|---|---|---|

| Tier0 | 高性能层 | SSD | 性能和价格较高,适合存放访问频率很高的数据 |

| Tier1 | 性能层 | SAS | 性能较高,价格适中,适合存放访问频率中等的数据 |

| Tier2 | 容量层 | NL-SAS | 性能较低,价格最低且单盘容量大,适合存放大容量的数据以及访问频率较低的数据 |

华为动态RAID算法

华为全闪存产品功能

-

在发生Flash器件失效后,将主动恢复故障Flash中的数据并继续对数据进行RAID保护。

-

该算法能够动态调整RAID中数据块的数目,从而满足系统可靠性和容量要求。当出现某个CHUNK损坏,并且无法从RAID的成员盘以外选择新的CHUNK时,系统使用动态方式将原来N+M分条中的数据重构至新的(N-1)+M分条中。当有新的SSD盘插入时,系统重构RAID,动态的将原来(N-1)+M分条中的数据搬移至新的N+M分条中,提升硬盘利用率。

-

动态RAID采用EC(Erasure Code)算法,在全SSD盘配置下,能够动态调整CKG中CK的数目,从而满足系统可靠性和容量要求。

RAID-TP

-

现有系统的持续升级意味着客户需要不断购买更高容量的磁盘来逐渐取代现有磁盘,不同容量的磁盘将用于同一系统中。问题是如何在不同容量磁盘混用的环境中保证最佳利用率。

-

RAID-TP采用了华为优化的FlexEC算法,这个算法允许系统容忍三盘同时故障,这样不仅可以提高可靠性,还允许更长的重建时间。

-

与传统的RAID系统相比,使用FlexEC算法重建时实际从单个磁盘读取的数据量减少了70%,降低了对系统性能的影响。

-

在典型的4:2 RAID 6系统中,利用率通常约为67%,而配备25个磁盘的华为OceanStor全闪存存储的容量利用率则大幅度提高了20%。

常用存储协议

- 协议是通信计算机双方必须共同遵从的一组约定。如怎么样建立连接、怎么样互相识别等。只有遵守这个约定,计算机之间才能相互通信交流。

- 协议不仅要定义双方互相通信所使用的语言,还要规定所使用的硬件、传输介质、传输协议以及各自的接口技术等。

SCSI

小型计算机接口(Small Computer System Interface) 指的是一个庞大协议体系,到目前为止经历了SCSI-1/SCSI-2/SCSI-3变迁。

lSCSI协议本质上同传输介质无关,SCSI可以在多种介质上实现,甚至是虚拟介质。

目前最新的SCSI-3标准可以达到640MBps传输速率。

SCSI-3有很多型号,Ultra(fast-20)的传输频率20MHz,数据频宽 8位,传输率20MBps

Ultra wide 的传输频率20MHz,数据频宽16位,传输率40MBps

Ultra 2 的传输频率80MHz,数据频宽16位,传输率80MBps

Ultra 160 的传输频率80MHz,数据频宽16位,传输率160MBps

Ultra 320 的传输频率80MHz,数据频宽16位,传输率320MBps

Ultra 640 的传输频率160MHz,数据频宽16位,传输率640MBps

SCSI逻辑拓扑

- 启动器(Initiator),本质上,SCSI是一个C/S架构,其中客户端成为启动器,负责向SCSI目标器发送请求指令,一般主机系统都充当了启动器的角色。

- 目标器(Target),处理SCSI指令的服务端称为目标器,它接收来自主机的指令并解析处理,比如磁盘阵列或存储设备的角色就是目标器。

- 逻辑单元(LUN),LUN是SCSI目标器中所描述的名字空间资源,一个目标器可以包括多个LUN,而且每个LUN的属性可以有所区别,比如LUN#0可以是磁盘,LUN#1可以是其他设备。

- SCSI的Initiator与Target共同构成了一个典型的C/S模型,每个指令都是“请求/应答”这样的模型来实现。

- Initiator主要任务:发出SCSI请求。

- Target主要任务:回答SCSI请求,通过LUN提供业务,并通过任务管理器提供任务管理功能。

SCSI启动器模型

主机的SCSI系统一般工作中“启动器”模式下面,由于SCSI的体系结构来说,分为了“架构层(中间层)”,“设备层”,“传输层”,故此一般的操作系统,都将SCSI分为三个层次,包括Windows,Linux,AIX,Solaris,BSD。

SCSI目标器模型

SCSI通信过程

- 总线忙 在总线通信开始之前,总线必须处于空闲状态。 启动器发送测试信号确认总线是否空闲;

- 寻址 通过发收双方的地址来确认通信的双方;

- 协商 通信双方协商确定后面数据包的大小和数据包发送的速度;

- 连接 数据包传输阶段;

- 断开连接 数据传输完成,释放总线;

断开重连:有助于缩短设备通信连接时间。只有第一次通信执行五个步骤,之后再次通信可以省略协商这个步骤;

SCSI协议寻址

频宽:假设频宽16位,则可以连接15个设备;

-

传统的SCSI控制器连接单条总线,相应的只具有一个总线号。企业级的一个服务器则可能配置了多个SCSI控制器,从而就可能有多条SCSI总线。在引入存储网络之后,每个FC HBA(Host Bus Adapter)或iSCSI(Internet SCSI)网卡也都各连接着一条总线,因此必须对每一条总线分配一个总线号,在他们之间依靠不同的总线号加以区分。

-

为了对连接在SCSI总线上的设备寻址,SCSI协议引入了SCSI设备ID和逻辑单元号LUN(Logical Unit Number)。在SCSI总线上的每个设备都必须有一个唯一的设备ID,当然服务器中的主机总线适配器也拥有自己的设备ID,固定为7。每条总线,包括总线适配器,最多允许有8个或者16个设备ID。设备ID一方面用以寻址,另一个作用是标识该设备在总线使用上的优先级。

-

每一个存储设备可能包括若干个子设备,如虚拟磁盘、磁带驱动器等。 因此SCSI协议引入了逻辑单元号LUN ID,以便于对存储设备中的子设备进行寻址。

-

使用一个三元描述标识一个SCSI目标:总线号/目标设备ID/逻辑单元号LUN ID。

SCSI协议模型

命令层:也称应用层,包括设备专用的通用指令。

传输层:定义了设备互联的标准规则。保证计算机生成的SCSI指令都能成功的传送到目标端。

物理层:也称互连层。定义了电信号传输方法、数据传输模式之类的接口细节。

SCSI读写操作流

iSCSI

(Internet SCSI) SCSI over internet 我发现就没有TCP/IP霍霍不了的东西。

-

把SCSI命令和块状数据封装在TCP中在IP网络中传输。iSCSI作为SCSI的传输层协议,基本出发点是利用成熟的IP网络技术来实现和延伸SAN。

-

SCSI协议层负责生成CDB,并将其送到iSCSI协议层,然后由 iSCSI协议层进一步封装成PDU,经IP网络进行传送。

iSCSI启动器/目标器

iSCSI Name 每个启动设备和目标设备都有一个IQN(iscsi唯一名字)。启动器和目标器通过IQN互相识别。

iSCSI体系结构

iSCSI节点将SCSI指令和数据封装成iSCSI包,然后该数据封装被传送给TCP/IP层,再由TCP/IP协议将iSCSI包封装成IP协议数据以适合在网络中传输。

iSCSI和SCSI、TCP和IP的关系

FC

项目部署必备技能。

FC(Fibre Channel ) 网状通道。事实上人们大多叫它是光纤通道,诡异得很,或许真的是因为主要用光纤作为介质。

优势:提高扩展性、增加传输距离、解决安全性问题;

FC协议栈结构

-

FC-0:物理界面 这是最下一层, FC-0定义物理连接。它的主要用途是选择协议操作的不同物理介质和数据速率。这种方式确保系统具有最大限度的灵活性, 允许采用现有连接线和不同的技术以满足不同系统的需求。常用连接线为铜缆和光缆。

-

FC-1:字节编码 本层记录8b/10b传输编码用于平衡传输位流。此外, 编码还可以作为数据传输和接受错误检测机制。选择8b/10b编码是因为它的优秀的传输特性, 这个极为稳定的编码降低了部件设计成本同时保证了良好的传输密度易于时钟恢复。注: 8b/10b设计也用于 IBM ESCON。

-

FC-2:数据分发 本层包含在网络内发送数据的基本规则。包括:

-

如何将数据切分为小帧;

-

一次可以发送多少数据(流控制);

-

帧应当发送到什么地方。它同时包括根据应用定义服务等级。

- FC-3:通用服务 本层定义包括条带(通过多条通道传输数据), 多点传送(将一个信息发送到多个目标)和查寻组(为一个节点映射多个端口)等先进功能。于是当FC-2为单一端口定义功能时, FC-3层为可以跨端口定义功能。

- FC-4:高层协议映射 本层将光纤通道性能映射为IP, SCSI或ATM等协议。SCSI是FC协议的子集。

FC的典型组网

点对点 只能连接两个设备,一般用于DAS;

FC-AL仲裁环 最多支持127个设备;传输方向固定,有旁路故障功能;

FC交换网络 最高支持1600多万个设备,其实是指它的地址长度是24bit(呵呵);

FC协议的七种端口类型

设备(节点)端口:

- N_Port:Fabric直连连接设备。

- NL_Port:Loop连接设备。用于连仲裁环。

交换机端口:

- E_Port:扩展端口(交换机到交换机)。

- F_Port:Fabric端口,是Fabric面向用户N_Port的连接点。

- FL_Port:Fabric Loop端口。用于连仲裁环。

- G_Port:普通(Generic)端口,可以转换为E或F端口。默认端口类型。

- U_Port:通用(Universal)端口,用于描述自动端口检测的术语。

FC HBA卡:光纤通道卡,Fibre Channel HBA,用于服务器和光纤阵列的连接。

FC协议通信原理

任何网络都需要寻址机制, FC当然也不例外,但FC的寻址和编制方式与以太网有所不同,例如:在以太网交换机的端口上不需要有MAC地址,而FC交换机上的端口都有自己的WWPN地址,这是因为在FC网络中, FC交换机担当了很重要的角色,它要处理到FC协议的最上层-应用层。也就是说,FC终端设备只负责产生数据,其他功能(封包、流控和安全等)均由FC交换机来保障。

WWN(World Wide Number) 硬件的全球唯一标识。

WWNN(World Wide Node Name)全球唯一节点名字。 64bit,FC交换机和FC HBA卡上会有WWNN。【又叫 Node WWN】不管这个设备上有多少个FC端口,FC设备自身都有一个唯一的WWNN地址来代表它自己。

WWPN(World Wide Port Name)全球唯一端口名字。 64bit, FC设备的每个端口都有一个全球唯一的WWPN地址。 【又叫 Port WWN】

一个设备只有一个WWNN,可以有多个WWPN。

WWN范例:

第一个十六进制字符是生产厂商选择的NAA(Network Address Authority)编码;FC预留;IEEE定义;厂商自定义;

如果用8个字节的WWPN来做路由,是不明智的,因此还需要再映射一层地址。Fabric ID: WWPN和Fabric ID之间需要建立映射关系,就像MAC和IP的映射一

样,设备会为每个连接到FC网络中的接口分配一个Fabric ID,用这个ID嵌入到链路帧中做路由,这个ID长24位,格式如下:

FCID(24bit) —— 在WWPN和FCID之间建立映射关系。

- Domain ID:前8位是Domain ID,用来区分网络中每台FC交换机。WWNN最小者获胜成为主交换机,然后这个交换机向所有其他交换机分配Domain ID。

- Area ID:中8位是Area ID,用来区分同一台交换机上不同的端口组,比如1、2、34端口属于Area 1。

- Port ID:后8位是Port ID,用来区分一个同Area中不同端口

ZONE

FC SWITCH上的Zone功能类似于以太网交换机上的VLAN功能,它是将连接在SAN网络中的设备(主机和存储),逻辑上划到为不同的区域内,使得不同区域中的设备相互间不能FC网络直接访问,从而实现网络中的设备之间的相互隔离。

Zone的功能包含以下两点:

- 防止主机节点访问未经授权的存储。

- 隔离不必要的RSCN(Registered State Change Notification)

zone的必要性

1.安全性:FC SWITCH上的Zone功能类似于以太网交换机上的VLAN功能,它是将连接在SAN网络中的设备(主机和存储),逻辑上划到为不同的区域内,使得不同区域中的设备相互间不能FC网络直接访问,从而实现网络中的设备之间的相互隔离。

2.故障影响的最小化:在一个zone中的设备状态发生变更,会发送RSCN帧,那么接收到该RSCN影响的区域只是包含该设备的zone。

zone的划分方法

1.基于设备的wwpn号,通常也叫软zone

2.基于端口索引(Domain, Index),也就是交换机的端口,通常也叫做硬zone。使用物理端口指定Zone对象时,Zone对象通过一对十进制数字“D,I”来表示。其中,“D”表示交换机的域ID,“I”表示交换机的端口索引号,“D”和“I”之间通过逗号“,”分隔。

3.别名alias,将某些wwn或者端口进行自定义标记,方便zone的划分

zone类型

1.普通zone:设置基本分区,控制各设备或端口之间的访问权限。

2.TI zone: (流量隔离Zone) 当存在多条ISL级联链路(多个E_Port)时,用于指定某条ISL链路只负责传送与该链路E_Port在同一TI Zone内的端口的流量。

3.QoS zone:为指定的链路流量提供高质量的服务,其成员只能是WWN。

zone的划分原则

1、优先推荐基于设备的wwn号的方法,如果设备少应该采用点对点原则的Zoning规划,每一个Zone中只包含一个启动器和一个目标器,这种方法最安全,性能做好,但是如果设备多比较麻烦。

也可以每一个Zone中只包含一个启动器和多个目标器(这些目标器在一个物理存储设备里)这个比较适合设备多的场景。这种方法的好处就是交换机上连线的时候不需要考虑端口是否会插错,缺点就是如果设备的HBA卡坏了或控制器坏了需要从新划分zone

2、其次使用基于端口的方法,这种方法的好处就是如果设备的HBA卡坏了或控制器坏了不用从新划分zone,但是每次连线时候一定要注意zone对应的端口,要不然插错了就不能通信了。

3、注意:规划zone时,最好保证同一zone内的成员都是WWN形式,或者都是端口号形式。尽量避免同一个zone中即出现WWN成员又出现端口成员。

4、注意:不推荐在Fabric无Zoning规划

FCoE

-

FCoE:是定义从FC到IEEE 802.3以太网络的映射协议,使用的是以太网的物理层和数据链路层和FC的网络层、服务层和协议层。

-

FCoE保留FC-2以上的协议栈,把FC中的FC-0和FC-1用以太网的链路层取代。

增强型无损以太网

FCoE需要其他协议支持:由于以太网是可以容忍网络丢包的,但是FC协议不允许出现丢包,那么FCoE做为以太网中传输的FC协议来说同样是继承了这点特点不允许丢包。所以想要FCoE协议可以正常的运行在以太网络中就需要对以太网做一定的增强来避免丢包 ,这种增强型的以太网叫CEE(Converged Enhanced Ethernet)。

SAS

-

SAS:Serial Attached SCSI,是SCSI总线协议的串行标准,即串行连接SCSI。

-

串行接口结构简单,支持热插拔,传输速度快,执行效率高。一般情况下,较大的并行电缆会带来电子干扰,SAS的电缆结构可以解决这个问题。SAS的电缆结构节省了空间,从而提高了使用SAS硬盘服务器的散热、通风能力。

-

SAS采用串行技术以获得更高的传输速率和更好的扩充性,并兼容SATA硬盘。

-

SAS采用点对点架构,目前的传输速率高达3Gbps、 6Gbps、 12Gbps 或更高,支持全双工模式。

PCIe

PCI Express(又称PCIe)是一种高性能、高带宽串行通讯互连标准,最早由英特尔提出,后由外设组件互连特别兴趣组(PCI-SIG)制定,以取代基于总线的通信架构,如:PCI、PCI Extended (PCI-X) 以及加速图形端口(AGP)。

NVMe

- NVMe,全称Non-Volatile Memory Express,非易失性存储器标准。

- NVMe标准是面向PCI-E SSD的,使用原生PCI-E通道与CPU直连可以免去SATA与SAS接口的外置控制器(PCH,Platform Controller Hub)与CPU通信所带来的延时。

- PCI-E是接口形态和总线标准,NVMe是为PCI-E SSD定制的标准接口协议。

RDMA、IB

- RDMA(Remote Direct Memory Access)远程直接内存访问,这是一种通过网络在两个服务器的应用软件之间搬运缓冲区里的数据的方法。

- 低时延

- 高吞吐量

- CPU、OS资源占用很少

目前大致有三类RDMA网络,分别是Infiniband,RoCE,iWARP。其中Infiniband是一种专为RDMA设计的网络,从硬件级别保证可靠传输,而RoCE和iWARP都是基于以太网的EDMA技术,支持相应的verbs接口,如图所示。

RoCE协议中,RoCE v1是基于以太网链路层实现的RDMAt协议,交换机需要支持PFC等流控技术,在物理层保证可靠传输;而RoCE v2是以太网TCP/IPt协议中UDP层实现。

InfiniBand(IB):从一开始就支持RDMA的新一代网络协议。需要支持该技术的网卡NIC和交换机。

RDMA过融合以太网(RoCE):一种允许通过以太网进行RDMA的网络协议。其较低的网络标头是以太网标头,其较高的网络标头,(包括数据)T是IB标头,这支持在标准以太网基础设施(交换机)上使用RDMA,只有网卡是特殊的,支持RoCE。

互联网广域RDMA协议(iWARP):允许通过TCP执行RDMA的网络协议。IB和RoCE中存在的功能在iWARP中不受支持。这支持在标准以太网基础设施(交换机)上使用RDMA。只有网卡应该是特殊的,并且支持iWARP(如果使用CPU卸载),否则所有iWARP堆栈都可以在SW中实现,并且丧失了大部分RDMA性能优势。

CIFS

- 1996年,微软提出将SMB改称为CIFS(Common Internet File System protocol),并加入了许多新的功能。现在CIFS指SMB的统称,目前各个版本分别为SMB1,SMB2,SMB3.0。

- CIFS采用C/S模式,基本网络协议:TCP/IP和IPX/SPX。

NFS

-

网络文件系统(Network File System),在Linux/Unix环境里普遍使用的网络文件共享协议,是IETF标准规范的网络文件共享协议。

-

NFS使用客户端/服务器架构。服务器程序向其他计算机提供对文件系统的访问,客户端程序对共享文件系统进行访问。NFS通过网络让不同类型操作系统的客户端彼此共享文件。

NDMP

- NDMP是一个专门为NAS设备的数据备份系统设计的协议。它可以让NAS设备直接向其所连接的硬盘设备或者位于网络上的备份服务器发送需要备份的数据,这个过程不需要任何备份Client Agent的参与。

- NDMP通常有两种组网方式:

- 2-way

- 3-way

存储系统架构

存储系统架构演变

高端存储架构演变

存储软件技术演变

分布式存储技术演变

分布式存储架构

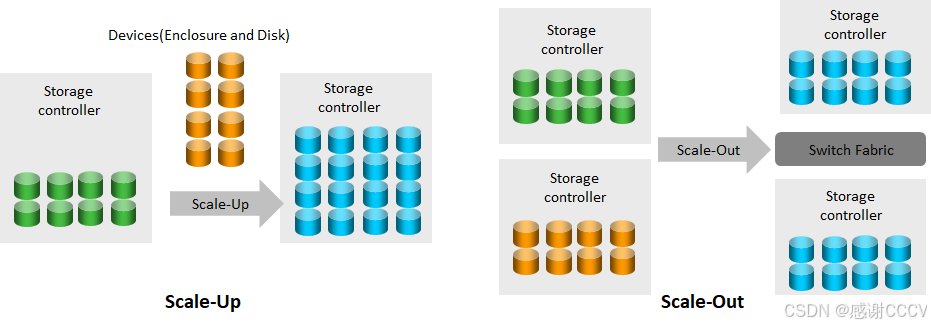

存储系统扩展方式

Scale-Up与Scale-Out

-

Scale-Up:

- 传统的纵向扩展架构,即利用现有的存储系统,通过不断增加存储器件来满足需求;

- 优点:初期操作简单;

- 缺点:随着存储系统规模增加,资源的增加已经到达瓶颈。

-

Scale-Out:

- 横向扩展架构的扩容通常是以节点为单位,通过扩展更多的控制器来满足需求;

- 优点:随着规模增加,单位价格降低,效率提升;

- 缺点:软件复杂度和管理复杂度增加。

华为存储产品架构

双控制器硬件架构

多控制器硬件架构

全互联架构

全互联的硬盘框

端到端全局资源共享

故障秒切 - 前端高级共享卡

全局Cache

全局Pool

后端共享

全均衡 (A-A) 架构

缓存镜像技术

可靠性关键技术

单控故障下的主机业务切换

存储网络架构

DAS

NAS

SAN

分布式

存储网络端口

逻辑端口(可以理解为vlanif)

-

逻辑端口是用户基于绑定端口、VLAN的端口或者以太网端口创建的,是承载主机业务的虚拟端口。

-

每个逻辑端口都会被分配一个唯一的IP地址来承载相应的业务。

-

以太网端口:存储系统接口卡上物理可见的以太网端口。绑定端口、VLAN和逻辑端口的创建都是基于可用的以太网端口的。

-

绑定端口:为了提高文件系统访问路径的可靠性和增加带宽,可以将同一个控制器下的多个以太网端口绑在一起形成绑定端口。

-

VLAN:存储系统上的以太网端口或者绑定端口资源在逻辑上划分成多个广播域,在VLAN内发送或接收业务数据时,给数据加上VLAN ID,实现VLAN之间的网络隔离和业务隔离,从而提高业务数据的安全性和可靠性。

IP漂移

- IP漂移是指逻辑IP地址从故障端口漂移到可用端口上,从而在不中断主机业务的情况下,将故障端口的业务快速切换到其它可用端口上,当故障端口恢复工作后,又可重新接管之前的业务。

- IP漂移的主要功能是在用户无感知的情况下,将故障端口上的业务,快速自动地切换到其它可用端口上,保障业务不中断,提高访问文件系统路径的可靠性。

- IP漂移的实质是当前承载业务端口的切换,这些端口可以是以太网端口、绑定端口或者VLAN的端口。

基于以太网端口的IP漂移

基于绑定端口的IP漂移

基于VLAN的IP漂移

FC组网

- FCR(Fibre Channel Routing)用于链接不同Fabric网络中的设备。与普通交换机E_Port级联不同,交换机通过FCR交换机链接后,两Fabric网络并没有融合,还是之前的两个独立的Fabric。两Fabric之间的链接交换机功能类似于路由器。

- FC Router:启用了FC-FC Routing服务的交换机。

- EX_Port:类似于E_Port类型的端口类型,但不传送Fabric服务或拓扑结构信息。

- Backbone Fabric:具有启用FC Router服务的交换机的Fabric可看作为Backbone Fabric。

- Edge Fabric:连接FC Router的Fabric可看做是Edge Fabric。

- IFL(Inter Fabric Link),在E_Port和EX_Port,或VE_Port和VEX_Port之间的链路,即FC路由链路

分布式存储组网

-

分布式存储简单的来说,将通用服务器的本地HDD、SSD等存储介质组织成一个大规模的存储资源池,然后将数据分散存储到多个数据存储服务器上。

-

分布式存储后端网络一般采用10GE,25GE和IB网络;前端网络一般采用GE,10GE,25GE网络。

网络平面划分

- 管理平面:与用户管理网络对接的平面,用于进行系统管理和维护;

- BMC平面:用于接入管理节点/存储节点Mgmt接口,提供远程硬件设备管理功能;

- 存储平面:内部平面,用于系统内部所有节点之间的业务数据通信;

- 业务平面:与客户应用对接,通过iSCSI/HDFS等标准协议访问存储;

- 复制平面:用于复制节点间进行数据同步复制;

- 仲裁平面:用于与双活仲裁服务器进行通信,只有块服务规划双活功能时才会规划该平面。

- FSM:FusionStorage Manager, 华为分布式存储的管理进程,提供告警、监控、日志、配置等操作维护功能,推荐主备部署。

- VBS:Virtual Block Service,VBS通过SCSI或iSCSI接口提供分布式存储接入点服务,使应用服务器能够通过VBS访问分布式存储资源。

- OSD:Object Storage Device,华为分布式存储的组件,承载分布式集群中用户数据的存储设备。

- REP:Replication,数据复制网络。

- EDS:Enterprise Data Service,企业数据服务组件,接收到来自VBS的I/O业务之后,执行具体的I/O操作。

组网规则

-

节点在机柜中优先从底向上部署。

-

在实际项目应用中,需要计算机柜中存储节点、交换机、KVM的总功耗和总重量,并根据客户机房条件综合判断一个机柜中可容纳的节点数量,设计适合具体项目实际情况的部署方案。

-

在典型配置中,基础柜内部的节点通过网线和SFP+线缆连接到本机柜中的交换机,扩展柜内部的节点需要通过网线和光纤连接到基础柜中的交换机。

存储常用高级技术

资源调优技术(Smart)

SmartThin

精简置备

SmartTier

冷热温数据

SmartQoS

性能调整

SmartDedupe

重复删除

SmartCompression

压缩

SmartMigration

迁移

数据保护技术(Hyper)

HyperSnap

快照

HyperClone

克隆

HyperReplication

远程复制(备份)

HyperMetro

双活,两个DC互为备份且都处于运行状态。

仲裁设备仅支持IP组网

HyperMetro存储双活设计:

- A-A 架构: 双活LUN,双站点均可读写,数据实时同步。

- 高可靠性设计:双重仲裁机制,跨站点坏块修复,提高系统可靠性。

- 高性能设计:提供多种性能优化手段,减少站点间交互延时,业务性能提升30%。

- 灵活扩展设计:支持异构,支持与快照、远程复制联动,可扩展为两地三中心容灾方案。

HyperMetro提供了两种仲裁模式:

- **静态优先级模式:**应用在未配置仲裁服务器的场景。

- **仲裁服务器模式(推荐):**应用在配置了仲裁服务器的场景。(物理或者VM都可以,安装华为专用仲裁软件)

业务连续性解决方案

备份侧重数据安全性,容灾侧重业务连续性。

备份解决方案

备份方案的概念

备份(backup)指在信息技术与数据管理领域中,将文件系统或数据库系统中的数据加以复制;一旦发生灾难或错误操作时,得以方便而及时地恢复系统的有效数据和正常运作。

为何需要备份?法规遵从提出数据保护要求、数据丢失风险无处不在

备份的本质:存储数据的“复制”。

备份的根本目的:意外发生后的数据恢复。

正确的认识备份。

备份与容灾的关系

备份是为了数据恢复,归档是为了法规遵从

备份主要考虑因素

数据备份的特点

备份方案的架构体系

四个构成部分:备份管理系统、备份客户端、备份网络、备份介质。

一套备份系统三大组件:备份服务器,备份软件,备份介质,即存储设备。

备份软件组件主要有:

- Master Server(管理服务器)对备份系统的各模块的系统控制管理,对备份策略、备份任务以及数据恢复的配置界面和过程监控;

- Media Server(介质服务器)负责介质设备的管理,和介质设备通信、读写管理,是备份服务器和介质的中间件;

- Client(备份用户端)备份目标设备,软件模块client负责和Master server通信交换信息;

- Agent(数据库代理)只在数据库备份时需要;

- Management Console(管理终端)是用户GUI,可视化操作界面,管理备份软件操作。

备份系统三要素

BW **BW(Backup Window)**一个工作周期内留给备份系统进行备份的时间长度;

RPO **RPO (Recovery Point Objective)**客户可以承受的最大数据丢失量,故障发生后数据可以恢复到的时间点;

RTP **RTO (Recovery Time Objective)**客户可以承受的最长停机时间;

-

一体化备份,开机即用,一体化解决方案,集成度高,方案高效;

-

数据中心集中备份,主攻大容量数据中心备份项目,安全可靠;

-

虚拟化备份适用于FusionSphere、VMware虚拟化环境备份。

备份方案的组网

LAN-Base 基于LAN的备份,数据流和控制流都基于LAN传输,占用网络资源的备份模式。

LAN-Free 控制流基于LAN传输,数据流不经过LAN。

Server-Free 控制流基于LAN传输,数据流不经过LAN。

存储设备将数据打快照,将快照(设备需要支持)注册到备份服务器,挂载为一台临时VM,将数据写入备份存储设备

Server-Less (NDMP)

NDMP是一个标准网络备份协议,从NDMP4.0开始就支持SAN存储备份,但是迄今为止,大多数厂商都只支持NAS备份,NDMP主要分两种备份组网方式,一种是(本地)2-Way组网,另一种是3-Way组网。NDMP也属于Server Free备份组网模式。

本地2-Way备份模式下,数据在DMA(Data Management Application,一般为备份软件管理服务器)控制下,数据从NDMP主机(主存储)传输到直连的磁带上,不通过LAN本地网络发送备份数据。磁带机必须在NDMP 类型的存储单元中,即备份服务器需要通过NDMP发现带库并加载磁带。

实际上,NAS设备做为主存,备份服务器通过LAN上的NDMP主机来指示NAS设备开始备份,NAS设备通过光纤通道将备份中的数据发送到与其直接连接的磁带设备中。NDMP备份也是在主存上创建文件快照,基于快照备份。备份过程中,通过NDMP将文件和目录信息传输到备份服务器,然后进行编制索引,进行维护。

三向3-Way备份模式下,备份数据需要从NDMP主机(存储)上传输到备份服务器上,然后通过介质服务器写入到磁带设备。通过本地LAN网络传输备份数据,磁带机须连接在介质服务器上。

备份方案的关键技术

常见备份类型:完全备份、累计增量备份、差异增量备份

- 备份策略的选择:

- 多于操作系统和应用软件,在每一次系统更新或者安装了新的软件后,建议做一次全备份;

- 对于关键的应用数据,涉及每天大量的数据更新,但是总数据量不是很大,可以在备份窗口内每天做一个全备份;

- 对于关键应用,如果每天只有少量的数据更新,可以在每月或每周做一个全备份,在此基础上做短时间周期的增量备份。

数据重删

源端重删

并行重删

快照备份

标准备份

持续备份

高级备份

备份方案的典型应用案例

数据库场景

虚拟化平台场景

文件系统场景

操作系统场景

容灾解决方案

容灾定义

容灾是指,除了生产站点以外,用户另外建立的冗余站点,当灾难发生,生产站点受到破坏时,冗余站点可以接管用户正常的业务,达到业务不间断的目的。为了达到更高的可用性,许多用户甚至建立多个冗余站点。

常用容灾解决方案

容灾备份解决方案框架

容灾设计模式 - 同步、异步相结合

主备容灾方案

双活容灾方案

两地三中心 (3DC) 容灾方案

云计算下的新灾备模式演进

云主备数据级容灾实现方式

容灾技术

基于主机层

- 应用级

- 数据库级

- 逻辑卷级

基于网络层

基于阵列层

- SAN同步复制容灾

- SAN异步复制容灾

- NAS异步复制容灾

- 异步远程复制多时间点技术 - 秒级RPO

- 远程复制 - 应用一致性

- 远程复制 - 一致性组

- 几种容灾技术的对比

- 典型的容灾演习方案

存储系统运维管理

存储系统操作管理

存储管理工具

基础管理操作

存储系统运维管理

通用运维管理流程

常用存储系统运维管理工具

典型存储系统运维场景流程方法

802

802

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?