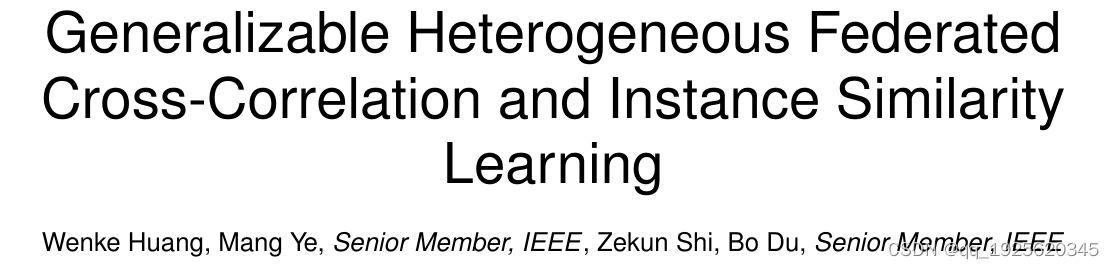

TPAMI2023,提出了一种新颖的 FCCL+,即带有非目标蒸馏的联邦相关性和相似性学习,促进了域内可辨别性和域间泛化。对于异构性问题,我们利用不相关的未标记公共数据进行异构参与者之间的通信。我们构建了互相关矩阵并在 logits 和特征级别上对齐实例相似性分布,有效地克服了沟通障碍并提高了泛化能力。对于局部更新阶段的灾难性遗忘,FCCL+ 引入了联邦非目标蒸馏,它在避免优化冲突问题的同时保留了域间知识,通过描述后验类关系充分蒸馏了特权域间信息。

贡献

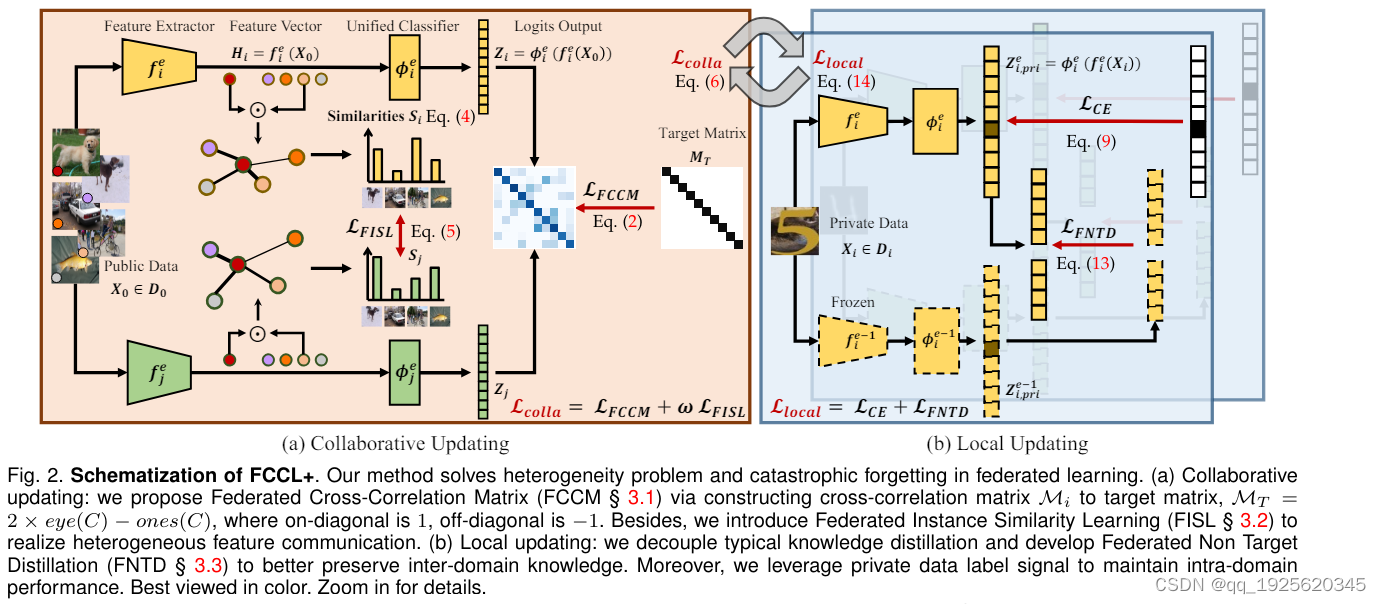

- 我们在联邦学习中引入了一种有效的异构特征知识转移策略——联邦实例相似性学习(FISL),以在异构参与者之间建立连接,而无需额外的共享网络结构设计。通过对齐未标记公共数据之间的实例相似度分布,异构模型实现特征信息通信。与提出的联合互相关矩阵(FCCM)合作,我们实现了逻辑和特征级别的知识通信,从而获得了更好的泛化能力。

- 我们解开了典型的知识蒸馏,并开发了联合非目标蒸馏(FNTD),以在本地更新阶段更好地保留跨领域知识。与私有数据标签监督(域内信息)约束配合,它有效地平衡了多个领域知识,从而解决了灾难性遗忘问题,提高了域间和域内的性能。

- 我们为异构和同构联邦学习提供统一基准,支持各种最先进的方法。我们使用未标记的公共数据(例如 Cifar-100、Tiny-ImageNet 和 Fashion-MNIST)在大规模场景(即 Digits、Office Caltech、Office31 和 OfficeHome)上严格验证所提出的方法。我们进一步提供详细的消融研究和深入讨论以验证其有效性。

算法流程

分为本地更新和联合更新两部分,联合更新发生在通讯的时候,考虑特征矩阵的相似性FCCM和实例级的相似性FISL,所用的数据是未标注的公共数据集;本地更新则是client内部更新,考虑的是灾难性遗忘问题,提出FNTD避免不兼容的优化问题,所用数据集是本地私有数据。

Federated Cross-Correlation Matrix

这部分和之前那篇FCCL一模一样, Z i Z_i Zi表示第 i i i个参与者对应样本集(未标注公共数据)输出的logits, b b b 表示批次样本, u 、

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3084

3084

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?