大数据环境安装脚本升级

功能新增&调整

最近对大数据环境安装脚本进行了升级。相比上一个版本,增加了以下功能:

-

增加HBase集群安装。

-

增加Spark一键安装。

-

增加HUE一键编译安装。

-

增加Maven一键安装,并配置国内阿里镜像源。

-

增加NodeJS一键安装,并配置国内阿里镜像源。

-

HBase、Spark安装配置文件frames.txt格式有所调整。

# 安装包名 是否安装(true/false) 安装节点 主节点 hbase-2.0.0-bin.tar.gz true node01,node02,node03 node02 -

Hadoop安装脚本升级,增加了HistoryServer配置,并根据是否安装HUE添加适配参数。

-

Hive安装脚本升级,支持安装2.x版本,配置参数优化调整,自动修复元数据问题。

-

升级集群安装入口脚本clusterOperate.sh,添加对host_ip列表的集群进行一键环境初始化。

-

batchOperate.sh脚本做了细节调整。

新版本的脚本,已经提交到hive分支中,master分支因为之前的课程原因暂不进行升级,之后测试通过后再进行合并。

附上脚本开源地址:https://github.com/MTlpc/automaticDeploy

大数据环境一键安装

大数据环境使用脚本安装时,与之前相比,只有第3步不同。这里直接在一个节点上,执行clusterOperate.sh,便会对集群所有节点进行脚本分发、安装包分发、环境初始化,简化了使用步骤。

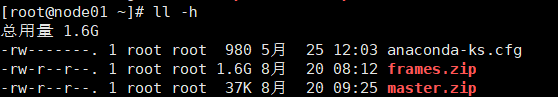

- 下载frames.zip包,里面包含大数据组件的安装包,并上传到node01中

链接:https://pan.baidu.com/s/1XxuouuogndEc6vIIiUhyTw

提取码:i4ki

复制这段内容后打开百度网盘手机App,操作更方便哦

- 将frames.zip压缩包,解压到/home/hadoop/automaticDeploy目录下

unzip frames.zip -d /home/hadoop/automaticDeploy/

- 进行集群环境配置,并分发安装脚本和文件

/home/hadoop/automaticDeploy/systems/clusterOperate.sh

-

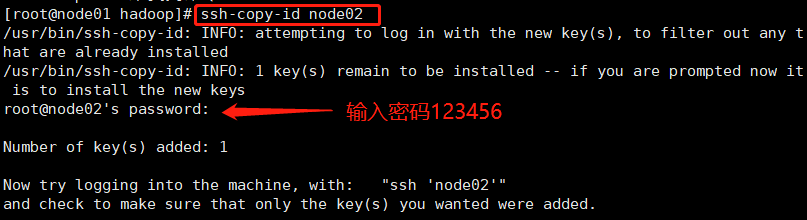

为了避免脚本中与各个节点的ssh因为环境问题,执行失败,需要手动测试下与其它节点的ssh情况,如果失败,则手动添加

-

失败后重新添加SSH

ssh-copy-id node02

- 在各个节点执行脚本,安装Hadoop集群

/home/hadoop/automaticDeploy/hadoop/installHadoop.sh

source /etc/profile

# 在Node01节点执行,初始化NameNode

hadoop namenode -format

# 在Node01节点执行,启动Hadoop集群

start-all.sh

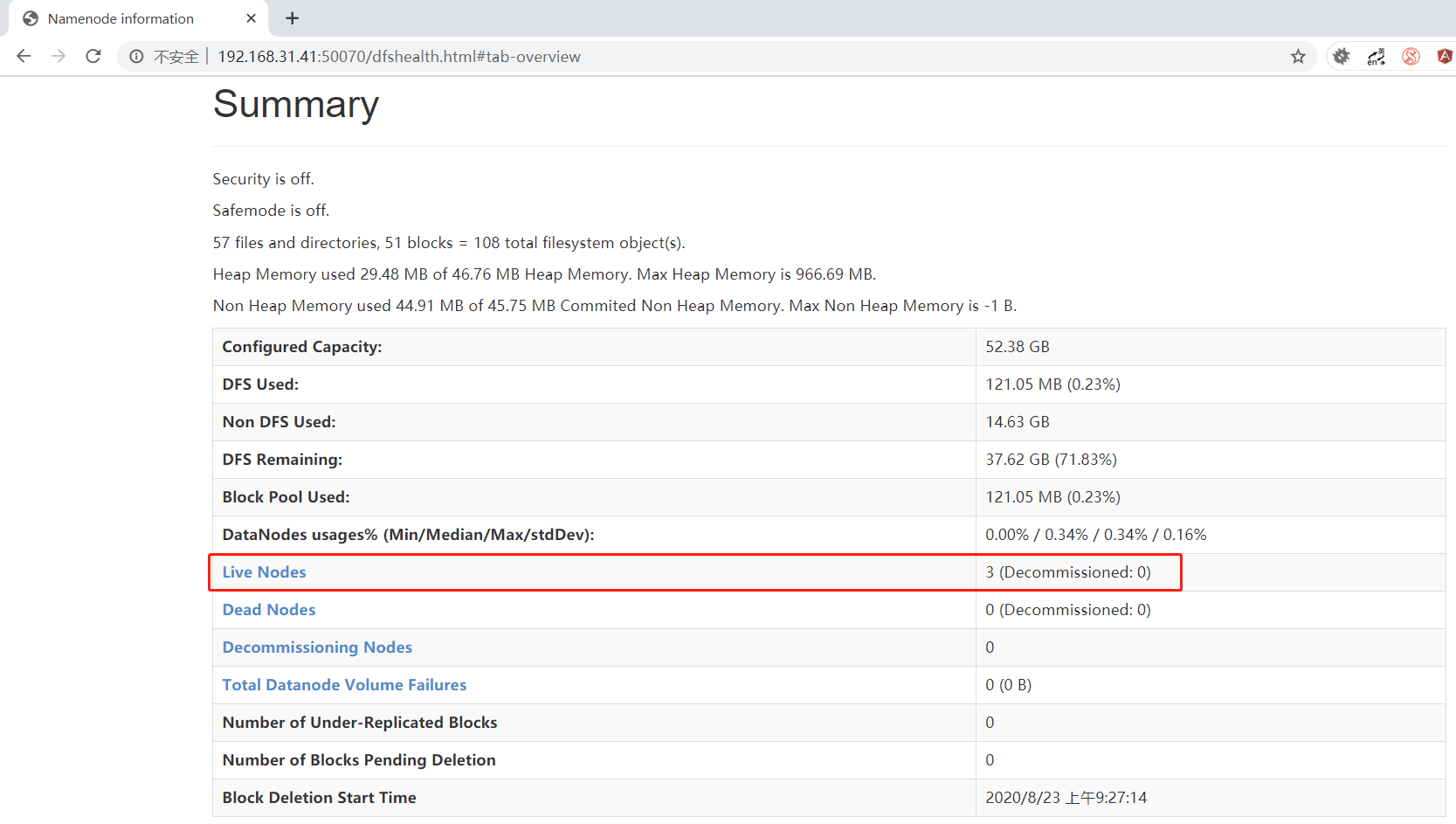

- 使用本地浏览器访问node01:50070,成功则说明Hadoop搭建成功

后话

如果有帮助的,记得点赞、关注。在公众号《数舟》中,可以免费获取专栏《数据仓库》配套的视频课程、大数据集群自动安装脚本,并获取进群交流的途径。

我所有的大数据技术内容也会优先发布到公众号中。如果对某些大数据技术有兴趣,但没有充足的时间,在群里提出,我为大家安排分享。

公众号自取:

512

512

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?