目录

现在AI模型大家应该都不陌生,使用AI可以极大的提高我们工作和生活的变量,但是我们大多是使用的AI都需要联网或者收费,那么有没有想要部署一个自己专属的AI大模型呢,今天就带大家来操作一下。

本次是基于CentOS7.9环境进行的操作,并且采用容器化方式部署,大大简化了操作流程

准备Docker环境

安装Docker

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo

yum -y install docker-ce docker-ce-cli containerd.io

启动Docker

# 启动服务

systemctl start docker

systemctl enable docker准备Docker-Compose

安装Docker Compose的时候可能会因为网络安装的慢或者无法安装,可以开启魔法,也可以评论区@我

curl -L "https://github.com/docker/compose/releases/download/1.24.1/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

chmod +x /usr/local/bin/docker-compose

ln -s /usr/local/bin/docker-compose /usr/bin/docker-compose

docker-compose --version准备源代码

git clone https://github.com/open-webui/open-webui.git

[root@bogon ~]# git clone https://github.com/open-webui/open-webui.git

Cloning into 'open-webui'...

remote: Enumerating objects: 22440, done.

remote: Counting objects: 100% (517/517), done.

remote: Compressing objects: 100% (183/183), done.

remote: Total 22440 (delta 301), reused 460 (delta 272), pack-reused 21923

Receiving objects: 100% (22440/22440), 48.51 MiB | 1.70 MiB/s, done.

Resolving deltas: 100% (14679/14679), done.

启动服务

修改docker-compose.yaml文件

# 修改第一行版本

# 注释第14行到第18行

[root@bogon open-webui]# cat docker-compose.yaml

version: '3'

services:

ollama:

volumes:

- ollama:/root/.ollama

container_name: ollama

#pull_policy: always

tty: true

restart: unless-stopped

image: ollama/ollama:${OLLAMA_DOCKER_TAG-latest}

open-webui:

#build:

# context: .

# args:

# OLLAMA_BASE_URL: '/ollama'

# dockerfile: Dockerfile

image: ghcr.io/open-webui/open-webui:${WEBUI_DOCKER_TAG-main}

container_name: open-webui

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

ports:

- ${OPEN_WEBUI_PORT-3000}:8080

environment:

- 'OLLAMA_BASE_URL=http://ollama:11434'

- 'WEBUI_SECRET_KEY='

extra_hosts:

- host.docker.internal:host-gateway

restart: unless-stopped

volumes:

ollama: {}

open-webui: {}

启动

[root@bogon ~]# cd open-webui/

[root@bogon open-webui]# docker-compose up -d --build

# 启动完成以后查询容器状态

[root@bogon open-webui]# docker-compose ps

Name Command State Ports

---------------------------------------------------------------------------------

ollama /bin/ollama serve Up 11434/tcp

open-webui bash start.sh Up 0.0.0.0:3000->8080/tcp,:::3000->8080/tcp

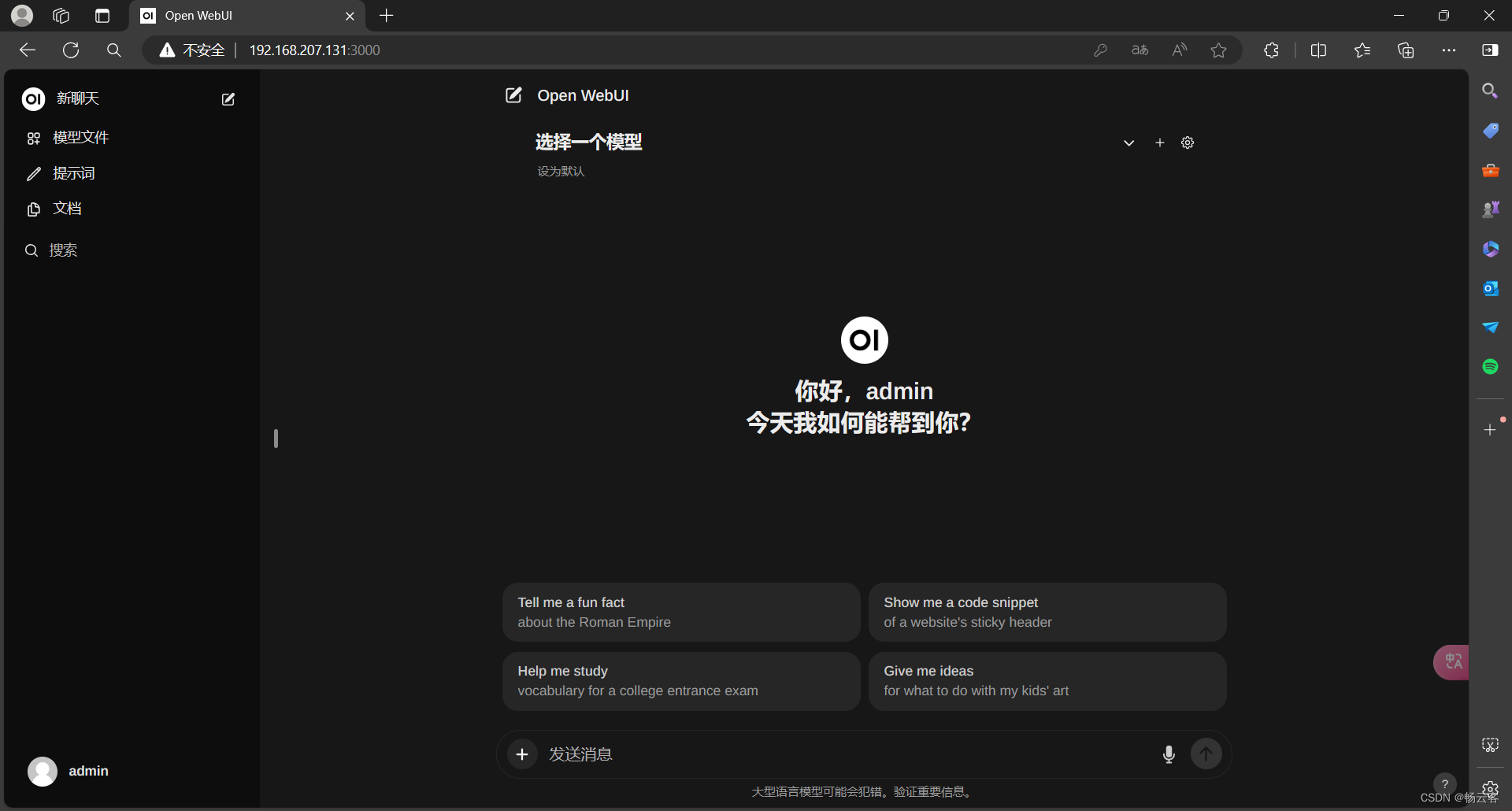

测试使用

访问

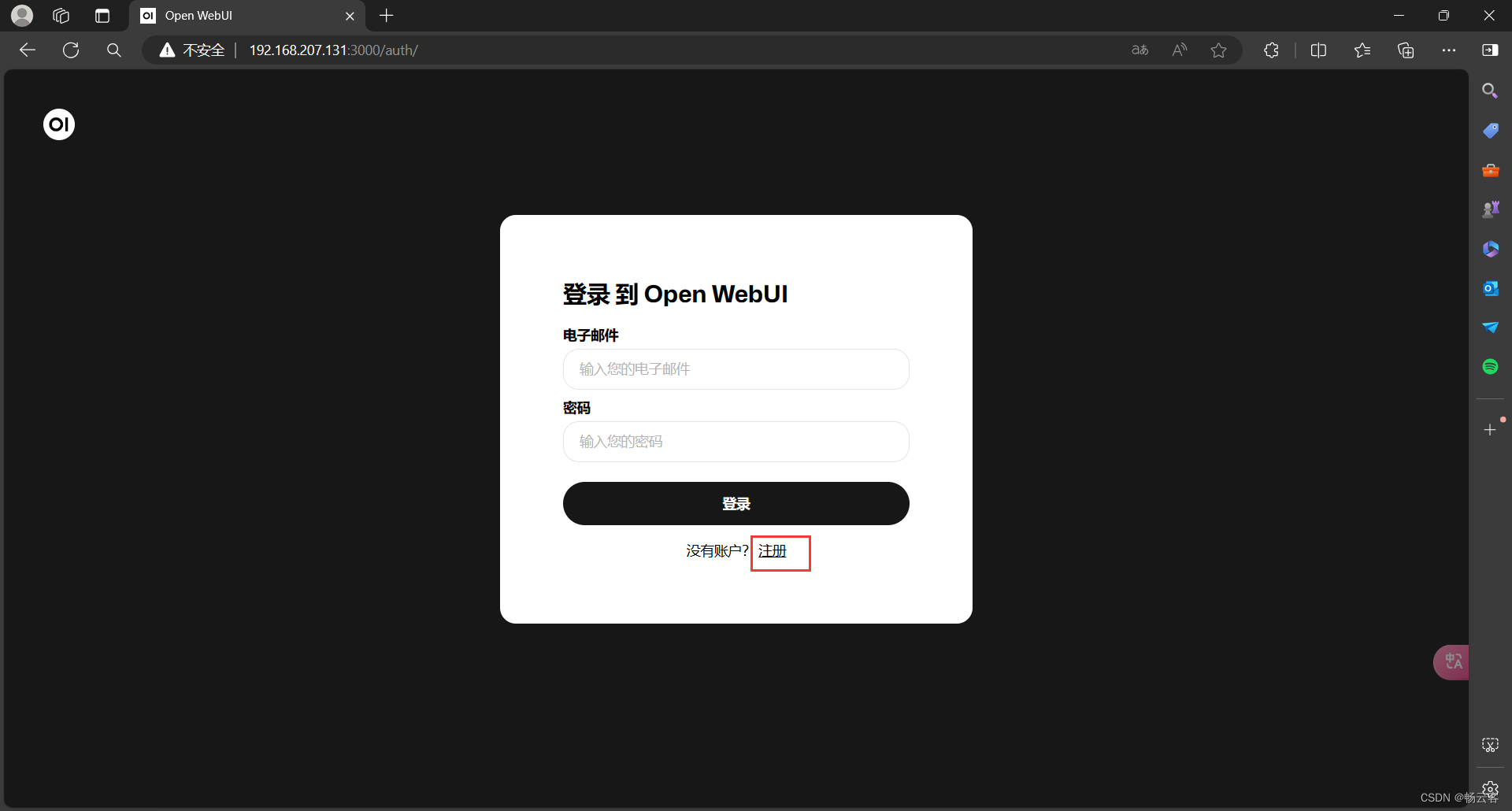

打开浏览器访问服务器的ip加上3000端口

http://192.168.207.131:3000

注册账号

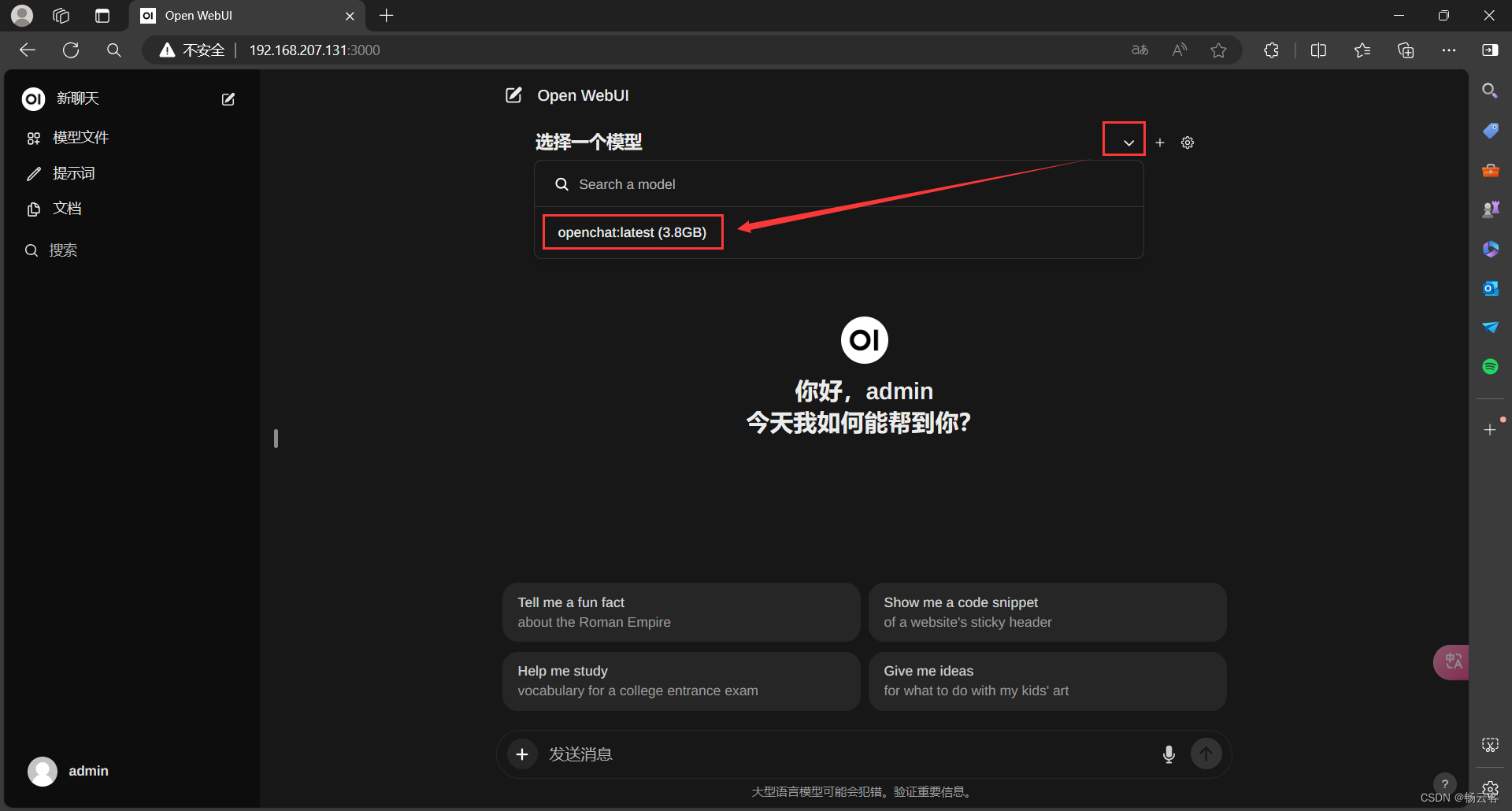

选择模型

ollama里面有很多模型可以使用,但是需要我们下载,经过测试觉得比较好用的一个是openchat(当然也有其他的,大家可以多测试测试,选择一个好用的,这里面我就用openchat了)

下载模型

下载完成以后会有>>>提示符输入/bye按回车即可

[root@bogon open-webui]# docker exec -it ollama ollama run openchat

pulling manifest

pulling 1cecc26325a1... 100% ▕█████████████████████▏ 4.1 GB

pulling 43070e2d4e53... 100% ▕█████████████████████▏ 11 KB

pulling d68706c17530... 100% ▕█████████████████████▏ 98 B

pulling 415f0f6b43dd... 100% ▕█████████████████████▏ 65 B

pulling 278996753456... 100% ▕█████████████████████▏ 483 B

verifying sha256 digest

writing manifest

removing any unused layers

success

>>> /bye

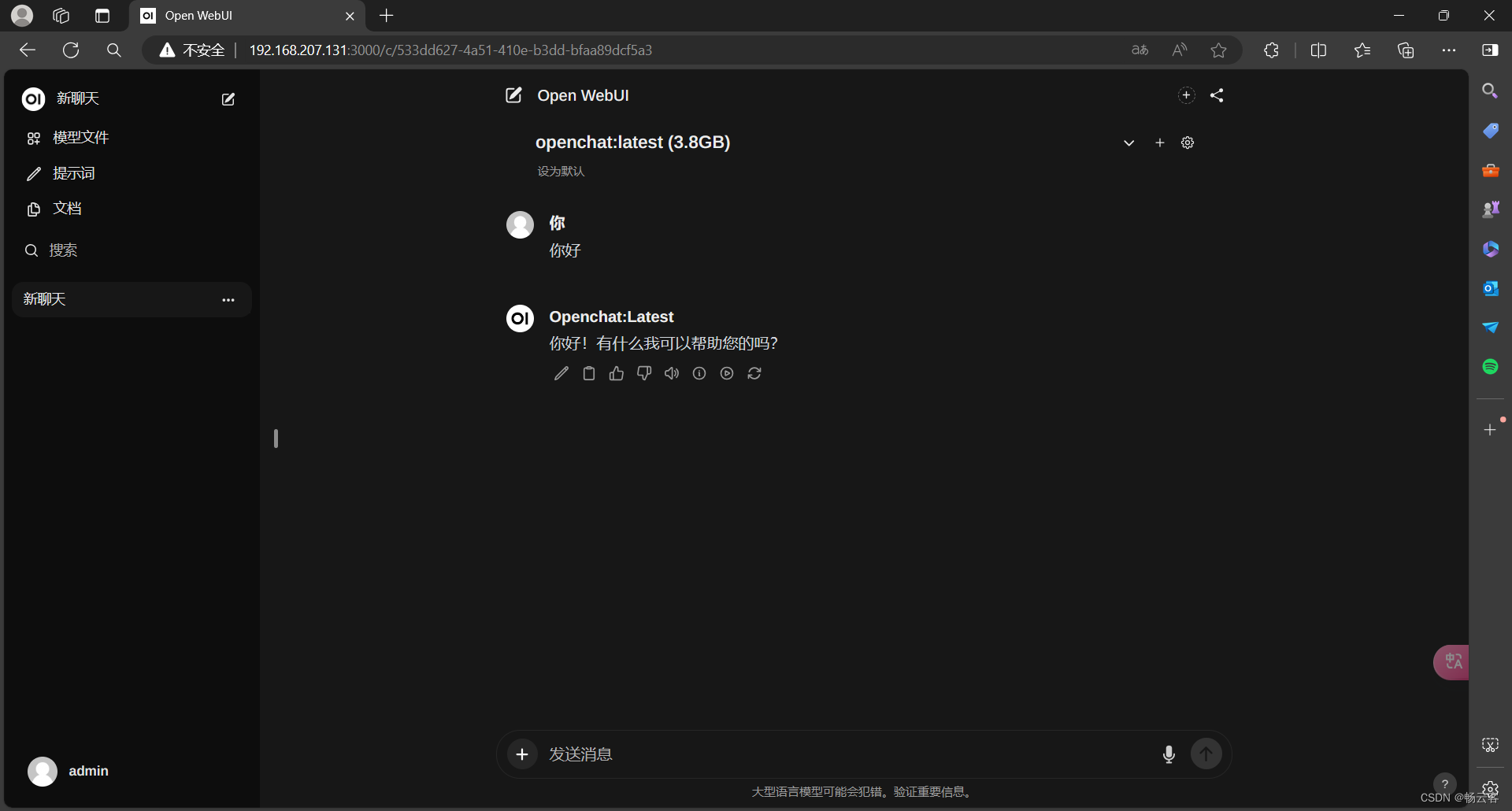

刷新浏览器,选择模型

接下来你就可以尽情体验了

1576

1576

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?