AI 增强音频插件详解

AI增强音频插件是指利用人工智能技术来处理、分析或生成音频信号的软件插件。这些插件将传统的数字信号处理技术与机器学习算法相结合,为音频制作带来了全新的可能性。

核心概念

什么是音频插件

音频插件是在数字音频工作站(DAW)中运行的软件组件,用于处理音频信号。常见格式包括:

- VST/VST3 (Virtual Studio Technology)

- AU (Audio Units) - macOS专用

- AAX (Avid Audio eXtension) - Pro Tools专用

- LV2 - 开源标准

AI如何增强音频插件

AI技术通过以下方式增强传统音频处理:

- 学习复杂的非线性关系 - 传统算法难以建模的复杂音频变换

- 自适应处理 - 根据输入音频的特征动态调整处理参数

- 智能分析 - 自动识别音频内容的特征和模式

- 创造性生成 - 基于学习的模式创造新的音频内容

主要应用类型

1. 硬件建模与仿真

模拟经典硬件设备的声音特征

- 管子放大器建模 - 使用神经网络学习真空管放大器的非线性特性

- 吉他效果器仿真 - 模拟经典的失真、过载、合唱等效果

- 模拟设备建模 - 重现vintage压缩器、均衡器的特殊音色

技术特点:

- 使用WaveNet、LSTM等网络架构

- 通过大量硬件录音数据训练

- 能够捕捉传统建模难以表达的细微差别

2. 智能音频处理

自动化和智能化的音频处理

- 智能均衡 - 自动分析音频频谱并应用合适的EQ设置

- 自适应压缩 - 根据音频动态特性自动调整压缩参数

- 智能降噪 - 使用深度学习区分信号和噪声

- 声音增强 - 智能提升音频质量和清晰度

3. 音频分析与转换

理解和转换音频内容

- 音频转MIDI - 将音频信号转换为MIDI音符数据

- 音高检测与修正 - 自动检测并修正音高不准确的问题

- 和弦识别 - 自动识别音频中的和弦进行

- 节拍检测 - 智能分析音频的节拍和节奏模式

4. 创意生成工具

基于AI的音乐创作辅助

- 旋律生成 - 基于风格学习生成新的旋律线条

- 和声生成 - 为给定旋律自动配置和声

- 节奏生成 - 创造符合特定风格的鼓点模式

- 音色变换 - 将一种乐器的音色转换为另一种

技术实现方式

神经网络架构

常用的网络类型:

- 循环神经网络 (RNN/LSTM/GRU)

- 适合处理时序音频数据

- 能够记忆长期依赖关系

- 常用于音序生成和时间建模

- 卷积神经网络 (CNN)

- 擅长提取音频的频域特征

- 用于音频分类和模式识别

- 常与其他网络结合使用

- 生成对抗网络 (GAN)

- 用于高质量音频生成

- 能够学习复杂的数据分布

- 在音色转换中表现出色

- Transformer架构

- 处理长序列音频数据

- 注意力机制捕捉全局关系

- 在音乐生成中越来越流行

实时处理挑战

AI音频插件面临的技术挑战:

- 延迟要求 - 音频处理通常要求<10ms的延迟

- 计算资源限制 - 需要在有限的CPU/内存下运行

- 实时安全性 - 不能在音频线程中进行内存分配

- 跨平台兼容性 - 需要在不同操作系统和硬件上稳定运行

实际应用案例

商业产品

- iZotope Neutron - AI辅助混音插件

- LANDR Mastering - AI自动母带处理

- Output Arcade - AI驱动的样本库和创作工具

开源项目

- Neural Amp Modeler - 开源的放大器建模插件

- ChowTapeModel - 使用AI建模的磁带仿真插件

- MelAI - AI旋律生成插件

开发生态系统

核心技术栈

- JUCE框架 - 跨平台音频应用开发

- RTNeural - 实时神经网络推理引擎

- PyTorch/TensorFlow - 模型训练

- ONNX - 模型格式标准化

开发流程

- 数据收集 - 收集训练所需的音频数据

- 模型训练 - 使用Python/PyTorch训练神经网络

- 模型导出 - 转换为适合实时推理的格式

- 插件集成 - 在JUCE项目中集成推理引擎

- 优化调试 - 确保实时性能和稳定性

未来发展趋势

技术发展方向

- 更高效的网络架构 - 专为音频优化的轻量级模型

- 边缘计算优化 - 更好的移动设备和嵌入式支持

- 多模态融合 - 结合音频、MIDI、乐谱等多种信息

- 个性化定制 - 根据用户偏好自适应的AI系统

应用领域扩展

- 教育工具 - AI辅助的音乐学习和训练

- 无障碍技术 - 为听力障碍人士提供音频辅助

- 游戏音频 - 动态生成的游戏背景音乐

- 虚拟现实 - 沉浸式3D音频体验

AI增强音频插件代表了音频技术的未来发展方向,它不仅提高了音频处理的质量和效率,还为音乐创作和音频制作开辟了全新的创意空间。随着AI技术的不断进步,我们可以期待更多创新的应用和突破性的功能出现。

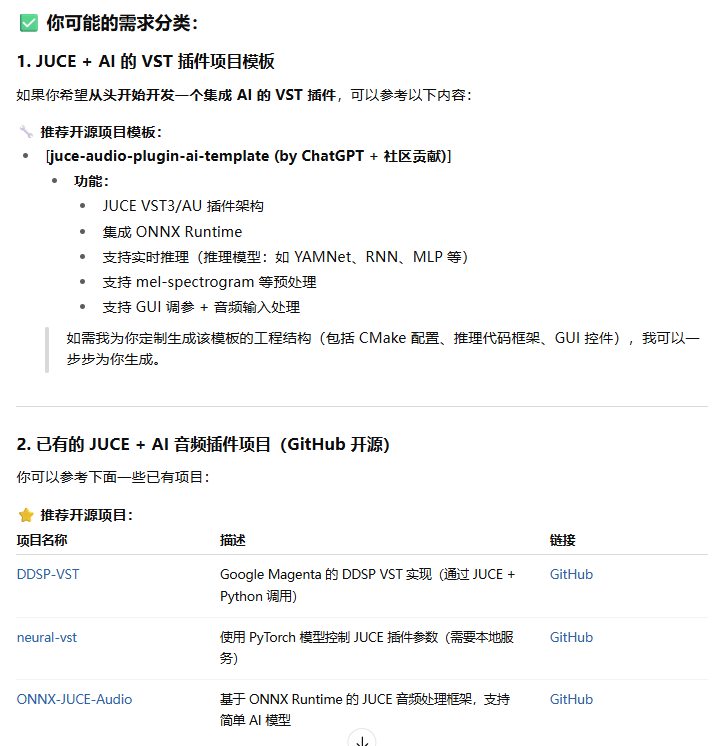

开源 JUCE AI

| 项目名称 | 功能聚焦 | AI 技术栈 | JUCE 插件形式 |

|---|---|---|---|

| ai‑enhanced‑audio‑book | 音效建模、分类 | libtorch / RTNeural | ✅ |

| magenta DDSP‑VST | 音频生成、神经合成 | Magenta / DDSP | ✅ |

| SmartGuitarAmp | 吉他音色建模、AI 效果 | WaveNet / 深度网络 | ✅ |

| RAVE_VST | 音频生成、模型部署 | RAVE 模型 | ✅ |

开源 JUCE 合成器 AI

以下是一些 开源的 JUCE + AI 合成器项目,可用于学习如何将神经网络模型嵌入到 JUCE 插件中,实现 AI 驱动的声音合成或音色匹配:

推荐项目列表

1. magenta/ddsp‑vst

Google Magenta 团队开发的 实时 DDSP 合成器插件,基于 JUCE + DDSP 实现的 VST/AU,支持实时神经音色合成与模型控制(如 MIDI 驱动的 timbre 转换)。代码开源,可作为合成器插件集成 AI 的参考框架。arXiv+8Junichi Shmizu+8arXiv+8

相关的学术实现和参考:SMC704/juce‑ddsp 提供了基于 JUCE 的 DDSP 插件源码,适合用于 timbre transfer、神经音色合成等应用。arXiv

2. GuitarML / SmartGuitarAmp

JUCE 插件实现的 WaveNet 神经网络音频建模,用于模拟吉他电子管放大器的声音。虽然主要是效果模拟,但演示了将深度学习模型嵌入 JUCE 插件的过程,对音色合成或音色模拟非常有启发意义。Junichi Shmizu

3. Neural Wavetable Synthesizer(Neural Wavetable)

源自论文的概念验证项目:基于神经网络生成可演奏 wavetable 的合成器插件(VST/AU),通过 autoencoder 在 latent 空间中生成波形,可用于实时演奏与音色变化。Junichi Shmizu+3arXiv+3GitHub+3

4. DiffMoog

一个开源的 Differentiable Modular Synthesizer,支持自动声音匹配和参数预测。它提供了可区分的模块如 LFO、滤波器、包络等,结合 encoder 网络来预测合成器参数,使其能够自动复制输入音色。非常适合研究将 AI 模型集成到合成器参数控制系统中。

| 项目名称 | 功能聚焦 | AI 技术栈 | JUCE 插件形式 |

|---|---|---|---|

| ddsp‑vst / juce-ddsp | 神经音色合成、timbre 转换 | Magenta DDSP + JUCE | ✅ VST/AU 实时 |

| SmartGuitarAmp | WaveNet 模拟音色 | WaveNet + JUCE | ✅ VST 插件 |

| Neural Wavetable | wavetable 神经生成 | Autoencoder / latent 空间 | ✅ VST/AU 插件 |

| DiffMoog | AI 控制合成参数匹配 | 可微分合成结合 encoder | ✅ 可集成框架 |

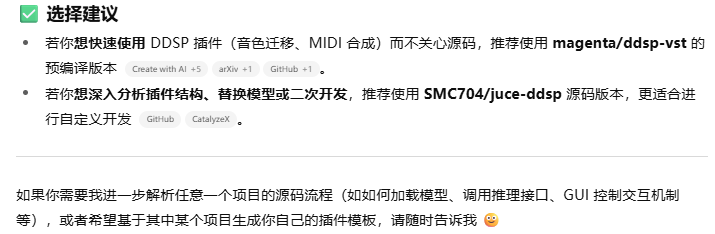

推荐使用方式

-

学习插件结构:从

ddsp-vst和SmartGuitarAmp的代码中了解如何在 JUCE 中加载神经网络模型、处理 MIDI 输入、并输出音频。 -

模型集成思路:

-

若已有 ONNX 或 TorchScript 模型,可以考虑在 JUCE 中使用 libtorch / ONNX Runtime 进行推理;

-

如果你希望实现基于参数预测的声合成(如 DiffMoog 的思路),可以把模型作为控制器嵌入合成链;

-

-

技术迁移和参考:

-

Neural Wavetable提供了基于 autoencoder 的 wavetable 生成思路; -

DiffMoog可供参考如何将 AI 模型用于参数配置优化及自动化匹配。

-

下一步建议

如果你希望我帮你生成一个 AI‑辅助合成器插件工程模板(包括 JUCE+ONNX/tLlib/模型加载、GUI 控件、声音输出框架等),请告诉我:

-

你想要实现的功能比如:声音生成、音色匹配、MIDI 控制跌调制等;

-

模型格式(ONNX / TorchScript / libtorch / Python 转本地);

-

是否需要实现实时低延迟处理以及图形界面;

-

是否希望支持参数预测和自动优化。

我可以帮助你构建项目结构,提供样板代码,甚至包括示例模型调用流程。

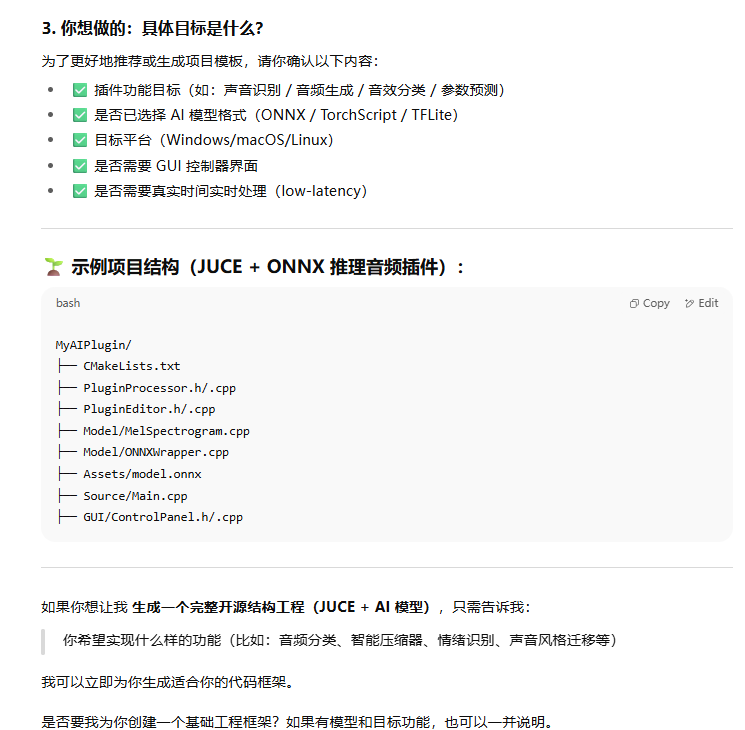

1.DDSP

适合用于了解 AI 驱动的合成器在 JUCE 中的实时部署实现。

1. magenta/ddsp‑vst(DDSP‑VST 插件)

这是 Google Magenta 团队提供的 实时基于 DDSP 的神经合成器和效果器 插件,支持 VST3 与 AU 格式,并通过 JUCE 6.x 构建,实现 MIDI 控制、音色转换与神经声音生成等功能GitHub+15GitHub+15GitHub+15。

-

构建方式:

-

使用 CMake(支持 Ninja 构建)或 Projucer

-

macOS 使用 Xcode,Windows 使用 Visual Studio 2022

-

编译后分别生成 DDSP Synth 和 DDSP Effect 两个插件GitHub+10GitHub+10GitHub+10

-

-

运行依赖:需要 TensorFlow C 库(tensorflow.dll / dylib)与 aubio,以及

Models文件夹与插件放在同目录GitHub

该插件基于论文“Real‑time Timbre Transfer and Sound Synthesis using DDSP”,以实时语音或音频输入转换 timbre 为目标,支持 GUI 调整与 MIDI 控制GitHub+9arXiv+9GitHub+9。

magenta/ddsp: DDSP: Differentiable Digital Signal Processing

2. SMC704/juce‑ddsp(由论文作者提供)

该版本由 SMC704(研究作者之一)维护,目标为论文中的实时 timbre 转换插件,基于 JUCE 6.0.5 开发。

-

项目结构包含

SharedCode(核心代码)、StandalonePlugin和VST3插件模块 -

使用 Projucer 导出工程,支持 Visual Studio 和 Xcode 编译kvraudio.com+13GitHub+13GitHub+13

此版本实现完整与 Magenta ddsp‑vst 等价功能,是学习 AI 合成器在 JUCE 插件中嵌入模型的极佳参考。

| 项目名称 | 功能聚焦 | 技术栈 | 插件格式 |

|---|---|---|---|

| magenta/ddsp‑vst | 实时 DDSP 合成与 timbre 转换 | JUCE + DDSP + TensorFlow C API | VST3 / AU |

| SMC704/juce‑ddsp | 论文实现版,实时合成器插件 | JUCE 6.0.5 + TensorFlow C + aubio | VST3 / Standalone |

如何上手与使用

构建指引

-

克隆项目,运行

repo-init.sh下载模型与子模块。 -

使用 CMake 或 Projucer 生成平台工程文件。

-

将依赖库(tensorflow、aubio)与

Models文件夹放到插件可执行目录中。 -

编译并安装 VST3/AU 插件,然后在 DAW(例如 Ableton、Logic 或 Reaper)中加载测试GitHub+10GitHub+10GitHub+10Junichi ShmizuJuce+2GitHub+2arXiv+2GitHub。

功能使用示例

-

载入音频作为输入,通过 MIDI 控制产生实时转换后的合成声音。

-

GUI 控件包括音量、合成器参数、模型选择等;

-

可用于音色风格迁移、虚拟乐器音色同步等应用场景。

🔎 拓展参考

-

可参考音频开发工具合集 Yuan‑ManX/audio‑development‑tools,里面列出了 MIDI‑DDSP、DDSP‑VST 等相关项目GitHub。

-

若计划将合成器移植至 Android,可查看 atsushieno/aap-juce-ddsp 项目,这是一个基于 Android AAP 平台移植的版本GitHub。

🛠️ 如果你想继续

-

我可以帮你深入分析其中一个项目的代码结构(如模型加载、音频处理流程、GUI 实现等)。

-

如果你想基于此定制一个基础合成器插件模板,支持指定功能(如 timbre 控制、MIDI 输入、声音输出等),我可以帮你设计工程结构,并提供样板 C++ + JUCE 项目。

需要什么样的进一步支持,我随时愿意协助 😄

DDSP

DDSP(Differentiable Digital Signal Processing,可微数字信号处理)是 Google Magenta 提出的一个结合传统音频合成技术与神经网络的框架,专为实现高质量、可控制的声音合成而设计。它既保留了 DSP 的结构化可解释性,又引入了深度学习的表示能力。

下面是对 DDSP 及其插件(如 DDSP-VST)功能的全面介绍:

🎧 什么是 DDSP?

DDSP 是一个声音合成框架,它使用深度学习模型控制传统 DSP 模块(如振荡器、滤波器、混响器等),从而实现可学习、可控的音频合成器。

✅ 特点总结:

| 特性 | 描述 |

|---|---|

| 可微分 | 使用神经网络对参数建模,使整个信号路径可微分,可通过梯度学习音频合成方式 |

| 结合传统 DSP 模块 | 不直接预测波形,而是预测振幅包络、频率等参数,然后使用可解释的合成器合成音频 |

| 低延迟 / 实时 | 结构紧凑、效率高,适合用于实时插件(如 JUCE 插件中的 DDSP-VST) |

| 适用于音色建模 | 通过训练,可以模仿小提琴、萨克斯、合成器等乐器的音色特征 |

🧠 DDSP 的核心模块

以下是典型 DDSP 架构的构成模块:

-

Encoder

-

输入为音频或控制信号(如 pitch/MIDI)

-

输出为潜在编码(latent embedding)

-

-

Decoder(通常是一个 RNN 或 MLP)

-

解码器将 latent 表示转换为声学参数,如:

-

pitch curve

-

loudness envelope

-

harmonic amplitudes

-

noise magnitudes

-

-

-

Synthesis Module

-

核心为两个模块:

-

Harmonic Synthesizer:基于频率与幅度生成谐波部分

-

Filtered Noise Synthesizer:模拟气息、沙沙声、共鸣等非谐波成分

-

-

-

Reverb、Envelope 等可学习 DSP 单元

-

Loss Function

-

使用多尺度 STFT 损失、感知损失等进行优化

-

🎛️ DDSP-VST 插件实现功能

Google Magenta 的 ddsp-vst 插件项目提供了 DDSP 模型在 VST3 / AU 插件 中的实际部署。它主要分为两个插件:

🔹 1. DDSP Synth 插件

-

MIDI 控制:可接收 MIDI 输入,输出合成音频

-

音色选择:用户可选择不同风格的预训练模型(如弦乐器、铜管等)

-

实时合成:支持在 DAW 中实时演奏或回放

🔹 2. DDSP Effect 插件

-

音频输入处理:将任意输入音频信号转换成目标音色(即音色迁移)

-

混合控制:允许原始音频和合成音频之间的 dry/wet 混合

-

声码器风格控制:类似于 AutoTune、Vocoder,但使用神经网络生成器代替传统编码器

| 应用类型 | 举例 |

|---|---|

| 🎹 虚拟乐器 | 用神经网络学习小提琴、萨克斯等音色,替代传统采样器 |

| 🎶 声音风格迁移 | 将人声实时转换为吉他、小号、合成器音色 |

| 🧪 神经合成实验 | 在声学研究、建模自然声音上使用(如鸟叫、风声) |

| 🎛️ 插件产品化 | 制作具有独特 AI 音色的 VST 插件(如 DDSP-VST) |

| 🤖 AI 音频创作工具 | 实现音乐创作中 "唱出旋律 → 自动合成" 的 AI 助手功能 |

| 项目/功能 | 是否具备 | 说明 |

|---|---|---|

| 实时生成 | ✅ | 支持低延迟插件 |

| 音色风格迁移 | ✅ | 输入声音实时映射为目标音色 |

| 多种合成器模块 | ✅ | 谐波合成、噪声合成、混响等 |

| MIDI 支持 | ✅ | 合成器模式支持 MIDI 输入 |

| 模型可扩展 | ✅ | 可用自己训练的 DDSP 模型替换 |

| 与 JUCE 集成 | ✅ | 已提供 JUCE 插件版本源代码 |

开源项目地址回顾

-

🔗 Magenta 官方插件仓库:https://github.com/magenta/ddsp-vst

-

🔗 SMC704 作者实现版:https://github.com/SMC704/juce-ddsp

-

📄 论文介绍:[2001.04643] DDSP: Differentiable Digital Signal Processing

如果你希望我进一步讲解:DDSP 模型训练方法 / 如何在 JUCE 插件中部署 DDSP 模型 / 替换为自己的 timbre transfer 模型等,随时告诉我,我可以手把手带你搭建或精简这个系统。

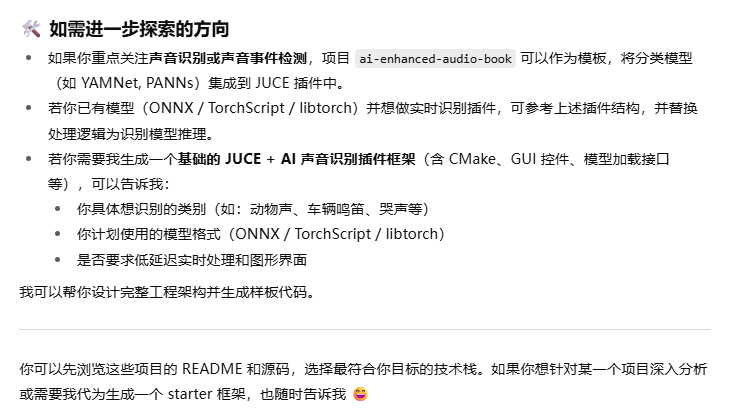

AI如何在https://github.com/SMC704/juce-ddsp里面使用的

| 项目 | magenta/ddsp‑vst | SMC704/juce‑ddsp |

|---|---|---|

| 发布机构 | Google Magenta 社区 | Aalborg University 的论文作者团队 |

| 维护状态 | 已归档,只读 | 开源、可编译、可扩展 |

| 插件形态 | Synth + Effect 插件预编译版本 | JUCE 源码插件(Synth 和 Effect 模式均支持) |

| 实时性能优化 | 使用小型模型、推理间隔优化 | 侧重准确性与代码可读性 |

| 自动生成 DSP 代码 | 否 | 使用 MATLAB Coder 自动生成核心 DSP 算法代码 |

| 模型可替换性 | 有限 | 高(可替换模型文件、增加自定义模块) |

| 开发友好性 | 用户体验友好,普通用户易上手 | 更适合研究者和开发者定制 |

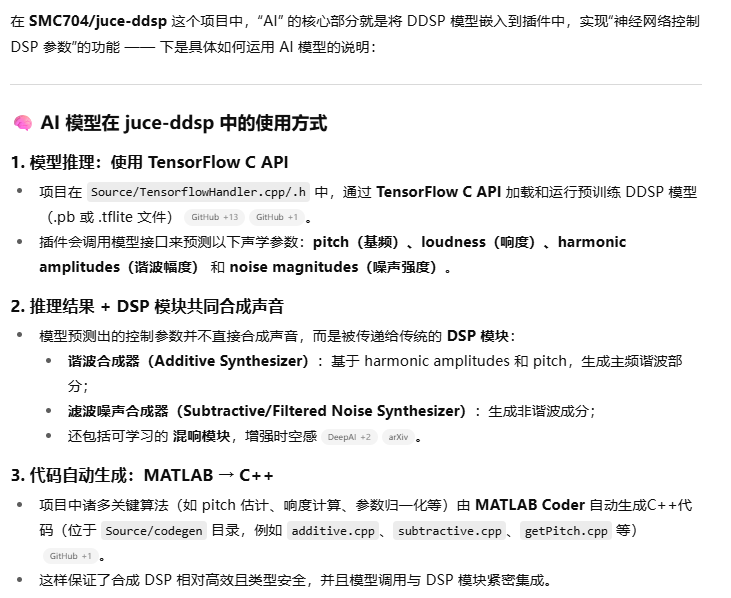

主流推理引擎

一线主流通用推理引擎(跨框架支持,性能优化强)

| 推理引擎 | 支持模型格式 | 适用平台 | 特点 |

|---|---|---|---|

| ONNX Runtime | ONNX | 跨平台(CPU/GPU/ARM) | 微软出品,跨框架推理标准,速度快 |

| TensorRT | ONNX / TensorFlow / PyTorch | NVIDIA GPU | 极致优化的 GPU 推理引擎 |

| OpenVINO | ONNX / TensorFlow / PyTorch | Intel CPU / VPU / GPU | 英特尔出品,适用于边缘设备 |

| TVM | ONNX / TensorFlow / PyTorch | 可编译到多种硬件 | 编译型推理框架,适用于嵌入式 |

| TFLite | TensorFlow Lite (FlatBuffer) | 移动端、边缘设备 | TensorFlow 的轻量版本,适合移动设备 |

| NCNN | Caffe / ONNX / 自定义 | Android/ARM/LoongArch | 腾讯出品,轻量、高性能 |

框架绑定的原生推理后端(适合深度集成)

| 引擎 | 所属框架 | 特点 |

|---|---|---|

| TensorFlow Serving | TensorFlow | 服务化部署,适合在线推理 |

| Libtorch (TorchScript) | PyTorch | 原生 C++ 接口,适合嵌入式和客户端 |

| TF C API | TensorFlow | C 语言接口,底层接入,适合自定义推理场景 |

专用于端侧设备 / 特定硬件加速的引擎

| 推理引擎 | 平台/厂商 | 特点 |

|---|---|---|

| Core ML | Apple macOS/iOS | 专用于 Apple 设备,配合 Metal 优化 |

| Qualcomm SNPE | Snapdragon 芯片 | 适用于 Android 移动端 |

| MediaTek NeuroPilot | MediaTek 设备 | 联发科 AI 推理平台 |

| RKNN Toolkit | Rockchip 芯片 | 适用于瑞芯微 NPU 推理 |

总结推荐(按使用场景):

| 场景 | 推荐引擎 |

|---|---|

| 跨平台通用部署 | ✅ ONNX Runtime |

| GPU 极致加速 | ✅ NVIDIA TensorRT |

| 嵌入式 / 端侧 / ARM | ✅ TFLite / NCNN / TVM |

| iOS / macOS 端 | ✅ Core ML |

| PyTorch 项目用 C++ 调用 | ✅ libtorch |

| TensorFlow 项目轻量部署 | ✅ TF Lite / TF C API |

libtorch TensorFlow C API ONNX Runtime

以下是 libtorch、TensorFlow C API 和 ONNX Runtime 的简要对比和功能介绍,帮助你理解它们各自的用途及在 AI 推理中的角色:

🔧 1. LibTorch(PyTorch C++ API)

-

开发方:Meta (Facebook)

-

语言:C++

-

简介:

LibTorch 是 PyTorch 的 C++ 实现版本,用于在没有 Python 环境的系统中运行训练好的 PyTorch 模型。 -

优点:

-

原生 C++,适合低延迟场景(如音频插件、嵌入式系统)

-

支持 GPU(CUDA)、多线程

-

PyTorch 训练的模型可直接导出为

.pt文件用于部署

-

-

适用场景:

-

音频处理插件(如 JUCE)

-

游戏 AI

-

嵌入式推理

-

🔧 2. TensorFlow C API

-

开发方:Google

-

语言:C

-

简介:

TensorFlow 提供了 C 接口,可以用在 C/C++ 项目中加载.pb或 SavedModel 格式的模型。 -

优点:

-

原生 TF 模型支持

-

多语言绑定(C 接口 → 可绑定到 Python、Go、Rust 等)

-

-

缺点:

-

C 接口功能较 Python 限制多

-

文档和社区支持不如 Python 版本

-

-

适用场景:

-

已经使用 TF 训练模型的工程想要部署到 C/C++ 环境

-

移动端(Android NDK)

-

🔧 3. ONNX Runtime

-

开发方:Microsoft

-

语言:C/C++、Python、C# 等

-

简介:

ONNX 是一个开放的深度学习模型交换格式,ONNX Runtime 支持跨框架(PyTorch、TensorFlow、scikit-learn 等)导出模型进行统一推理。 -

优点:

-

支持多种模型来源(PyTorch、TF、sklearn 等)

-

可部署到多平台(Windows/macOS/Linux/嵌入式)

-

高效,支持 GPU、TensorRT、OpenVINO 加速

-

-

适用场景:

-

模型跨平台部署

-

需要后端自由切换(CPU/GPU/FPGA)

-

追求高性能、跨框架兼容性

-

| 特性 | LibTorch | TensorFlow C API | ONNX Runtime |

|---|---|---|---|

| 模型格式 | .pt | .pb, SavedModel | .onnx |

| 支持平台 | 跨平台 | 跨平台 | 跨平台 |

| 适配语言 | C++ | C/C++ | C/C++、Python、C# 等 |

| GPU 支持 | ✅ | ✅ | ✅(CUDA/TensorRT) |

| 部署灵活性 | 中等 | 中 | 高 |

| 易用性 | 中 | 较低 | 高 |

| 适合 JUCE 插件 | ✅ | ✅ | ✅(推荐) |

如你正在做 JUCE 音频插件 + AI 项目,推荐优先考虑:

-

✅ ONNX Runtime:最灵活,兼容性强,支持导出自 PyTorch/TensorFlow。

-

✅ LibTorch:如训练模型来自 PyTorch 且不需跨框架部署。

-

⚠️ TensorFlow C API:适用于 TensorFlow 专属项目,但使用难度略高。

如果你希望我给你生成一个基于其中某种库的 JUCE 示例项目,我也可以帮你搭好基础框架。是否需要?

140

140

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?