由于csdn的bug,之前写的内容丢失,所以这篇内容不全

为什么线性回归中,bias和weight能够被优化?

因为其Variable中的trainable参数被设置为了True,所以在使用优化算法时,就能够被优化

梯度爆炸/梯度消失

在极端情况下,权重的变得非常大,以至于溢出,导致nan值

如何解决梯度爆炸问题(深度神经网络(如RNN)中更容易出现):

- 重新设计网络

- 调整学习率(通常学习率过大容易出现梯度爆炸)

- 使用梯度截断(在训练过程中检查和限制梯度的大小)

- 使用激活函数

作用域

import tensorflow as tf

def myregression():

"""

自实现一个线性回归预测

:return: None

"""

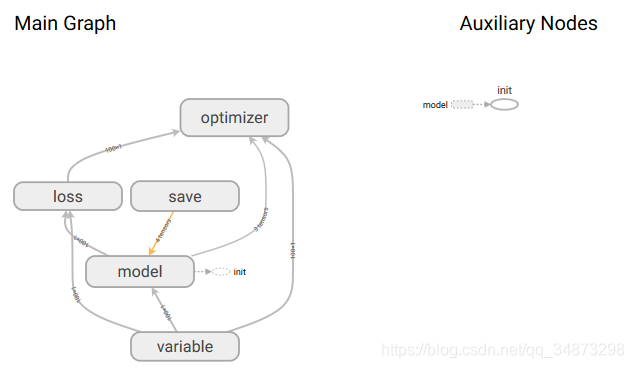

with tf.variable_scope("variable"):

#准备数据

x = tf.random_normal([100, 1], mean=1.75, stddev=0.5, name="x_data")

y_true = tf.matmul(x, [[0.7]]) + 0.8 #矩阵相乘必须是2维的

with tf.variable_scope("model"):

#建立线回归模型

weight = tf.Variable(tf.random_normal([1, 1], mean=0.0, stddev=1.0, name="weight"))

bias = tf.Variable(0.0, name="bias")

y_predict = tf.matmul(x, weight) + bias

with tf.variable_scope("loss"):

#建立损失函数,均方误差

loss = tf.reduce_mean(tf.square(y_predict-y_true)) #reduce_mean是计算平均值

with tf.variable_scope("optimizer"):

#梯度下降优化损失

train_op = tf.train.GradientDescentOptimizer(learning_rate=0.1).minimize(loss) #梯度下降去进行优化,即最小化损失,所以后面加了minimize

#定义一个初始化变量的op

init_op = tf.global_variables_initializer()

#通过会话运行程序

with tf.Session() as sess:

#初始化变量

sess.run(init_op)

#打印随机初始化的权重和偏置值

print("随机初始化的参数权重为:\n", weight.eval(), "\n偏置为:\n", bias.eval())

#运行优化

#循环训练优化

for i in range(1000):

sess.run(train_op)

print("优化",i,"次优化过后的参数权重为:", weight.eval(), " 偏置为:", bias.eval())

return None

if __name__ == "__main__":

myregression()

在命令行运行tensorboard --logdir=“保存文件的路径”

260

260

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?