示例

Epochs

Batch Size

Learning Rate

总结

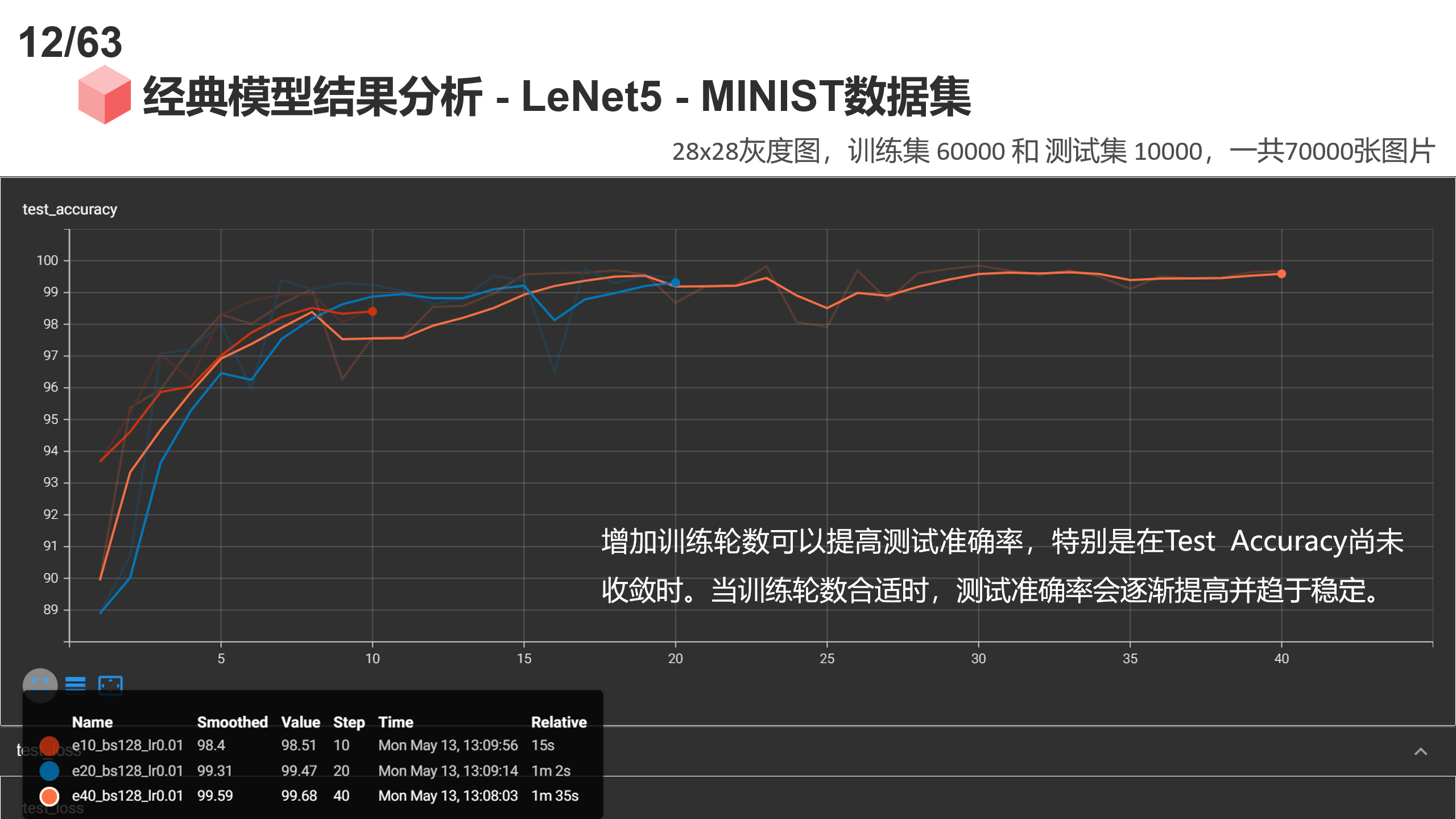

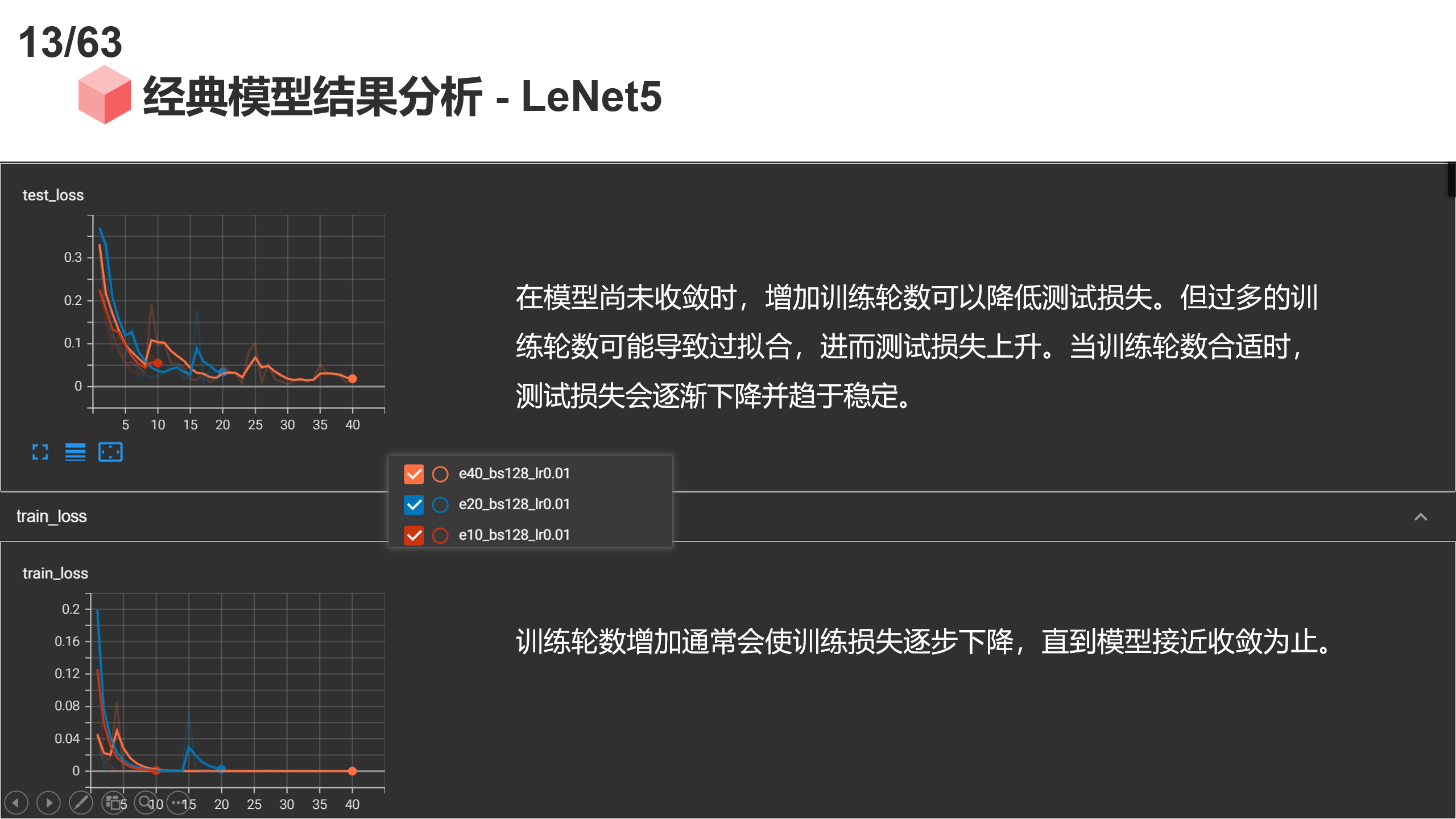

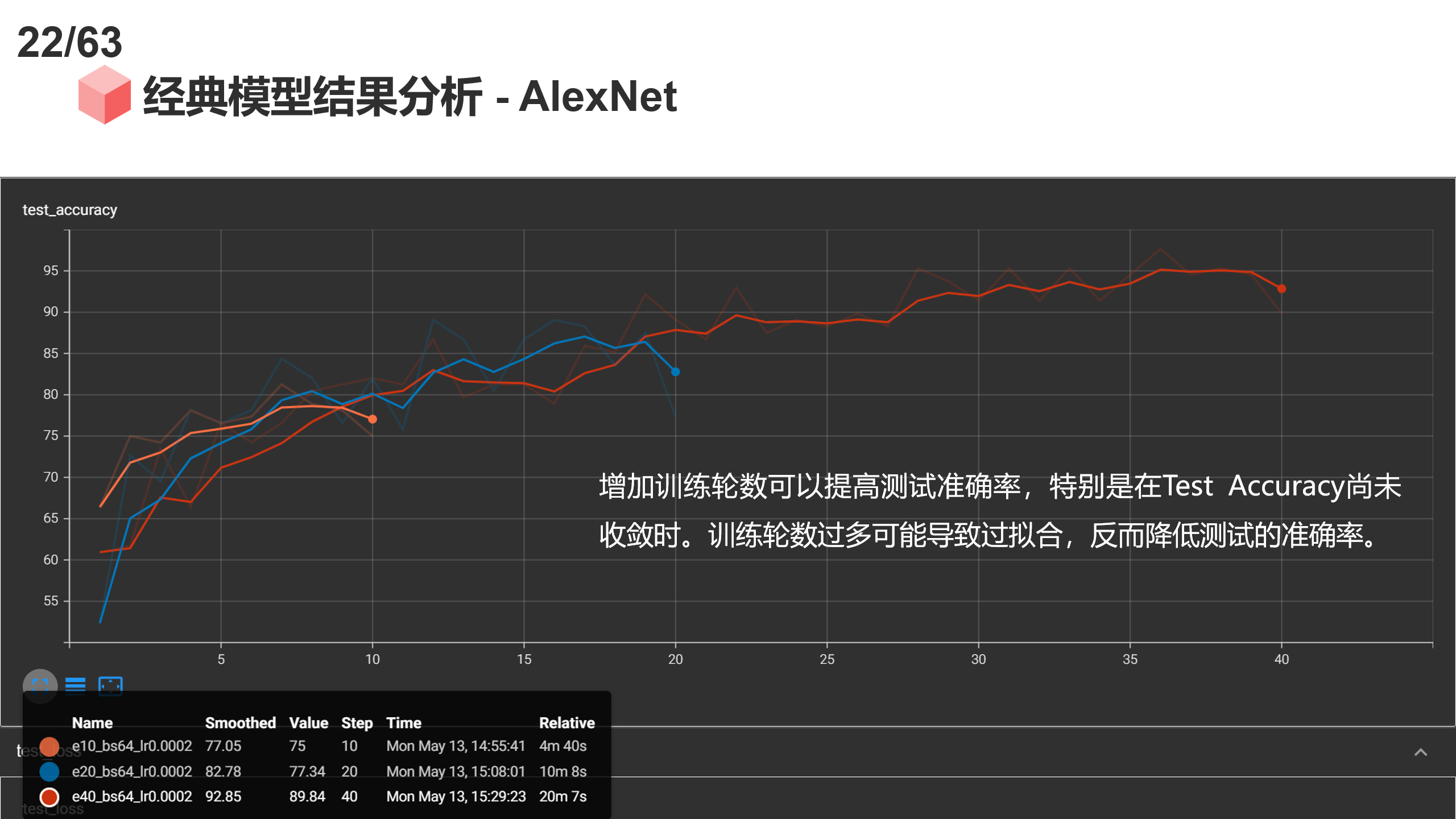

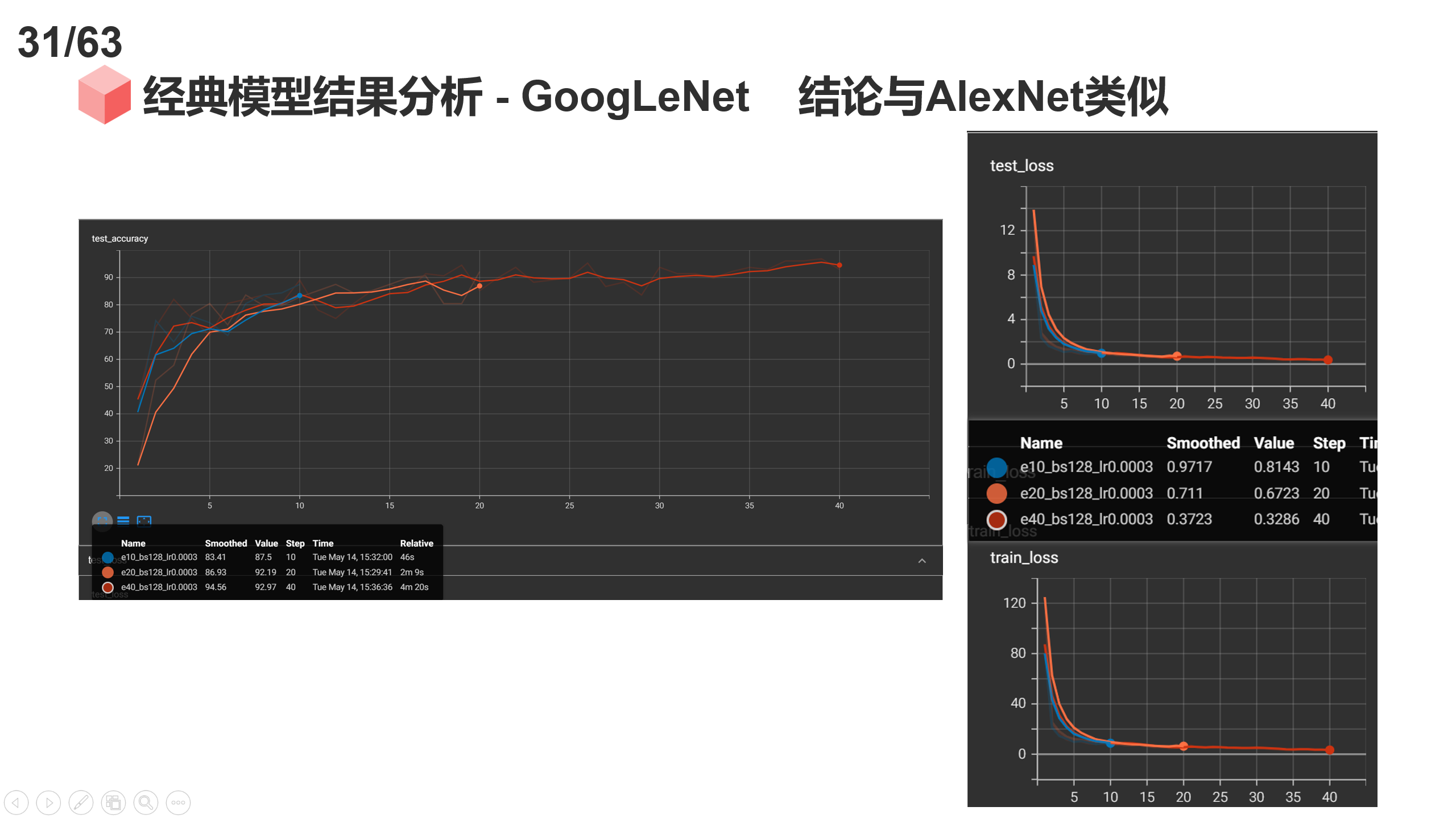

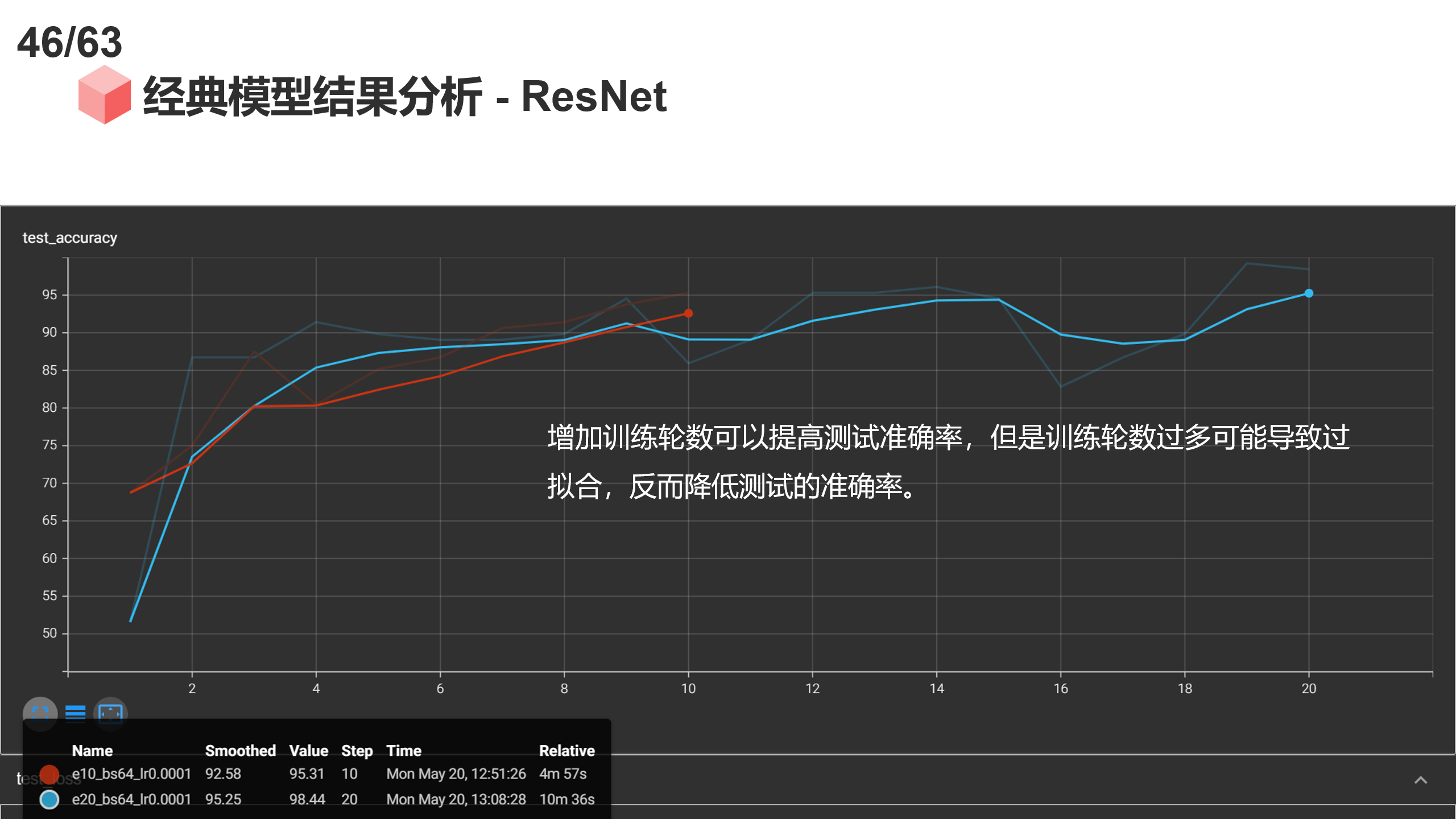

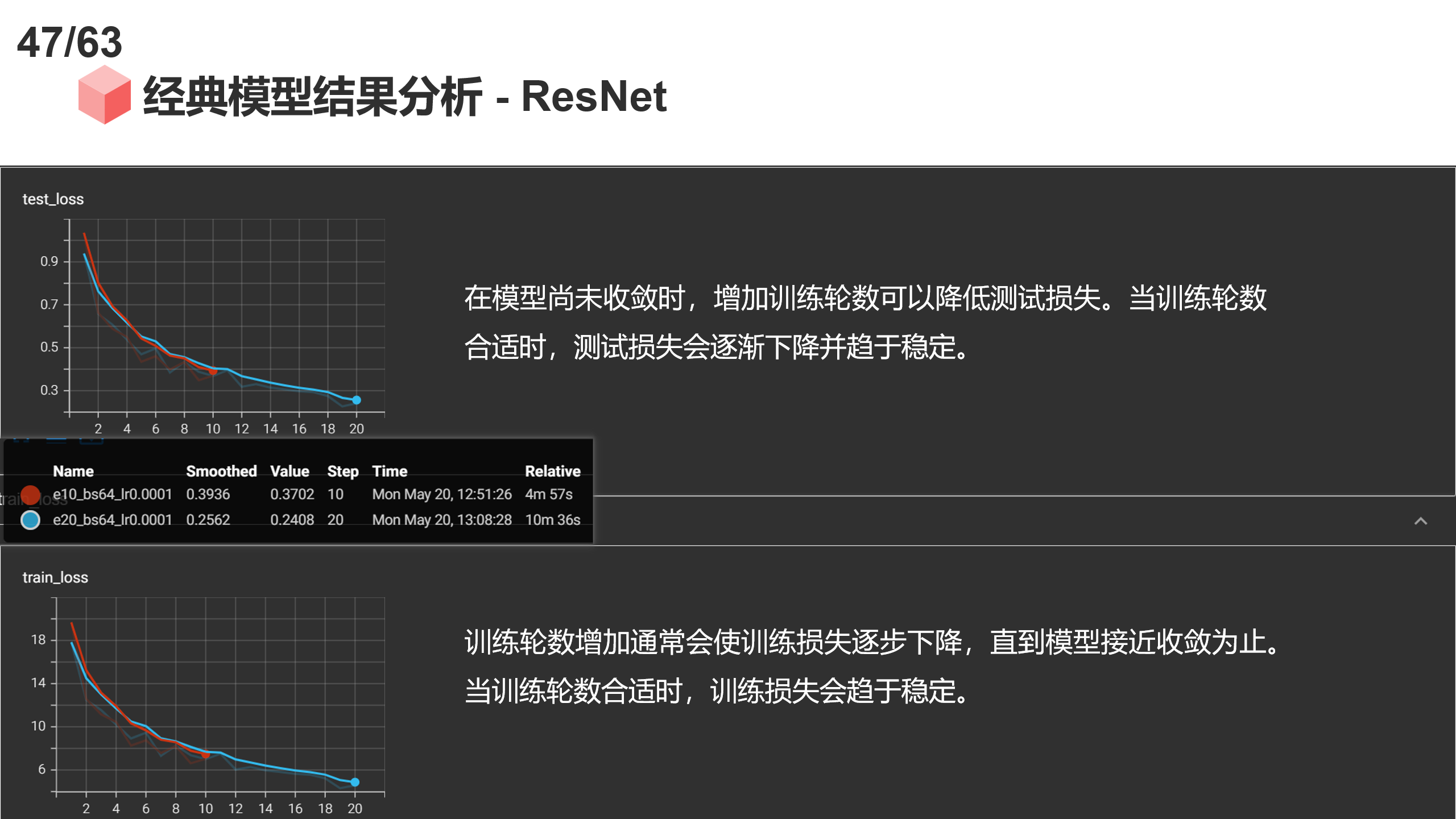

Epochs(训练轮数)

- Test Accuracy: 增加训练轮数可以提高测试准确率,特别是在Test Accuracy尚未收敛时。训练轮数过多可能导致过拟合,反而降低测试的准确率。当训练轮数合适时,测试准确率会逐渐提高并趋于稳定。

- Test Loss: 在模型尚未收敛时,增加训练轮数可以降低测试损失。但过多的训练轮数可能导致过拟合,进而测试损失上升。当训练轮数合适时,测试损失会逐渐下降并趋于稳定。

- Train Loss: 训练轮数增加通常会使训练损失逐步下降,直到模型接近收敛为止。当训练轮数合适时,训练损失会趋于稳定。

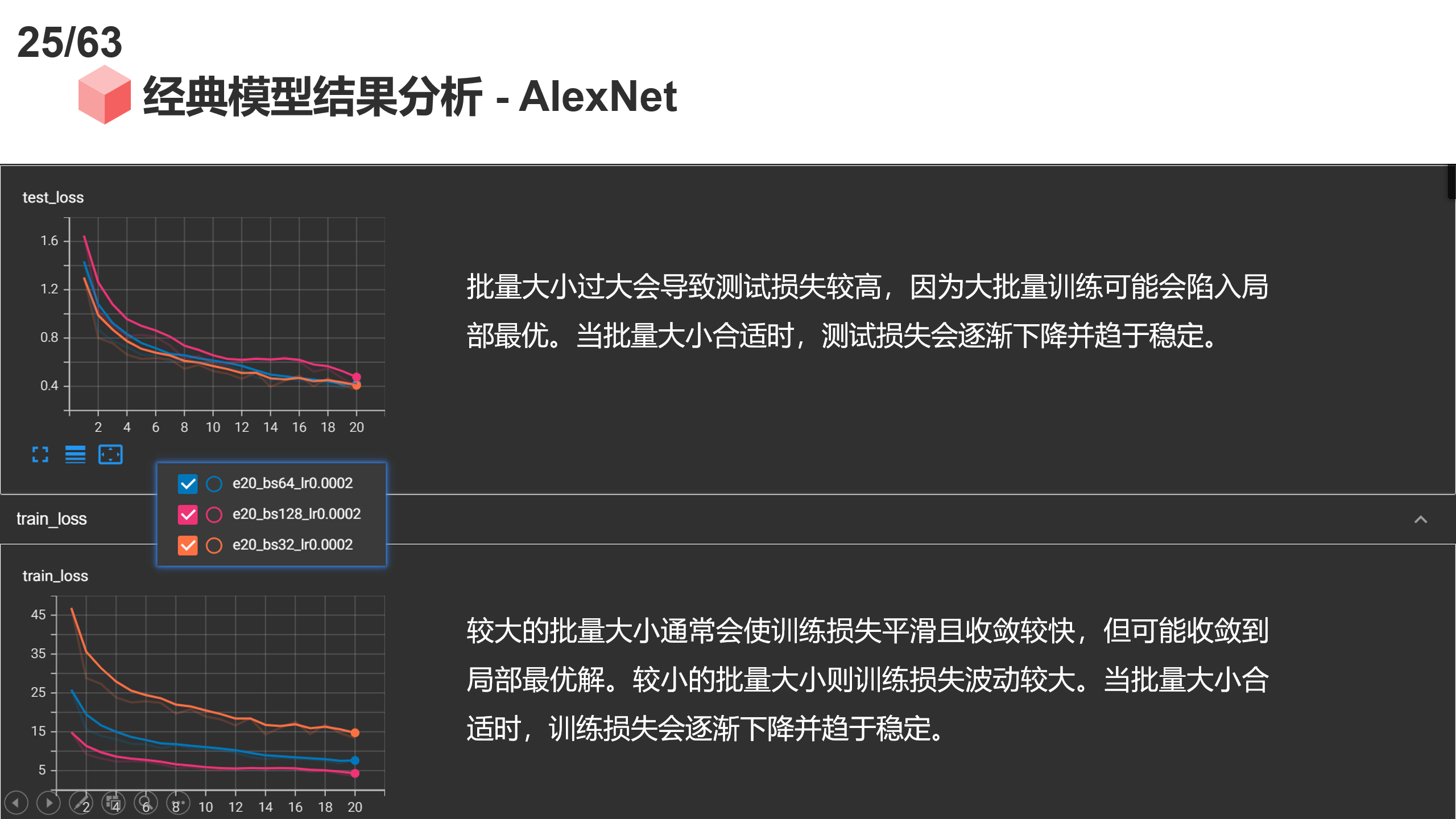

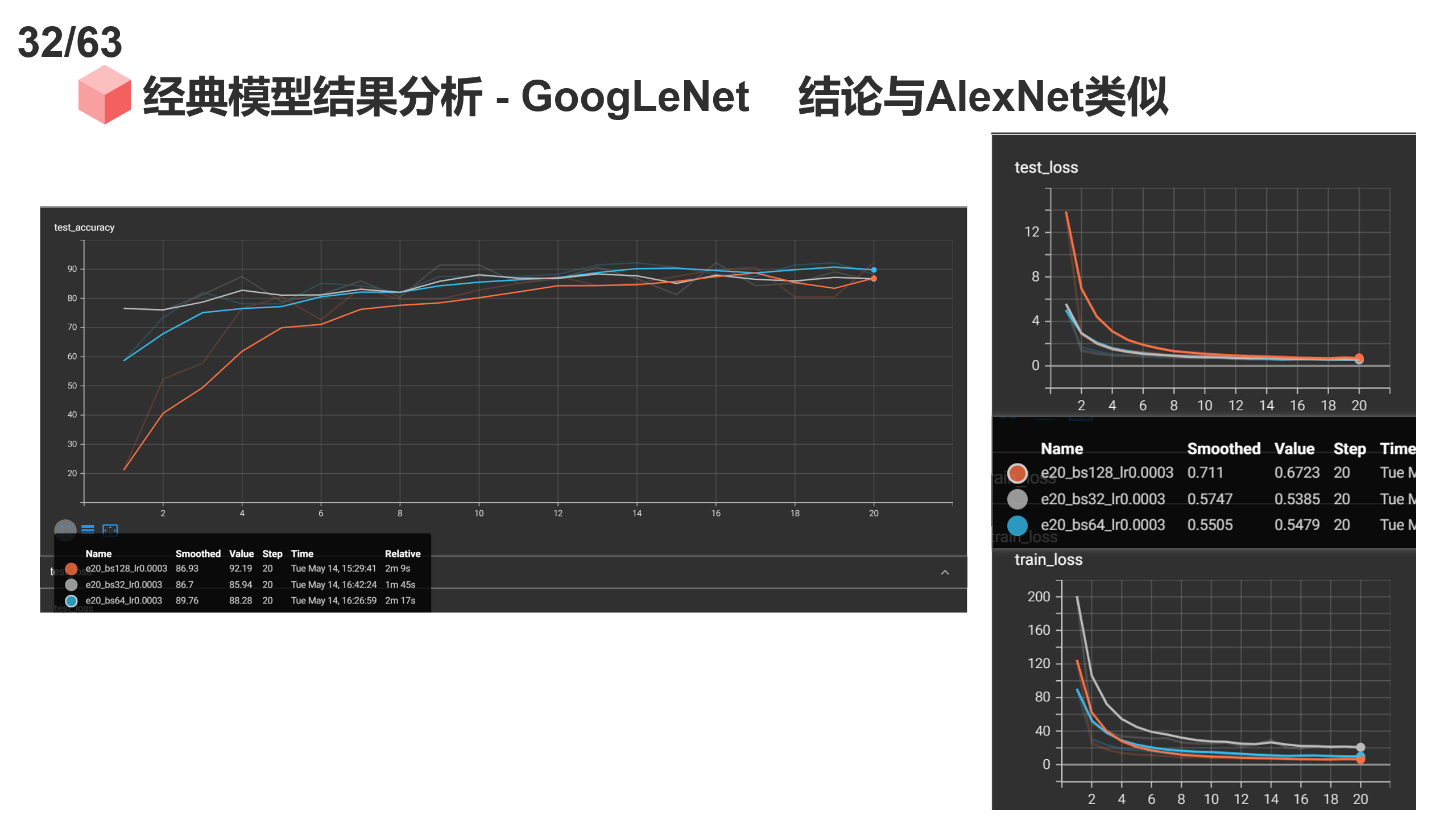

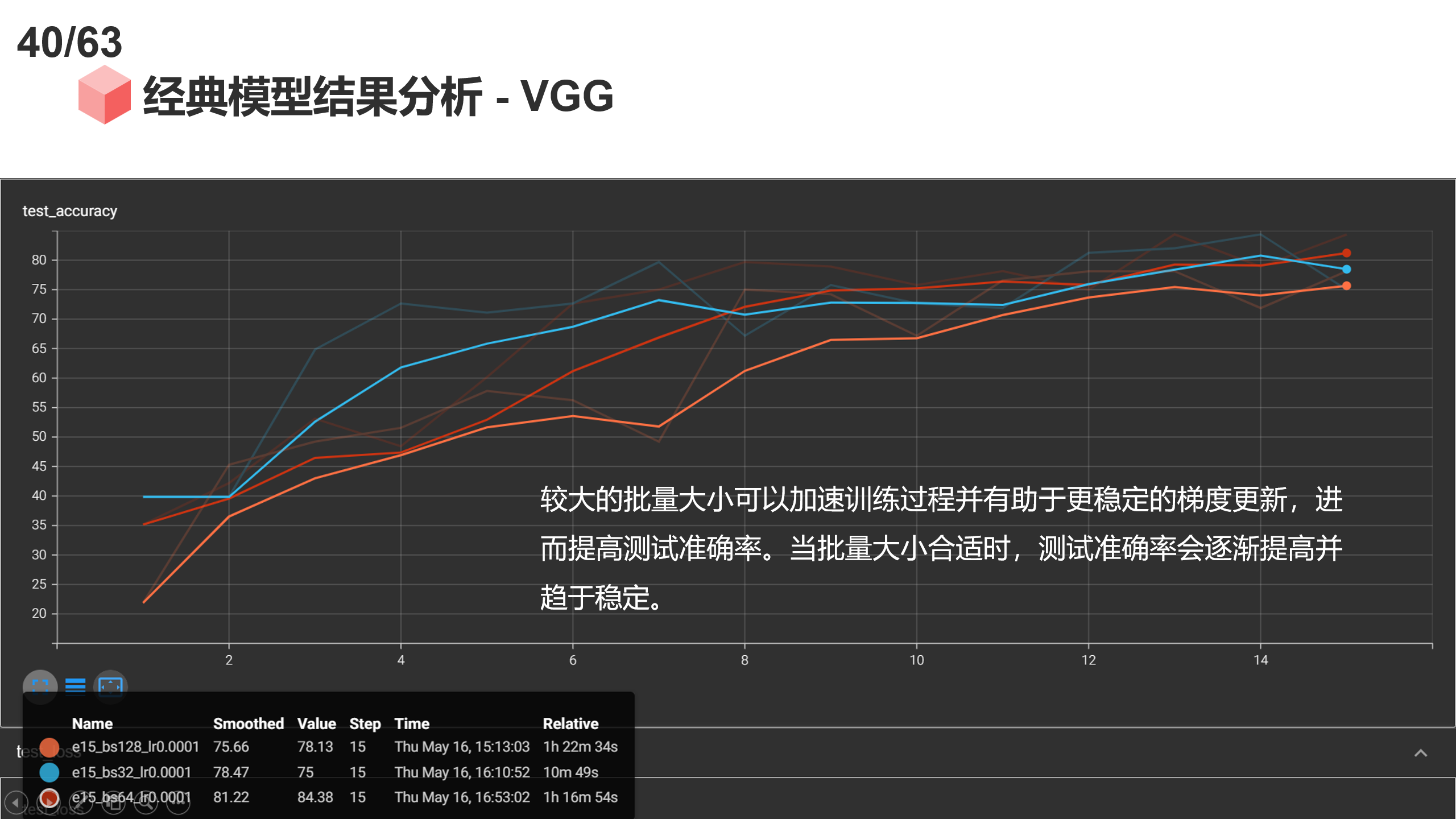

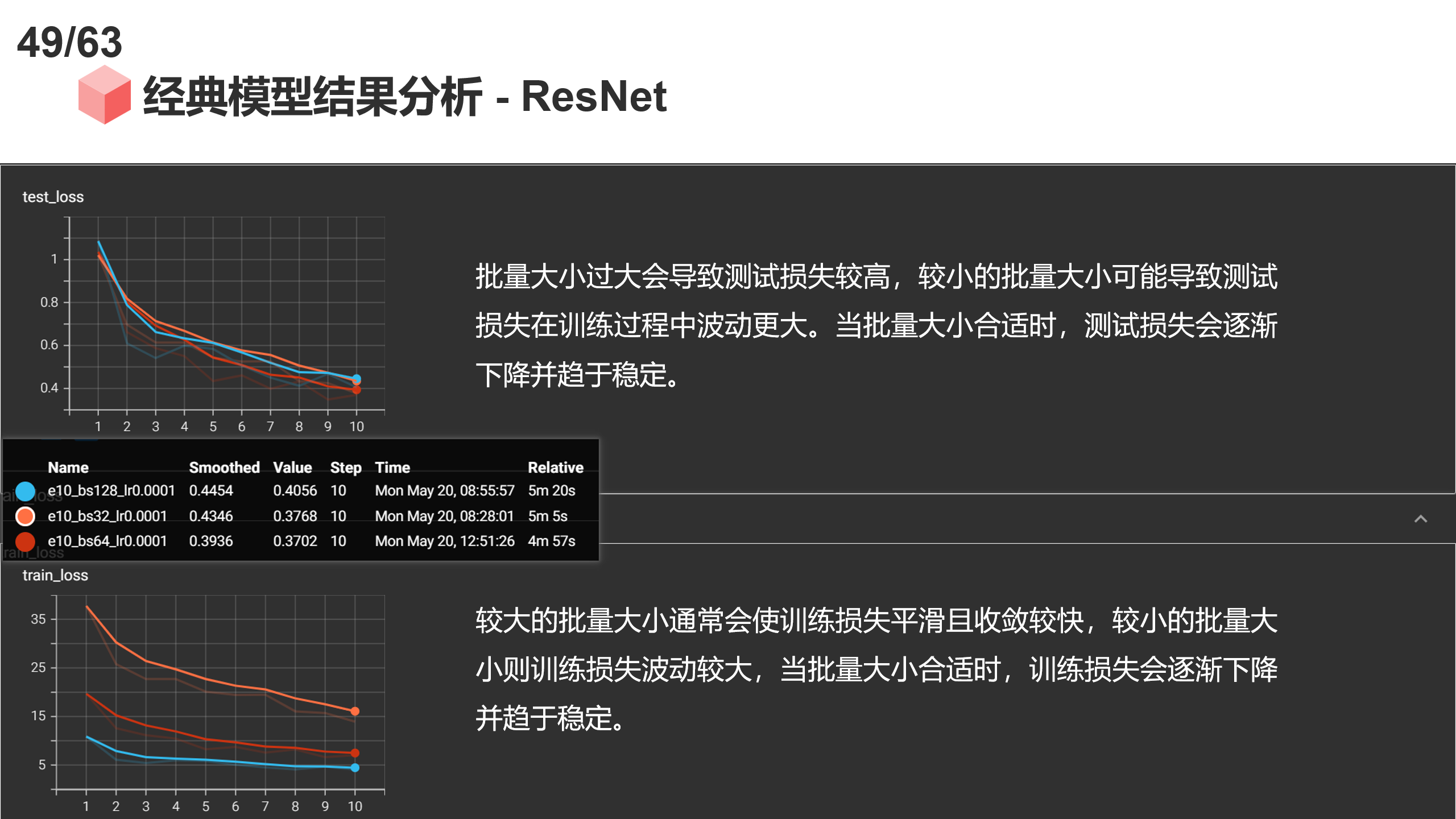

Batch Size(批量大小)

- Test Accuracy: 较大的批量大小可以加速训练过程并有助于更稳定的梯度更新,进而提高测试准确率。但是,大的批量大小可能导致模型泛化能力下降(过拟合),降低测试准确率。小的批量大小可以提供更多次的梯度更新,但可能导致训练不稳定。当批量大小合适时,测试准确率会逐渐提高并趋于稳定。

- Test Loss: 批量大小过大会导致测试损失较高,因为大批量训练可能会陷入局部最优。较小的批量大小可能导致测试损失在训练过程中波动更大。当批量大小合适时,测试损失会逐渐下降并趋于稳定。

- Train Loss: 较大的批量大小通常会使训练损失平滑且收敛较快,但可能收敛到局部最优解。较小的批量大小则训练损失波动较大,但有可能找到更好的全局最优解。当批量大小合适时,训练损失会逐渐下降并趋于稳定。

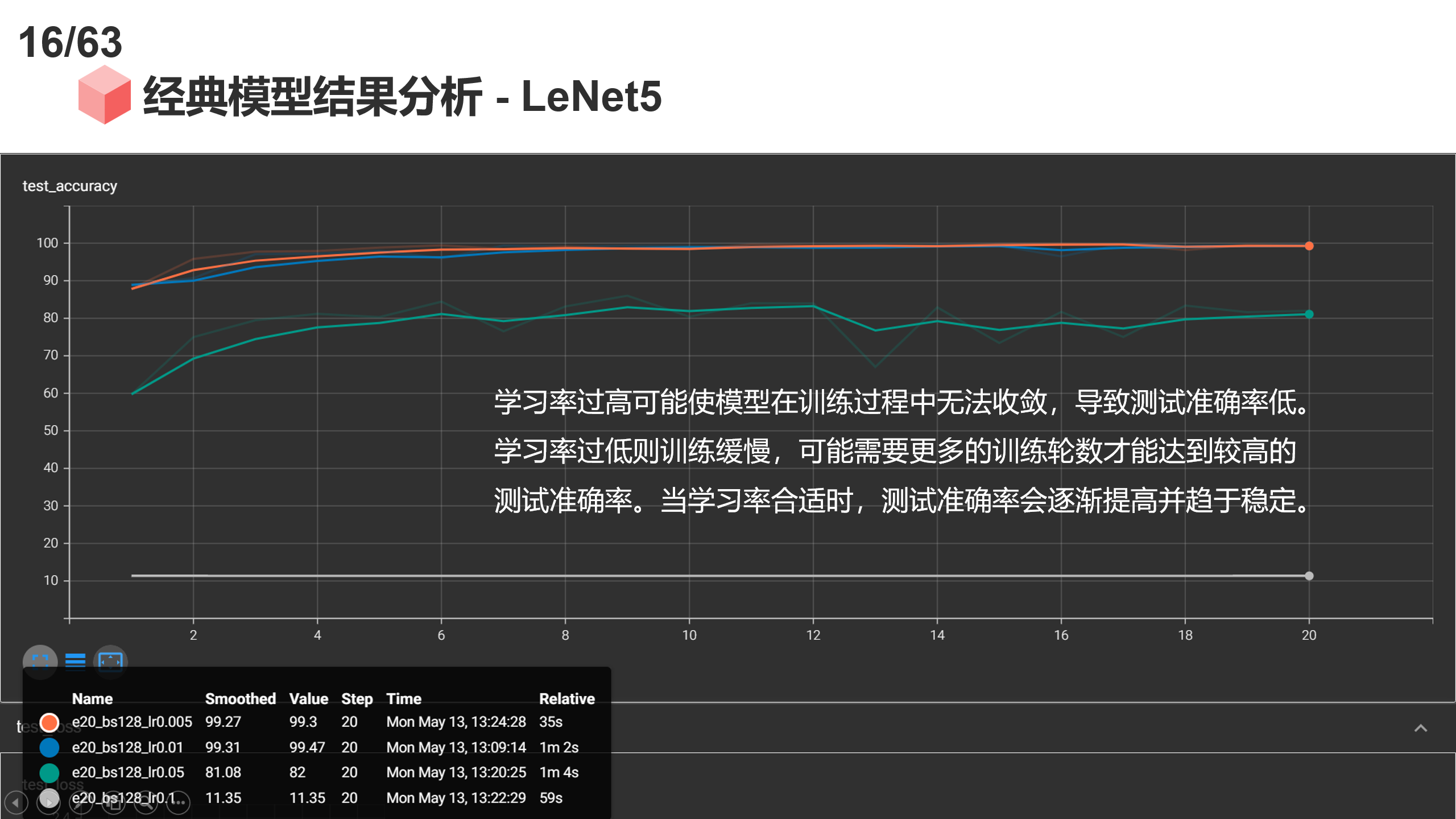

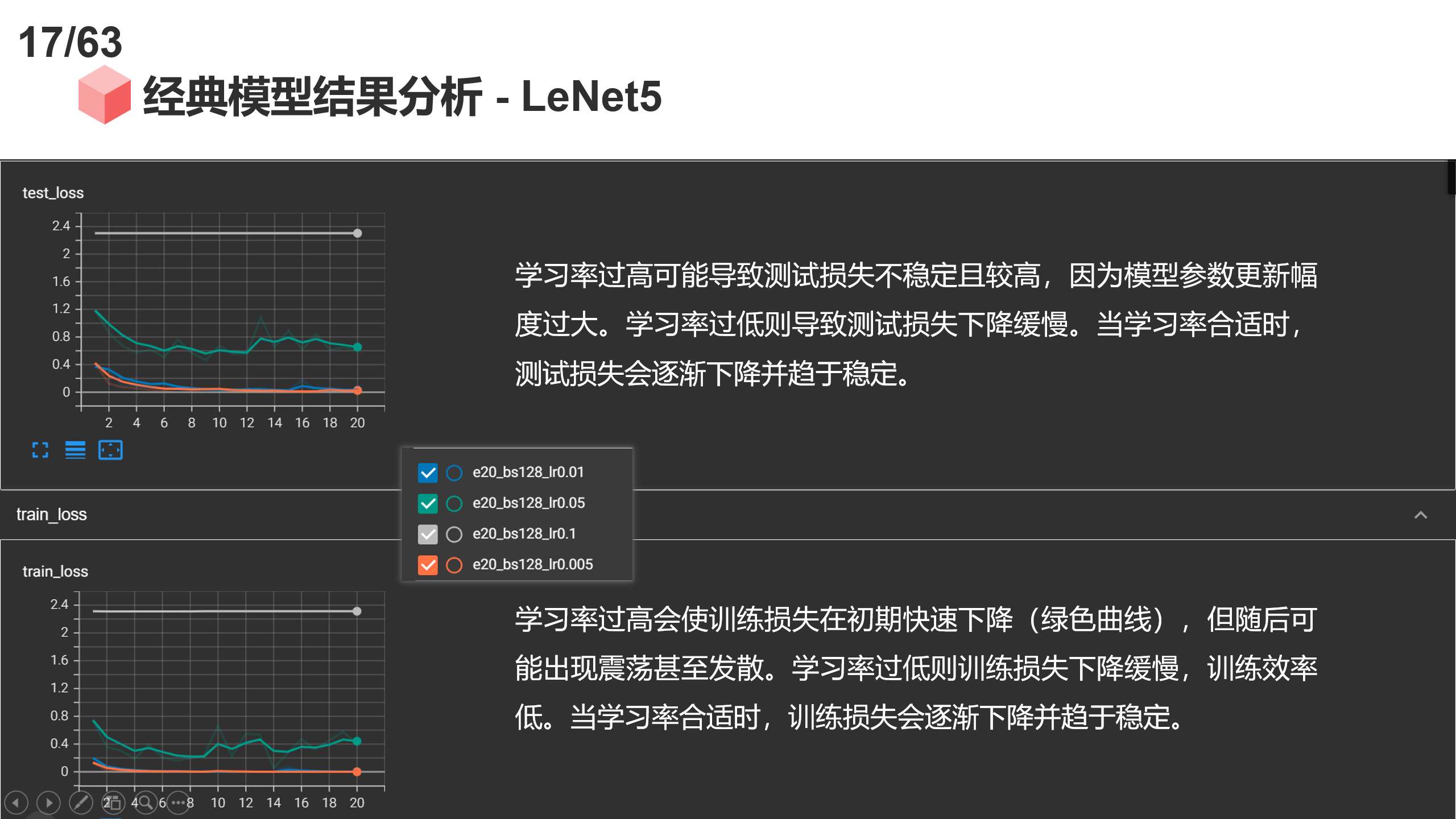

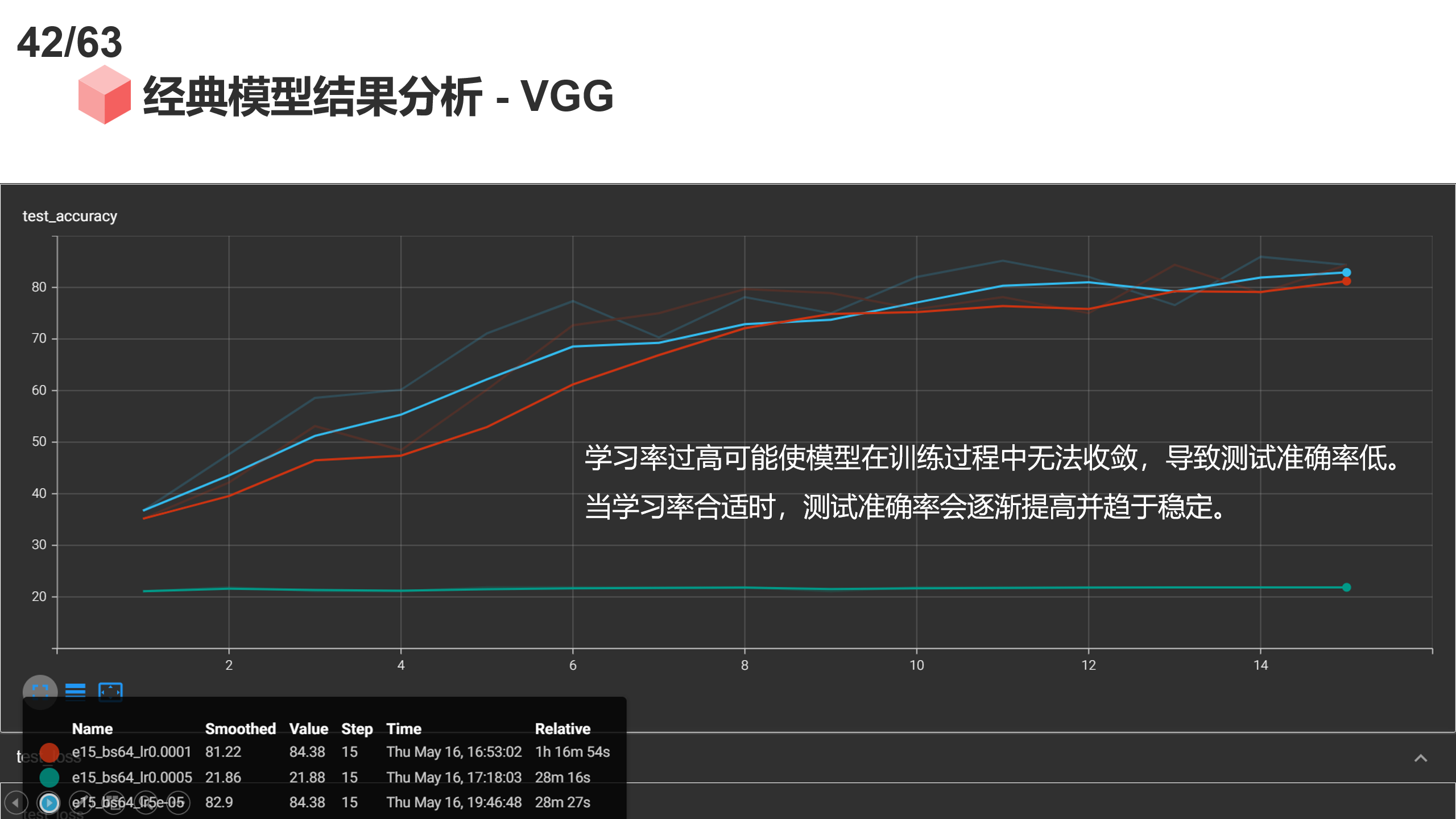

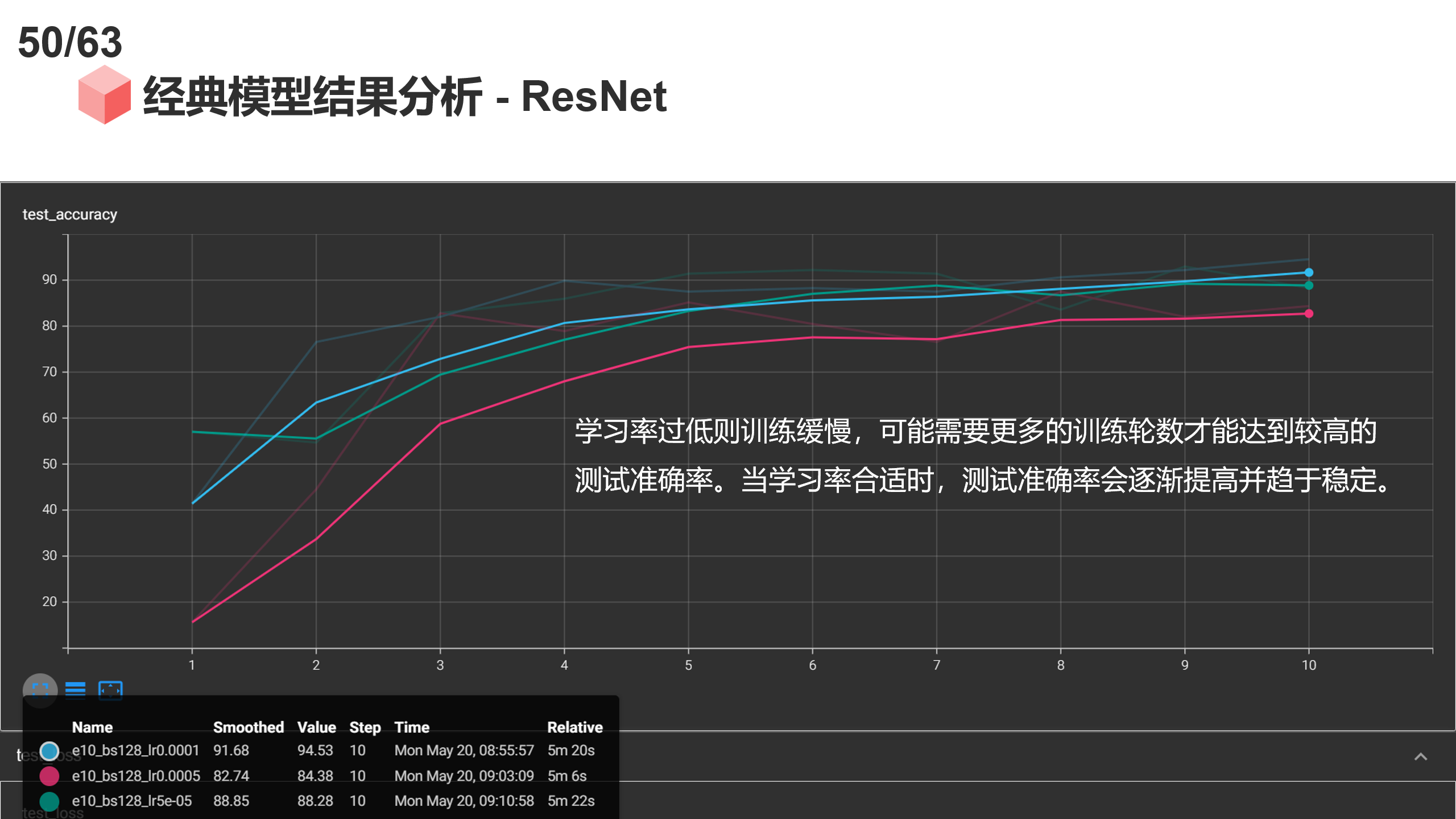

Learning Rate(学习率)

- Test Accuracy: 学习率过高可能使模型在训练过程中无法收敛,导致测试准确率低。学习率过低则训练缓慢,可能需要更多的训练轮数才能达到较高的测试准确率。当学习率合适时,测试准确率会逐渐提高并趋于稳定。

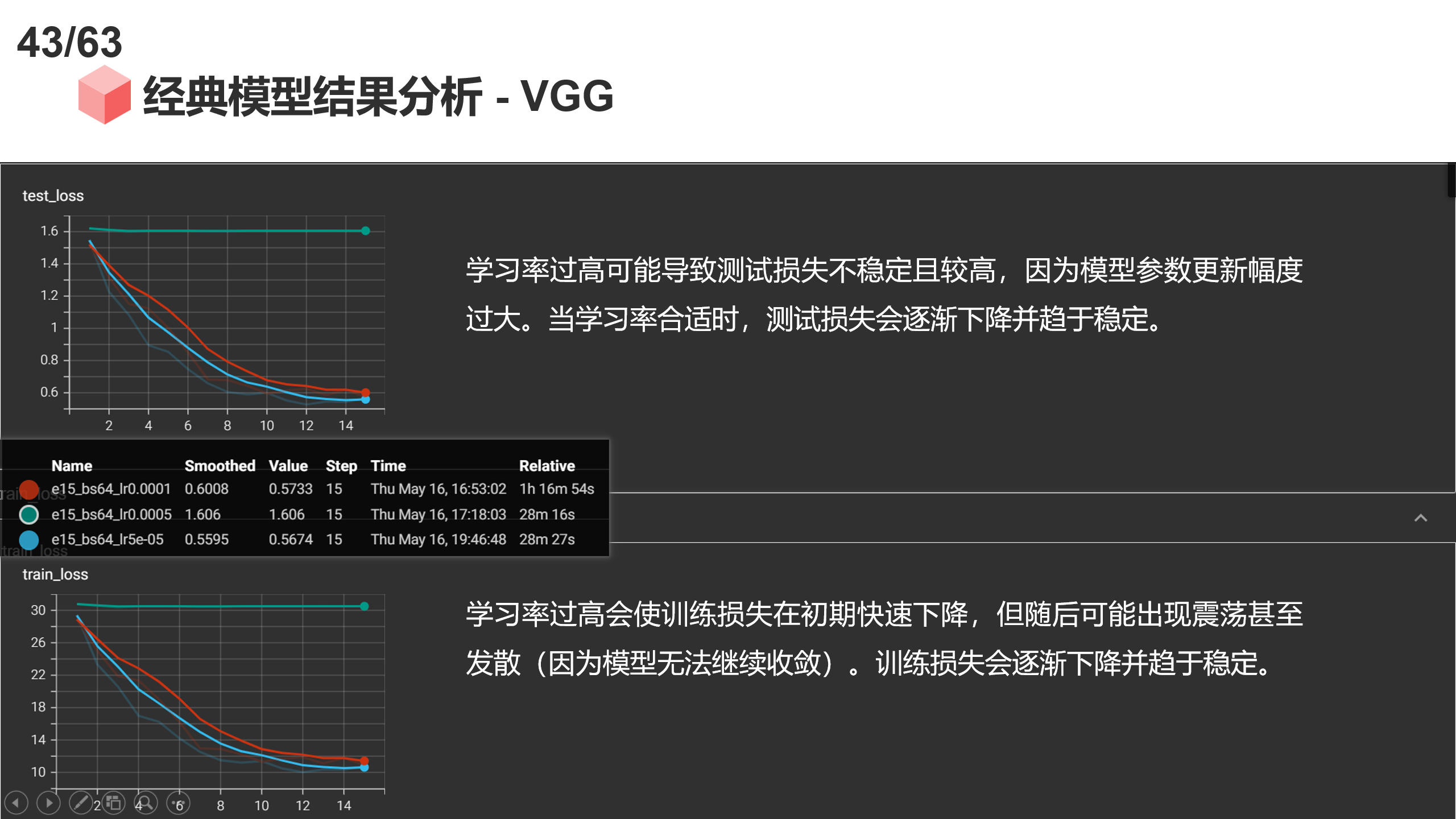

- Test Loss: 学习率过高可能导致测试损失不稳定且较高,因为模型参数更新幅度过大。学习率过低则导致测试损失下降缓慢。当学习率合适时,测试损失会逐渐下降并趋于稳定。

- Train Loss: 学习率过高会使训练损失在初期快速下降,但随后可能出现震荡甚至发散(因为模型无法继续收敛)。学习率过低则训练损失下降缓慢,训练效率低。当学习率合适时,训练损失会逐渐下降并趋于稳定。

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?