目录

基于CNN的SR方法(2014-2020优秀论文)

轻量型SR网络

真实场景SR

基于GAN的SR

经典网络

单帧图像超分辨率重建(Single Image Super Resolution, SISR)旨在从一张降质的低分辨率图像(Low Resolution, LR)中恢复出相应的高分辨率图像(High Resolution, HR),这是一个不适定的逆问题。SISR方法可以分成三类:基于插值的方法,基于重构的方法和基于学习的方法。随着深度学习和人工智能的发展,使用卷积神经网络(CNN)重建图像是研究的热点。

两篇全面的超分综述

Deep Learning for Image Super-resolution: A Survey(2019, IEEE TPAMI)

A Deep Journey into Super-resolution: A survey (2019)

基于CNN的SR方法

论文代码在github上可以找到

1、Image Super-Resolution Using Deep Convolutional Networks (SRCNN,ECCV2014,Depth:3层)

- 首次将CNN引入SR领域

- 输入是双三次插值后的大图。优:网络可学习的信息增加;缺:插值方法可能引入噪声,影响网络性能

- SRCNN网络结构

2、Accelerating the Super-Resolution Convolutional Neural Network (FSRCNN,ECCV2016,Depth:8层)作者同SRCNN

- 输入LR小图

- 对SRCNN改进,提出更加快速和参数更少的模型。提出使用反卷积层放大图像,使得网络可以输入未插值的小图;反卷积层位于网络末端,减少网络计算量。

- 先用1x1降维,再用1x1升维,bottleneck结构降参;将一个5x5卷积分解成2个3x3卷积,后者参数更少。

- General100 + 91images作为训练集,并且进行数据增强

- FSRCNN网络结构

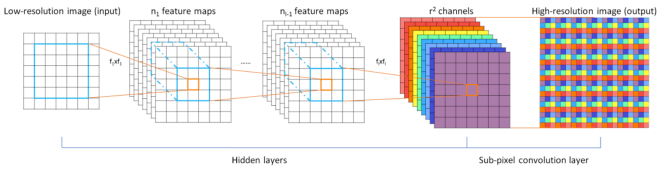

3、Real-Time Single Image and Video Super-Resolution Using an Efficient Sub-Pixel Convolutional Neural Network (ESPCN,CVPR2016, Depth:3层)

- 输入LR小图,提出亚像素卷积上采样方式,即通过通道数扩张和像素点重新排列来实现图像放大。得到通道数为 r2 的与输入图像大小一样的特征图像。再将特征图像每个像素的 r2个通道重新排列成一个rxr的区域,从而大小为 HxWxr2 的特征图像被重新排列成 rHxrWx1的高分辨率图像

- ESPCN网络结构

4、Accurate Image Super-Resolution Using Very Deep Convolutional Networks (VDSR,CVPR2016,Depth:20层)

VDSR提到,输入的低分辨率图像和输出的高分辨率图像在很大程度上是相似的,也就是指低分辨率图像携带的低频信息与高分辨率图像的低频信息相近,因此只需要学习高分辨率图像和低分辨率图像之间的高频部分残差即可

- 输入插值大图

- 将网络层数加深至20层提高精度,20个卷积层均采用3x3的卷积核。

- 提出skip-connection,全局残差,相当于对高频进行训练,加快了训练速度,收敛效果也更好

- 采用大学习率训练网络,使用梯度裁剪策略

- 将不同倍数的图像混合在一起训练,训练出来的一个模型就可以解决不同放大因子的超分辨率重建

- VDSR网络结构

- 残差网络

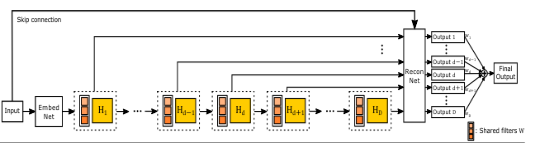

5、Deeply-Recursive Convolutional Network for Image Super-Resolution (DRCN, CVPR2016,Depth:20层)与VDSR作者相同

- 输入插值大图

- 递归监督,递归同一卷积层16次,该16个卷积层参数共享,在网络深度增加时没有引入额外的待学习参数,达到降参的目的

- 全局skip-connection,缓解梯度消失/梯度爆炸问题

网络最终输出为D个递归得到的结果再加权平均

6、Image Super-Resolution via Deep Recursive Residual Network(DRRN,CVPR2017,Depth:52层)

- 输入大图

- 递归一个模块,(DRCN递归一个卷积层)模块包含2个卷积层

- 全局和局部skip-connection

- DRRN网络结构

- MemNet

7、Deep Laplacian Pyramid Networks for Fast and Accurate Super-Resolution(LapSRN, CVPR2017,Depth:24层)

- 输入LR

- 提出金字塔结构,每一级都只对原图放大两倍,然后加上残差获得一个结果。具体为:把放大2倍的结构作为基础模块,通过级联2个该模块,在放大2倍的基础上实现4倍放大,通过级联3个该模块,在放大4倍的基础上实现8倍放大。重建高分辨率图像时,如果只用一次上采样的操作,在获得大倍数(8倍以上)的上采样因子时就会比较困难,这种方式对于大倍率放大任务(x8)效果较好

- 提出新的损失函数 Charbonnier loss

- 训练一次网络可以完成2,4,8倍的放大任务

改进版本MS-LapSRN(84层);加入了一个递归,增加了一个带有上采样的浅通道来增加图像信息;仍然是使用2×的模块作为基础模块,递归实现4×,8×的任务,2×模块内的conv层也是使用递归,联合使用双重递归大大降低了参数量,实现了一个轻量级的模型

8、(SRDenseNet,ICCV2017,Depth:64层)

直接将DenseNet (CVPR2017)用于超分问题。

在稠密块(dense block)中,前面所有层的输出是后面所有层的输入,每两层之间都有联系。这样能够减轻梯度消失问题、加强特征传播、支持特征复用、减少参数数量【相较于其他分类网络(特征数为256,128),dense block中每层输出的特征图数量都很少(12,24,40)相比较dense少了很多的参数】

SRDenseNet

9、EDSR

10、SRGAN

11、RDN

12、RCAN

13、IDN-TSCN

14、CARN

15、AWSRN

4278

4278

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?