一、解决的问题

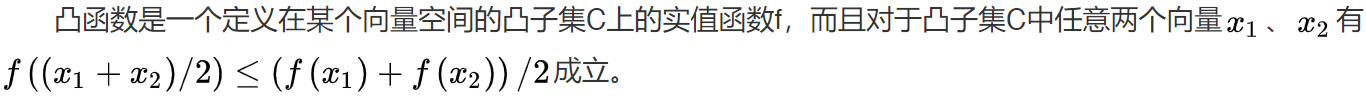

假设是一个凸函数,其中

是一个向量。想要找到

的极小值,那么我们就可以通过梯度下降(Cauchy, 1847)的方法找到这个极小值以及极小值所对应的

。注意,这里的凸函数是指

如果说我们想要解决的问题不是找到的极小值而是找到

的极大值,那么也很简单,只要转化一下问题即可,即找到

的极小值。

二、一个简单的实际问题

这里假设的维度只有一维,然后我们想要下面函数的极大值

一般使用梯度下降算法时我们是不知道函数图像的,但为了便于学习梯度下降算法,我这里先给出它所对应的函数图像,如下

这个函数显然只有极大值,没有极小值。因此,为了能够使用梯度下降法,我们需要对该问题进行转换,即找到函数的极小值,它所对应的函数图像如下

这个时候,我们才能够直接使用梯度下降找到函数的极小值。注意,经过优化后,我们能够找到

的极小值以及极小值所对应的

,但找到极小值不是我们的最终目的,通过

来找到

的极大值才是最终目的。

三、梯度下降法

在使用梯度下降算法之前,我们首先需要明白,输入的是什么,输出的是什么。输入的是的初始值

和目标函数

;输出的是目标函数

极小值及其对应的

。

我们对进行求导,得到

关于

的梯度

,具体如下

然后我们通过

来迭代更新,其中

是学习率。当

时,梯度下降算法收敛。换句话说,当

时,我们找到了

的极小值的近似值(约等于极小值)。

四、使用Python3实现

根据上面的解决方法,除了需要设置函数、

的梯度函数和

的初始值,我们还需要指定一个学习率

。这里,

设定为0.00001,

的初始值设置为-5到5之间的浮点数。具体的代码如下

import math

import random

# y = f(x) = -x*x + 4x + 12

def f(x):

return (- x * x) + 4 * x + 12

# df(x)/dx = -2x + 4

def df(x):

return (- 2 * x) + 4

# y = -f(x)

def negative_f(x):

return -f(x)

# d(-f(x))/dx = -df(x)/dx =-(df(x)/dx)

def negative_df(x):

return -df(x)

# 梯度下降法求y=f(x)= -x*x + 4x + 12 极大值及其对应的x

# 转换后

# 梯度下降法求y=-f(x)极小值及其对应的x

def gradient_descent():

# 设置学习率

epsilon = 0.00001

# 随机初始化x得到x0

x = random.uniform(-5, 5)

# 求梯度(用于更新x)

gradient = negative_df(x)

negative_fx = negative_f(x)

# 输出x、y和梯度的初始值

print('x={:.8f}'.format(x), '-f(x)={:.8f}'.format(negative_fx), 'd(-f(x))/dx={:.8f}'.format(gradient))

while True:

# 迭代更新x

x = x - epsilon * gradient

# 求梯度(用于更新x)

gradient = negative_df(x)

negative_fx = negative_f(x)

# 输出梯度下降过程x、y和梯度的变化

print('x={:.8f}'.format(x), '-f(x)={:.8f}'.format(negative_fx), 'd(-f(x))/dx={:.8f}'.format(gradient))

# 判断梯度下降是否达到收敛条件

if math.fabs(gradient) < 0.0001:

break

# 输出y=-f(x)的极小值及其对应的x

print('Final x={:.8f}'.format(x), '-f(x)={:.8f}'.format(negative_f(x)))

# 根据y=-f(x)极小值对应的x,求y=f(x)的极大值

print('Final x={:.8f}'.format(x), 'f(x)={:.8f}'.format(f(x)))

# 程序入口

if __name__ == '__main__':

gradient_descent()

五、结果

最终的输出结果为

Final x=1.99995000 -f(x)=-16.00000000

Final x=1.99995000 f(x)=16.00000000 第二行的输出值和

(极大值)就是我们通过梯度下降法想要实现的目的。

如果使用迭代的次数作为横坐标,作为纵坐标,那么就能够得到下面的函数优化曲线图。我们能够发现,当迭代次数趋于无穷大时,

收敛于-16。

六、简单的讨论

①由于函数不一定只有一个极小值,所以当

的极小值个数大于1时,使用

解决最优化问题时,很有可能会陷入局部最优化,即虽然找到了一个极小值,但这个极小值很有可能不是全局的极小值(这里全局的极小值等于最小值)。

②经过实践发现,学习率的设置也是很需要技巧的。过大的学习率或者过小的学习率都不好,适中的学习率才是最好的。但是如何才能够找到适中的学习率呢?不知道。这个需要研究者根据特定的问题并经过不断的尝试才能够发现最合适的学习率。

208

208

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?