目录

论文信息

论文名称:Robust Black-box Watermarking for Deep Neural Network using Inverse Document Frequency

作者:Mohammad Mehdi Yadollahi et al. University of New Brunswick

发表年份:2021

发表会议: IEEE Intl Conf on Dependable, Autonomic and Secure Computing, Intl Conf on Pervasive Intelligence and Computing, Intl Conf on Cloud and Big Data Computing, Intl Conf on Cyber Science and Technology Congress

开源代码:None

文章简介

本文开创性地提出一种基于TF-IDF的保护文本分类模型的黑盒水印方法,根据文档中词的重要性构建触发集,训练模型并嵌入水印。

研究动机

本文指出,目前模型水印以及攻击方法大多是用来保护图像处理模型[3-8,10,11,14,15],而对于语言模型的版权问题仍未引起太大重视,个别工作尝试了语言模型的无盒水印[9]。基于此,本文提出一种通过黑盒水印方式保护文本分类模型版权的方法。

研究方法

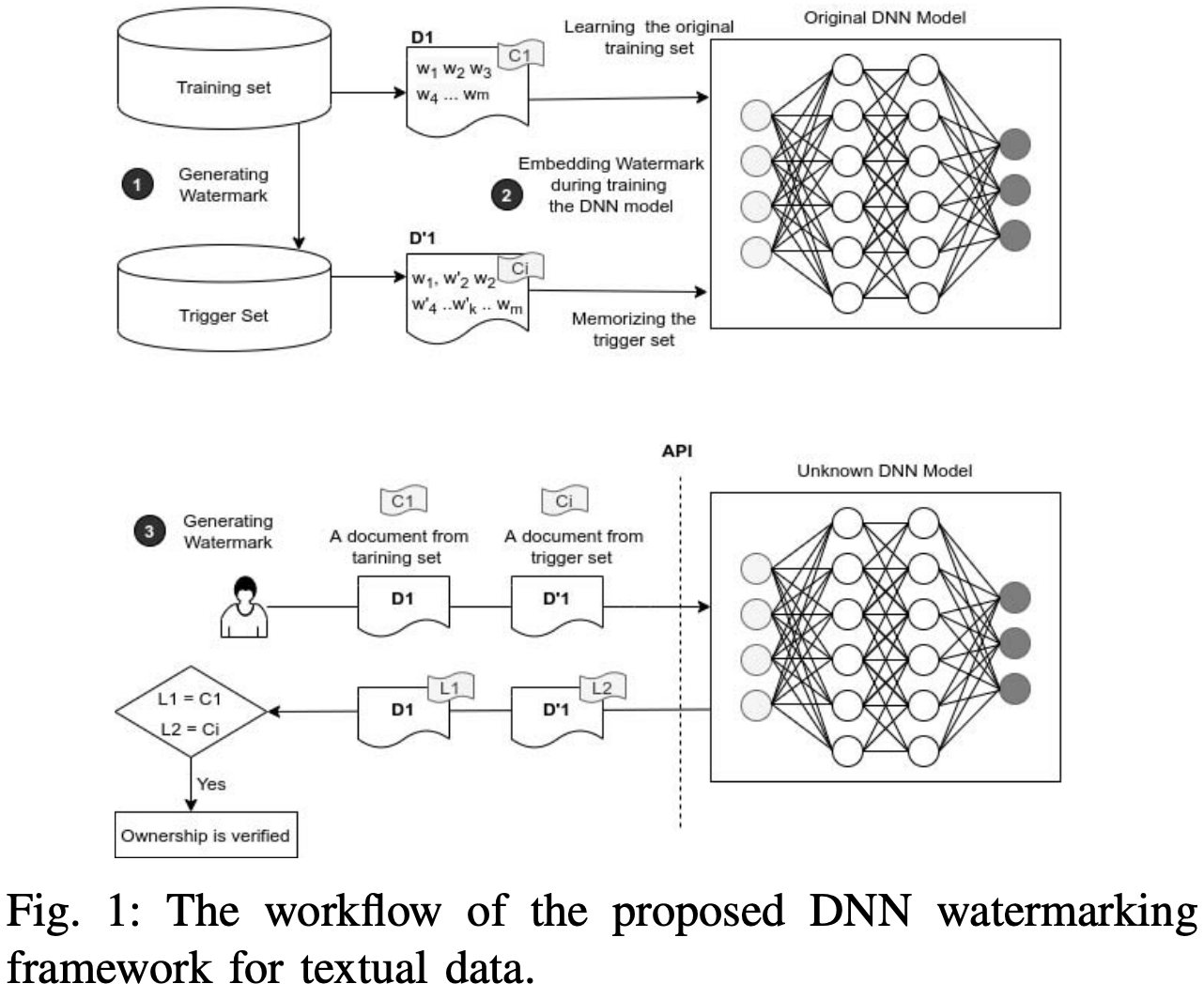

与针对图像分类模型的黑盒水印相似,针对文本分类的黑盒水印同样分为(1)水印生成(触发集构造);(2)水水印嵌入以及(3)版权验证三个阶段。

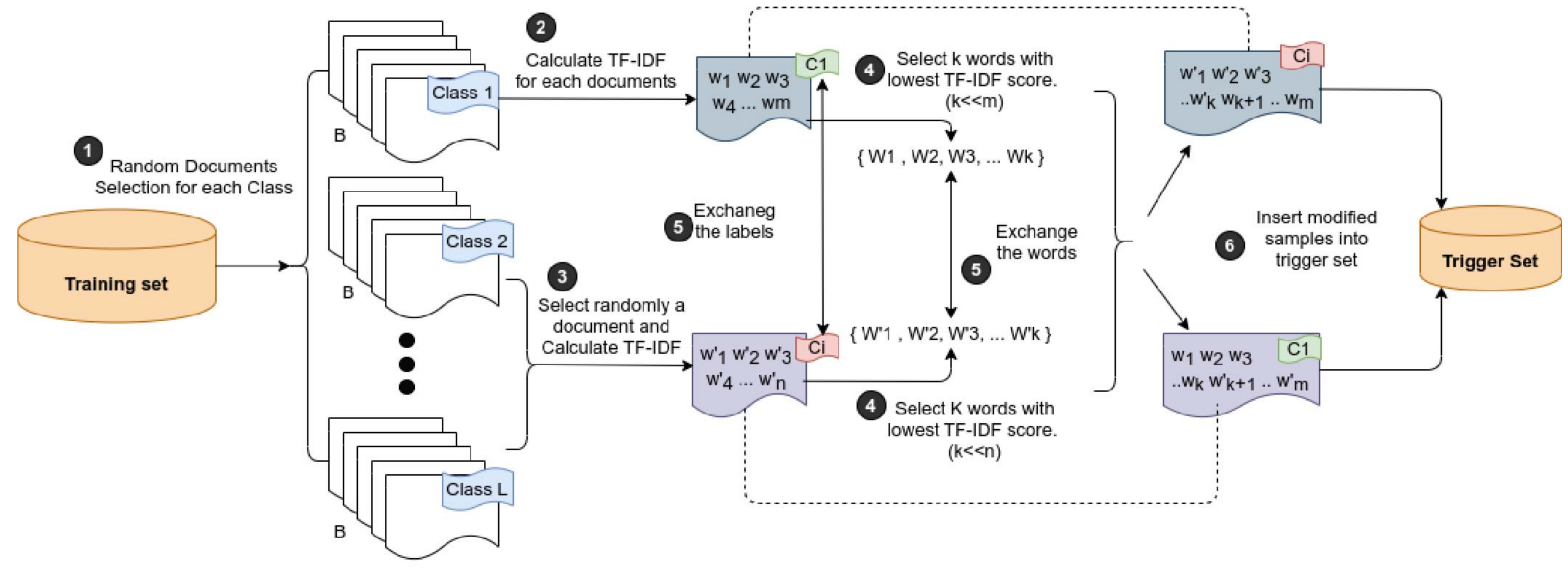

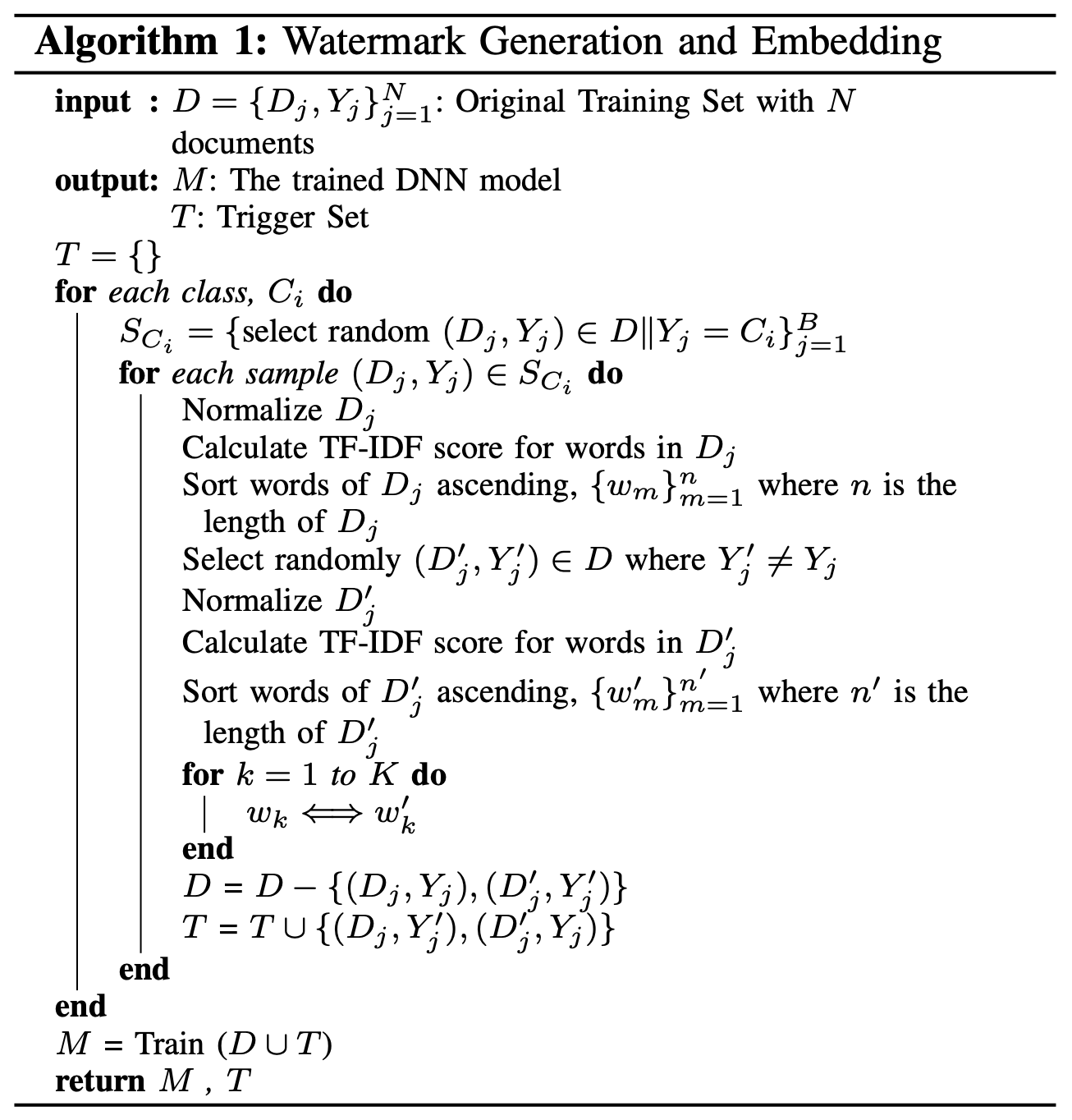

水印生成

从训练集 D D D中选择 N C ∗ B N_{C} * B NC∗B 个原始数据进行修改(其中 N C N_{C} NC 为类别数量, B B B 为每个类别的样本数),得到触发集 T T T。修改方法如下:

- 对每个类别

C

i

C_{i}

Ci:

- 得到 B B B 个样本集合 S C i S_{C_{i}} SCi,

- 对每个样本

(

D

j

,

Y

j

)

∈

S

C

i

(D_{j}, Y_{j}) \in S_{C_{i}}

(Dj,Yj)∈SCi:

(1) 对文档 D j D_{j} Dj 去停用词;

(2) 计算 D j D_{j} Dj 中每个单词 w m w_{m} wm 的 TF-IDF 分数,用来衡量单词的重要性;

(3) 对 D j D_{j} Dj 中的单词进行降序/升序排列;

(4) 选择与当前样本类别 Y j Y_{j} Yj 类别不一致的另一样本 ( D j ′ , Y j ′ ) (D'_{j}, Y'_{j}) (Dj′,Yj′)

(5) 计算 D j ′ D'_{j} Dj′ 中每个单词 w m ′ w'_{m} wm′ 的 TF-IDF 分数,用来衡量单词的重要性;

(6) 对 D j ′ D'_{j} Dj′ 中的单词进行降序/升序排列;

(7) 根据排序结果,将 D j D_{j} Dj 与 D j ′ D'_{j} Dj′ 的前 K K K 个词进行互换,得到两个水印文档。

(8) 对调 D j D_{j} Dj 与 D j ′ D'_{j} Dj′ 对应的标签,得到触发集中的两个样本 ( D j ′ , Y j ) (D'_{j}, Y_{j}) (Dj′,Yj) 与 ( D j , Y j ′ ) (D_{j}, Y'_{j}) (Dj,Yj′)。 - 重复上述过程,直到得到总数为 N C ∗ B N_{C} * B NC∗B 的触发集 T T T。

生成的水印文档示例如下:

水印嵌入

采用数据投毒的方式,使用触发集与其余训练数据对模型进行 From Scratch 的训练。水印生成与水印嵌入的完整流程如下:

版权验证

将触发集中的水印文档输入到模型中,若模型输出预设的水印标签,则说明当前模型为含水印的模型。

实验结果

在 IMDB 与 HamSpam 两个二分类数据集上进行实验。但是没有说用的是什么模型呀!

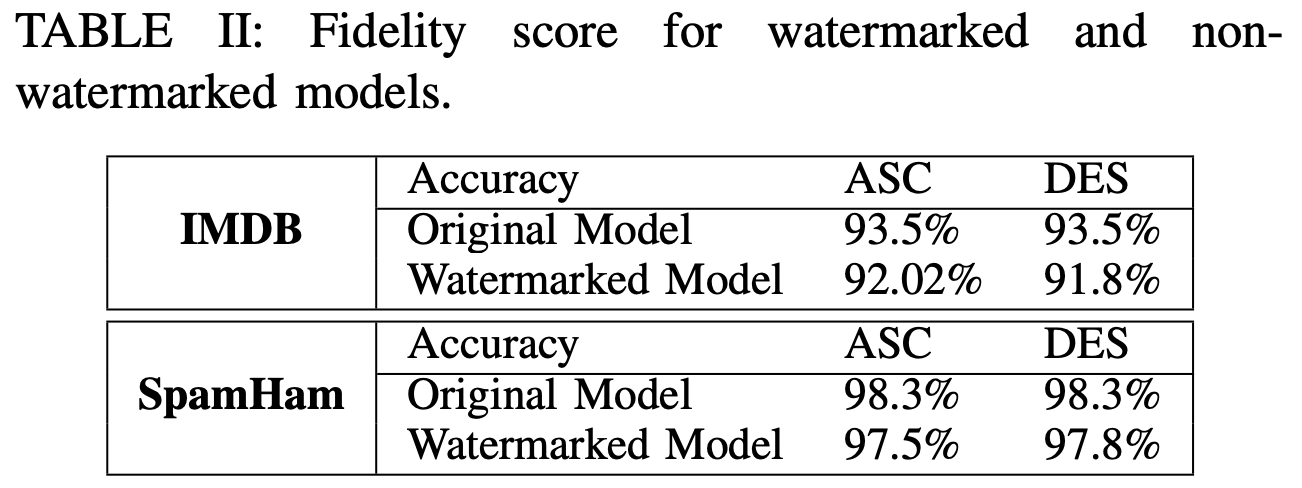

保真度(Fidelity)

其中,ASC和DES为触发集构造阶段对文档中单词重要性的排序依据,ASC为升序排列,DES为降序排列。

Integrity(完整性)

虚警率要低,防止伪造攻击。也就是误触发率要尽可能低,防止模型窃取者模糊模型的版权。(未测试)

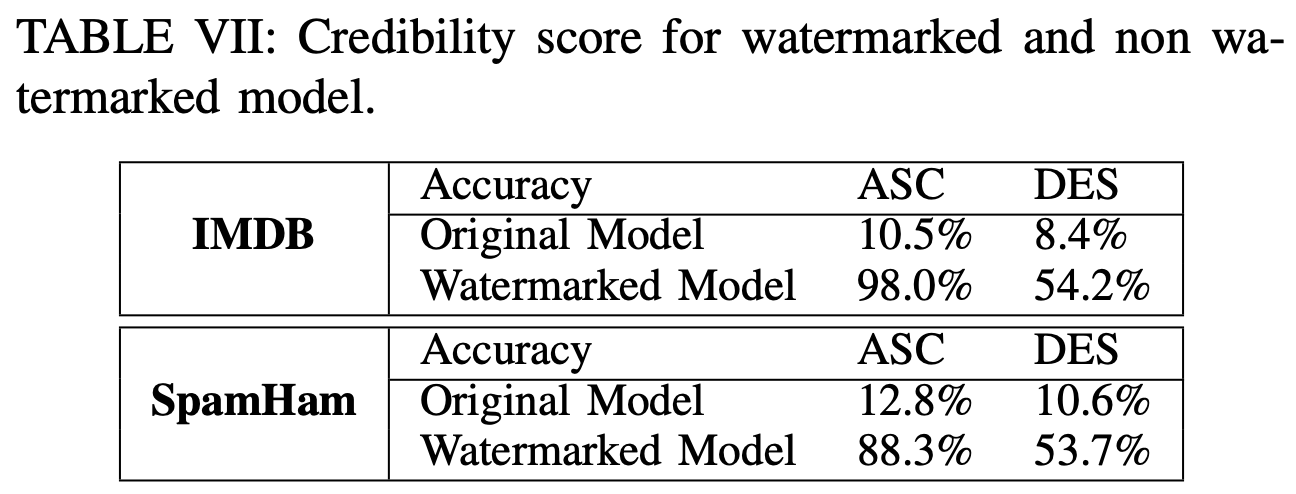

Credibility(有效性)

要尽可能地检测出水印的存在,漏报率要尽可能低。

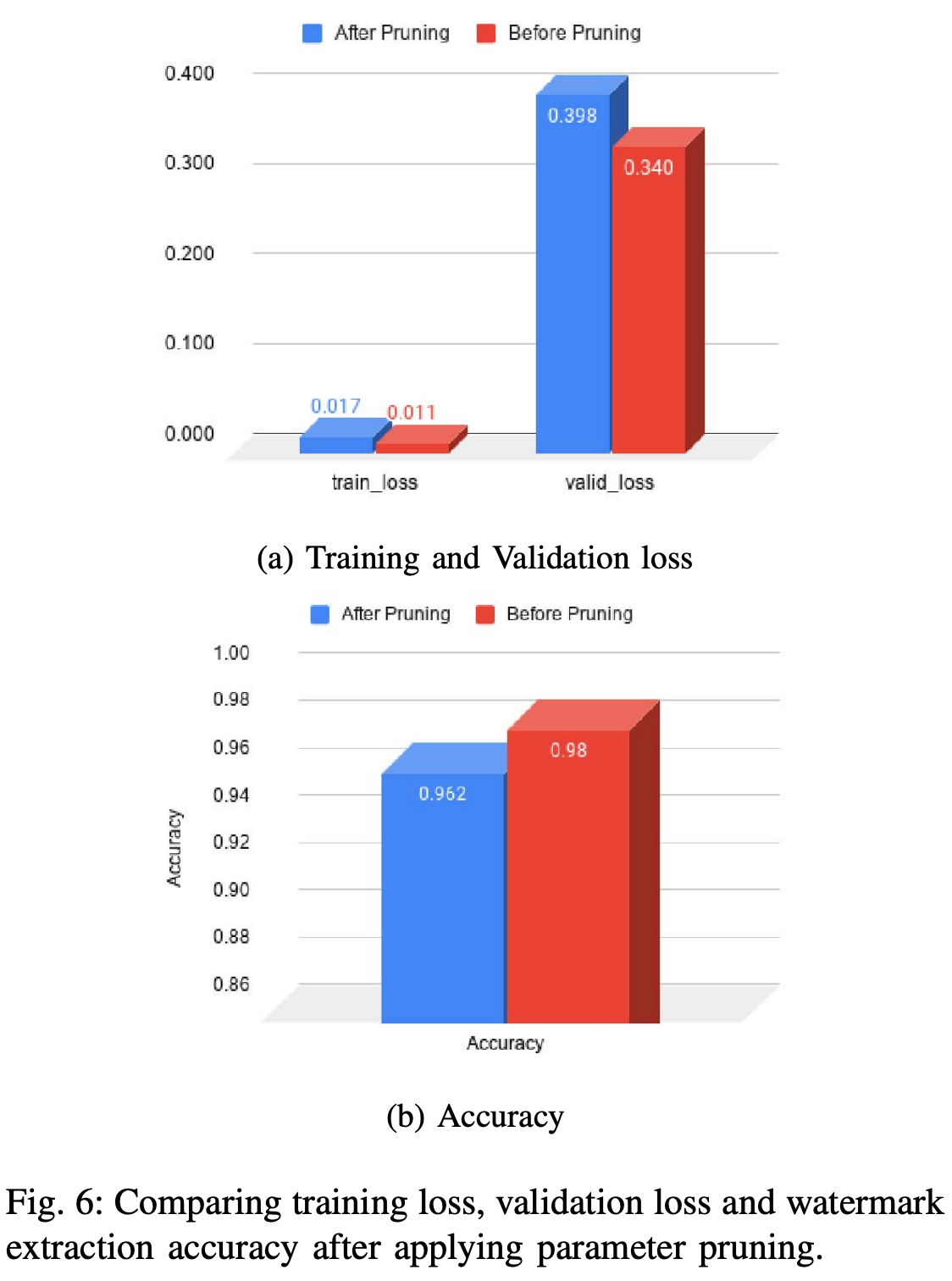

Robustness(鲁棒性)

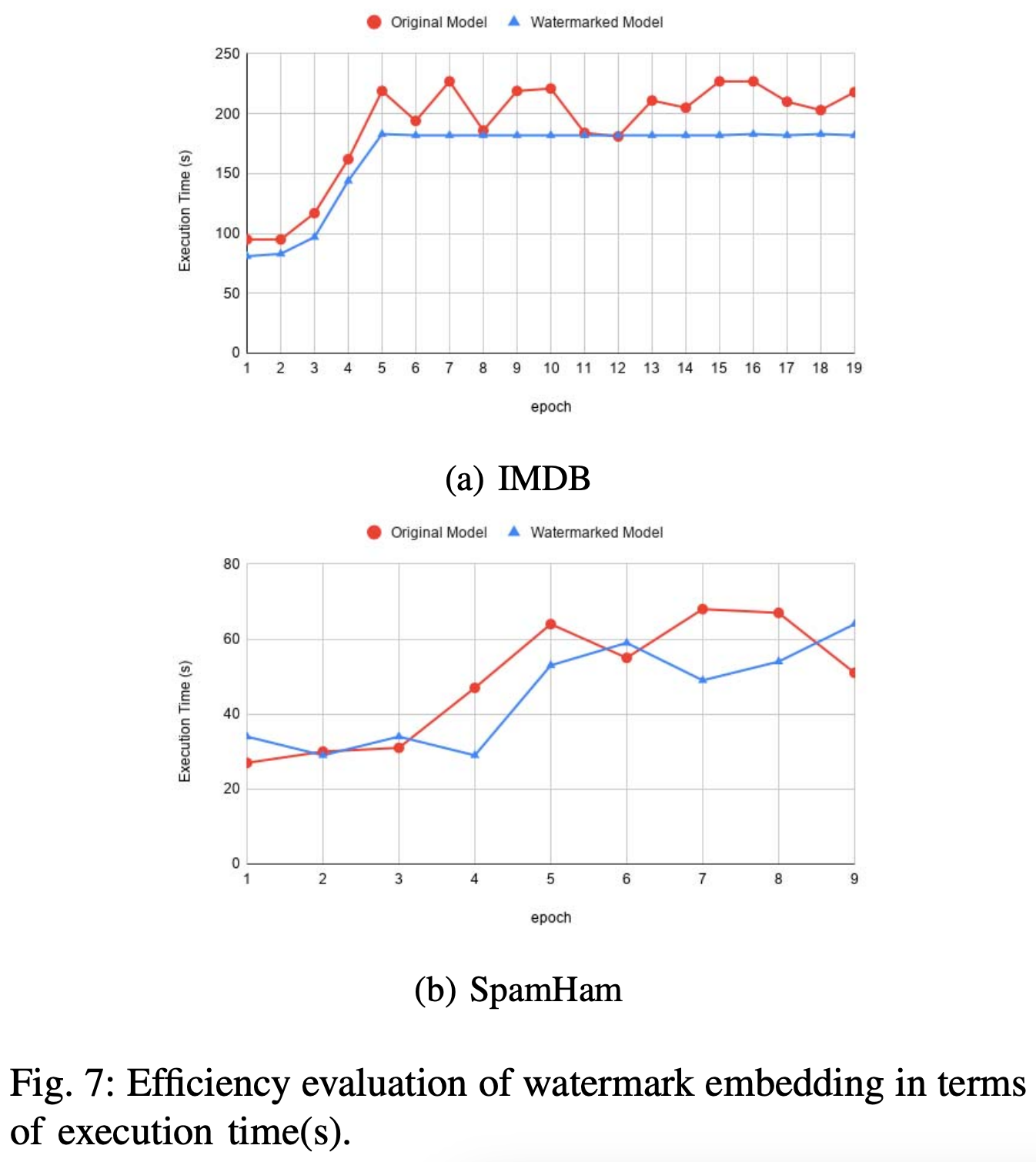

Efficiency(高效性)

Security(安全性)

本工作分析了brute-force attack对于文本领域黑盒水印的影响,作者指出,由于文本空间是无穷且离散的,因此暴力破解攻击对文本领域不适用。

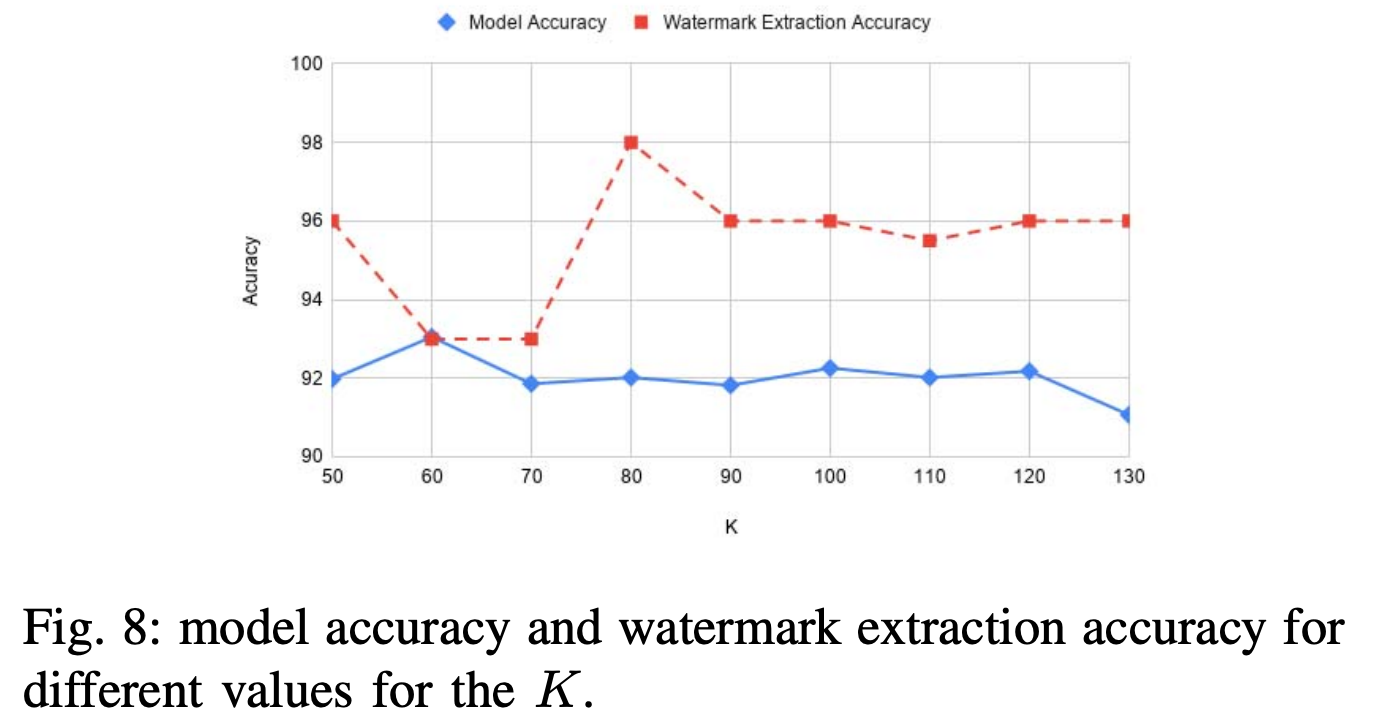

消融实验

本文分析了超参数

K

K

K 对于水印保真度和有效性的影响。

方法评估

To the best of my knowledge, 这是第一篇对语言模型进行水印保护的文章,使用的是黑盒水印方法,构造触发集的方式比较独特,是通过对两个文档中的某些极端单词对调产生水印文档,同时互换标签得到水印标签。不过不太清楚作者为什么要通过这种元素互换的方式构造水印文档,还有一个问题就是,通过这种方式生成的水印文档很容易遭受查询修改攻击,因为由 Figure 3 可知,水印文档的流畅性并不是那么高,很有可能被攻击者识别出来,从而破坏模型所有者对于版权的验证过程。

相关文献

[3] J. Zhang, Z. Gu, J. Jang, H. Wu, M. P. Stoecklin, H. Huang, and I. Molloy, “Protecting intellectual property of deep neural networks with watermarking,” AsiaCCS, 2018.

[4] J. Guo and M. Potkonjak, “Watermarking deep neural networks for embedded systems,” ICCAD, 2018.

[5] H. Chen, B. D. Rouhani, and F. Koushanfar, “Blackmarks: Blackbox multibit watermarking for deep neural networks,” arXiv, 2019.

[6] Y. Nagai, Y. Uchida, S. Sakazawa, and S. Satoh, “Digital watermarking for deep neural networks,” International Journal of Multimedia Information Retrieval, vol. 7, no. 1, pp. 3–16, 2018.

[7] H. Chen, B. D. Rouhani, C. Fu, J. Zhao, and F. Koushanfar, “Deepmarks: A secure fingerprinting framework for digital rights management of deep learning models,” ICMR, 2019.

[8] S. Szyller, B. G. Atli, S. Marchal, and N. Asokan, “Dawn: Dynamic adversarial watermarking of neural networks,” MM, 2021.

[9] A. Venugopal, J. Uszkoreit, D. Talbot, F. J. Och, and J. Ganitkevitch, “Watermarking the outputs of structured prediction with an application in statistical machine translation,” EMNLP, 2011.

[10] M. Shafieinejad, J. Wang, N. Lukas, and F. Kerschbaum, “On the robustness of the backdoor-based watermarking in deep neural networks,” IH&MMSec, 2021.

[11] R. Namba and J. Sakuma, “Robust watermarking of neural network with exponential weighting,” AsiaCCS, 2019.

[14] B. D. Rouhani, H. Chen, and F. Koushanfar, “Deepsigns: A generic watermarking framework for ip protection of deep learning models,” ASPLOS, 2019.

[15] Y. Quan, H. Teng, Y. Chen, and H. Ji, “Watermarking deep neural networks in image processing,” IEEE TNNLS, 2020.

1902

1902

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?