上一章:深度篇——神经网络(二) ANN与DNN 和常用激活函数

下一章:深度篇——神经网络(四) 细说 调优神经网络

本小节,细说 网络拓扑与训练神经网络,下一小节细说 调优神经网络

二. ANN 与 DNN

3. 网络拓扑

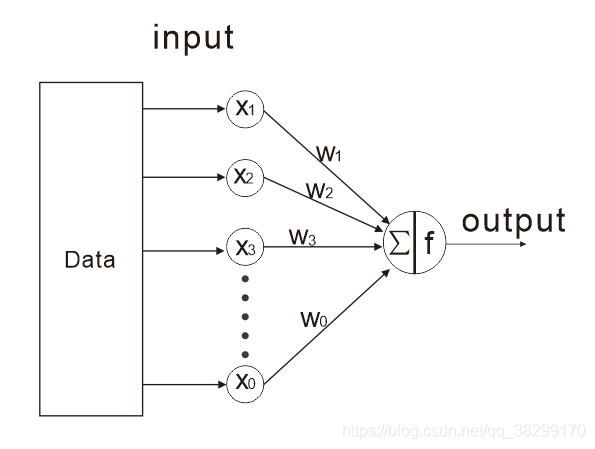

(1). 单层网络

(2). 多层网络

多层网络至少有 1 个 hidden 层,也可以有多个 hidden 层。有 bias 值,可以让函数不必一定要经过原点。

(3). 无论是 ANN,还是 DNN,网络连接都是全连接。

output 层的激活函数与 hidden 层的激活函数可以相同,也可以不同,根据需求而定。output 层可以是单值输出,也可以是多值输出。

4. 训练神经网络

(1). 训练神经网络的两个阶段

①. 前向阶段

前向阶段即正向传播

正向传播根据数据集和激活函数,当前的 值,计算出 loss 损失函数

②. 后向阶段

后向阶段即反向传播

反向传播利用链式法则对 进行求导,代入数据集的值,求出梯度

③. 链式法则

若函数 在点

上可导,

则

④. 栗子

a. 栗一

有 ,且

。

解:令 ,则

本文深入探讨了神经网络的网络拓扑,包括单层和多层网络结构,并详细阐述了训练神经网络的过程,涉及前向传播、反向传播、链式法则和梯度下降法。通过实例解释了如何计算损失函数和更新权重,为理解神经网络的训练机制提供了清晰的指导。

本文深入探讨了神经网络的网络拓扑,包括单层和多层网络结构,并详细阐述了训练神经网络的过程,涉及前向传播、反向传播、链式法则和梯度下降法。通过实例解释了如何计算损失函数和更新权重,为理解神经网络的训练机制提供了清晰的指导。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?