一、k8s资源监控

- Metrics-Server是集群核心监控数据的聚合器,用来替换之前的heapster。

容器相关的 Metrics 主要来自于 kubelet 内置的 cAdvisor 服务,有了Metrics-Server之后,用户就可以通过标准的 Kubernetes API 来访问到这些监控数据。

Metrics API 只可以查询当前的度量数据,并不保存历史数据。

Metrics API URI 为 /apis/metrics.k8s.io/,在 k8s.io/metrics 维护。

必须部署 metrics-server 才能使用该 API,metrics-server 通过调用 Kubelet Summary API 获取数据。 - Metrics Server 并不是 kube-apiserver 的一部分,而是通过 Aggregator 这种插件机制,在独立部署的情况下同 kube-apiserver 一起统一对外服务的。

kube-aggregator 其实就是一个根据 URL 选择具体的 API 后端的代理服务器。

Metrics-server属于Core metrics(核心指标),提供API metrics.k8s.io,仅提供Node和Pod的CPU和内存使用情况。而其他Custom Metrics(自定义指标)由Prometheus等组件来完成。

1.Metrics-server安装部署

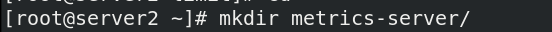

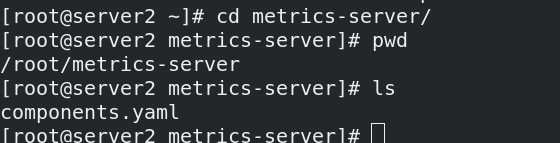

建立用于存放相关资源清单文件的目录

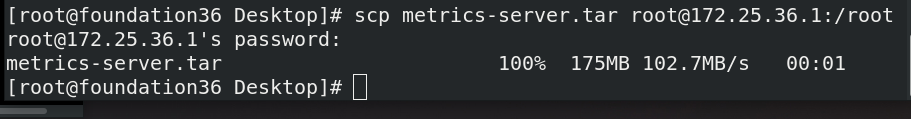

真机将metrics-server.tar发送给server1

server1导入镜像,并上传至仓库

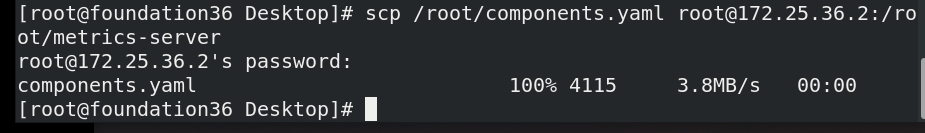

真机将components.yaml发送给server2

应用资源清单

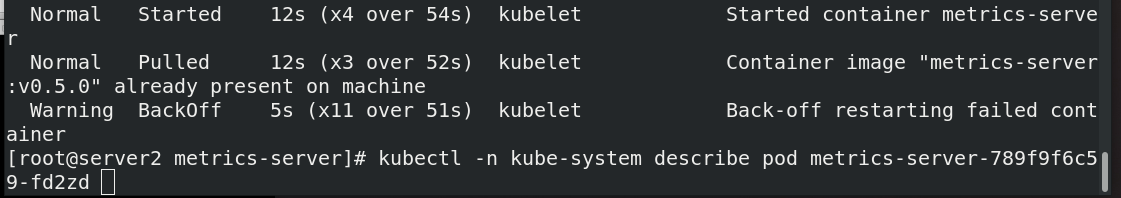

发现没有就绪

查看日志

2.解决报错

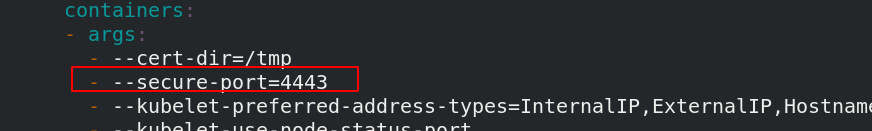

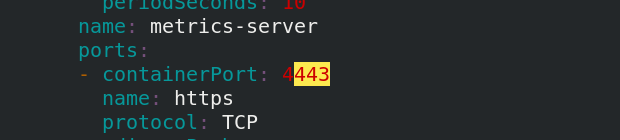

修改清单配置,安全端口和容器端口修改为4443

应用配置

查看kube-system命名空间的pod信息,可以看到metrics-server处于运行状态但并未就绪

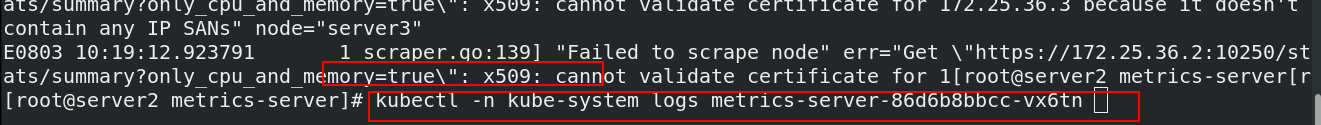

查看日志,报错1:x509: certificate signed by unknown authority;

显然缺少证书,Metric Server 支持一个参数 --kubelet-insecure-tls,可以跳过这一检查,然而官方也明确说了,这种方式不推荐生产使用。

此时metrics-server没有后端服务器

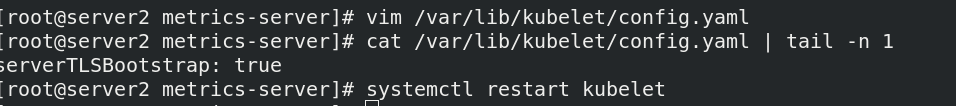

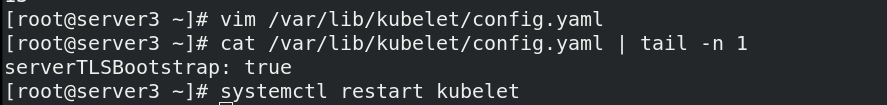

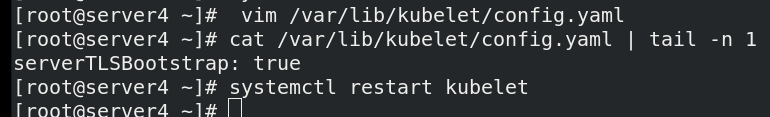

在master和各个节点上,启用TLS Bootstrap 证书签发;

添加之后,重启服务

再次应用资源清单创建pod,但是仍然为就绪;

提示tls内部错误,安全传输层协议(TLS)用于在两个通信应用程序之间提供保密性和数据完整性。

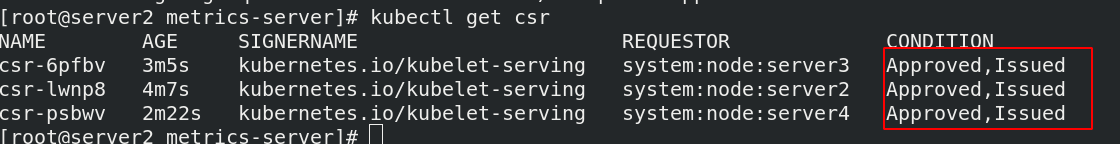

查看证书,可以看到是pending状态;

当对三个节点都进行授权后

查看状态变为已授权

错误2:当出现 dial tcp: lookup server2 on 10.96.0.10:53: no such host

这是因为没有内网的DNS服务器,所以metrics-server无法解析节点名字。可以直接修改coredns的configmap,将各个节点的主机名加入到hosts中,这样所有Pod都可以从CoreDNS中解析各个节点的名字。

编辑coredns的cm

将各个节点的主机名加入到hosts中

修改完成后metrics-server正常运行

可以看到后端地址和端口

部署成功后,通过kubectl top node可以监控到所有节点的资源使用情况

查看 pod 的使用情况

使用以下命令查询,以验证安装是否成功,如果安装成功会返回一堆值

二、Dashboard部署(可视化)

- Dashboard可以给用户提供一个可视化的 Web 界面来查看当前集群的各种信息。用户可以用 Kubernetes Dashboard 部署容器化的应用、监控应用的状态、执行故障排查任务以及管理 Kubernetes 各种资源。

首先在仓库创建新项目kubernetesui,方便管理镜像

下载所需要的配置文件:recommended.yaml

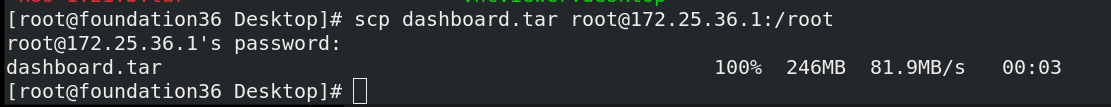

真机将dashboard.tar发送给server1

server1导入镜像并上传至仓库

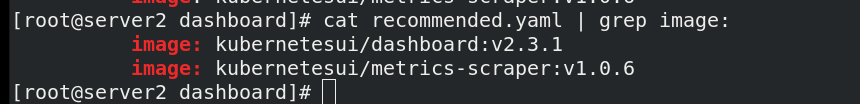

修改配置文件中的镜像地址和版本

应用recommended.yaml文件,可以看到创建了新的ns和服务等

可以看到新创建的ns:kubernetes-dashboard

查看kubernetes-dashboard下的容器和服务是否正常运行;

注意:psp安全策略一定要禁掉,否则两个控制器起不来

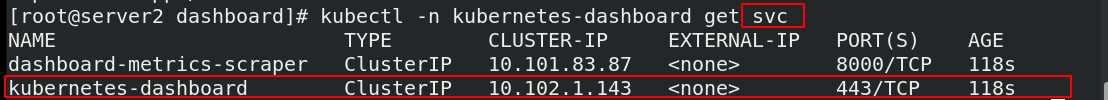

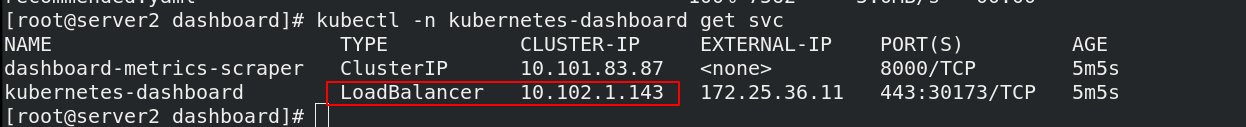

查看svc服务

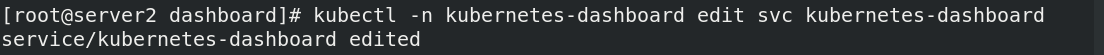

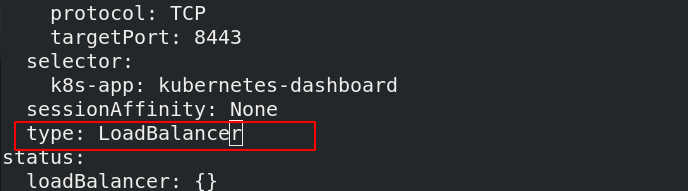

更改 kubernetes-dashboard 的 ClusterIP 为 loadbalance,使外部可以访问

修改完成后,可以看到其外部访问地址为172.25.36.11

查看metallb-system命名空间,有4个pod

根据暴露的ip网页访问:https://172.25.36.11,发现需要输入token才能认证

查看kubernetes-dashboard命名空间内的secrets,找到token

查看详细信息,把token复制,粘贴到网页中

认证成功后进入界面,不过有红色报错信息;

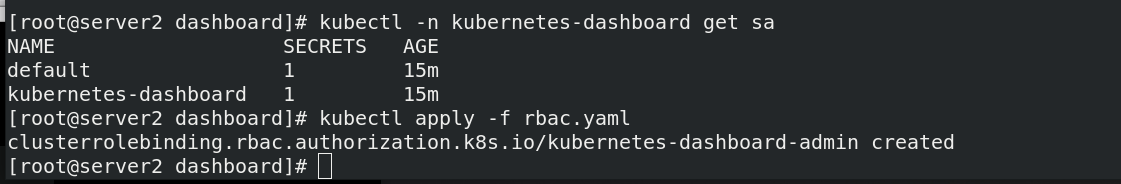

因为默认dashboard对集群没有操作权限,需要授权,接下来我们需要解决授权问题

通过查看dashboard的kubernetes-dashboard这个全局角色的详细信息,可以看到只有读权限(get list watch)

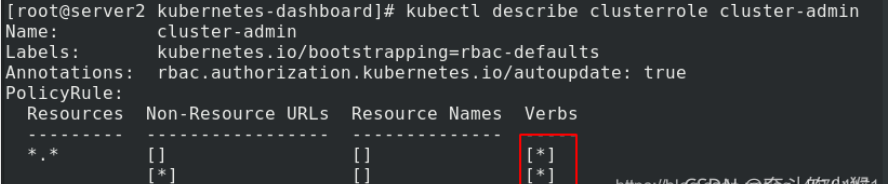

编辑rbac.yaml配置文件,在全局角色绑定中将cluster-admin的权限赋予kubernetes-dashboard,使其具有读写权限(cluster-admin是 Kubernetes 提供的预先定义好的 ClusterRole 来供用户直接使用)

kind: ClusterRoleBinding %全局角色绑定

name: cluster-admin %权限使用的是以前创建的cluster-admin,在里面有读写权限

name: kubernetes-dashboard %作用对象是kubernetes-dashboard

应用 rbac.yaml文件,可以看到权限是*,表示全开

现在重新测试访问,现在网页就没有报错了,可以查看到监控

查看控制器状态

三、Dashboard图形化控制k8s

使用图形化创建一个控制器

成功创建控制器

进入server2命令行也可以查看到刚创建的pod,查看其ip并测试访问

将镜像的v1版本升级成v2

测试修改成功

在Deployments菜单中,修改元数据

扩容到三个副本

此时有3个pod正在运行

3625

3625

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?