引入

题目:Multi-instance transfer metric learning by weighted distribution and consistent maximum likelihood estimation( 通过加权分布和一致的最大似然估计进行多示例迁移度量学习)

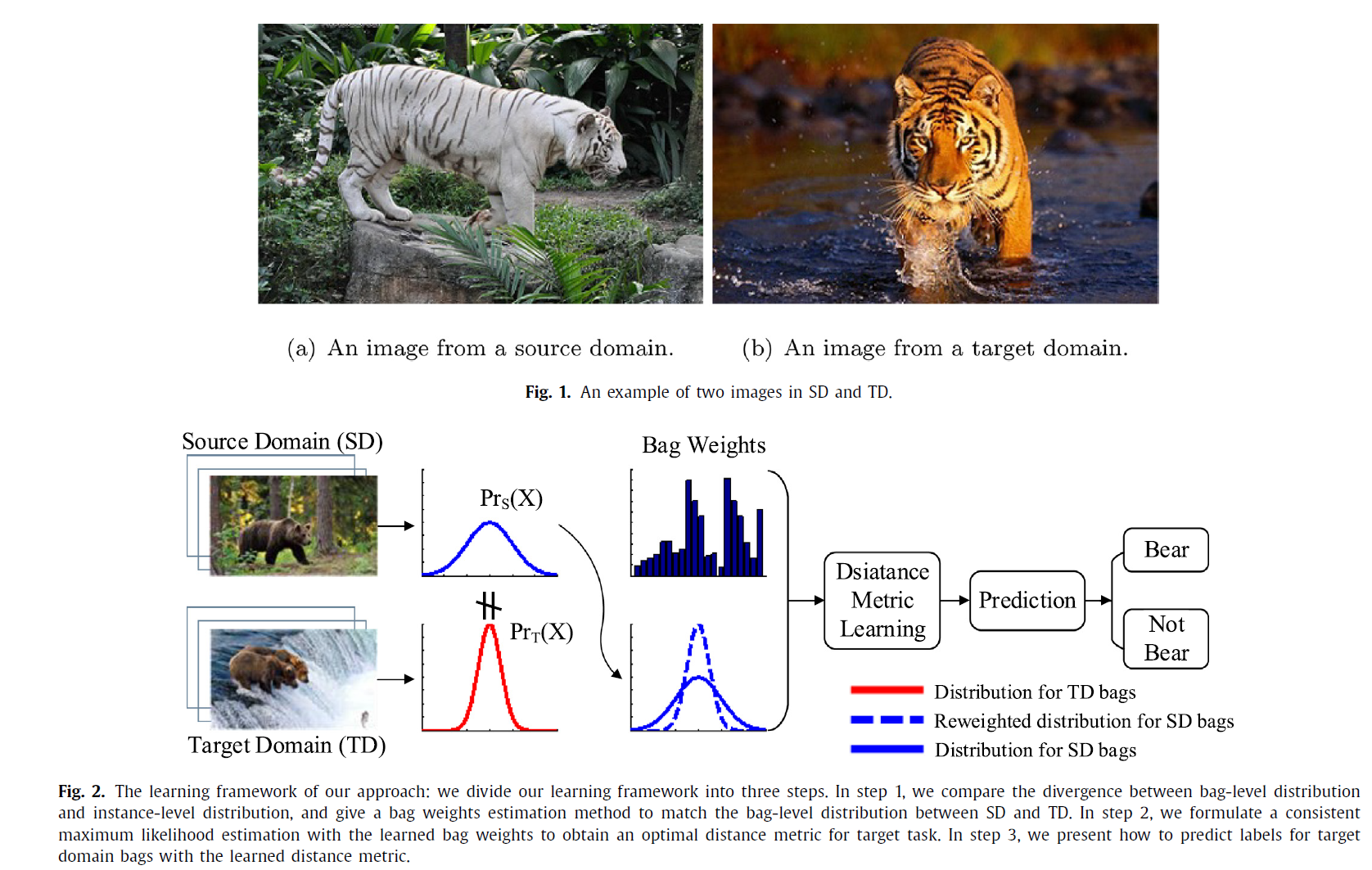

摘要:多示例学习 (MIL) 旨在通过训练带有标签包的模型来预测未标记包的标签。 现有 MIL 方法的通常假设是训练数据的底层分布与测试数据的分布相同。 然而,这种假设在实践中可能无效,尤其是当来自源域(SD)的训练数据和来自目标域(TD)的测试数据来自不同的分布时。 在本文中,我们提出了一种新颖的算法多示例迁移度量学习(MITML)。 特别是,MITML 首先尝试通过使用包加权方法来桥接不同域的分布。 然后学习一致的最大似然估计方法来构建最佳距离度量并用于对测试包进行分类。

Bib:

@article{JIANG201849,

title = {Multi-instance transfer metric learning by weighted distribution and consistent maximum likelihood estimation},

journal = {Neurocomputing},

volume = {321},

pages = {49-60},

year = {2018},

issn = {0925-2312}

}

方法概述

学习框架分为三个步骤:

在步骤 1 中,比较了包级别分布和实力级别分布之间的差异,并给出了包权重估计方法来匹配 SD 和 TD 之间的包级别分布。

在步骤 2 中,用学习到的包权重制定一致的最大似然估计,以获得目标任务的最佳距离度量。

在第 3 步中,展示了如何使用学习的距离度量来预测目标域包的标签。

主要贡献

- 我们说明了包级别的分布差异,并找到了一种通过在多示例情况下扩展**核均值匹配(KMM) ** 来估计包权重的方法。 所提出的方法允许我们在不使用复杂的密度估计的情况下估计包的权重。 学习到的包权重可用于将知识从 SD 转移到 TD 中的多示例任务。

- 相对于一些基于度量的迁移学习中的传统学习原则,侧重于调整类内和非类的参数,MITML 提出了一种新的学习原则,不仅最大化相同标签包之间的判别概率,而且最小化不同标签包之间的概率。新的学习原理允许 MITML 使用更少的参数,从而提高了算法的泛化能力。

212

212

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?