A Unified End-to-End Framework for Efficient Deep Image Compression

Abstract

图像压缩是一种广泛使用的减少图像空间冗余的技术. 近年来, 基于学习的图像压缩利用神经网络强大的表示能力取得了重大进展. 然而, 目前最先进的基于学习的图像压缩方法计算量巨大, 限制了其实际应用能力. 在本文中, 我们基于三种新技术提出了一种称为高效深度图像压缩 (EDIC) 的统一框架, 包括通道注意模块, 高斯混合模型和解码器端增强模块. 具体来说, 我们设计了一种用于基于学习的图像压缩的自动编码器式网络. 为了提高编码效率, 我们使用通道注意模块来利用潜在表示之间的通道关系. 此外, 熵模型引入了高斯混合模型, 提高了比特率估计的准确性. 而且, 我们引入了解码器端增强模块, 以进一步提高图像压缩性能. 我们的EDIC方法也可以很容易地与深度视频压缩 (DVC) 框架[1]结合, 以进一步提高视频压缩性能. 同时, 我们的EDIC方法显著提高了编码性能, 同时略微增加了计算成本. 更重要的是, 实验结果表明该方法优于当前最先进的图像压缩方法, 与Minnen方法[2]相比, 解码速度快150倍以上. 该框架还成功地提高了最新深度视频压缩系统DVC[1]的性能.

1. Introcution

图像压缩旨在减少图像中的空间冗余, 在许多应用中广泛用于节省带宽和存储大小. 传统的图像压缩方法[3]-[6]依赖手工制作的技术来提高压缩效率. 例如, JPEG[3]使用离散余弦变换 (DCT) 将图像从像素域转换到频域以获得高压缩效率. 然而, 传统的压缩方法无法通过使用大规模训练进行优化, 这可能会限制其性能.

近年来, 基于学习的图像和视频压缩方法[1], [2], [7]-[19]受到越来越多的关注. Ballé等人[9]提出了一种使用基于卷积神经网络 (CNN) 的自动编码器的端到端优化图像压缩方法. 为了进一步提高压缩效率, Minnen等人[2]使用自回归先验信息来获得准确的熵模型, 并获得与传统编解码器相当甚至更好的性能[6].

虽然当前最先进的基于学习的方法[2], [18]提高了压缩性能, 但它们也显著增加了计算成本. 与之前的学习方法[9], [10]相比, 当前最先进的方法[2], [18]通过使用自回归先验信息来利用潜在特征空间中的空间冗余. 因此, 对每个像素顺序执行[2], [18]中的解码过程, 而先前的方法[9], [10]可以并行地通过卷积层重构所有像素. 如 表1 所示, 使用Ballé方法[10]的分辨率为 768×512 的图像的平均GPU解码时间为0.013秒, 而使用Minnen方法[2]的相应解码时间为2.426秒. 在本文中, 我们提出了一个问题: 是否有可能在不显著增加计算时间的情况下提高压缩效率? 为了解决这个问题, 我们提出了一个称为高效深度图像压缩的统一框架, 该框架由三个新组件组成, 包括通道注意模块, 高斯混合模型和解码器端增强模块. 具体来说, 我们利用自动编码器式网络来构建图像压缩框架. 为了进一步提高压缩性能, 我们还利用编码器侧潜在特征中的信道关系,并使用有效的信道注意模块来增强相应的表示能力。更重要的是与[2], [9], [10], [18]一样,我们建议使用高斯混合模型 (GMM) 进行更精确的熵估计, 而不是使用单一高斯模型进行熵估计. 此外, 我们引入了解码器端增强模块来减少压缩伪影. 信道注意技术, 高斯混合模型和解码器端增强模块无缝结合, 与[2], [18]中的自回归先验技术相比, 该技术在计算成本略有增加的情况下, 获得了更好的图像压缩性能. 实验结果表明, 与当前最先进的方法[2]相比, 本文提出的图像压缩方法实现了相当的压缩性能, 而对于分辨率为 768×512 的图像,我们的方法的解码速度比[2]快150倍以上. 我们的方法可以很容易地用于视频压缩, 并且在视频压缩方面也取得了很好的效果.

表1, 不同方法在柯达[20]图像数据集上的解码时间和BDBR较jpeg2000[4]的改进. 解码时间正在使用一个RTX 2080ti进行评估. BDBR的全称是“bjontegaard delta比特率”, 是指在相同psnr下比特率的相对还原百分比.

本文的贡献总结在以下几个方面. 首先, 据我们所知, 我们是第一个引入通道注意技术来提高图像压缩效率的人. 其次, 引入高斯混合模型以更精确的方式模拟潜在表示的分布. 第三, 我们还应用了解码器端增强模块, 以进一步提高图像压缩性能. 第四, 与Minnen方法[2]相比, 我们提出的EDIC框架实现了最先进的图像压缩性能, 同时显著减少了解码时间. 第五, 所提出的框架具有通用性, 并且提高了最近基于学习的视频压缩系统的性能[1].

最近的两项工作[21]、[22]也提出了类似的想法来提高图像压缩性能. 然而, 我们想强调的是, 我们的工作是一个并行的工作, 因为这两个作品[21],[22]的日期,这三个作品出现在arxiv, 彼此非常接近. 此外, 我们的工作在以下三个方面与文献[21], [22]不同. 首先, 两个作品[21], [22]都利用了基于作品[2]的上下文信息, 这与[2]中的方法一样非常慢. 相比之下, 我们的工作基于[10]中的方法而不是[2]中的算法, 因此我们的工作比这两个工作[21], [22]都快得多. 其次, 我们提出的注意力模块是利用潜在表征的通道关系, 而程等人[21]介绍了用于图像压缩的空间注意力方案. 第三, 我们还使用我们新提出的技术 (即高斯混合模型、信道注意方案和解码器端增强方法) 进行视频压缩, 并在基准数据集上取得了有希望的结果, 这在[21]、[22]中没有讨论.

2. Relatied Work

A. Traditional Image and Video Compression

在实际应用中, 图像和视频压缩技术被广泛用于节省带宽和存储容量. 在过去的几十年里, 人们提出了许多图像和视频压缩方法, 并成功地建立了一些标准. 为了提高压缩效率, 传统的图像和视频压缩方法[3]-[6]依赖于手动设计的技术, 例如线性变换, 基于块的运动估计和运动补偿方案.

图像压缩方法主要关注于减少图像中的空间冗余. 一种简单的方法是将图像从像素域转换到更易于压缩的频域. 例如JPEG[3]使用离散余弦变换, 而JPEG2000[4]使用离散小波变换. 在变换过程之后, 这些系数被量化, 然后被发送到解码器侧. 为了进一步提高压缩效率, 通过使用熵编码工具 (例如算术编码[24]) 对量化系数进行无损编码. 最近, 视频压缩中的帧内预测技术也被用于图像压缩. 例如, BPG[6]标准基于HEVC/H.265[25], 与先前的图像编解码器 (例如JPEG和JPEG2000) 相比, 该标准实现了最先进的图像压缩性能. BPG标准采用预测变换技术, 并采用35种编码模式来获得预测图像, 这进一步减少了空间冗余.

视频压缩用于减少视频序列中的时间冗余. 为了提高压缩效率, 大多数视频压缩算法遵循混合编码架构. 特别是H.264[26]是使用最广泛的视频编解码器. 在H.264中, 使用基于块的运动估计和运动补偿模块来获得预测帧. 然后, 我们可以计算剩余信息, 并使用线性变换对其进行压缩. 最近, HEVC/H.265[25]和多功能视频编码 (VVC) 被提出作为下一代视频编解码器. 这些标准建立在以前的混合编码架构的基础上, 并利用更先进的技术进行高效编码. 例如, HEVC使用所谓的编码单元 (CU) 树技术, CU大小在64×64 到 8×8 之间, 为不同的视频内容提供灵活的编码单元.

B. Learning based Image and Video Compression

在过去几年中, 深度神经网络 (DNN) 已经证明了其在许多计算机视觉任务中的有效性, 包括超分辨率, 去噪等. 最近, 研究人员试图利用神经网络强大的表示能力来提高图像/视频压缩性能[2], [7]-[16] ,[18]. Toderici等人提出了第一个使用递归神经网络 (RNN) 的基于学习的图像压缩框架. 他们的方法可以通过单个模型生成多个比特率. 在[17]中, 引入了更先进的RNN模块和有效的重建技术, 以便在MS-SSIM方面与BPG相比达到相当甚至更好的性能[27], 然而, 这些方法[7], [8], [17]旨在最小化比特率, 而不是考虑率失真权衡.

在[9]中,Ballé等人通过优化率失真准则,提出了一种基于CNN的图像压缩框架。为了提高熵模型的准确性,在[10]中提出了一种超先验模型,其中潜在表示基于零均值高斯分布建模。在[2]中,Minnen等人采用自回归先验来进一步改进压缩,并在峰值信噪比方面取得优于BPG的性能。然而,这些基于CNN的图像压缩系统必须针对不同的比特率训练不同的模型,并显著增加模型大小。在[28]中,Choi等人提出了一种使用条件自动编码器的变速率深度图像压缩框架,并通过单个模型生成不同的比特率。

考虑到量化过程本身不可微,以端到端的方式优化图像压缩系统是非常重要的。在[9]中,通过在训练阶段添加均匀噪声来近似量化操作。在[11]中替换训练阶段中量化操作的梯度以进行端到端优化。为了进一步提高压缩效率 Rippel等人[14]使用多尺度图像分解技术来利用不同尺度之间的关系。Agustsson等人[16]提出了一种基于生成对抗网络的图像压缩系统,该系统为极低比特率压缩提供了视觉上令人愉悦的重建图像。此外,李等人[13]研究了潜在表示中的空间关系,并计算了重要性图,以指导基于学习的图像压缩方法。受传统视频编码中帧内预测技术的启发,Baig等人使用修复方法[29]获得重建帧中的预测块,并使用神经网络对相应残差进行编码。尽管目前最先进的基于学习的方法[2]、[18]比传统方法(如BPG[6])实现了更好的性能,但当使用自回归先验[2]、[18]时,计算成本增加了近100倍。因此,为实际应用构建一个更高效的图像压缩框架至关重要。

近年来,基于学习的视频压缩受到了越来越多的关注。吴等人将视频压缩公式化为帧插值,并应用神经网络对残差信息进行编码。Lu等人[1]遵循传统的混合编码架构,采用神经网络实现视频压缩过程,可以以端到端的方式进行优化。Cheng等人[30]在编码过程中使用了插值循环,并在损失函数中设计了基于空间能量压缩的惩罚项,以提高编码效率。在[31]中,提出了一种用于视频压缩的3D自动编码器方案,无需计算运动信息。在[32]中,提出的框架可以将潜在表示解码为运动和混合系数。此外,在潜在空间而不是像素域中压缩残余信息。

3. Proposed Methods

A. Overall Architecture for Image Compression

在本节中,我们介绍了所提出的高效深度图像压缩框架,称为EDIC。提出方案的架构如 图1 所示。受基于学习的图像压缩[9]、[10]最新进展的启发,我们还利用自动编码器式网络进行基于学习的图像压缩。具体来说,该方案有四个模块,即编码器网络、解码器网络、超编码器网络和超解码器网络。编码器网络以原始图像

x

x

x 为输入,使用多个卷积层和非线性函数生成相应的潜在表示

y

y

y 。潜在表示

y

y

y 将量化为

y

^

\hat y

y^ 。在算术编码之后,与算术编码器和算术解码器一样,量化的潜在表示

y

^

\hat y

y^ 被发送到解码器网络以重建最终解码图像

x

^

\hat x

x^ 。我们采用与[2]、[10]相同的量化策略。考虑到图像压缩方法旨在在给定比特率目标下获得高质量的重建图像,并且使用熵模型估计比特率,因此建立准确的熵模型至关重要。在该框架中,我们遵循[2]、[10]中的流程,应用超编码器和超解码器模块来估计熵模型的参数。具体来说,基于潜在表示y,超编码器模块获得超先验信息并将其编码为潜在表示

z

z

z 。类似地,潜在表示

z

z

z 将量化为

z

^

\hat z

z^ 。然后,量化的

z

^

\hat z

z^ 将通过算术编码发送。最后,超解码器将使用量化的超潜在表示

z

^

\hat z

z^ 作为输入来重构超先验信息,并估计熵模型的相应参数

Φ

\Phi

Φ 。超隐表示的熵模型与[9]、[10]相同。我们提出的方法中的网络架构和熵模型将在接下来的三节中讨论。

图1. 提出的 EDIC 框架. 每个卷积层由过滤器的数量、内核大小和步长表示。→表示下行采样,←表示上行采样。N和M为设置某一层通道数的超参数。“GDN”是[23]中提出的生成分离正则化,“IGDN”是逆GDN。“Q”表示量化。“AE”和“AD”分别代表算术编码器和算术解码器。“Φ”为高斯混合模型的估计参数。

通过以下方式考虑率失真权衡,优化了整个基于学习的图像压缩框架:

其中 D D D和 R R R分别表示失真和比特率。 λ \lambda λ是权衡参数。 d ( ⋅ ) d(\cdot) d(⋅)是失真度量(均方误差或 MS-SSIM [27])。 H H H表示编码潜在表示 y ^ \hat y y^和 z ^ \hat z z^的比特率。在该方法中,通过使用相应潜在表示的熵来近似比特率, 即 H ( y ^ ) = E [ − l o g 2 ( p y ^ ∣ z ^ ( y ^ ∣ z ^ ) ) ] H(\hat y)=E[-log_2(p_{\hat y|\hat z}(\hat y|\hat z))] H(y^)=E[−log2(py^∣z^(y^∣z^))] 和 H ( z ^ ) = E [ − l o g 2 ( p z ^ ( z ^ ) ) ] H(\hat z)=E[-log_2(p_{\hat z}(\hat z))] H(z^)=E[−log2(pz^(z^))] 。 p y ^ ∣ z ^ ( y ^ ∣ z ^ ) p_{\hat y|\hat z}(\hat y|\hat z) py^∣z^(y^∣z^) 和 p z ^ ( z ^ ) p_{\hat z}(\hat z) pz^(z^)分别表示 y ^ \hat y y^和 z ^ \hat z z^ 的分布。

B. Channel Attention Scheme

在[2]、[18]中,使用了自回归先验模型来提高压缩性能,该模型捕获了潜在表示中的空间关系。同时,一些工作将非局部块[33]实现的空间注意机制应用于图像压缩[34]、[35],旨在减少空间冗余。基于上述两个动机并受到[36]的启发,我们建议使用轻型通道注意技术来利用潜在表示

y

^

\hat y

y^ 和

z

^

\hat z

z^ 中的通道注意。提出注意模块的架构如 图2 所示。让我们将输入特征映射表示为

X

X

X,

X

∈

R

I

×

J

×

C

X\in R^{I×J×C}

X∈RI×J×C,其中

I

,

J

,

C

I,J,C

I,J,C分别表示特征图的高度、宽度和通道维度。首先,我们应用全局平均池来获得信道统计

t

∈

R

C

t\in R^C

t∈RC,其公式如下:

其中

t

c

t_c

tc表示 t 的第 c 个元素,

x

c

(

i

,

j

)

x_c(i,j)

xc(i,j) 表示输入特征映射

X

X

X的第

c

c

c 个通道特定值。然后,我们应用几个非线性变换来捕捉通道关系。具体而言,非线性变换在以下公式中描述:

图2. 我们通道注意模块的结构。“GAP”代表全局平均池化。“FC”表示全连接层。

其中

s

s

s 指输出通道方向的注意力值,

W

1

∈

R

C

r

×

C

W_1\in R^{\frac{C}{r}×C}

W1∈RrC×C 和

W

2

∈

R

C

×

C

r

W_2\in R^{C×\frac{C}{r}}

W2∈RC×rC 表示完全连接的层,

δ

\delta

δ 是非线性变换的ReLU激活函数[37],

σ

\sigma

σ 表示sigmoid激活。为了降低维数,我们将 r 设置为16。最后,我们用 s 重新缩放输入特征映射

X

X

X。此外,我们在实现中添加了残差运算。

如图1所示,提出的信道注意模块集成到编码器网络和超编码器网络中,并用于利用信道关系进行高质量压缩。我们将重新加权的特征映射应用于以下量化和熵编码模块。

C. Gaussian Mixture Model for Entropy Estimation

在基于学习的图像压缩方法中,准确的比特率估计至关重要。在[2]、[18]中,基于学习的系统采用超先验压缩方案,潜在表示

y

^

\hat y

y^ 建模为高斯分布,如下所示:

式中

p

z

^

(

z

^

)

p_{\hat z}(\hat z)

pz^(z^) 用分解熵模型[9]表示。超编码器和超解码器的目标是估计高斯模型的参数

μ

\mu

μ 和

σ

\sigma

σ 。虽然单高斯熵模型相比之前的工作[9]已经取得了显著的改进,但单高斯模型的表示能力仍然有限,尤其是对于复杂内容。因此,我们利用高斯混合模型来进一步提高图像压缩系统的效率。具体而言,

y

^

\hat y

y^ 的分布公式如下:

其中

w

i

w_i

wi 表示不同高斯模型的权值。F为高斯模型个数。如 图3 所示,我们设计了三个卷积层和两个LeakyReLU层来估计高斯混合模型的参数

Φ

\Phi

Φ。在我们的实现中,F被设为2。因此设置GMM模块的输出通道数K为 5×N,前 4×N个通道分别用于估计两个高斯模型的均值和方差, 以估计各高斯模型的权值。我们在最后N个通道的输出上添加一个sigmoid层。如果一个高斯模型的权值为w,那么另一个高斯模型的权值为 (1−w),具体来说,如果我们设计 F(F≥3) 高斯模型,我们可以将GMM模块的输出通道数改为 3×FxN(K=3×F)。同样,前2个通道 FxN 估计F高斯模型的均值和方差参数。特别的是,我们在最后一个 F×N信道之后加入softmax层来计算每个高斯模型的权值。

图3. GMM模块的结构。N表示用于设置特定层的通道数的超参数,K取决于高斯模型的数量。

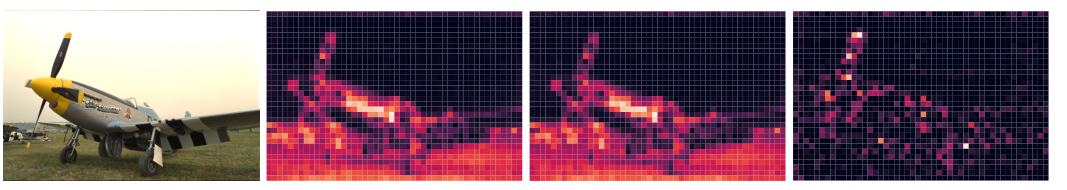

我们提供了GMM模块的进一步分析。如 图4 所示,左边是来自Kodak[20]的原始图像,右边是单个高斯模型和混合高斯模型的潜在表示 y ^ \hat y y^ 的估计位分配映射差。较亮的区域表示高斯混合模型节省的比特数更多。从图4可以看出,高斯混合模型可以节省更多的比特,尤其是在边缘区域。

图4. 潜在表示的位分配映射

y

^

\hat y

y^ 。左栏为柯达[20]的原始图像。左中一列是使用单个高斯模型作为熵模型后

y

^

\hat y

y^ 的位分配图。右中一列是使用高斯混合模型作为熵模型后

y

^

\hat y

y^ 的位分配图。右边一列是它们之间的位分配差。我们使用“kodim20.png”进行可视化。

D. Decoder-side Enhancement

由于提出的压缩方案是一个有损过程,重建图像不可避免地有压缩伪影。为了进一步提高重构质量,我们在图像重构后的解码器端引入了增强模块。在输入重构图像的基础上,采用多个残差块来恢复原始图像。受超分辨率[38]网络设计策略的启发,我们引入残差块来学习图像的高频信息进行图像压缩。如 图5 所示,我们首先添加一个卷积层,将信道维数从3增加到32。然后,我们将三个增强块应用到卷积层的输出。每个增强块有三个残差块。最后,加入卷积层和残差运算得到重建图像。此外,解码器端增强模块可以很容易地集成到整个压缩系统中,并以端到端的方式进行高效优化。如 图6 所示,我们对解码器端增强模块进行了分析。学习到的图像就是经过最后一层卷积后的输出。我们观察到,学习后的残差图像主要包含高频信息,这意味着解码器侧增强模块有助于预测高频成分。

图5,解码器端增强模块的结构。“RB”表示残差块。

图6,左图像是经过解码器侧增强模块后的重建图像,右图像是经过学习后的残差图像。我们选取柯达[20]的“kodim01.png”作为示例。

总体框架如 图7 所示。

{

x

1

,

x

2

,

.

.

.

,

x

t

−

1

,

x

t

}

\{x_1, x_2, ..., x_{t-1}, x_t\}

{x1,x2,...,xt−1,xt}表示当前视频序列。

x

t

x_t

xt 为时间 t 时的帧,

x

^

t

{\hat x}_t

x^t为重建帧。

m

t

m_t

mt和

r

t

r_t

rt 分别为运动信息和残差信息。我们的视频压缩框架的过程如下所示。

图7, 我们的视频压缩方法的框架。残差压缩模块和运动压缩模块的网络结构如图1所示。比特率估计模块是我们用来估计潜在表示的比特率的方法。“Q”表示量化。

- 运动估计与压缩: 我们利用[39]提出的CNN模型来预测光流,光流代表运动信息 v t v_t vt。我们不直接对运动信息 v t v_t vt进行编码,而是将 v t v_t vt发送到运动压缩模块的编码器网络得到 m t m_t mt,然后将 m t m_t mt量化,利用运动压缩模块的解码器网络重构运动信息 v ^ t {\hat v}_t v^t。

- 运动补偿,剩余压缩与帧重建: 运动补偿模块以前一帧重构后的 x ^ t {\hat x}_t x^t和运动信息 v ^ t {\hat v}_t v^t为输入,得到预测帧 x ‾ t \overline x_t xt,并认为这一帧尽可能接近当前帧 x t x_t xt。之后,我们使用原始帧 x t x_t xt和 x ‾ t \overline x_t xt来获取残差信息 r t r_t rt,其中 r t = x t − x ‾ t r_t = x_t - \overline x_t rt=xt−xt。残差信息模块的编码器网络对剩余信息 r t r_t rt进行编码,对 r t r_t rt进行量化,得到潜在表示 y t y_t yt。同样,残差信息模块的解码器网络对残差信息 r ^ t {\hat r}_t r^t进行重构。然后,可以得到最终的重构帧 x ^ t {\hat x}_t x^t,其中 x ^ t = r ^ t + x ‾ t {\hat x}_t = {\hat r}_t + \overline x_t x^t=r^t+xt.

- 框架优化:通过最小化以下Rate-Distortion权衡来优化整体框架:

其中 L t L_t Lt为当前时间 t 时的损耗,d(·,·)为当前帧 x t x_t xt与重构帧 x ^ t {\hat x}_t x^t之间的失真, H ( r ^ t ) H({\hat r}_t) H(r^t)和 H ( m ^ t ) H({\hat m}_t) H(m^t)为残差信息的潜在表示 r ^ t {\hat r}_t r^t和运动信息的潜在表示 m ^ t {\hat m}_t m^t的比特率,由比特率估计模块估计。

DVC采用Ballé[10]方法压缩残差信息,Ballé方法[9]方法压缩运动信息。在我们的工作中,我们建议使用我们提出的EDIC图像压缩框架来压缩残差信息和运动信息。具体而言,在残差压缩模块和运动压缩模块的编码器网络中,我们利用第III-B节中提出的通道注意方案来减少剩余信息和运动信息潜在表示的冗余。在比特率估计模块方面,我们引入了新提出的高斯混合模型作为第三- c节中的熵模型,以更准确地估计潜在表示的比特率,其中超编码器和超解码器网络用于估计高斯混合模型的参数。此外,在残差压缩模块和运动压缩模块的解码器网络中,我们在第III-D节中加入了解码器端增强模块,有效提高残差信息和运动信息的重构质量。

4. Experiments

在本节中,我们进行了大量的实验,以证明我们提出的EDIC框架的有效性,该框架由注意模块、GMM模块和解码器端增强模块组成。在图像压缩方面,我们采用Flick.com上的20745幅高质量图像,随机取 256×256 裁剪好的patch进行训练。为了进行性能评估,我们计算了速率失真(RD)性能,该性能是对柯达图像数据集[20]中的所有图像进行评估。在视频压缩方面,我们使用Vimeo-90k[40]数据集,该数据集有89800个视频片段,分辨率为256 × 256,作为我们的训练数据集,并在HEVC标准测试序列(即B类,C类,D类,E类)[25]上评估我们的模型,该[25]广泛用于评估视频压缩方法。我们的EDIC框架是在PyTorch[41]平台上实现的。所有实验都是在拥有11gb内存的GPU NVIDIA 2080Ti服务器上进行的。

A. Performance and implementation details for Image Compression

图像压缩的质量度量作为MSE损失函数,我们使用不同的λ值 (即256,512,1024,2048,4096,6144 8192) 训练我们的模型。在第一阶段,以λ为8192训练码率失真曲线上的高码率点。模型在1个GPU上训练,batch大小为4。我们使用Adam优化器[42],在前3,000,000次迭代中学习率为1×10−4,在其余500,000次迭代中学习率为1×10−5。对于其他比特率,我们只采用高比特率(λ = 8192)训练的模型作为预训练模型,并对模型进行微调。我们使用Adam优化器,在前50万次迭代中学习率为1×10−4,在其余50万次迭代中学习率为1×10−5。其他训练设置保持不变。当我们的模型用其他质量指标(如MS-SSIM损失函数)进行优化时,我们采用λ为8192的MSE损失函数优化的模型作为我们的预训练模型。然后,我们将MSE损失函数改为MSSSIM损失函数,并用不同的λ值(即16、32、64、128、256、384、512)对预训练模型进行微调。我们以1×10−5的学习率训练模型,迭代50万次。另外,我们设置N为320,M为480。如 图8 所示,我们采用峰值信噪比(peak信噪比,PSNR)作为质量度量。我们将我们的EDIC方法与著名的图像压缩标准, 如bgp [6], JPEG [3], JPEG2000[4],以及最近的神经网络方法,如Ballé的工作[10],Minnen的工作[2]和Lee的工作[18]进行了比较。Lee的工作[18]的结果来自他们发布的源代码2。Ballé的工作[10]和Minnen的工作[10]的结果是基于我们的实现。与传统方法相比,我们的EDIC方法在很大程度上超过了bgp[6]、JPEG[3]、JPEG2000[4]。与现有的基于深度学习的方法相比,我们的EDIC比Ballé的工作[10]取得了显著的改进。据我们所知,Minnen等人提出的方法在图像压缩方面取得了最先进的性能。在低比特率下,我们的方法与Minnen的工作[2]和Lee的方法[18]有可比性,在高比特率下,我们的方法比Minnen的工作[2]和Lee的方法[18]有明显的性能改善。此外,Minnen的工作和Lee的方法非常缓慢,因为他们的推理策略是顺序的。相比之下,我们的方法很容易并行化。因此,我们的方法是非常有效的,这对于实际应用场景是非常重要的。此外,注意模块、GMM模块和解码器端增强模块都是独立的模块,可以很容易地与其他方法合并。如 **图8 ** 所示,当我们将我们的方法纳入Minnen的工作[2]时,我们的带有上下文模型的EDIC方法与我们的EDIC方法相比,也实现了超过0.2 dB的改进。Minnen的工作[2]具有可以估计更准确的熵参数的上下文模型。这再次证明了我们所提出的方案的有效性。如图9所示,我们还采用MSSSIM质量度量进行实验。为了更清楚地描述改进,我们使用分贝(

−

10

l

o

g

10

(

1

−

M

S

S

S

I

M

)

-10log_{10}(1-MSSSIM)

−10log10(1−MSSSIM)) 报告MS-SSIM 值。很明显,我们的EDIC优于bgp的[6]、JPEG的[3]、JPEG2000的[4]和Ballé的[10]。与目前最先进的方法相比,我们的edc在低比特率下可与Minnen的方法[2]相媲美,低于Lee的工作[18]。然而,在高比特率下,我们的EDIC明显优于他们的方法。

图8。我们提出的 EDIC 方法的率失真曲线和竞争方法的图像压缩时使用 PSNR 度量。“上下文模型”来自Minnen的工作[2],它必须在推理阶段按顺序执行。

7052

7052

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?