概述

使用 OpenStack Compute 托管和管理云计算系统。OpenStack 计算是基础设施即服务 (IaaS) 系统的主要部分。主要模块是用 Python 实现的。

OpenStack Compute 与用于身份验证的 OpenStack Identity、用于资源库存跟踪和选择的 OpenStack Placement、用于磁盘和服务器映像的 OpenStack Image 服务以及用于用户和管理界面的 OpenStack Dashboard 交互。

图像访问受项目和用户的限制;每个项目的配额是有限的(例如,实例的数量)。

OpenStack Compute 可以在标准硬件上水平扩展,并下载图像以启动实例。

用途与功能

用途与功能 :

- 实例生命周期管理

- 管理计算资源

- 网络和认证管理

- REST 风格的 API

- 异步的一致性通信

- Hypervisor 透明:支持Xen,XenServer/XCP,KVM, UML, VMware vSphere and Hyper-V

Nova的架构

- Nova架构组件作用介绍

Nova由多个服务器进程组成,每个进程执行不同功能

DB:用于数据存储的sql数据库

API:用户接收http请求,转换命令,通过消息队列或者http与其他组件通信的nova组件

scheduler:用于决定哪台计算节点承载计算实例的nova调度器

network:管理ip转发,网桥或者虚拟局域网的nova计算组件

compute:管理虚拟机管理器与虚拟机之间通信的nova计算组件

conductor:处理需要协调(构建虚拟机或者调整虚拟机大小)的请求,或者处理对象转换

-

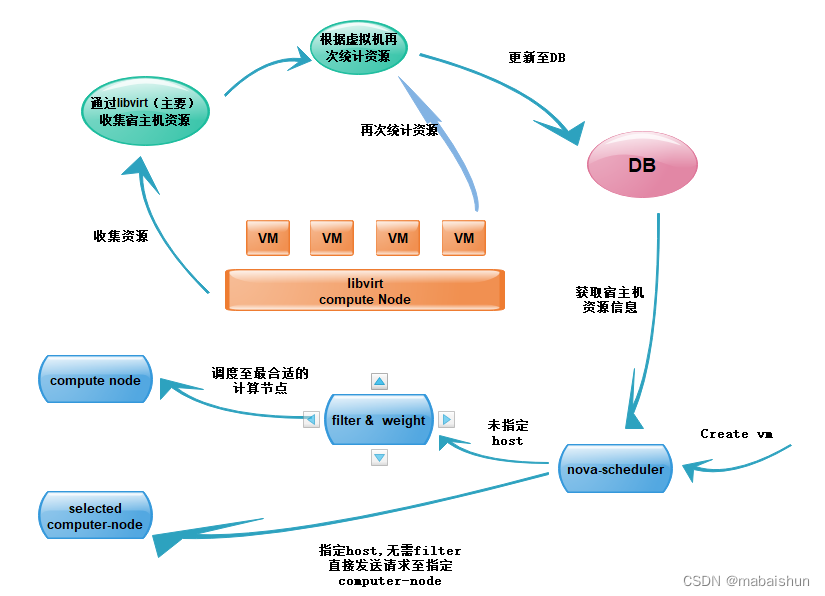

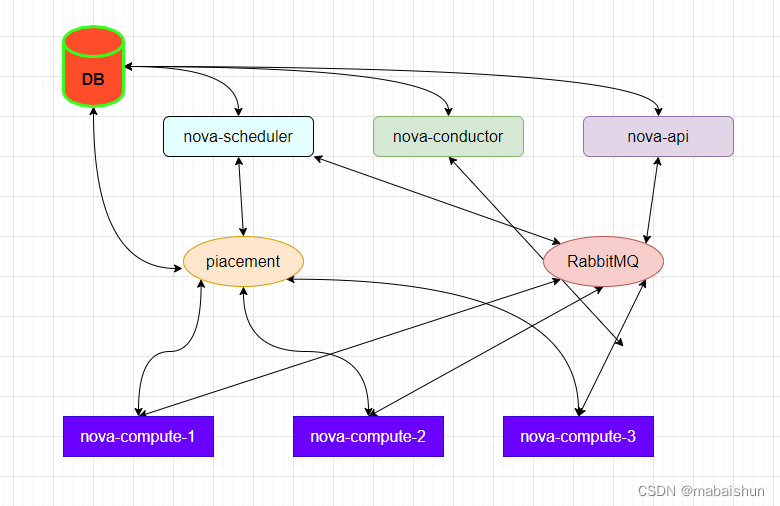

Nova架构基本工作流程图

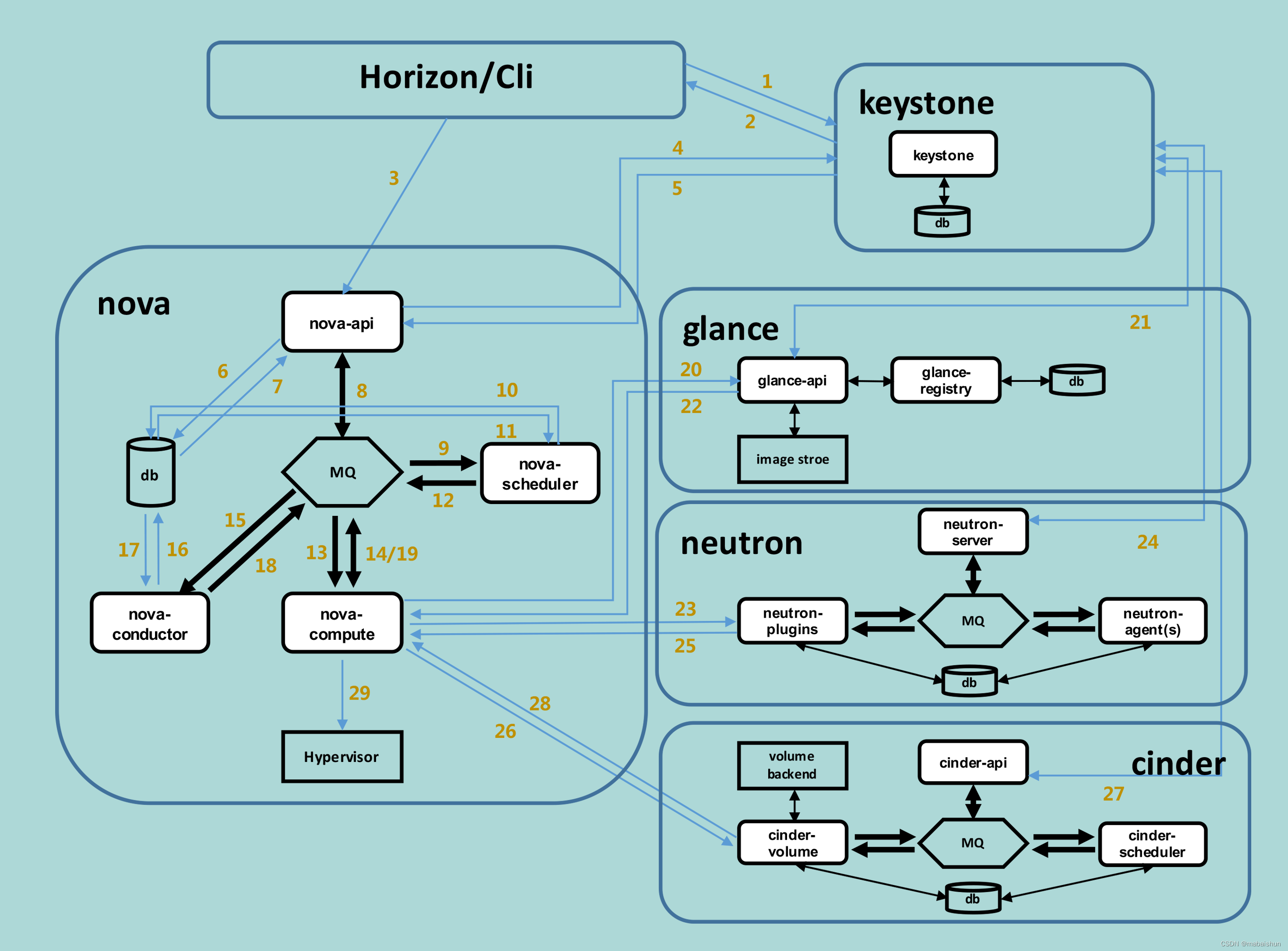

图A nova内部工作机制及流程:

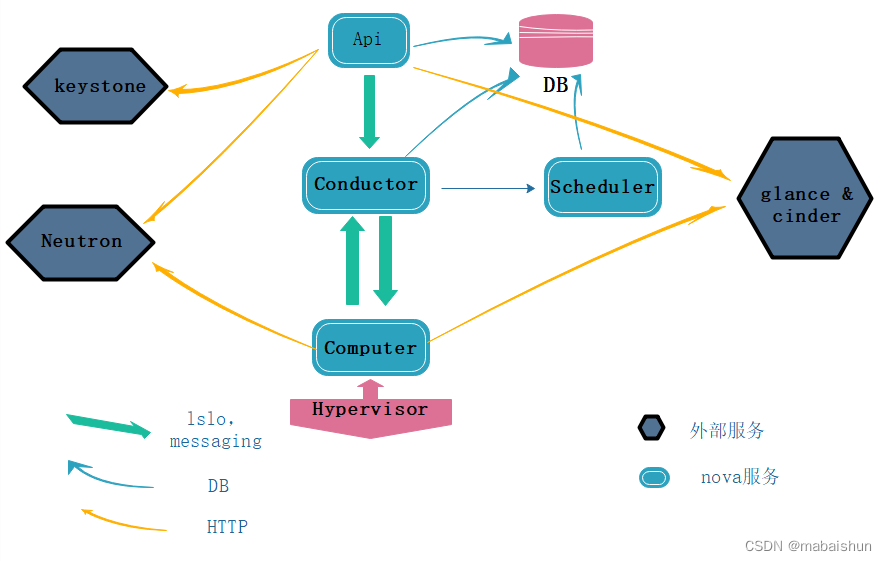

图B Nova服务与外部组件之间的协调工作

流程图解释说明 :当一个实例开始的时候,会先从硬件上通过hypervisor去调用 cpu, 内存,硬盘等一系列资源,到达conductor进行一个预处理,形成一个构建成虚拟机大小的请求,同时也会调用api向存储器发出请求来调用资源,再通过scheduler调度器来决定哪台计算节点承载计算实例(如图A解释,此时有两个方法,一个是直接指定host,无需filter直接发送请求指定computer-node,另外一种就是未指定host,通过一个筛选与权重衡量,调度最合适的计算节点),在这一系列完成之后,会开始进行外部服务,首先会去与keystone进行认证,之后调用网络资源,镜像以及存储资源来完成内部流程(如图B)。

nova架构组件详细介绍

1. Nova组件-Api

是整个 Nova 组件的门户,接收和响应客户的 API 调用。所有对 Nova 的请求都首先由 nova-api 处理。nova-api 向外界暴露若干 HTTP REST API 接口 在 keystone 中我们可以查询 nova-api 的 endponits。

客户端就可以将请求发送到 endponits 指定的地址,向 nova-api 请求操作。 当然,作为最终用户的我们不会直接发送 Rest AP I请求。 OpenStack CLI,Dashboard 和其他需要跟 Nova 交换的组件会使用这些 API。

Nova-api 对接收到的 HTTP API 请求会做如下处理:

- 检查客户端传入的参数是否合法有效

- 调用 Nova 其他子服务的处理客户端 HTTP 请求

- 格式化 Nova 其他子服务返回的结果并返回给客户端

nova-api是外部访问并使用nova提供的各种服务的唯一途径,也是客户端和nova之间的中间层。

Api是客户访问nova的http接口,它由nova-api服务实现,nova-api服务接收和响应来自最终用户的计算api请求,作为openstack对外服务的最主要接口,nova-api提供了一个集中的可以查询所有api的端点。总结为·一点:就是作为组件外部和内部交互的入口(http,rabbitmq)

所有对nova的请求都首先由nova-api处理,api提供rest标准调用服务,便于与第三方系统集成。(云计算产品/平台集成 )

最终用户不会直接改送restrestful api请求,而是通过openstack命令行,dashbord控制面板(web界面)和其他需要跟nova交换的组件来使用这些api.

可以从nova-api查询,定位到其他api位置 ,还可以调用其他核心服务共同完成同一个需求。

2. Nova组件-Scheduler

-

Scheduler可解释为调度器,由nova-scheduler服务实现,主要解决的是如何选择在哪个计算节点上启动实例的问题,它可以应用多种规则,如果考虑内存使用率,cpu负载率,cpu架构(intel/amd)等多种因素,根据一定的算法,确定虚拟机实例能够运行在哪一台计算服务器上,Nova-scheduler服务会从队列中接收一个虚拟机实例的请求,通过读取数据库的内容,从可用资源池中选择最合适的计算节点来创建新的虚拟机实例

-

创建虚拟机实例时,用户会提出资源要求,如cpu,内存,磁盘各需要多少,openstack将这些需求定义在实例类型中,用户只需要指定需要使用哪个实例类型就可以了。

nova调度器的类型:

- 随机调度器(chance scheduler):从所有正常运行nova-compute服务节点中随机选择

- 过滤器调度器(filter scheduler):根据指定的过滤条件以及权重来选择最佳的计算节点,filter又称为筛选器。

- 缓存调度器(caching scheduler):可看作随机调度器的一种特殊类型,在随机调度的基础上将主机资源信息缓存在本地内存中,然后通过后台的定时任务定时从数据库中获取最新的主机资源信息。

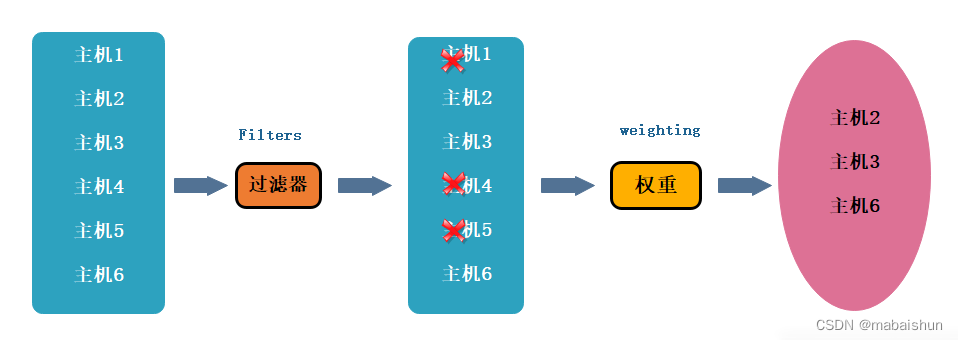

过滤调度器调度过程:

主要分为二个阶段

- 通过指定的过滤器选择满足条件的计算节点,比如内存使用率小50%,可以使用多个过滤器依次进行过滤。

- 对过滤后的主机列表进行权重计算并排序,选择最优的计算节点来创建虚拟机实例。

过滤器

-

当过滤调度器需要执行调度操作时,会让过滤器对计算节点进行判断,返回true或false

配置文件:/etc/nova/nova.conf -

scheduler_available_filters选项用于配置可用过滤器,默认是所有Nova自带的或氯气都可以用于过滤作用

Scheduler_available_filters = nova.scheduler.filters.all_filters

-

另外还有一个选项scheduler_default_filters用于指定nova-scheduler服务真正使用的过滤器,默认值如下

scheduler_default_filters = retryfilters.availabilityzoneFilter,RamFilter,

ComputeFilter,CompputerCapabilitiesFilter,ImagePropertiesFilter,

ServerGroupAntiAffinityFilter,ServerGroupAffinityFilter

过滤类型

过滤顺序:过滤调度器将按照列表中的顺序依次过滤

-

retryfilter(再审过滤器)

主要作用是过滤掉之前已经调度过的节点,如A,B,C都通过了了过滤,A权重最大被选中执行操作,由于某种原因,操作在A上失败了,Nova-filter将重新执行过滤操作,那么此时A就会retryfilter直接排除,以免再次失败 -

AvailabilityZoneFilter (可用区域过滤器)

为提高容灾性并提供隔离服务,可以将计算节点划分到不同的可用区域中,openstack默认有一个命令为nova的可用区域,所有的计算节点初始是放在nove区域的。用户可以根据需要创建自己的一个可用区域,创建实例时,需要指定将实例部署在哪个可用区域中,nova-scheduler执行过滤操作时,会使用availabilityZoneFilter不属于指定可用区域计算节点过滤掉。 -

RamFilter(内存过滤器)

根据可用内存来调度虚拟机创建,将不能满足实例类型内存需求的计算节点过滤掉,但为了提高系统资源利用率,Openstack在计算节点的可用内存时允许超过实际内存大小。超过的程度是通过nova.conf配置文件中

ram_allocation_ratio参数来控制的,默认值是1.5。

viletc/nova/nova.conf

Ram_allocation_ratio=1.5 -

DiskFilter(硬盘调度器)

根据磁盘空间来调度虚拟机创建,将不能满足类型磁盘需求的计算节点过滤掉。磁盘同样允许超量,超量值可修改nova.conf中disk_allocation_ratio中的参数控制,默认值是1.0

vi etc/nova/nova.conf

disk_allocation_ratio=1.0 -

CoreFilter(核心过滤器)

根据可用CP核心来调度虚拟机创建,将不能满足实例类型vCPU需求的计算节点过滤掉。vCPU也允许超量,超量值是通过修改nova.conf中

cpu_allocation_ratio参数控制,默认值是16。

Viletc/nova/nova.conf cpu_allocation_ratio=16.0 -

ComputeFilter(计算过滤器)

保证只有nova-compute服务正常工作的计算节点才能被nova-scheduler调度,它是必选的过滤器。 -

ComputeCapablilitiesFilter (计算能力过滤器)

根据计算节点的特性来过滤,如x86_64和ARM架构的不同节点,要将实例 -

lmagePropertiesFilter(镜像属性过滤器)

根据所选镜像的属性来筛选匹配的计算节点。通过元数据来指定其属性。如希望镜像只运行在KVM的Hypervisor上,可以通过Hypervisor Type属性来指定。

权重

- nova-scheduler服务可以使用多个过滤器依次进行过滤,过滤之后的节点再通过计算权重选出能够部署实例的节点。

🔺 注意

所有权重位于nova/scheduler/weights目录下,目前默认实现是> RAMweighter,根据计算节点空闲的内存量计算权重值,空闲越多,权重越大,实例将会被部署到当前空闲内存最多的计算节点上。

它的权重源码位于下面路径

/usr/lib/python2.7/site-packages/nova/scheduler/weights

openstack源码位置位于下面路径

/usr/lib/python2.7/site-packages

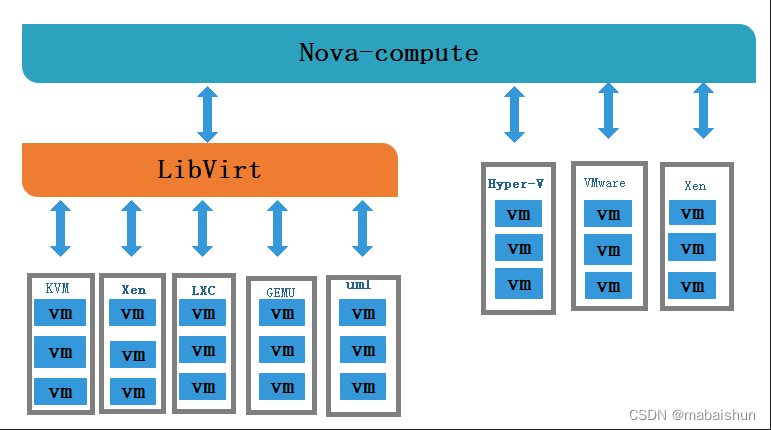

3. Compute组件

-

Nova-compute在计算节点上运行]负责管理节点上的实例。通常一个主机运行一个Nova-compute服务,一个实例部署在哪个可用的主机上取决于调度算法。OpenStack对实例的操作,最后都是提交给Nova-compute来完成。

-

Nova-compute可分为两类,一类是定向openstack报告计算节点的状态,另一类是实现实例生命周期的管理。

-

通过Driver(驱动)架构支持多种Hypervisor虚拟机管理器

- 面对多种Hypervisor,nova-compute为这些Hypervisor定义统一的接口.

- Hypervisor只需要实现这些接口,就可以Driver的形式即插即用到OpenStack系统中

-

定期向OpenStack报告计算节点的状态

- 每隔一段时间,nova-compute就会报告当前计算节点的资源使用情况和nova-compute服务状态。

- nova-compute是通过Hypervisor的驱动获取这些信息的。

-

实现虚拟机实例生命周期的管理

- OpenStack对虚拟机实例最主要的操作都是通过nova-compute实现的。创建、关闭、重启、挂起、恢复、中止、调整大小、迁移、快照

- 以实例创建为例来说明nova-compute的实现过程如下步骤:

- 为实例准备资源。

- 创建实例的镜像文件

- 创建实例的XML定义文件

- 创建虚拟网络并启动虚拟机

4. 三个组件总结概述

1. 三个组件功能总结

- nova可以控制实例生命周期

- nova-Scheduler 可以决定实例具体创建在哪个计算节点

- nova-compute:工作在计算节点,负责实例具体的创建过程

2. 调度器调度流程以及子功能

-

主要功能:决定实例具体创建在哪个计算节点

-

调度流程: 是由多个调度器/过滤器共同合作,依次过滤/筛选,最后以评分/权重的方式决定实例的功能

-

调度器子功能:

- 调度器通过不同的规则,对计算节点进行筛选

- 多个过滤器(只负责对应的过滤规则)

- 粗过滤(基础资源),例如CPU、内存、磁盘等

- 精细化的过滤 : 镜像属性、服务性能/契合度等亲和性/反

- 亲和性过滤(高级过滤)

通过这些精细化的过滤,最后为了可以筛选出从理论上,最为合适的计算节点来创建实例,在以上的过滤规则过滤之后,可以进行随机调度(内存调度器),会进行再筛选过滤,再筛选过滤:"污点"机制,会对过滤后,剩下的计算节点集群中,再进行过滤,排除之前有过故障的节点

5. nova-conductor组件

-

由nova-conductor模块实现,旨在为数据库的访问提供一层安全保障。Nova-conductor作为nova-compute服务与数据库之间交互的中介,避免了直接访问由nova-compute服务创建对接数据库。

-

Nova-compute访问数据库的全部操作都改到nova-conductor中, nova-conductor作为对数据库操作的一个代理,而且nova-conductor是部署在控制节点上的。

-

Nova-conductor有助于提高数据库的访问性能,nova-compute可以创建多个线程使用远程过程调用(RPC)访问nova-conductor。

-

在一个大规模的openstack部署环境里,管理员可以通过增加nova-conductor的数量来应付曰益增长的计算。

-

nova-compute 经常需要更新数据库,比如更新和获取虚机的状态。 出于安全性和伸缩性的考虑,nova-compute 并不会直接访问数据库,而是将这个任务委托给 nova-conductor。

这样做有两个显著好处:

- 更高的系统安全性

- 更好的系统伸缩性

6. PlacementAPI组件

- 对资源的管理全部由计算节点承担,在统计资源使用情况时,只是简单的将所有计算节点的资源情况累加起来,但是系统中还存在外部资源,这些资源由外部系统提供。如ceph、nfs等提供的存储资源等。面对多种多样的资源提供者,管理员需要统一的、简单的管理接口来统计系统中资源使用情况,这个接口就是PlacementAPl。

- acementAPI由nova-placement-api服务来实现,旨在追踪记录资源提供者的目录和资源使用情况。

- 费的资源类型是按类进行跟踪的。如计算节点类、共享存储池类、IP地址类等。

7. 虚拟机实例化流程

用户可以通过多种方式访问虚拟机的控制台

- Nova-novncoroxy守护进程:通过vnc连接访问正在运行的实例提供一个代理,支持浏览器novnc客户端。

-Nova-spicehtml5proxy守护进程:通过spice连接访问正在运行的实例提供一个代理,支持基于html5浏览器客户端。 - Nova-xvpvncproxy守护进程:通过vnc连结访问正在运行的实例提供一个代理,支持openstack专用的java客户端。

- Nova-consoleauth守护进程:负责对访问虚拟机控制台提供用户令牌认证。这个服务器必须与控制台代理程序共同使用。

总结下来就是:比如说是novnc客户端是需要通过vnc连接访问正在运行的实例提供一个代理,而访问过程就是由novncoroxy来守护进程,html5是apice提供的代理,由nova-spicehtml5proxy来进行进程守护,而java客户端则是由vnc提供代理,Nova-xvpvncproxy来守护进程。

8. 控制台接口介绍(nova_console)

- 用户(可以是OpenStack最终用户,也可以是其他程序)执行Nova Client提供的用于创建虚拟机的命令。

- nova-api服务监听到来自于Nova Client的HTTP请求,并将这些请求转换为AMQP消息之后加入消息队列。

- 通过消息队列调用nova-conductor服务。

- nova-conductor服务从消息队列中接收到虚拟机实例化请求消息后,进行一些准备工作。

- nova-conductor服务通过消息队列告诉nova-scheduler服务去选择一个合适的计算节点来创建虚拟机,此时nova-scheduler会读取数据库的内容。

nova-conductor服务从nova-scheduler服务得到了合适的将计算节点的信息后,在通过消息队列来通知nova-compute服务实现虚拟机的创建。

9. nova部署的几种模式

-

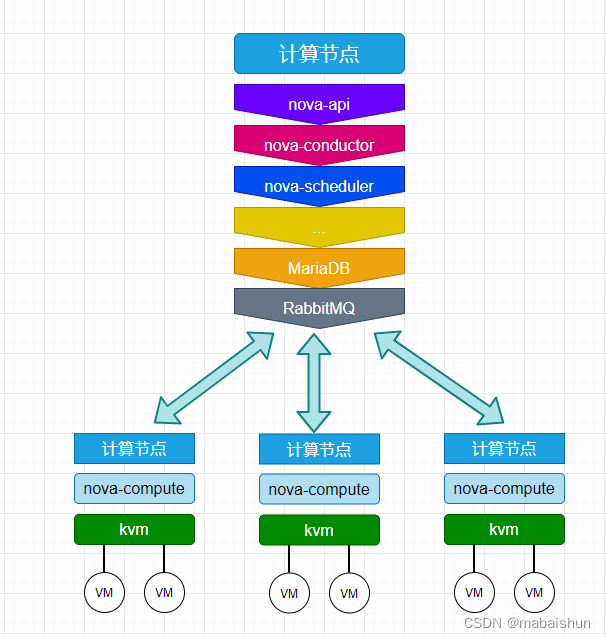

经典部署模式

-

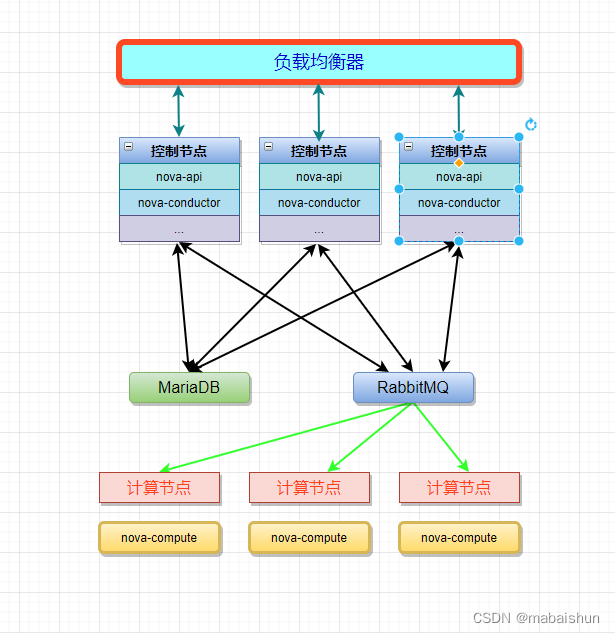

负载均衡部署模式

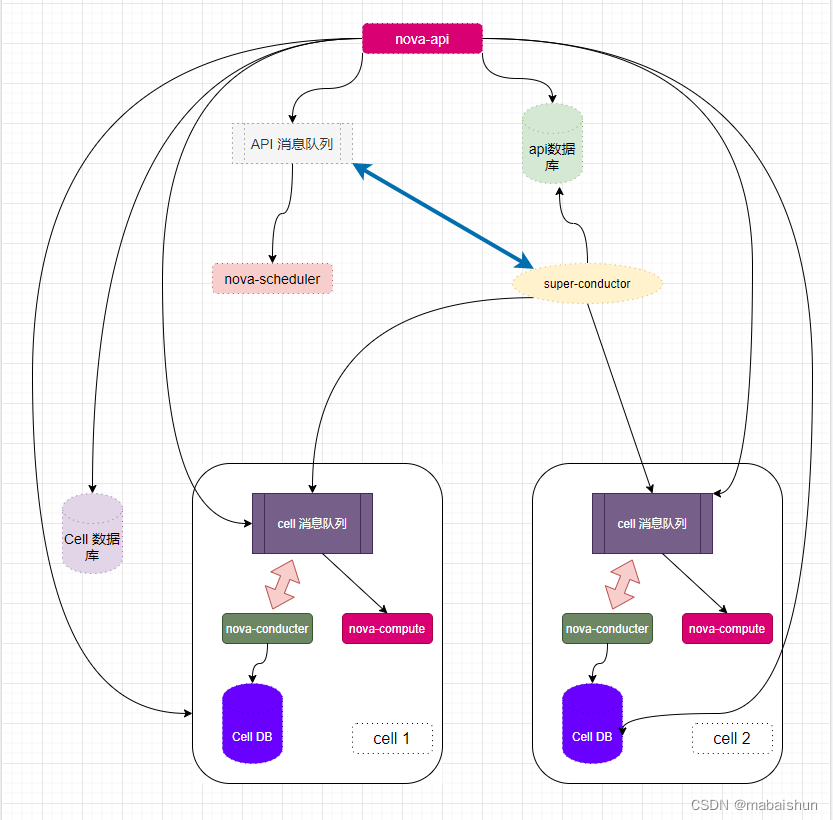

Nova的Cell架构模式介绍

什么是cell ?为什么有cell ?

当openstack nova 集群的规模变大时,所有的 Nova Compute节点全部连接到同一个 MQ,在有大量定时任务通过 MQ 上报给Nova-Conductor服务的情况下,数据库和消息队列服务就会出现瓶颈,而此时nova为提高水平扩展及分布式,大规模的部署能力,同时又不增加数据库和消息中间件的复杂度,引入了Cell概念。

如下图大量数据上报给DB数据库:

-

如何理解cell? cell可以看做是一个单元,为支持更大规模的部署,openstack将大的nova集群分成小的单元,每个单元都有自己的消息队列和数据库,可以解决规模曾大时候引起的瓶颈问题,在cell中,keystone, neutron,cinder,glance等资源是共享的。

还有一个就是API节点上的数据库

nova-api数据库中存放全局信息,这些全局数据表是从nova库迁移过来的,如flavor(实例模型) ,instance groups (实例组), quota(配额)

nova-cell0数据库的模式与nova一样,主要的作用就是当实例调度失败时,实例的信息将不属于任何一个cell ,因而存放到nova_cell0中,所以说cell0是存放数据调度失败的数据用来集中管理。

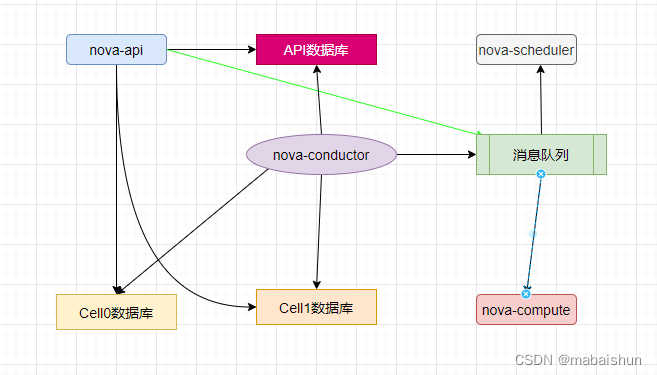

cell的两种架构模式及工作原理

单cell部署 架构模式:

多cell部署 架构模式:

下图整个有三部分组成,cell0、cell1,、cell2。 位于最上层的cell0,也就是api-cell, 而下层的cell1与cell2则是平行对等的关系,他们之间无交互,相互独立,还可以继续增加cell3,cell4 。 而上层的api cell主要包括了

Nova API, Nova Scheduler, Nova Conductor 这3个 Nova 服务 ,同时在 API Cell 中还需要 MQ 提供组件内的通信服务。API Cell 中的 DB 包含两个数据库,分别是 api数据库 和 cell数据库,api 数据库保存了全局数据,比如 flavor 信息。此外 api 数据库中还有一部分表是用于 placement 服务的;而 cell数据库则是用于保存创建失败且还没有确定位于哪个 cell 的虚机数据,比如当虚拟机调度失败时,该虚拟机数据就会被保存到cell数据库中。也就是cell0数据库中。

在每个 Cell 中,都有自己独立使用的数据库、消息队列和 Nova Conductor 服务,当前 Cell 中的所有计算节点,全部将数据发送到当前 Cell 中的消息队列,由 Nova Conductor 服务获取后,保存至当前 Cell 的 Nova 数据库中。整个过程都不会涉及到 API Cell 中的消息队列。因此通过对计算节点进行 Cell 划分,可以有效降低 API Cell 中消息队列和数据库的压力。假如一个 MQ 能支持200个计算节点,则在划分 Cell 以后,每个 Cell 都可以支持200个计算节点,有 N 个 Cell 就可以支持 N X 200 个计算节点,因此可以极大提升单个 OpenStack 的集群管理规模。

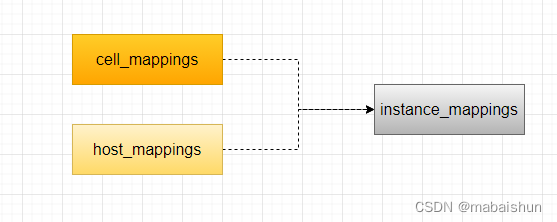

Cell v2实现的原理

在大致了解了 Cell V2 架构的基本组成后,接下来介绍一下在 Nova 组件中,究竟是如何实现 Cell 划分的。多 Cell 的实现涉及 nova_api 数据库中的3个表,分别是 cell_mappings, host_mappings, instance_mappings 表。这3个表之间的关系如下图所示:

cell_mappings 表记录了每个 Cell 的名字和其消息队列连接地址与数据库连接地址,通过该表中记录的信息,API Cell 中的 Nova API 服务和 Nova Conductor 服务就知道该如何连接到 Cell 中的消息队列和数据库了,并进一步将消息发送到 Cell 中的消息队列,或者直接访问 Cell 中的 Nova 数据库。

在 host_mappings 表记录了计算节点和 Cell 之间的对应关系,而instance_mappings 表则记录了 instance 和 Cell 之间的对应关系。通过这两个表的映射关系,API Cell 中的服务就可以轻易知道计算节点或者虚拟机所处的 Cell,并通过 cell_mappings 数据表中提供的链接对其进行操作。

Nova 创建虚拟机详细过程

1、界面或命令行通过RESTful API向keystone获取认证信息。

2、keystone通过用户请求认证信息,并生成auth-token返回给对应的认证请求。

3、界面或命令行通过RESTful API向nova-api发送一个boot instance的请求(携带auth-token)。

4、nova-api接受请求后向keystone发送认证请求,查看token是否为有效用户和token。

5、keystone验证token是否有效,如有效则返回有效的认证和对应的角色(注:有些操作需要有角色权限才能操作)。

6、通过认证后nova-api和数据库通讯。

7、初始化新建虚拟机的数据库记录。

8、nova-api通过rpc.call向nova-scheduler请求是否有创建虚拟机的资源(Host ID)。

9、nova-scheduler进程侦听消息队列,获取nova-api的请求。

10、nova-scheduler通过查询nova数据库中计算资源的情况,并通过调度算法计算符合虚拟机创建需要的主机。

11、对于有符合虚拟机创建的主机,nova-scheduler更新数据库中虚拟机对应的物理主机信息。

12、nova-scheduler通过rpc.cast向nova-compute发送对应的创建虚拟机请求的消息。

13、nova-compute会从对应的消息队列中获取创建虚拟机请求的消息。

14、nova-compute通过rpc.call向nova-conductor请求获取虚拟机消息。(Flavor)

15、nova-conductor从消息队队列中拿到nova-compute请求消息。

16、nova-conductor根据消息查询虚拟机对应的信息。

17、nova-conductor从数据库中获得虚拟机对应信息。

18、nova-conductor把虚拟机信息通过消息的方式发送到消息队列中。

19、nova-compute从对应的消息队列中获取虚拟机信息消息。

20、nova-compute通过keystone的RESTfull API拿到认证的token,并通过HTTP请求glance-api获取创建虚拟机所需要镜像。

21、glance-api向keystone认证token是否有效,并返回验证结果。

22、token验证通过,nova-compute获得虚拟机镜像信息(URL)。

23、nova-compute通过keystone的RESTfull API拿到认证k的token,并通过HTTP请求neutron-server获取创建虚拟机所需要的网络信息。

24、neutron-server向keystone认证token是否有效,并返回验证结果。

25、token验证通过,nova-compute获得虚拟机网络信息。

26、nova-compute通过keystone的RESTfull API拿到认证的token,并通过HTTP请求cinder-api获取创建虚拟机所需要的持久化存储信息。

27、cinder-api向keystone认证token是否有效,并返回验证结果。

28、token验证通过,nova-compute获得虚拟机持久化存储信息。

29、nova-compute根据instance的信息调用配置的虚拟化驱动来创建虚拟机。

安装和配置控制节点

在安装和配置计算服务之前,您必须创建数据库、服务凭证和 API 端点。

创建数据库、服务凭证和 API 端点

创建数据库

- 使用数据库访问客户端以root用户身份连接数据库服务器:

mysql -u root -p - 创建nova_api、nova和nova_cell0数据库:

MariaDB [(none)]> CREATE DATABASE nova_api; MariaDB [(none)]> CREATE DATABASE nova; MariaDB [(none)]> CREATE DATABASE nova_cell0; - 授予对数据库的适当访问权限:

替换NOVA_DBPASS为合适的密码。MariaDB [(none)]> GRANT ALL PRIVILEGES ON nova_api.* TO 'nova'@'localhost' \ IDENTIFIED BY 'NOVA_DBPASS'; MariaDB [(none)]> GRANT ALL PRIVILEGES ON nova_api.* TO 'nova'@'%' \ IDENTIFIED BY 'NOVA_DBPASS'; MariaDB [(none)]> GRANT ALL PRIVILEGES ON nova.* TO 'nova'@'localhost' \ IDENTIFIED BY 'NOVA_DBPASS'; MariaDB [(none)]> GRANT ALL PRIVILEGES ON nova.* TO 'nova'@'%' \ IDENTIFIED BY 'NOVA_DBPASS'; MariaDB [(none)]> GRANT ALL PRIVILEGES ON nova_cell0.* TO 'nova'@'localhost' \ IDENTIFIED BY 'NOVA_DBPASS'; MariaDB [(none)]> GRANT ALL PRIVILEGES ON nova_cell0.* TO 'nova'@'%' \ IDENTIFIED BY 'NOVA_DBPASS'; - 退出数据库访问客户端。

获取权限

source ./admin_openrc

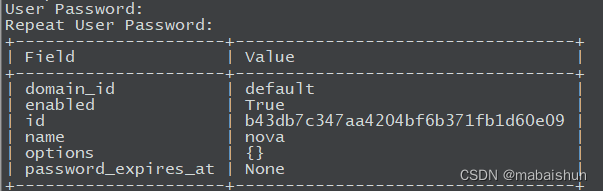

创建凭证

-

创建nova用户:

openstack user create --domain default --password-prompt nova

-

将admin角色添加到nova用户:

openstack role add --project service --user nova admin -

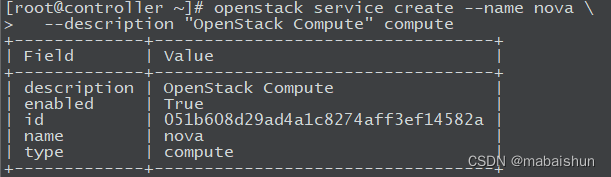

创建nova服务实体:

openstack service create --name nova \ --description "OpenStack Compute" compute

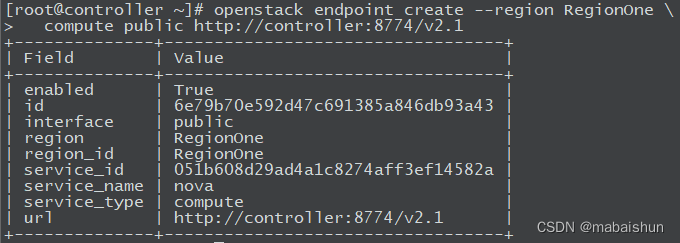

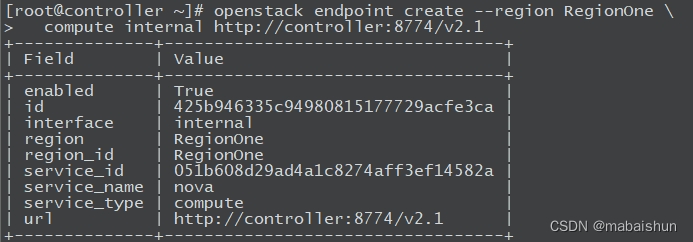

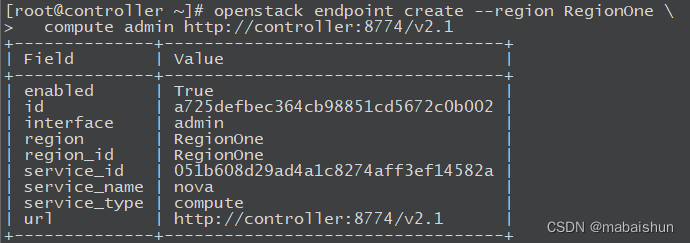

创建服务端点

openstack endpoint create --region RegionOne \

compute public http://controller:8774/v2.1

openstack endpoint create --region RegionOne \

compute internal http://controller:8774/v2.1

openstack endpoint create --region RegionOne \

compute admin http://controller:8774/v2.1

安装和配置组件

✔ 笔记

默认配置文件因发行版而异。您可能需要添加这些部分和选项,而不是修改现有的部分和选项。此外,配置片段中的省略号 ( …) 表示您应该保留的潜在默认配置选项。

1. 安装软件包

yum install -y openstack-nova-api openstack-nova-conductor \

openstack-nova-novncproxy openstack-nova-scheduler

2. 配置

编辑 /etc/nova/nova.conf 文件并完成以下操作:

-

在该[DEFAULT]部分中,仅启用计算和元数据 API:

[DEFAULT] # ... enabled_apis = osapi_compute,metadata -

在[api_database]和[database]部分中,配置数据库访问:

[api_database] # ... connection = mysql+pymysql://nova:NOVA_DBPASS@controller/nova_api [database] # ... connection = mysql+pymysql://nova:NOVA_DBPASS@controller/nova替换NOVA_DBPASS为您为计算数据库选择的密码。

-

在该[DEFAULT]部分中,配置RabbitMQ消息队列访问:

[DEFAULT] # ... transport_url = rabbit://openstack:RABBIT_PASS@controller:5672/替换为您在 中为 帐户RABBIT_PASS选择的密码。openstackRabbitMQ

-

在[api]和[keystone_authtoken]部分中,配置身份服务访问:

[api] # ... auth_strategy = keystone [keystone_authtoken] # ... www_authenticate_uri = http://controller:5000/ auth_url = http://controller:5000/ memcached_servers = controller:11211 auth_type = password project_domain_name = Default user_domain_name = Default project_name = service username = nova password = NOVA_PASS替换为您在身份服务中NOVA_PASS为用户nova选择的密码。

✔ 笔记

注释掉或删除该[keystone_authtoken] 部分中的任何其他选项。 -

在该[DEFAULT]部分中,配置my_ip选项以使用控制器节点的管理接口 IP 地址:

[DEFAULT] # ... my_ip = 10.0.0.10 -

在该[vnc]部分中,将 VNC 代理配置为使用控制器节点的管理接口 IP 地址:

[vnc] enabled = true # ... server_listen = $my_ip server_proxyclient_address = $my_ip -

在该[glance]部分中,配置图像服务 API 的位置:

[glance] # ... api_servers = http://controller:9292 -

在该[oslo_concurrency]部分中,配置锁定路径:

[oslo_concurrency] # ... lock_path = /var/lib/nova/tmp -

在该[placement]部分中,配置对 Placement 服务的访问:

[placement] # ... region_name = RegionOne project_domain_name = Default project_name = service auth_type = password user_domain_name = Default auth_url = http://controller:5000/v3 username = placement password = PLACEMENT_PASS替换为您为安装

Placement时创建的服务用户选择的密码 PLACEMENT_PASS。注释掉或删除该部分中的任何其他选项。

3. 填充nova-api数据库

su -s /bin/sh -c "nova-manage api_db sync" nova

✔ 笔记

忽略此输出中的任何弃用消息。

4. 注册cell0数据库

su -s /bin/sh -c "nova-manage cell_v2 map_cell0" nova

5. 创建cell1单元格

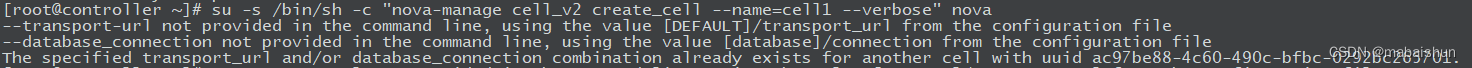

su -s /bin/sh -c "nova-manage cell_v2 create_cell --name=cell1 --verbose" nova

此处的警告可以忽略

6. 填充nova数据库

su -s /bin/sh -c "nova-manage db sync" nova

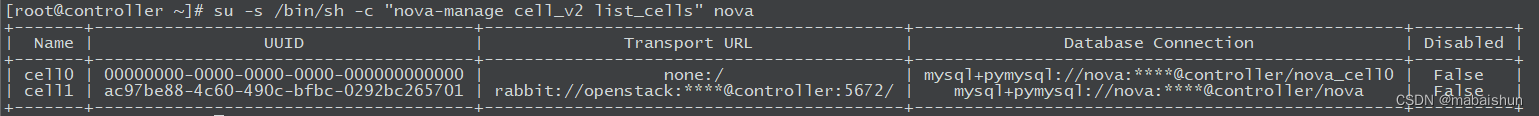

7. 验证 nova cell0 和 cell1 是否正确注册

su -s /bin/sh -c "nova-manage cell_v2 list_cells" nova

完成安装

启动计算服务并将它们配置为在系统启动时启动:

systemctl enable \

openstack-nova-api.service \

openstack-nova-scheduler.service \

openstack-nova-conductor.service \

openstack-nova-novncproxy.service

systemctl start \

openstack-nova-api.service \

openstack-nova-scheduler.service \

openstack-nova-conductor.service \

openstack-nova-novncproxy.service

安装和配置计算节点

本节介绍如何在计算节点上安装和配置计算服务。该服务支持多个管理程序来部署实例或虚拟机 (VM)。为简单起见,此配置在支持虚拟机硬件加速的计算节点上使用 Quick EMUlator (QEMU) 管理程序和基于内核的 VM (KVM) 扩展。在旧硬件上,此配置使用通用 QEMU 管理程序。您可以按照这些说明稍作修改,以使用额外的计算节点水平扩展您的环境。

✔ 笔记

本部分假设您按照本指南中的说明逐步配置第一个计算节点。如果要配置其他计算节点,请以与示例架构部分中的第一个计算节点类似的方式准备它们。每个额外的计算节点都需要一个唯一的 IP 地址。

安装和配置组件

✔ 笔记

默认配置文件因发行版而异。您可能需要添加这些部分和选项,而不是修改现有的部分和选项。此外,配置片段中的省略号 ( …) 表示您应该保留的潜在默认配置选项。

1. 安装

yum install -y openstack-nova-compute

2. 配置

编辑 /etc/nova/nova.conf 文件并完成以下操作:

-

在该[DEFAULT]部分中,仅启用计算和元数据 API:

[DEFAULT] # ... enabled_apis = osapi_compute,metadata -

在该[DEFAULT]部分中,配置RabbitMQ消息队列访问:

[DEFAULT] # ... transport_url = rabbit://openstack:RABBIT_PASS@controller替换为您在

openstack中为RabbitMQ帐户 RABBIT_PASS 选择的密码。 -

在[api]和[keystone_authtoken]部分中,配置身份服务访问:

[api] # ... auth_strategy = keystone [keystone_authtoken] # ... www_authenticate_uri = http://controller:5000/ auth_url = http://controller:5000/ memcached_servers = controller:11211 auth_type = password project_domain_name = Default user_domain_name = Default project_name = service username = nova password = NOVA_PASS替换为您在keystone服务中NOVA_PASS为用户nova选择的密码。

✔ 笔记

注释掉或删除该[keystone_authtoken] 部分中的任何其他选项。 -

在该[DEFAULT]部分中,配置my_ip选项:

[DEFAULT] # ... my_ip = MANAGEMENT_INTERFACE_IP_ADDRESS替换为计算节点上管理网络接口的 IP 地址。

-

配置/etc/nova/nova.conf[neutron]的部分。

-

在该[vnc]部分中,启用和配置远程控制台访问:

[vnc] # ... enabled = true server_listen = 0.0.0.0 server_proxyclient_address = $my_ip novncproxy_base_url = http://controller:6080/vnc_auto.html服务器组件侦听所有 IP 地址,代理组件仅侦听计算节点的管理接口 IP 地址。基本 URL 指示您可以使用 Web 浏览器访问此计算节点上实例的远程控制台的位置。

✔ 笔记

如果访问远程控制台的 Web 浏览器位于无法解析主机名的controller主机上,则必须替换 controller为控制器节点的管理接口 IP 地址。 -

在该[glance]部分中,配置图像服务 API 的位置:

[glance] # ... api_servers = http://controller:9292 -

在该[oslo_concurrency]部分中,配置锁定路径:

[oslo_concurrency] # ... lock_path = /var/lib/nova/tmp -

在该[placement]部分中,配置 Placement API:

[placement] # ... region_name = RegionOne project_domain_name = Default project_name = service auth_type = password user_domain_name = Default auth_url = http://controller:5000/v3 username = placement password = PLACEMENT_PASS替换为您在keystone服务中PLACEMENT_PASS为用户placement选择的密码 。注释掉该[placement]部分中的任何其他选项。

完成安装

-

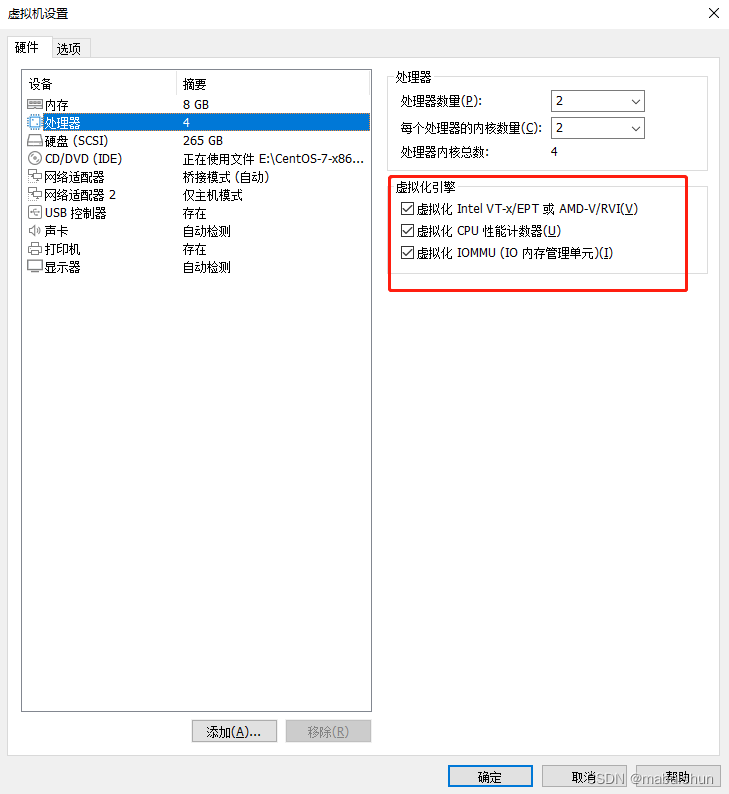

确定您的计算节点是否支持虚拟机的硬件加速:

egrep -c '(vmx|svm)' /proc/cpuinfo如果此命令返回值,则您的计算节点支持硬件加速,通常不需要额外配置。

如果此命令返回值zero,则您的计算节点不支持硬件加速,您必须配置libvirt为使用 QEMU 而不是 KVM。

如果是虚拟机,关机,编辑虚拟机,处理器选项,选中右边的虚拟化

如果是实体机,请设置BIOS选项。编辑文件中的[libvirt]部分,/etc/nova/nova.conf如下所示:

[libvirt] # ... virt_type = qemu -

启动 Compute 服务及其依赖项,并将它们配置为在系统启动时自动启动:

systemctl enable libvirtd.service openstack-nova-compute.service systemctl start libvirtd.service openstack-nova-compute.service✔ 笔记

如果nova-compute服务无法启动,请检查/var/log/nova/nova-compute.log. 该错误消息可能表明控制器节点上的防火墙正在阻止访问端口 5672。将防火墙配置为打开控制器节点上的端口 5672 并重新启动 计算节点上的服务。

错误: AMQP server on controller:5672 is unreachablenova-compute

将计算节点添加到单元数据库

此处命令在控制节点上运行

-

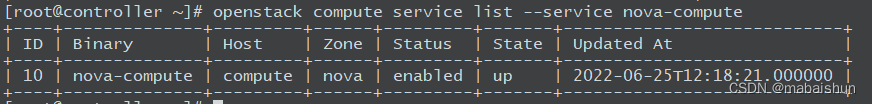

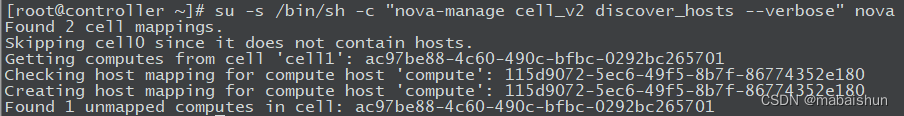

获取管理员凭据以启用仅限管理员的 CLI 命令,然后确认数据库中有计算主机:

source ./admin_openrc openstack compute service list --service nova-compute

-

发现计算主机:

su -s /bin/sh -c "nova-manage cell_v2 discover_hosts --verbose" nova

✔ 笔记

添加新计算节点时,必须在控制器节点上运行nova-manage cell_v2 discover_hosts以注册这些新计算节点。或者,您可以在/etc/nova/nova.conf中设置适当的间隔:[scheduler] discover_hosts_in_cells_interval = 300

验证操作

验证计算服务的操作。

✔ 笔记

在控制器节点上执行这些命令。

-

获取admin凭据以访问仅限管理员的 CLI 命令:

source ./admin_openrc -

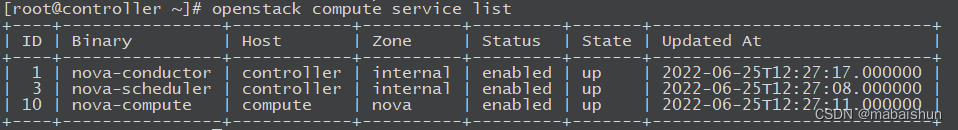

列出服务组件以验证每个进程的成功启动和注册:

openstack compute service list

✔ 笔记

此输出应指示在控制器节点上启用了两个服务组件,在计算节点上启用了一个服务组件。 -

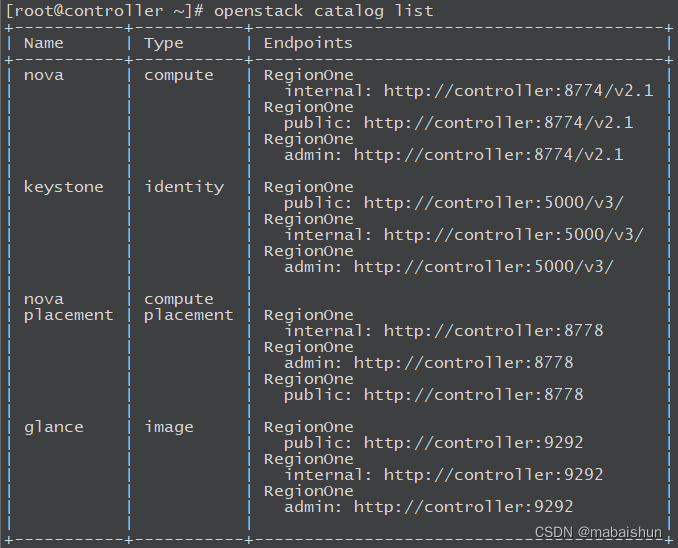

列出身份服务中的 API 端点以验证与身份服务的连接:

✔ 笔记

以下端点列表可能因 OpenStack 组件的安装而异。openstack catalog list

✔ 笔记

忽略此输出中的任何警告。 -

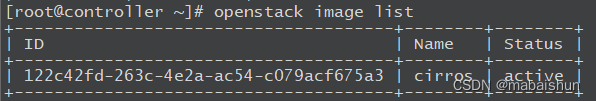

列出图像服务中的图像以验证与图像服务的连接性:

openstack image list

-

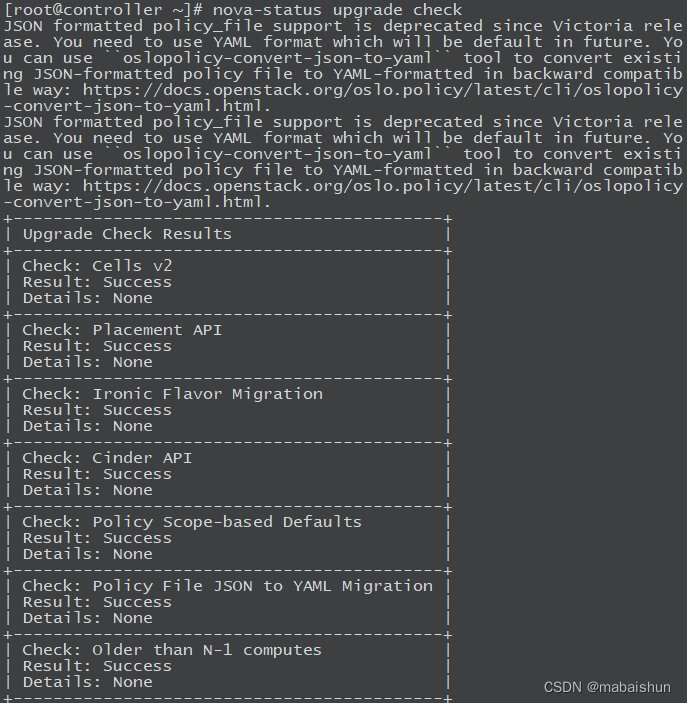

检查单元格和放置 API 是否成功运行,以及其他必要的先决条件是否到位:

nova-status upgrade check

281

281

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?