对于监督学习的分类问题,可以使用Logistic回归算法来拟合出适合的曲线,如果直线不能很好地满足需要,还可以将特征进行组合得到新的非线性特征值(如),从而拟合出含有许多非线性项的Logistic回归函数。但是,当特征数量非常多时,这种方法就会出现问题,例如,对于一张图片上是否有汽车,需要选取图上的每一个像素点作为特征值,假设图片有2500个像素,对于RGB图像则具有7500个特征值,对于这些特征值进行3次方的组合(

),特征数量达到百万量级,导致运算代价变得非常大,而神经网络为这类复杂的非线性假设提供了很好的解决方案。

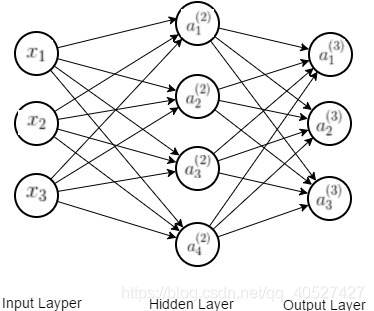

神经网络的基本架构如下图所示,第一层为输入层,最后一层为输出层,中间有若干个隐藏层 ,每两层之间有一个来进行连接,输出层和隐藏层之间有

,隐藏层和输出层之间有

,

的维数为

(其中

,

分别表示

左右相邻层的单元数,不包含偏置单元)。输入层和隐藏层之间的关系为:

,隐藏层与输出层之间的关系为

,其中g表示sigmoid函数。

表达式如下:

本文介绍了神经网络如何解决监督学习中非线性问题的挑战,特别是当特征数量庞大时,神经网络通过多层非线性变换提供有效解决方案。文章详细阐述了神经网络的基本架构、前馈传播和反向传播算法,并讨论了权重初始化的重要性及梯度检测,为神经网络的学习和实现提供了基础理解。

本文介绍了神经网络如何解决监督学习中非线性问题的挑战,特别是当特征数量庞大时,神经网络通过多层非线性变换提供有效解决方案。文章详细阐述了神经网络的基本架构、前馈传播和反向传播算法,并讨论了权重初始化的重要性及梯度检测,为神经网络的学习和实现提供了基础理解。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1444

1444

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?