简介

在LLM中,prompt(提示)是一个预先设定的条件,它可以限制模型自由发散,而是围绕提示内容进行展开。输入中添加prompt,可以强制模型关注特定的信息,从而提高模型在特定任务上的表现。

结构

可以说,prompt的组成类型可以有多种元素,但总体而言包含下面几种:

1、输入指令:告诉它执行的任务

比如我使用了大模型的翻译的功能,实际上就是添加了一个prompt,这里展示出部分源码:

这里很清楚的标明了翻译成中文这几个字,实际上这就是一个预先设定的prompt,让模型帮助我实现翻译文本的目的。

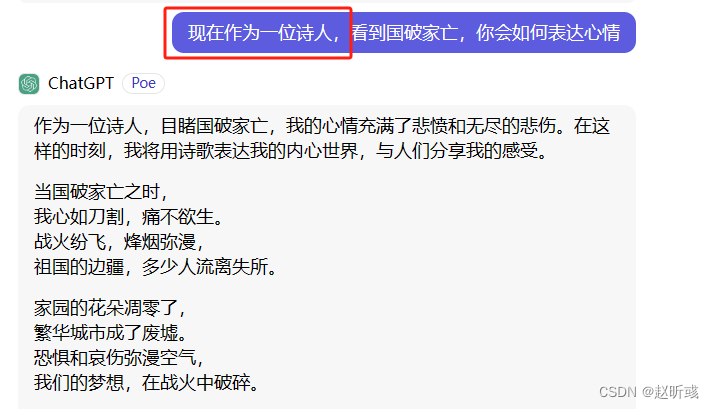

2、背景:环境的设定

这里的诗人的角色,就是通过prompt设定的。模型就会根据设定的“身份”来进行回复。

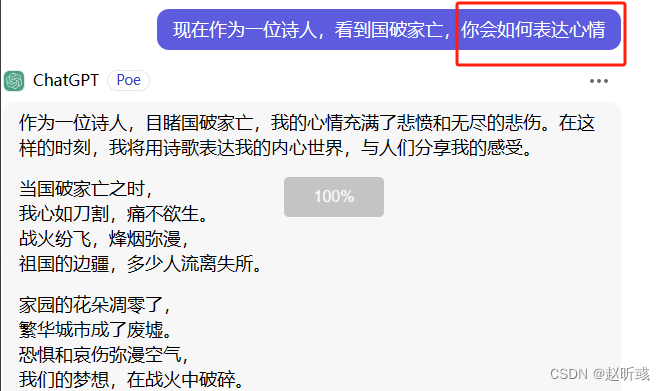

3、输入数据:真正的问题(question)

这里就是真正想询问的内容。

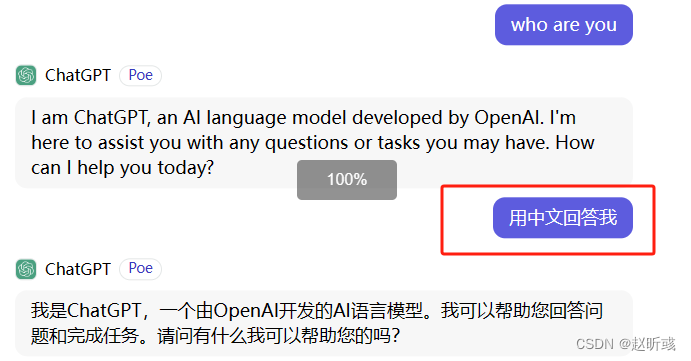

4、输出指示:输出的相关指示

当回答的语言、格式等不及预期,可以添加相应的内容进行提示,让模型根据我们需要的效果回复。

536

536

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?