1.现象

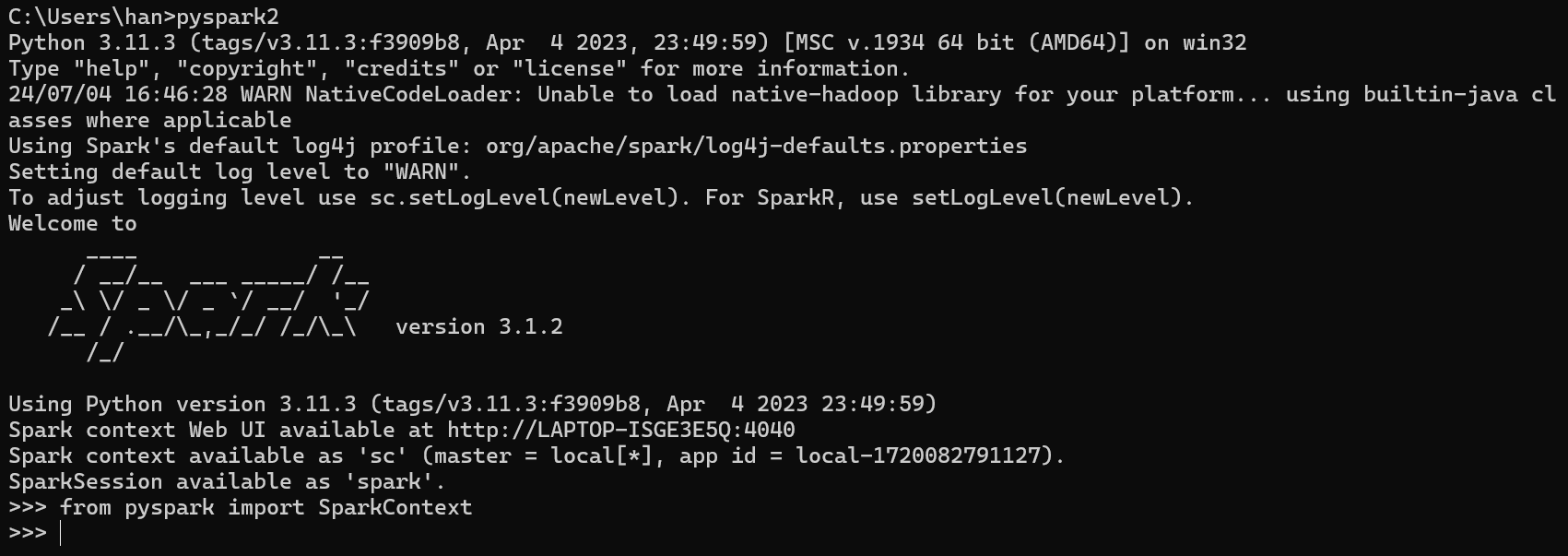

代码:from pyspark import SparkContext

dos窗口执行该命令正常:

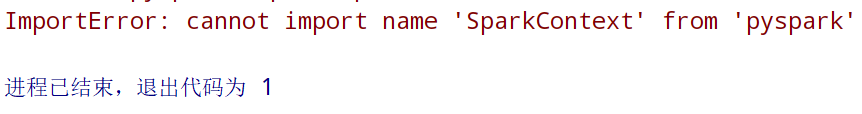

pycharm执行该语句提示:ImportError: cannot import name 'SparkContext' from 'pyspark'

2.解决办法

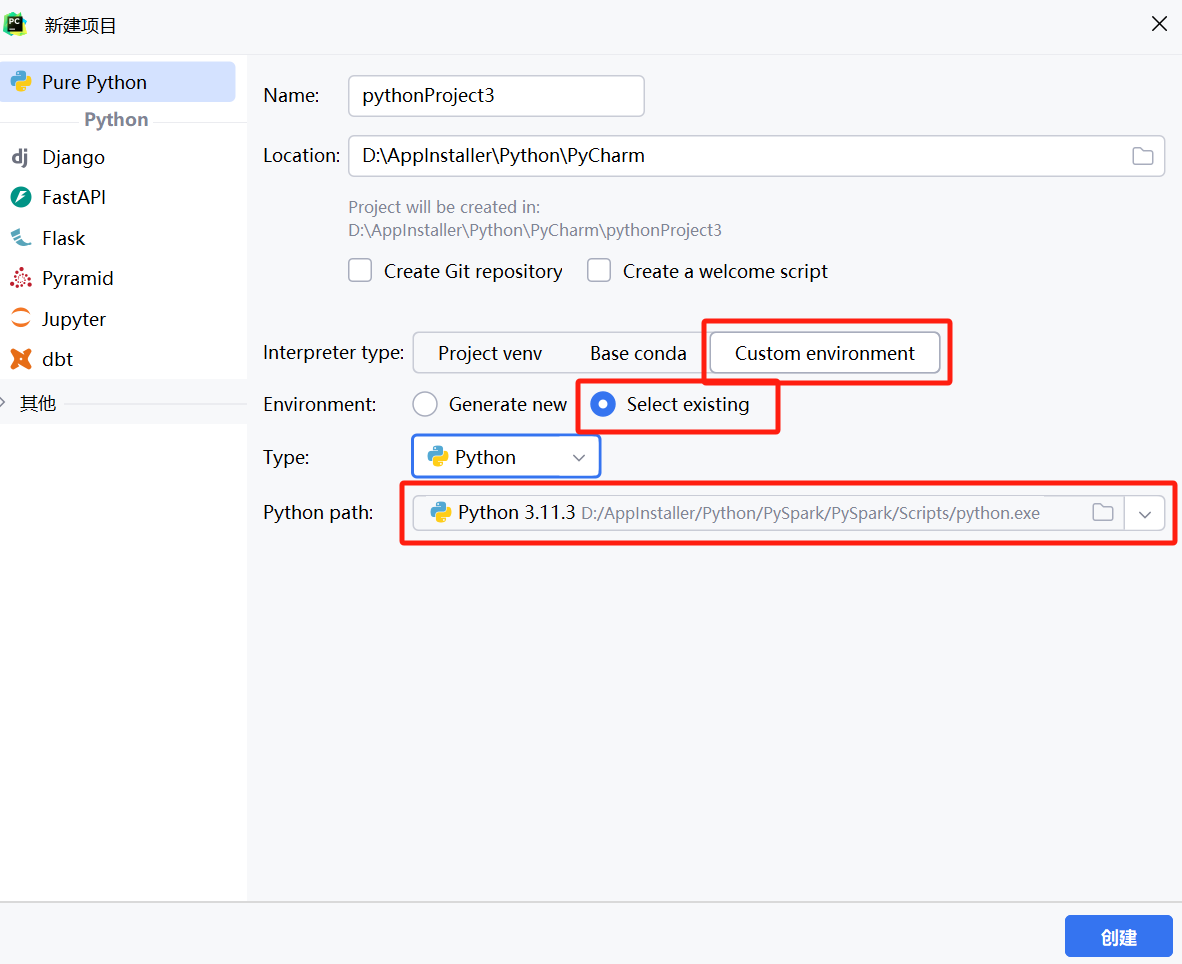

pycharm报错时,解释器选择是“Custom environment”如下图

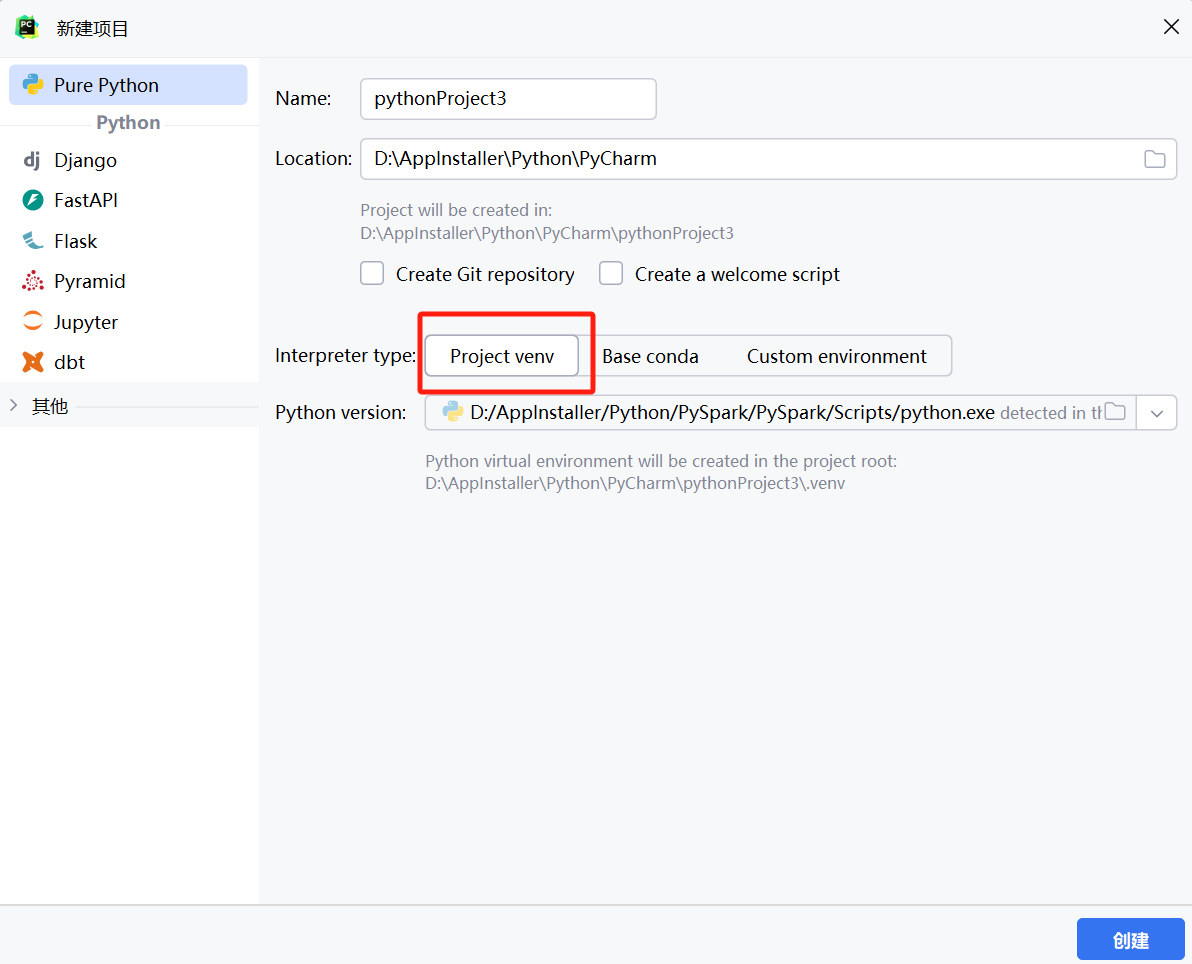

将该选项调整为:

在设置中查看该项目的解释器为自定义的解释器(在dos中使用mkvirtualenv 环境名,创建的虚拟环境)

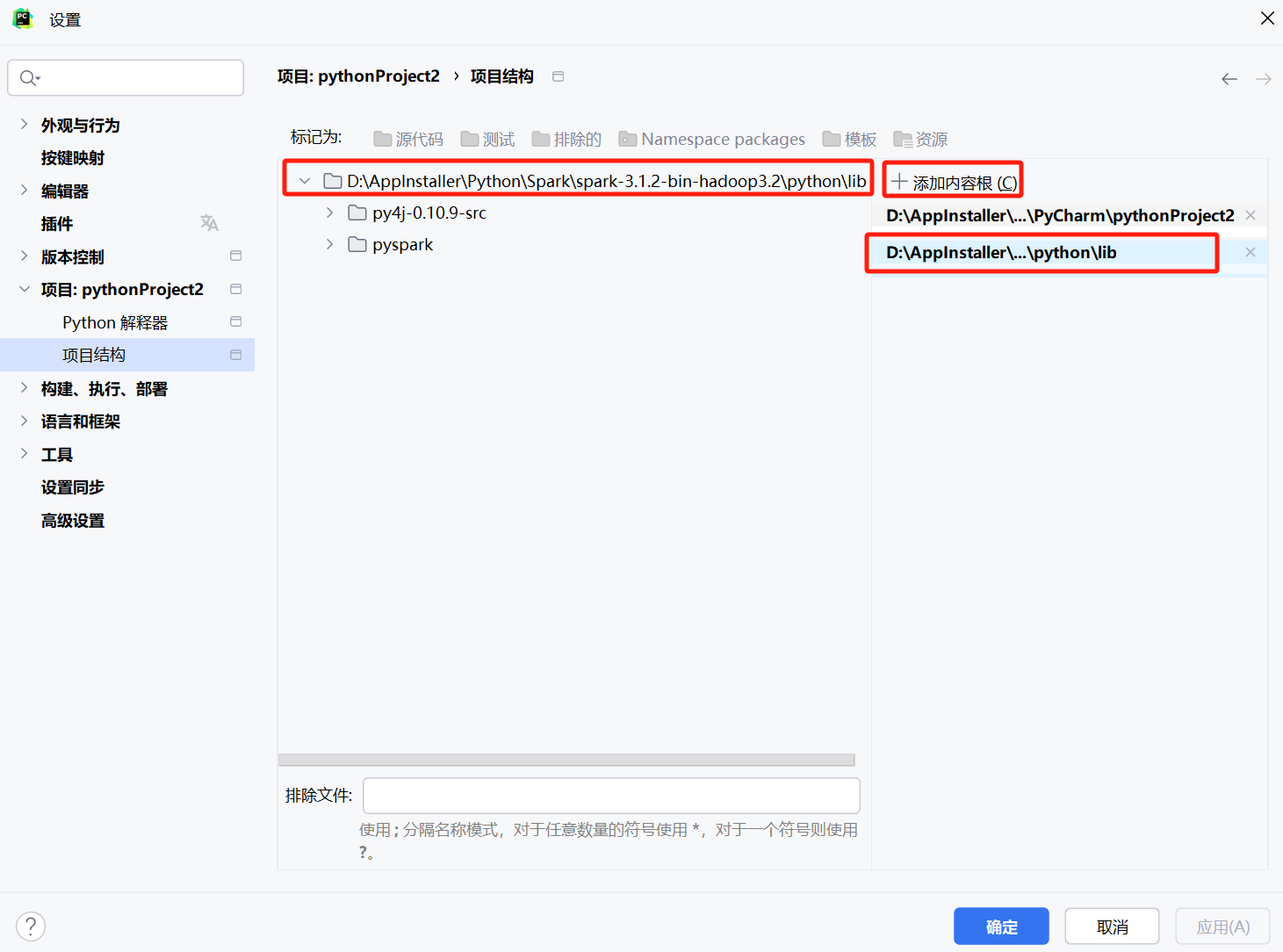

在项目结构选项中选择hadoop安装路径下面的lib目录,加载py4j

若运行结果显示py4j模块不存在,在pycharm中选择终端然后输入:pip install py4j命令,安装该模块即可。

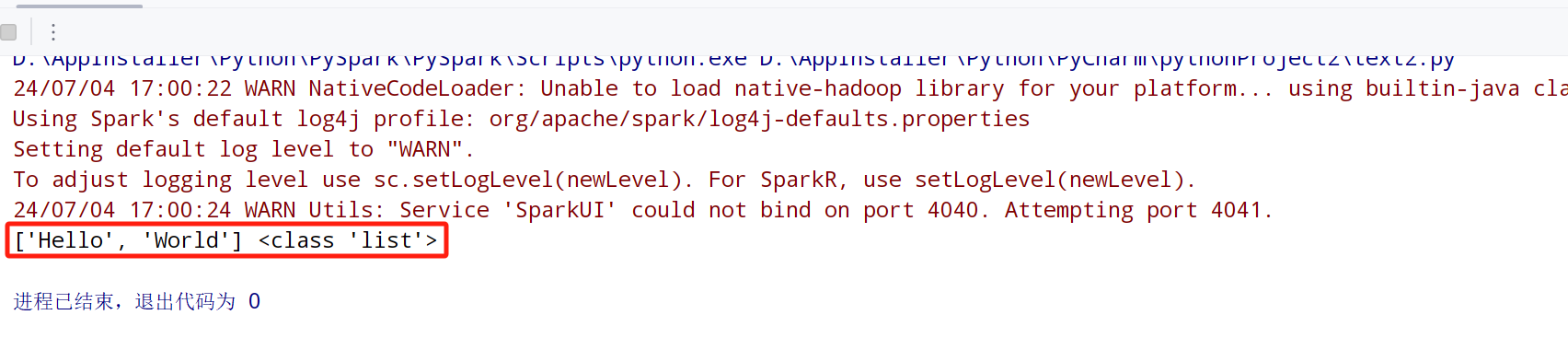

3.验证结果

备注:projectvenv(推荐的工程环境)、Baseconda(针对有conda经验的用户)和customenvironment(包括新建与现有环境选择)按理说应该选择自定义的环境,但是自定义的总是提示该错误,于是选择了工程环境。

2876

2876

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?