核技巧(Kernel Trick)与支持向量回归(SVR)详解

第十五次写博客,本人数学基础不是太好,如果有幸能得到读者指正,感激不尽,希望能借此机会向大家学习。这一篇内容来自于《机器学习》和林轩田《技法》以及自己的一些理解。

这篇文章首先对表示定理(Representor Theorem)进行介绍和证明,然后引出核技巧(Kernel Trick)及其应用,再介绍核技巧版的线性回归即核线性回归,最后通过核线性回归和带核SVM对比引出支持向量回归(Support Vector Regression)。

表示定理(Representor Theorem)

令 H \mathbf{H} H为核函数 k k k对应的再生核希尔伯特空间(Mercer 定理中提到过), ∣ ∣ h ∣ ∣ H ||h||_{\mathbf{H}} ∣∣h∣∣H表示 H \mathbf{H} H空间中关于优化问题的解 h h h的范数,对于任意单调递增函数 Ω : [ 0 , ∞ ] ↦ R \Omega:[0,\infty]\mapsto{\Bbb{R}} Ω:[0,∞]↦R和任意非负损失函数 l : R m ↦ [ 0 , ∞ ] l:\Bbb{R}^m\mapsto[0,\infty] l:Rm↦[0,∞],优化问题

的解总可写为

表示定理对损失函数没有限制,对正则化项 Ω \Omega Ω仅要求单调递增,甚至不要求 Ω \Omega Ω是凸函数,因此对于一般的损失函数和正则化项,优化问题的最优解 h ∗ ( x ) h^{*}\left(\mathbf{x}\right) h∗(x)都可以表示为核函数 k ( x , x i ) k\left(\mathbf{x},\mathbf{x}_i\right) k(x,xi)的线性组合。

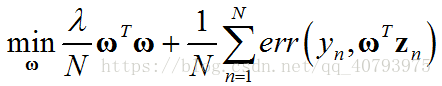

下面以带有 L 2 L_2 L2正则项的线性模型为例,证明这个定理,假设该优化问题可以表示为

其中, z n = ϕ ( x n ) \mathbf{z}_n=\phi\left(\mathbf{x}_n\right) zn=ϕ(xn),假设该问题的最优解为

最优的目标变量可以写为

证明上式成立,目标变量的一般形式可以写为 ω ∗ = ω ∣ ∣ + ω ⊥ \omega^*=\omega_{||}+\omega_{\bot} ω∗=ω∣∣+ω⊥,其中, ω ∣ ∣ ∈ s p a n ( x n ) \omega_{||}\in{span\left(\mathbf{x}_n\right)} ω∣∣∈span(xn), ω ⊥ ⊥ s p a n ( x n ) \omega_{\bot}\bot{span\left(\mathbf{x}_n\right)} ω⊥⊥span(xn),为了得到形如上式的最优解,应该使垂直分量 ω ⊥ = 0 \omega_{\bot}=0 ω⊥=0。根据反证法,如果该分量不为零,那么优化目标中的第二项,由于 ω ⊥ ⊥ s p a n ( x n ) \omega_{\bot}\bot{span\left(\mathbf{x}_n\right)} ω⊥⊥span(xn)的原因,可以表示为

本文详细介绍了核技巧(Kernel Trick)和其在支持向量回归(SVR)中的应用。首先阐述了表示定理,然后讲解了核线性回归,最后通过对比分析展示了SVR如何通过容忍一定误差来实现高效回归模型。SVR在保持核函数优势的同时,通过ε-不敏感损失函数实现了模型的稀疏性,降低了大规模数据的计算复杂度。

本文详细介绍了核技巧(Kernel Trick)和其在支持向量回归(SVR)中的应用。首先阐述了表示定理,然后讲解了核线性回归,最后通过对比分析展示了SVR如何通过容忍一定误差来实现高效回归模型。SVR在保持核函数优势的同时,通过ε-不敏感损失函数实现了模型的稀疏性,降低了大规模数据的计算复杂度。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1363

1363

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?