微积分

微积分在深度学习中同样占据着举足轻重的地位。神经网络中的优化算法,如梯度下降、反向传播等,都需要用到微积分的知识。这些优化算法通过计算损失函数对模型参数的梯度,来指导模型参数的更新方向,从而使模型能够逐渐逼近最优解。

此外,微积分中的导数、偏导数、链式法则等概念,也是理解神经网络工作原理和推导相关公式的基础。因此,掌握微积分的基础知识对于实现和调试深度学习算法同样至关重要。

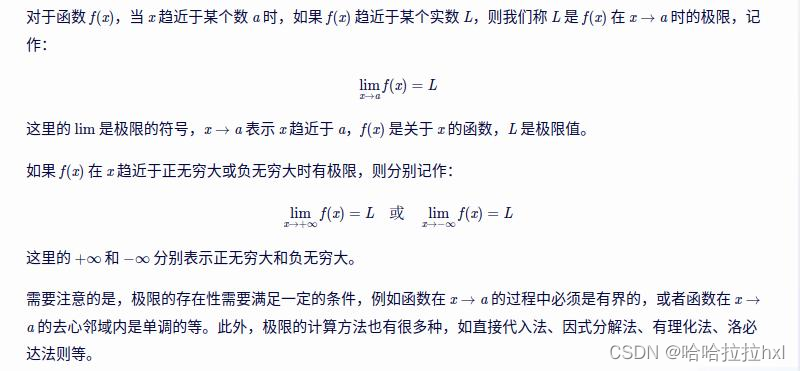

极限

极限的概念被清晰地阐述为函数值在某一点附近无限趋近某一特定值的过程,但永远不会达到该点。这种“无限靠近而永远不能到达”的思想是微积分学的基础,也是理解许多数学和物理现象的关键。

极限的一般表达式可以用以下公式来表示:

求导

求导是微积分中的一个核心概念,它描述了一个函数在某一点附近的变化率。在深度学习中,求导是优化算法(如梯度下降)的基础,用于找到使损失函数最小的参数值。

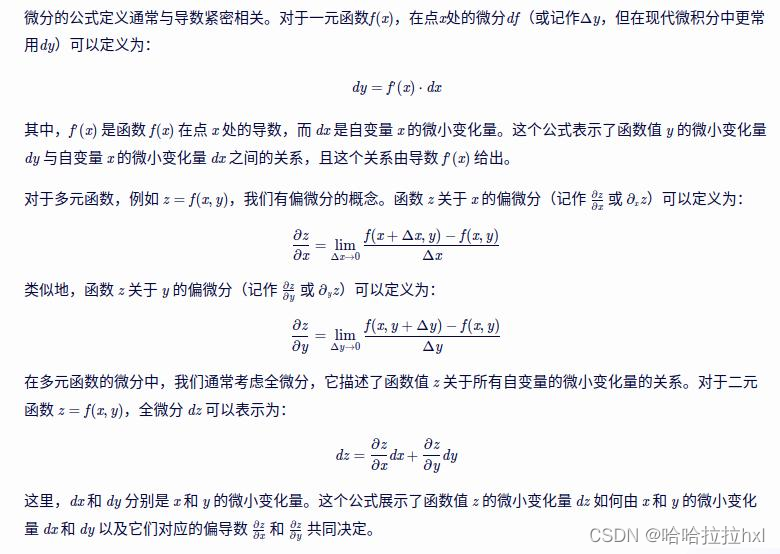

微分

微分是一个描述函数局部变化的重要概念,它与导数密切相关但又有所不同。具体来说,微分是对函数局部变化的一种线性描述,可以近似地表示当函数的自变量取值发生足够小的改变时,函数值是如何变化的。

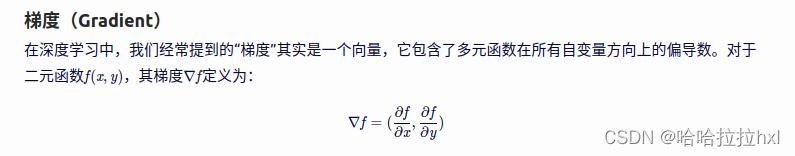

梯度指向了函数值增加最快的方向,而梯度的负方向则指向了函数值减小最快的方向。在深度学习中,我们通常使用梯度的负方向来更新模型的参数,这就是所谓的“梯度下降算法”。

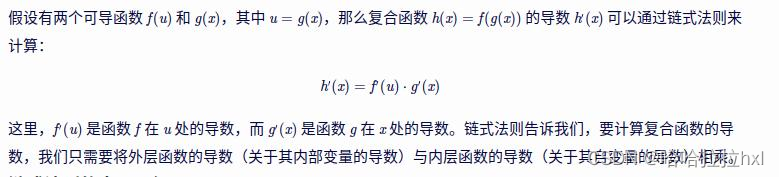

链式法则(Chain Rule)是微积分中用于计算复合函数导数的重要法则。在深度学习中,由于模型通常包含多层嵌套的函数(即复合函数),链式法则成为了计算梯度(即导数)的关键工具。

链式法则的定义

链式法则的直观理解

链式法则可以理解为“变化率的变化率”。当我们考虑一个复合函数时,它的变化率(即导数)是由内层函数和外层函数共同决定的。内层函数首先产生一个变化,这个变化再被外层函数放大或缩小,从而得到复合函数的最终变化率。链式法则正是用来计算这种“变化率的变化率”的。

链式法则在深度学习中的应用

在深度学习中,模型通常是由多层神经网络组成的,每一层都对应一个函数。当我们使用梯度下降算法来训练模型时,需要计算损失函数关于模型参数的梯度。由于损失函数是模型输出的复合函数(即经过多层神经网络变换后的函数),因此我们需要使用链式法则来逐层计算梯度。

具体来说,我们可以从损失函数开始,逐层向前计算每一层输出的梯度,直到到达输入层。在每一层中,我们都使用链式法则来计算该层输出的梯度,并将其传递给上一层。这个过程通常被称为“反向传播”(Backpropagation)。通过反向传播,我们可以高效地计算损失函数关于模型所有参数的梯度,并使用这些梯度来更新模型的参数。

链式法则的扩展

链式法则可以扩展到更高阶的复合函数。对于由多个函数嵌套而成的复合函数,我们可以将链式法则多次应用,依次计算每一层函数的导数,并将它们相乘得到最终的导数。此外,链式法则还可以与其他微积分法则(如乘法法则、除法法则、幂函数法则等)结合使用,以处理更复杂的函数形式。

示例

总结

以下深度学习中的微积分知识点:

- 极限:

- 极限是微积分的基础,用于描述函数在某一点的取值趋势。

- 导数(Derivative):

- 导数描述了函数在某一点附近的变化率,即函数值随自变量变化的快慢程度。

- 对于一元函数 f(x),其导数 f′(x) 定义为 limΔx→0Δxf(x+Δx)−f(x)。

- 微分(Differential):

- 微分描述了函数值随自变量的微小变化而产生的变化量。

- 在一元函数中,微分可以表示为 dy=f′(x)⋅dx,其中 dy 是函数值的变化量,dx 是自变量的变化量,f′(x) 是该点的导数。

- 偏导数(Partial Derivative):

- 偏导数用于描述多元函数中一个变量变化时,函数值如何随该变量变化,而保持其他变量不变。

- 对于多元函数 f(x,y),其关于 x 的偏导数 ∂x∂f 表示了当 x 变化而其他变量保持不变时,函数值如何变化。

- 梯度(Gradient):

- 梯度是一个向量,包含了多元函数在所有自变量方向上的偏导数。

- 对于二元函数 f(x,y),其梯度 ∇f 为 (∂x∂f,∂y∂f)。

- 梯度指向函数值增加最快的方向,而梯度的负方向则指向函数值减小最快的方向。

- 链式法则(Chain Rule):

- 链式法则用于计算复合函数的导数。

- 对于复合函数 h(x)=f(g(x)),其导数 h′(x) 可以通过 f′(g(x))⋅g′(x) 来计算。

- 在深度学习中,链式法则被用于反向传播算法,以计算损失函数关于模型参数的梯度。

这些知识点是深度学习数学基础的重要组成部分,特别是在理解和实现神经网络训练算法时至关重要。通过不断学习和实践,可以逐步加深对这些概念的理解和应用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?