1 介绍

本文将介绍一种基于Transformer和BiGRU(双向门控循环单元)的混合模型及其在时间序列预测中的应用。本模特适用于多输入单输出预测,适合风电预测,功率预测,负荷预测等等。

2 方法

首先,从Excel文件中导入数据,并去除了时间列。然后,将数据分为训练集和测试集,并进行了归一化处理。输入数据为前n-1列特征,输出为最后一列特征。接着,通过设置历史步长和未来预测步长,生成适用于训练和测试的数据集。

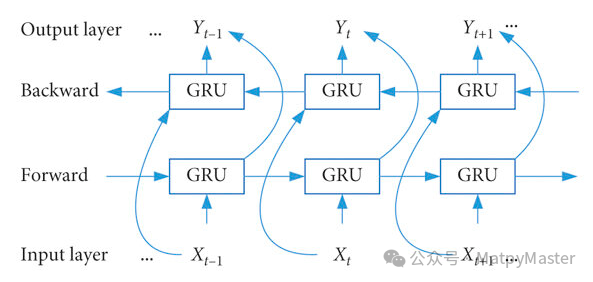

Transformer-BiGRU模型结合了Transformer和BiGRU的优势。Transformer用于捕捉全局特征,而BiGRU则更擅长于处理序列数据中的时间依赖性。模型结构如下:

-

输入层:接收归一化后的时间序列数据。

-

Transformer编码器层:使用多层Transformer编码器捕捉全局特征。

-

BiGRU层:使用多层双向GRU进一步处理序列特征。

-

线性层:输出预测结果。

3 结果

我们使用均方误差(MSE)作为损失函数,并采用Adam优化器进行模型训练。在训练过程中,每隔10个epoch打印一次损失,以监控模型的训练情况。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?