今天给大家介绍Stable Diffusion的另外一种打开方式 ComfyUI,

ComfyUI是基于节点流程是的AI绘图软件你可以把他认为它集成了Stable Diffusion的所有功能,每个功能就是一个节点,然后我们通过组装节点就可以灵活控制出图。

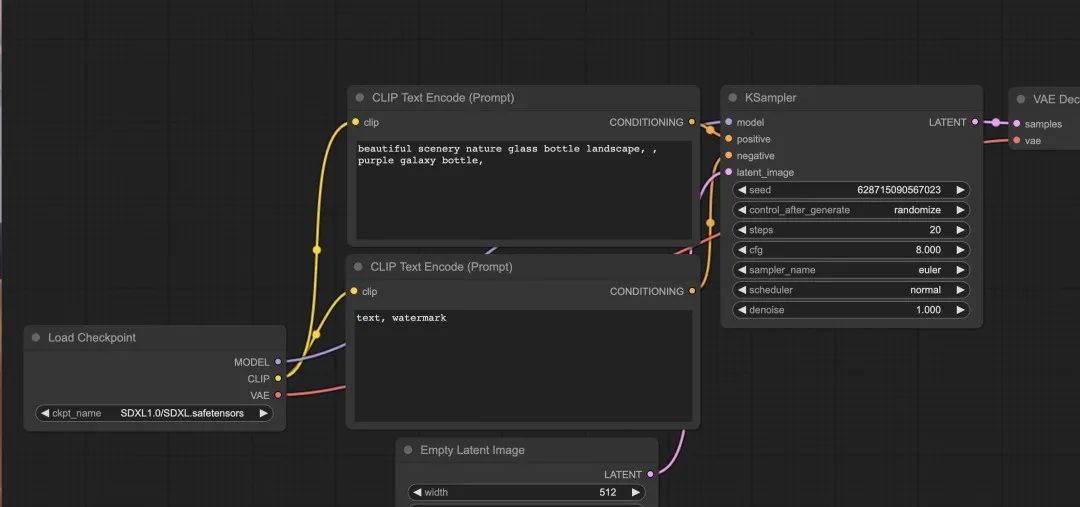

通过描述还是比较抽象,我们来看一下眼ComfyUI吧,看看节点流程是什么样子的。

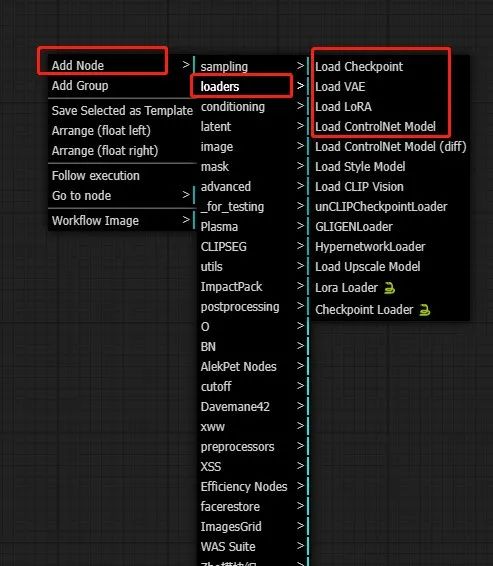

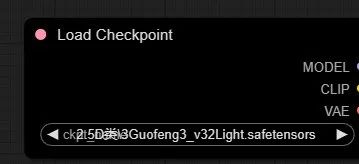

可以看到AI绘画的每个步骤都被拆成了一个节点,比如加载模型(Load Checkpoint)、采样器(KSampler)、提示词(Prompt)等都是以节点的形式存在。

大家用习惯WebUI之后,看到ComfyUI的节点可能有两种感觉–陌生,头大。现在我就带大家感受一下。

#01

/安装

原生网址:https://github.com/comfyanonymous/ComfyUI

B站UP主ZHO大佬的汉化包:https://github.com/ZHO-ZHO-ZHO/ComfyUI-ZHO-Chinese

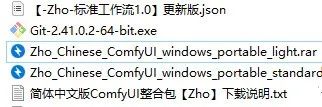

今天是直接用到的ZHO的汉化包,有精简版和标准版,我用的是标准版,此安装包文末领取。

注意:为了控制压缩包的大小,整合包内没有放置SD模型,

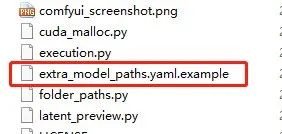

需要自己把模型到models\checkpoints里,或选择与WebUI模型路径共享),如果已经部署SD了,可以通过路径共享,方法是:

1、在ComfyUl文件夹中找到extra model paths.yamlexample文件右键用记事本打开文件;

2、把里面“path/to/stable-diffusion-webui/”换成你放置WebU模型的文件夹路径(路径中不要出现中文),切记,要改为SD的根目录;

3、点击文件-保存;

4、关闭文件,右键重命名文件,把名称中的.example去掉,变为extra model paths.yaml。重启之后,主模型加载器就会自动加载到模型。

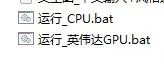

安装好了之后,可以启动了,这里有两种启动方式:

1、CPU启动;

2、GPU英伟达显卡启动,显卡好的话就用这个。

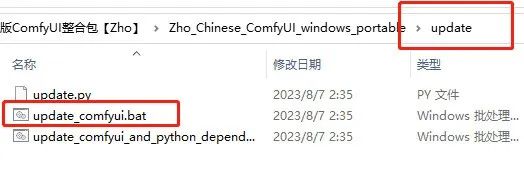

另外,后期Comfy更新升级可以用,主目录下的update文件夹里面的升级脚本升级。

**安装包获取方式关注公众号发送:**ComfyUI

#02

/使用

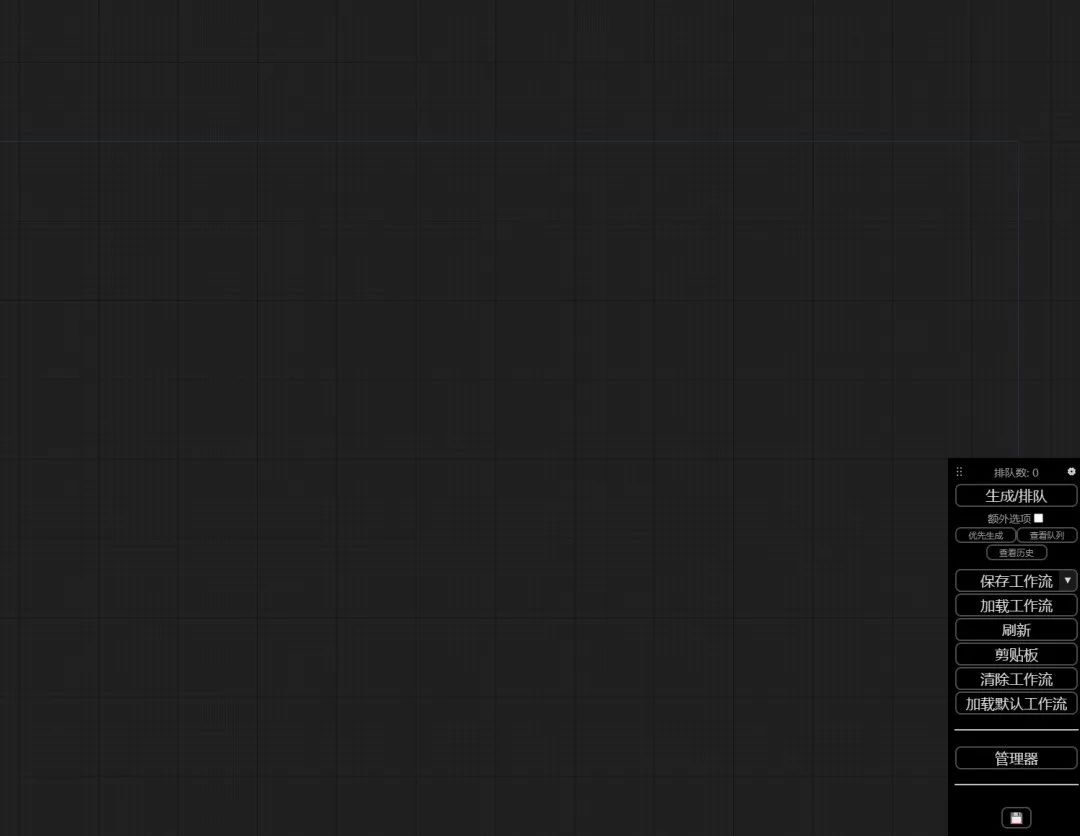

启动后,界面是空白的,模块没有在界面上显示,需要自定义添加。

简单运行

这时候有两种方法可以执行,推荐第二种。

1、鼠标右键,自主添加生成图片需要的模块;

2.可以直接用ZHO汉化的模块组:

界面上就会弹出对应的窗口,刚刚加的是主模型加载器。

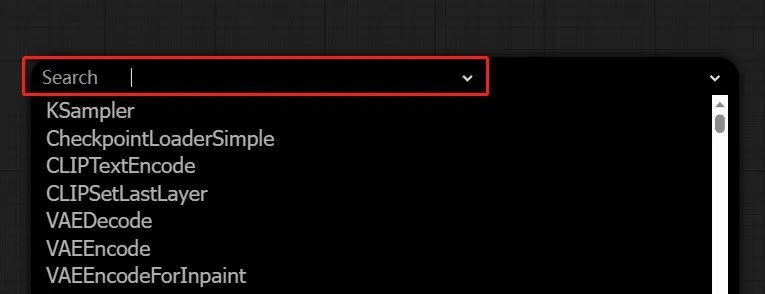

也可以鼠标双击界面,弹出搜索窗口,直接搜索常用版块:

Alek节点

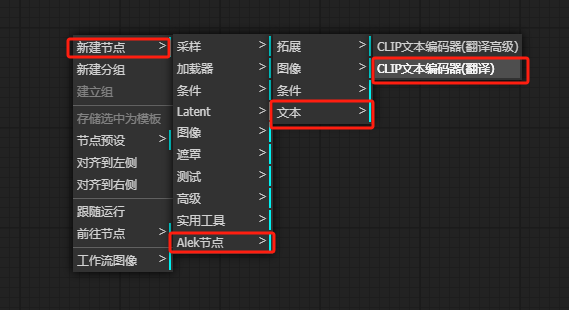

右键 — 新建节点 — Alek节点,可以看到四个功能:

依次点击会出现以下功能:

清除这些功能后,我们来实操一下:

-

**步骤1、**点击“加载默认”,调出默认工作流;

-

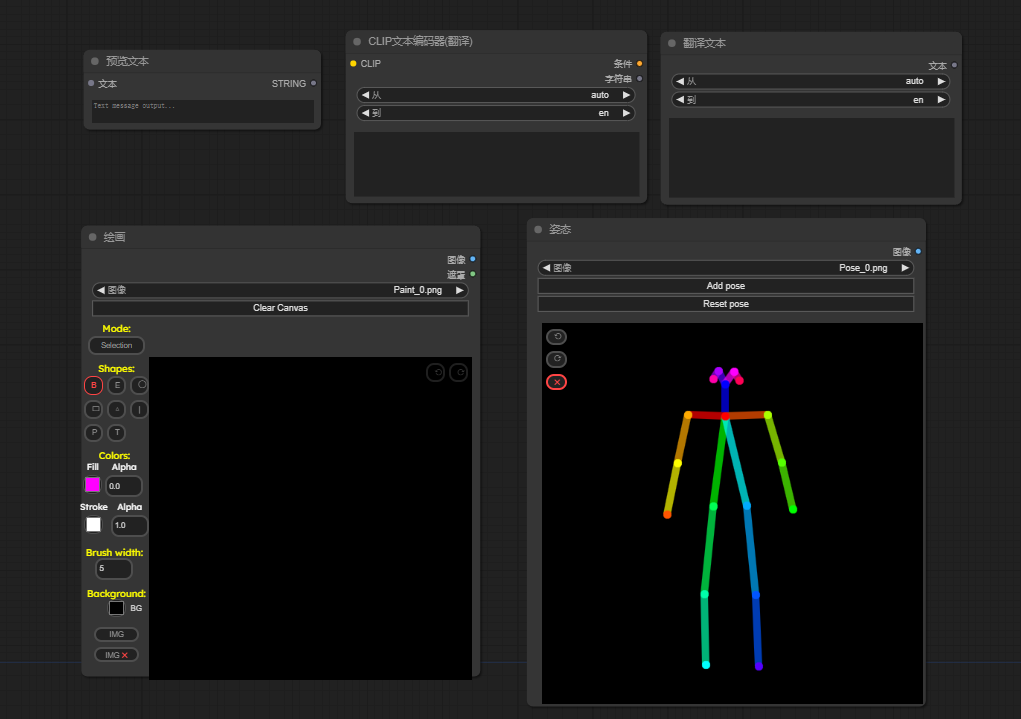

**步骤2、**调出CLIP文本编码器

**步骤3、**右键点击系统自带的 CLIP文本编码器,选择“转换 文本 为输入”

**步骤4、**链接翻译文本编码器和系统文本编码器

**步骤5、**右键“新建节点”—“Alek节点”—“拓展”—“预览文本”

**步骤6、**链接翻译编码器和预览文本

这一步是对“CLIP文本编码器(翻译)”栏进行预览,主要是避免插件翻译不准确。

所有的AI绘画工具,模型和插件资源·,AI学习资料及教程都已经整理好了,文末扫码即可免费获取噢~

写在最后

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

若有侵权,请联系删除

若有侵权,请联系删除

4196

4196

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?