茴香豆

https://www.bilibili.com/video/BV1QA4m1F7t4/?vd_source=902e3124d4683c41b103f1d1322401fa

一、笔记

RAG

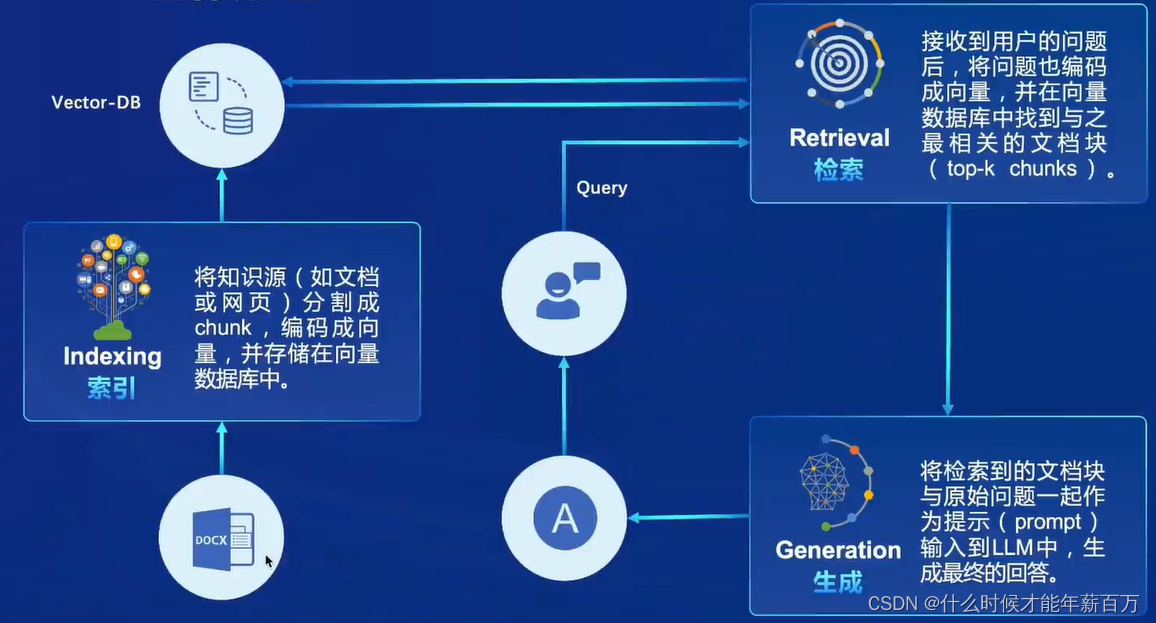

RAG(Retrieval Augmented Generation)是一种结合了检索(Retrieval)和生成(Generation)的技术,旨在通过利用外部知识库来增强大预言模型的性能。它通过检索用户输入相关的信息片段,并结合这些信息来生成更准确、更丰富的回答。简而言之,RAG=搜索引擎+大模型

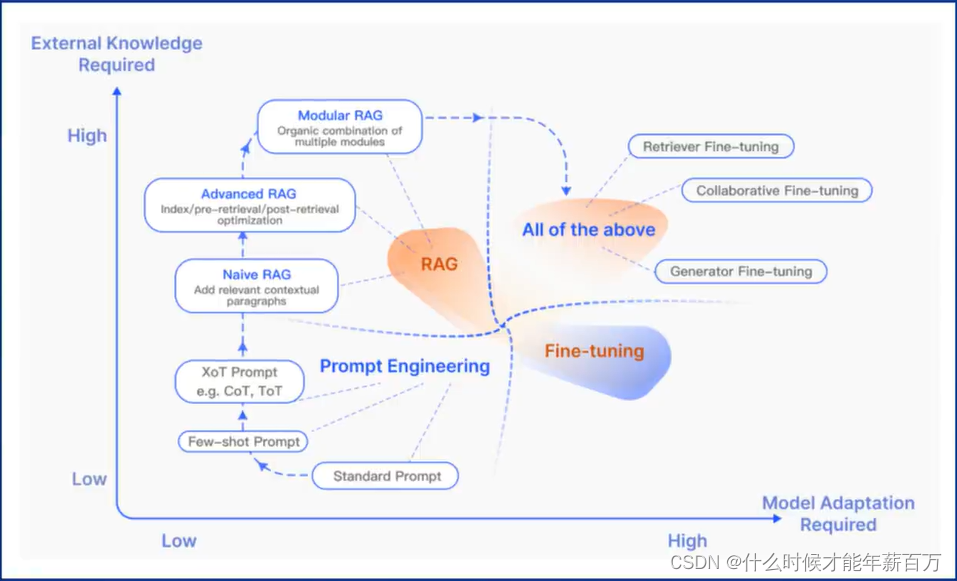

三种范式

Naive RAG→Advanced RAG→Modular RAG

优化方法

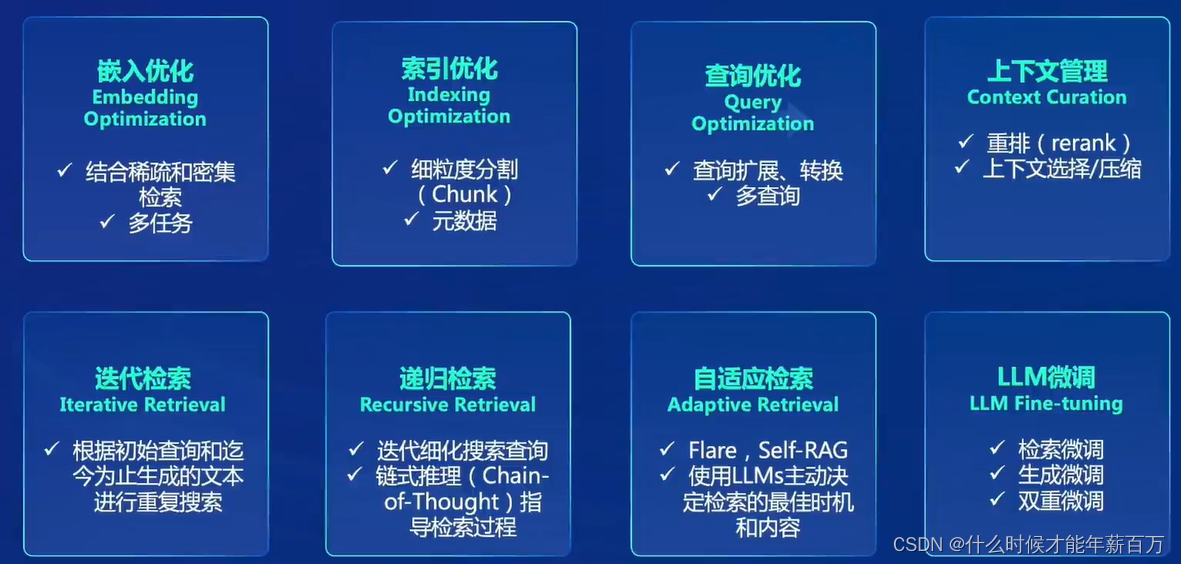

- 嵌入优化

- 索引优化

- 查询优化

- 上下文管理

- 检索优化:迭代检索、递归检索、自适应检索

- 大模型微调

RAG vs 微调

| RAG | 微调 | |

|---|---|---|

| 简介 | 非参数记忆;能够处理知识密集型任务;可以生成多样化内容 | 参数记忆;微调需要大量标注数据;可能存在过拟合 |

| 适用场景 | 适合信息更新较快的任务 | 适合高度专业化的任务 |

| 优势 | 动态知识更新,能处理长尾知识 | 可以针对特定任务优化 |

| 局限 | 依赖外部知识库的质量和大模型的能力 | 需要大量标注数据,不能很好适应新任务 |

大模型优化方法比较

- 微调(Fine-tuning)

- RAG

- 提示词工程(Prompt Engineering)

- 微调+RAG+提示词工程

茴香豆

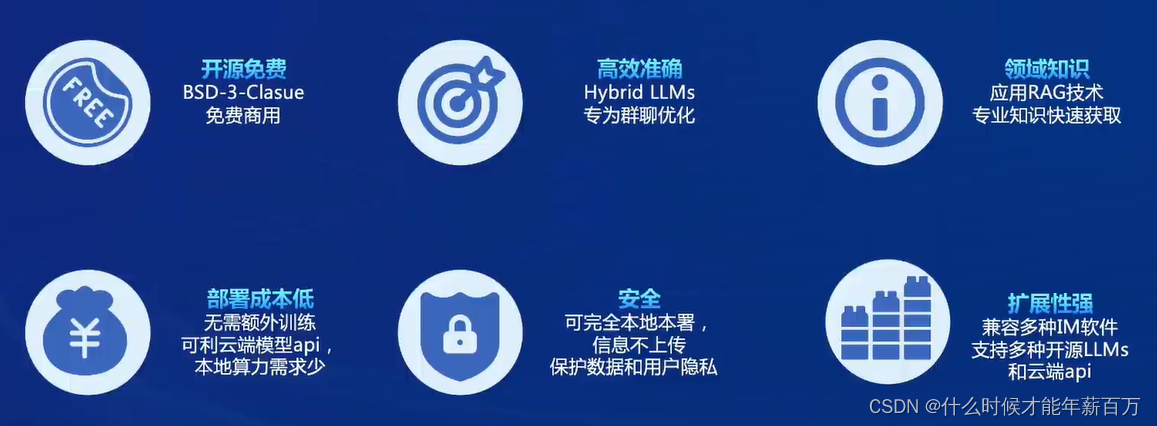

茴香豆是一个基于LLMs的领域知识助手,俗称豆哥。可以用作智能客服,或在即时通讯工具(IM),如微信群中高效解答问题

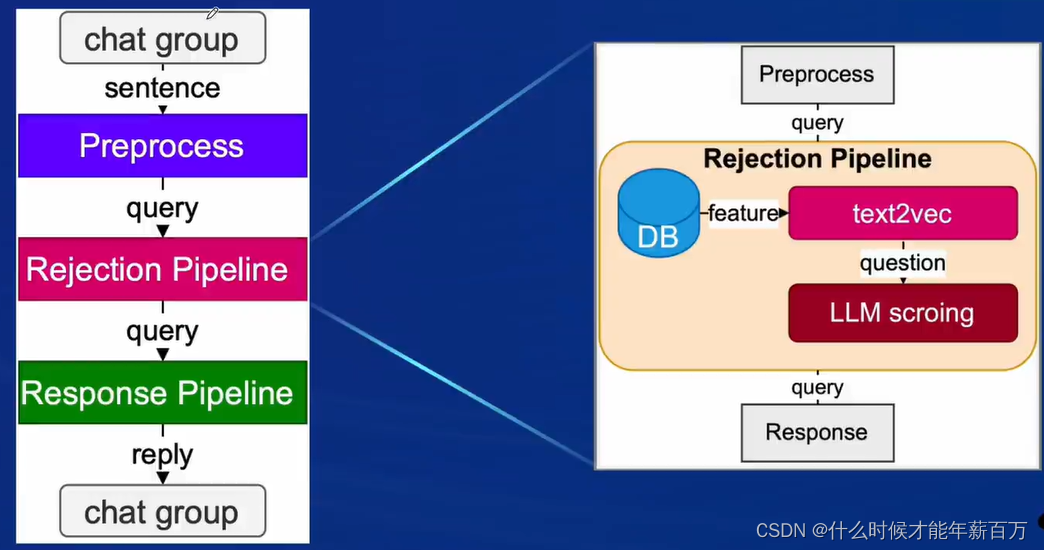

系统组成

知识库+前端+后端大模型+豆哥

- 知识库:markdown、word、pdf、txt、ppt

- 前端应用:微信、飞书等

- 后端:本地大模型——书生浦语、通义千问;远程大模型api——chatgpt、chatglm等

- 豆哥:豆哥负责整合、打通工作流,形成智能领域的知识问答助手

豆哥的工作流程可以分为:预处理、拒答工作流和应答工作流

拒答工作流可以对提问进行打分,打分高的问题可以进入应答流进行回答。

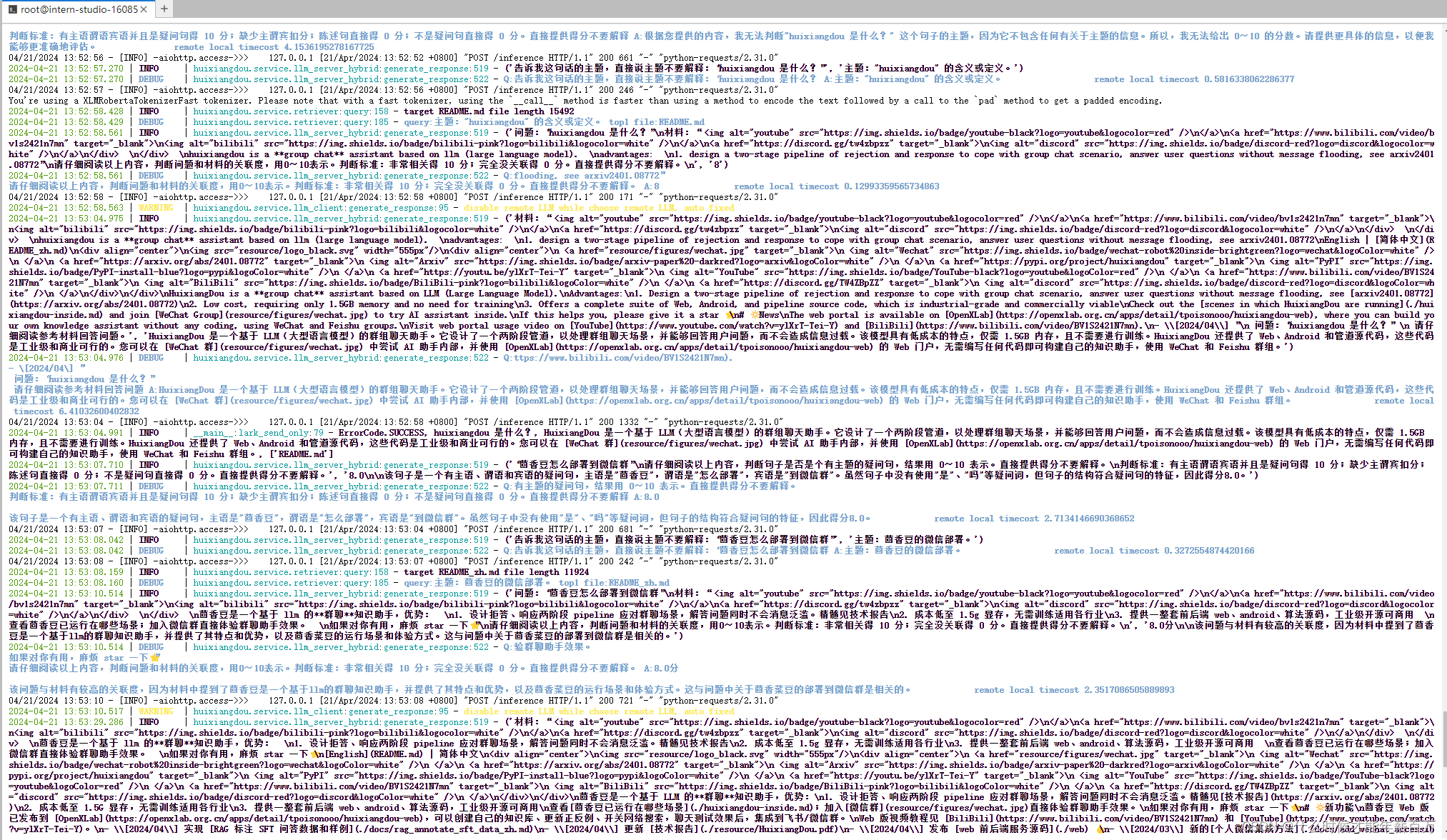

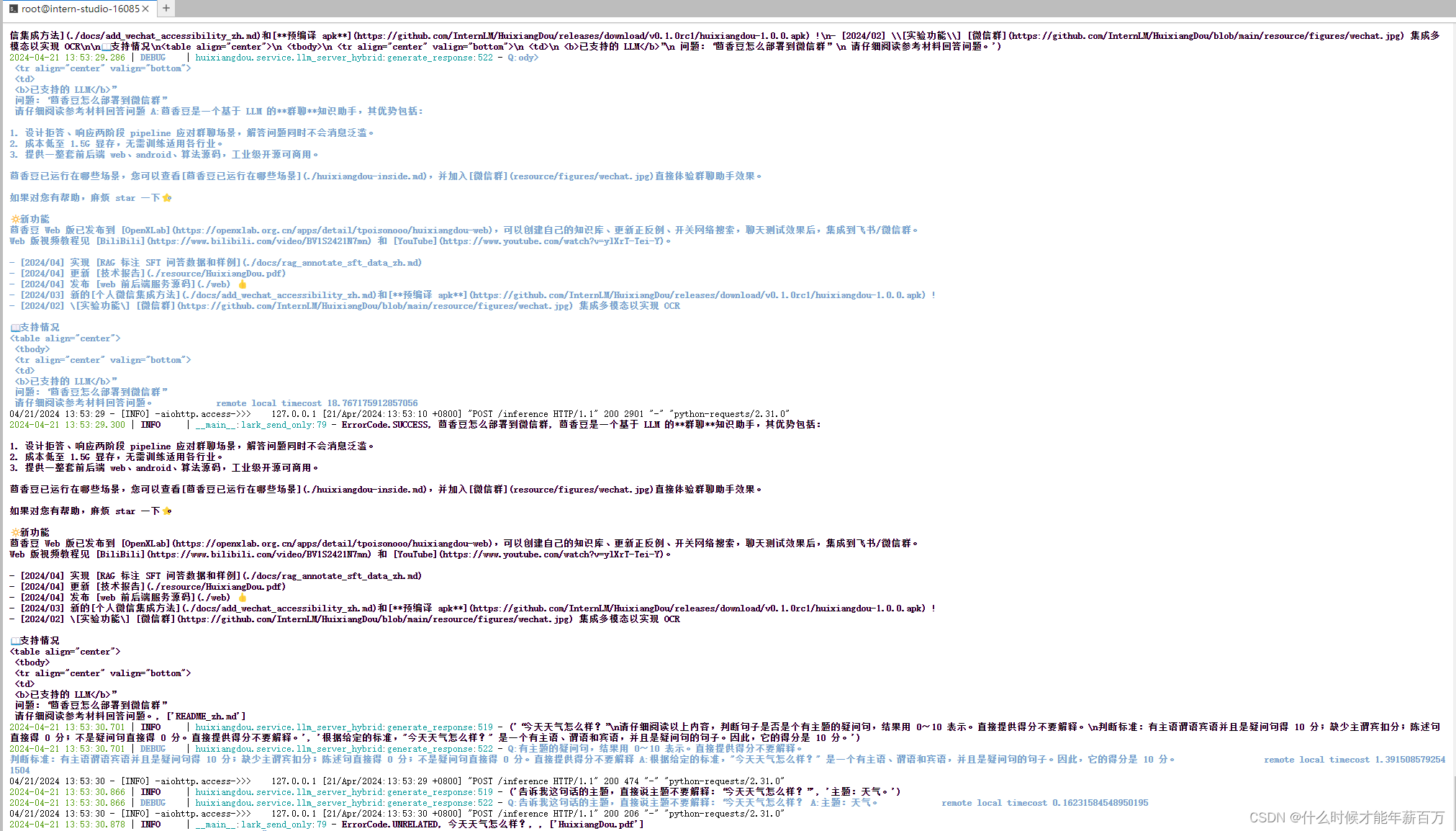

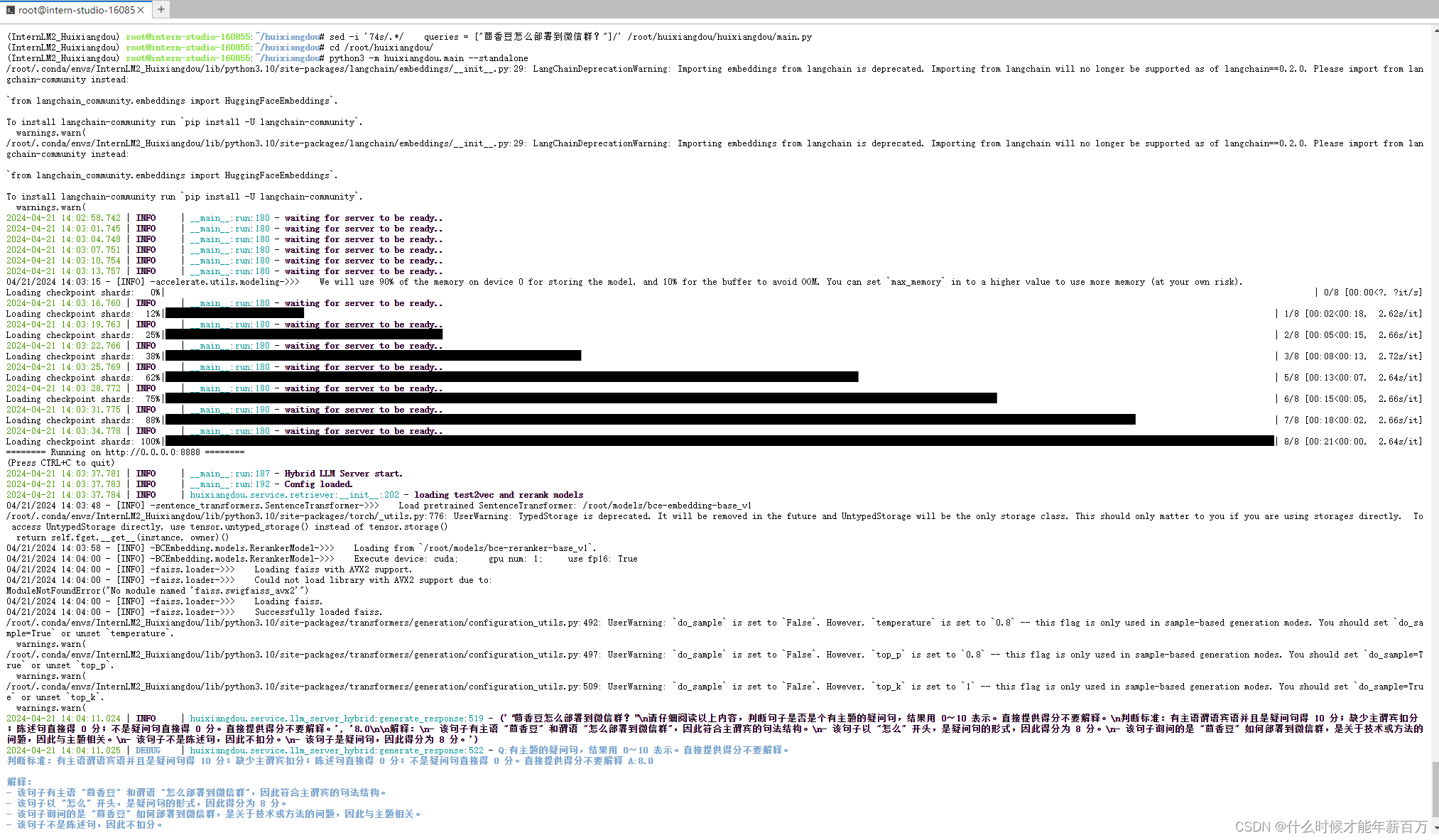

二、基础作业

在 InternLM Studio 上部署茴香豆技术助手

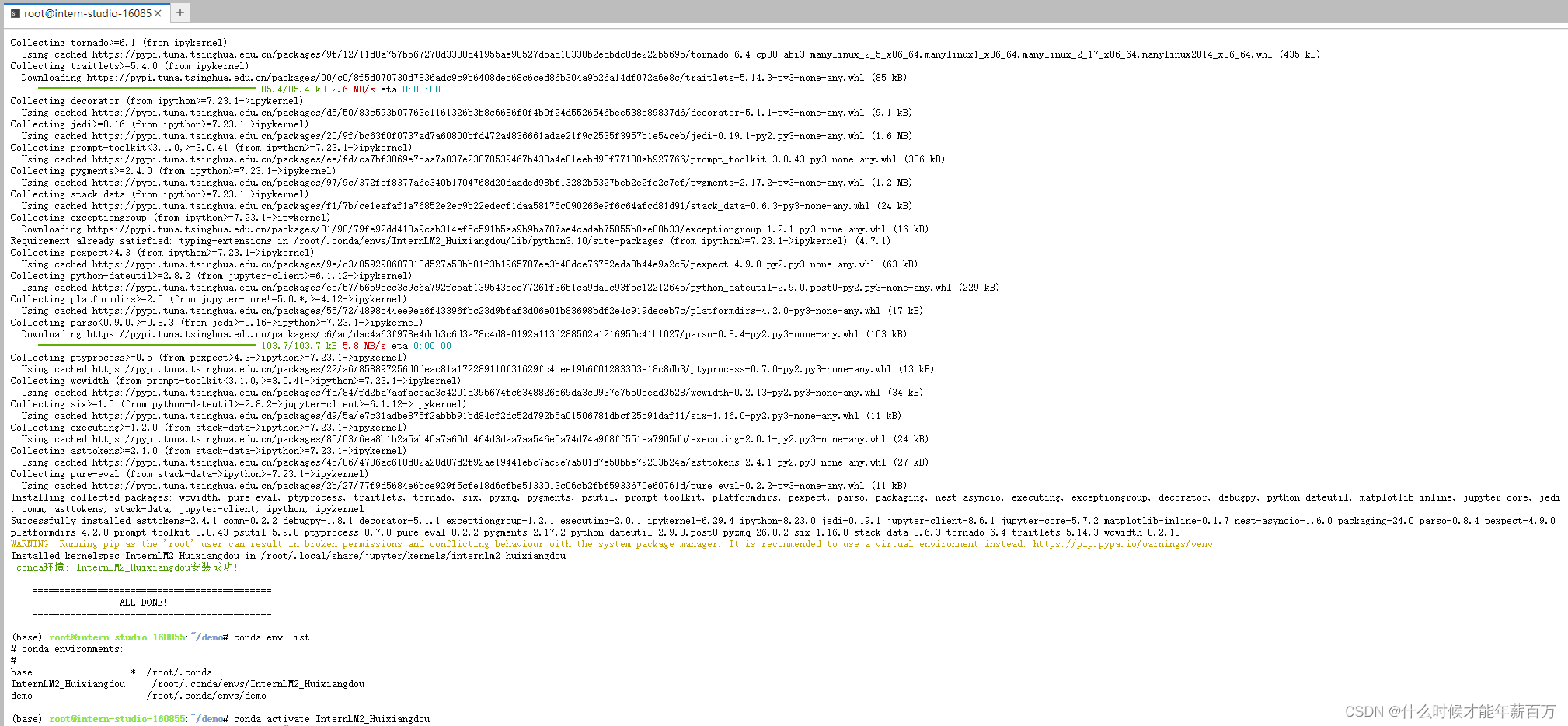

(1)环境准备

从官方环境复制运行 InternLM 的基础环境

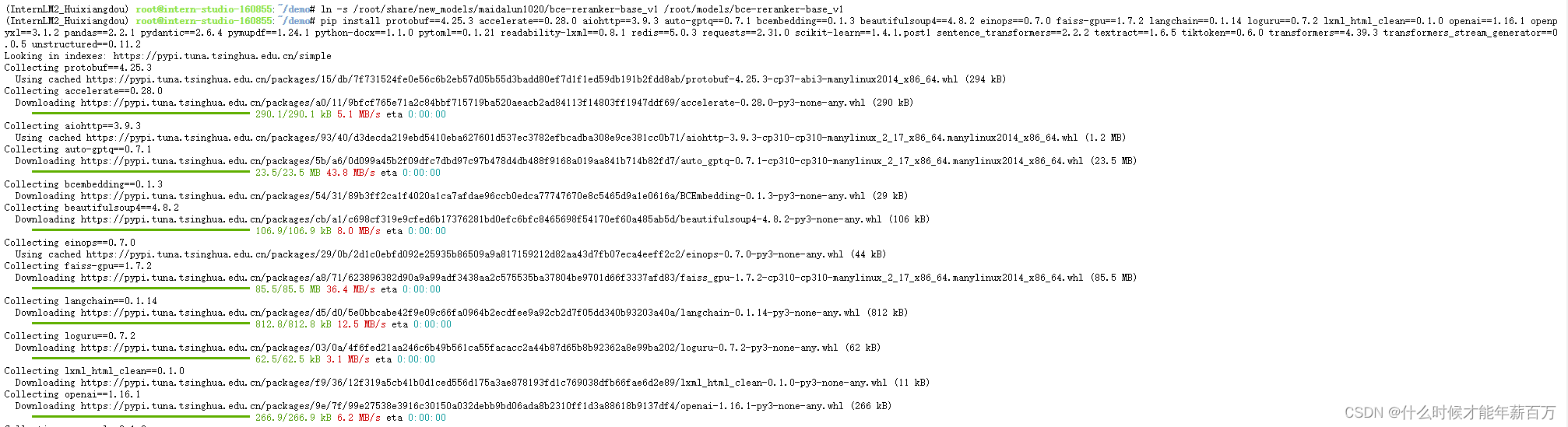

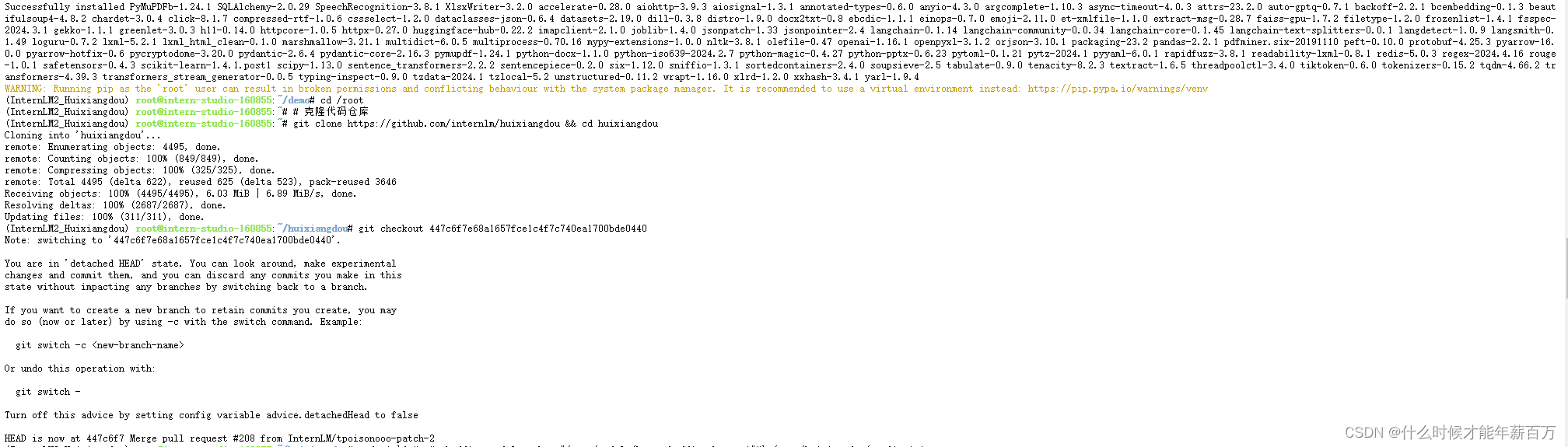

(2)安装茴香豆

(3)搭建RAG助手

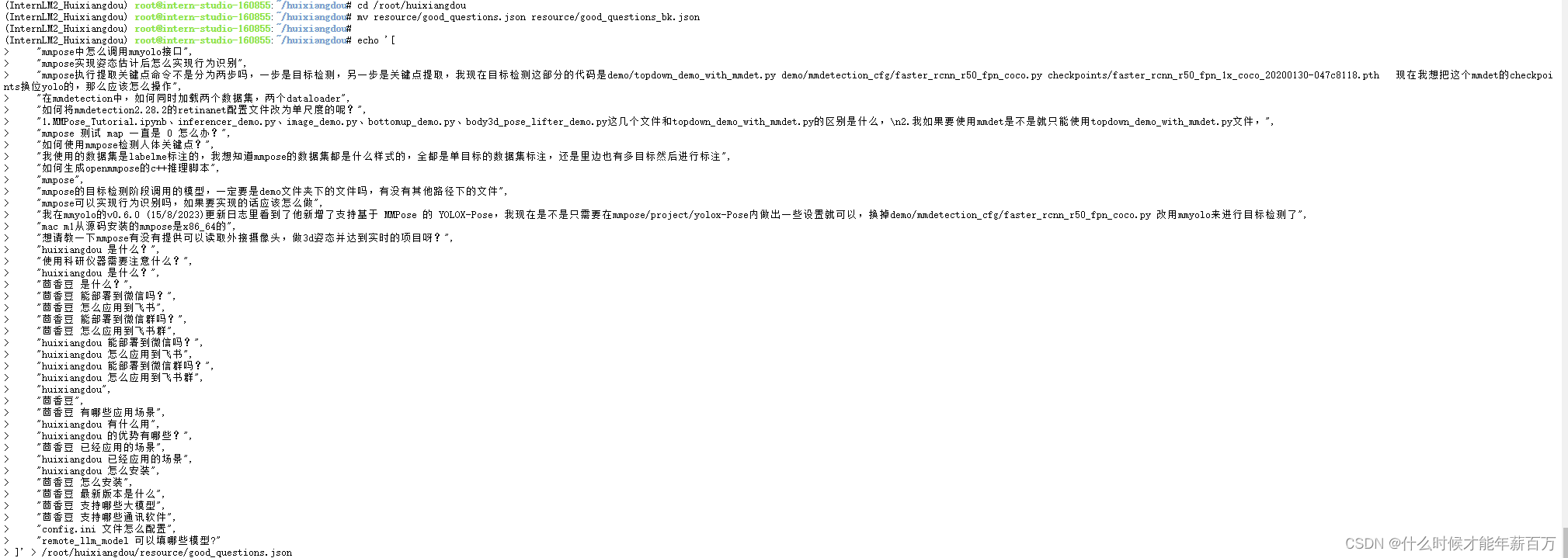

增加茴香豆相关的问题到接受问题示例中

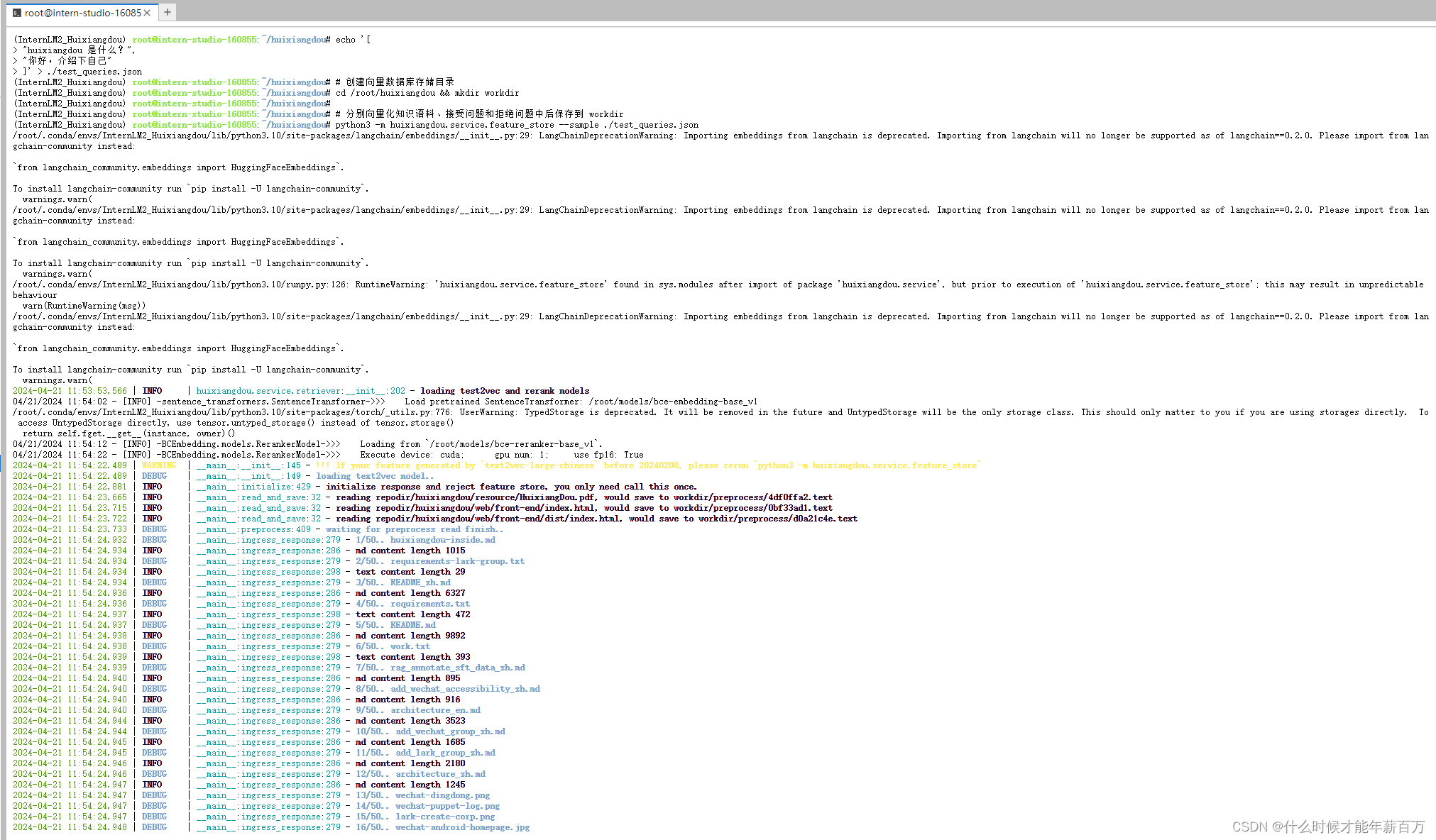

创建向量数据库

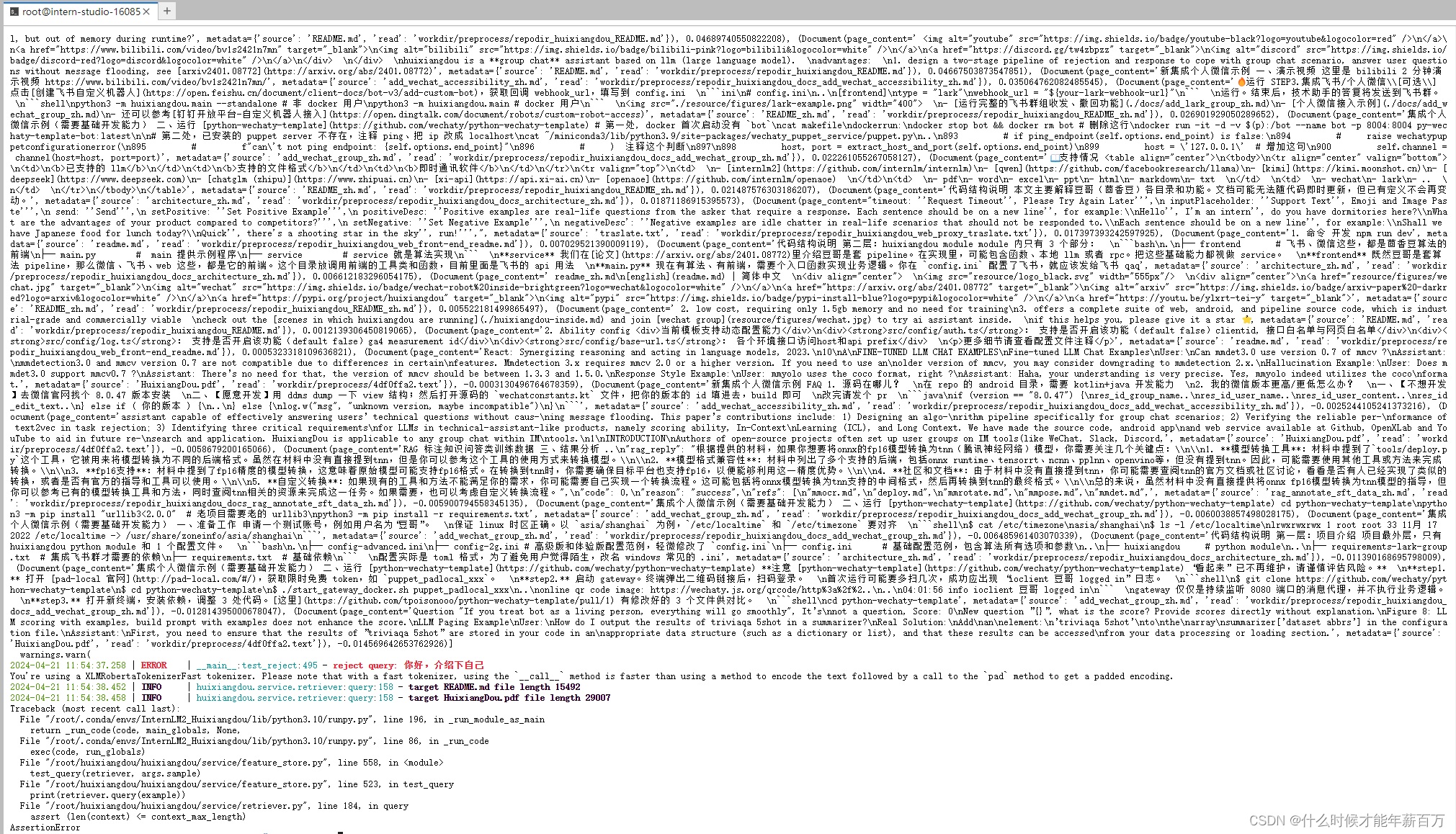

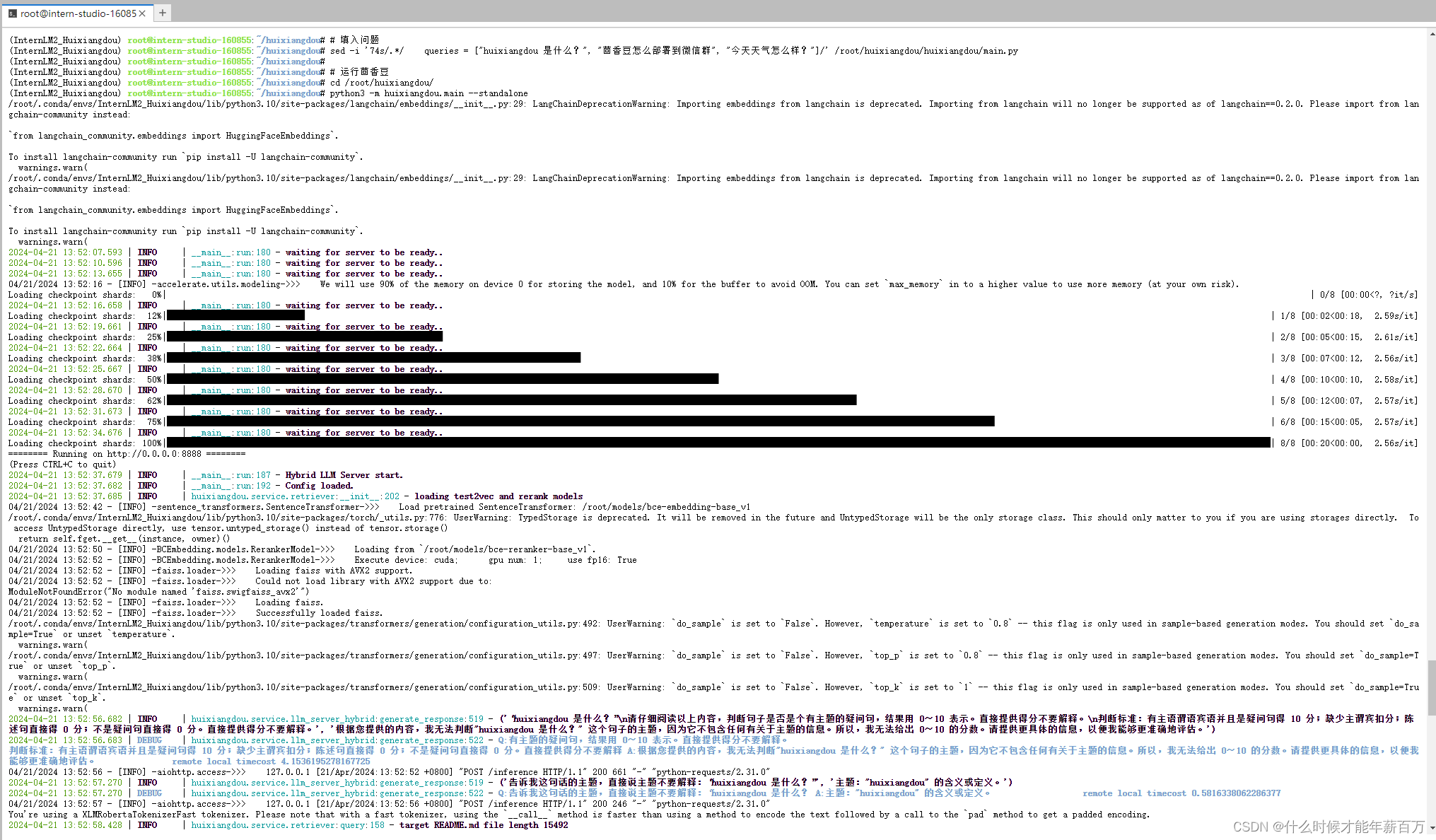

运行RAG知识助手

除了一个问题以外,其余两个都没有回答!!!

单独提问也无法正常回答:

369

369

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?