0.写在前面

目前Spark官方提供的最新版本3.2.0,是2021年10月份发布,但是该版本搭建Windows下环境,在使用spark-shell时,会报错,尚无解决方案(不知道现在解决没有)。所以我安装的是3.1版本

所使用的到的版本

spark 3.1.3

hadoop 3.2.1

scala 2.12 (注意,spark3.1.2不支持Scala2.13)

java 1.8

使用到的链接

scala官方下载

spark官方下载

hadoop官方下载

winutils下载

另所有使用的东西我都打包到

链接:https://pan.baidu.com/s/1fFEZmqUWZks-Hh5LkKRVww

提取码:1152

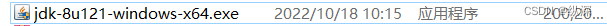

1.java环境

这里建议安装java8 不要装太高或者太低的版本

去官网上下载好 双击

点击下一步

本文详细介绍了如何在Windows上搭建Spark 3.1.3和Hadoop 3.2.1的环境,包括Java、Scala的安装与配置,以及winutils的获取。每个步骤都提供了下载链接和具体操作指南,适合初学者跟随操作。在搭建完成后,通过运行`spark-shell`验证了环境的正确性。

本文详细介绍了如何在Windows上搭建Spark 3.1.3和Hadoop 3.2.1的环境,包括Java、Scala的安装与配置,以及winutils的获取。每个步骤都提供了下载链接和具体操作指南,适合初学者跟随操作。在搭建完成后,通过运行`spark-shell`验证了环境的正确性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1375

1375

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?