《------往期经典推荐------》

二、机器学习实战专栏【链接】,已更新31期,欢迎关注,持续更新中~~

三、深度学习【Pytorch】专栏【链接】

四、【Stable Diffusion绘画系列】专栏【链接】

五、YOLOv8改进专栏【链接】,持续更新中~~

六、YOLO性能对比专栏【链接】,持续更新中~

《------正文------》

引言

2012年,深度学习领域经历了一次突破,推出了AlexNet,这是一种卷积神经网络(CNN),改变了图像分类。由Alex Krizhevsky、Ilya Sutskever和Geoffrey欣顿设计的AlexNet在当年赢得了ImageNet大规模视觉识别挑战赛(ILSVRC),其准确性比现有模型有了惊人的提高。AlexNet的表现不仅使CNN成为图像处理的强大工具,还引发了人们对深度学习的新兴趣。

AlexNet的关键细节

- 性能:AlexNet是专为2012年ILSVRC设计的,它实现了15.3%的前5名错误率,超过了次佳模型的26.2%的错误率。这一成功标志着CNN和更广泛的深度学习领域的关键时刻。

- 数据集:AlexNet在ImageNet数据集上进行训练,该数据集包含1,000个类别的120多万张图像。ImageNet的大规模数据集允许模型学习复杂的抽象特征,这表明CNN可以处理真实世界的图像数据。

AlexNet架构解析

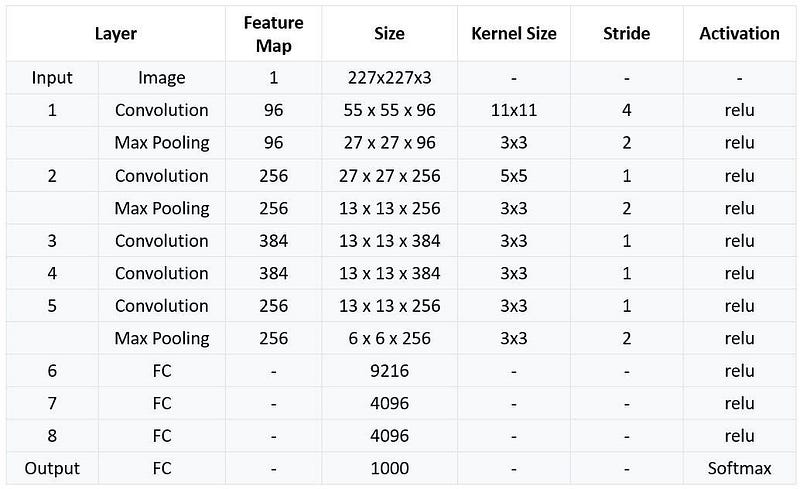

AlexNet由八层组成:五个卷积层,然后是三个完全连接的层。以下是其结构的分解:

- 输入层:模型将227x227 RGB图像作为输入。

- 第一卷积层:96个大小为11×11的过滤器,步长为4。它使用3×3内核和步幅2执行最大池化。

- 第二卷积层:256个大小为5 x 5的过滤器,pad=2,然后是最大池化。

- 第三、第四和第五卷积层:分别为384、384和256个过滤器,每个过滤器的核大小为3×3,pad = 1。

- 全连接层:最后三层是全连接的,前两层各有4096个神经元,最后一个输出层有1,000个神经元(用于1,000个类别的分类)。

AlexNet架构

AlexNet架构

AlexNet架构

AlexNet架构

每一层都使用ReLU激活函数来引入非线性,与LeNet等早期架构中使用的tanh或sigmoid激活相比,这提高了收敛速度。

AlexNet的主要创新

- ReLU激活:虽然LeNet使用tanh激活,但AlexNet引入了ReLU,它加速了收敛并减少了训练时间。

- GPU利用率:AlexNet是最早利用GPU并行性的深度学习模型之一,在训练中使用两个GPU来处理大型模型和数据集。

- Dropout正则化:AlexNet引入了Dropout,这是一种正则化技术,在训练过程中随机“丢弃”神经元以减少过度拟合。

- 数据增强:为了进一步减少过度拟合,AlexNet应用了随机裁剪和水平翻转等技术,显著扩展了有效数据集。

Lenet和Alexnet的比较

AlexNet代码实现

import tensorflow as tf

from tensorflow.keras import layers, models, datasets

import numpy as np

# Load and preprocess the CIFAR-10 dataset

(x_train, y_train), (x_test, y_test) = datasets.cifar10.load_data()

x_train, x_test = x_train / 255.0, x_test / 255.0 # Normalize the pixel values

# Define the AlexNet architecture

model = models.Sequential([

# First Convolutional Layer

layers.Conv2D(96, kernel_size=(11, 11), strides=(4, 4), activation='relu', input_shape=(32, 32, 3)),

layers.MaxPooling2D(pool_size=(3, 3), strides=(2, 2)),

# Second Convolutional Layer

layers.Conv2D(256, kernel_size=(5, 5), padding="same", activation='relu'),

layers.MaxPooling2D(pool_size=(3, 3), strides=(2, 2)),

# Third, Fourth, and Fifth Convolutional Layers

layers.Conv2D(384, kernel_size=(3, 3), padding="same", activation='relu'),

layers.Conv2D(384, kernel_size=(3, 3), padding="same", activation='relu'),

layers.Conv2D(256, kernel_size=(3, 3), padding="same", activation='relu'),

layers.MaxPooling2D(pool_size=(3, 3), strides=(2, 2)),

# Flatten and Fully Connected Layers

layers.Flatten(),

layers.Dense(4096, activation='relu'),

layers.Dropout(0.5),

layers.Dense(4096, activation='relu'),

layers.Dropout(0.5),

layers.Dense(10, activation='softmax') # CIFAR-10 has 10 classes

])

# Compile the model

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# Train the model

model.fit(x_train, y_train, epochs=10, batch_size=64, validation_data=(x_test, y_test))

# Evaluate the model

test_loss, test_acc = model.evaluate(x_test, y_test)

print(f'Test Accuracy: {test_acc:.4f}')

总结

AlexNet在2012年ImageNet竞赛中的胜利证明了CNN在解决复杂、大规模图像分类任务方面的潜力。通过构建LeNet的基本原则,并引入ReLU、dropout和基于GPU的训练等创新,AlexNet引发了一场深度学习革命。尽管今天的模型在深度和复杂性方面远远超过了AlexNet,但该架构的影响仍然是基础性的,为大规模图像识别任务中的卷积网络设定了标准。

好了,这篇文章就介绍到这里,喜欢的小伙伴感谢给点个赞和关注,更多精彩内容持续更新~~

关于本篇文章大家有任何建议或意见,欢迎在评论区留言交流!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?