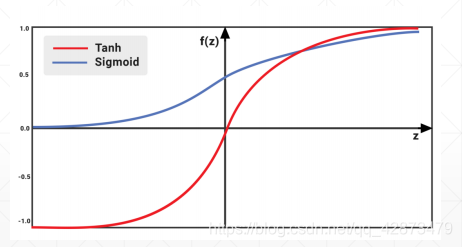

激活函数

- torch.sigmoid:范围在[0,1],光滑可导,但在趋近0和1时容易出现梯度离散。

- torch.tanh:范围在[-1,1]

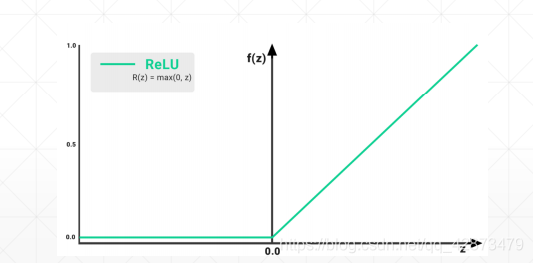

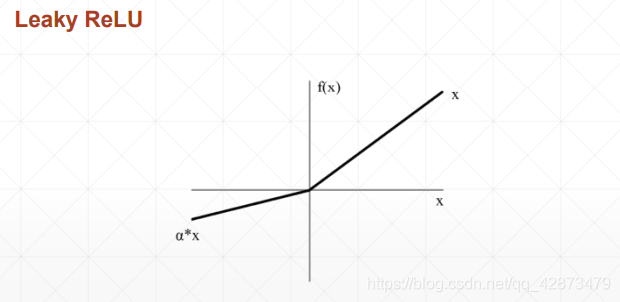

- torch.relu/F.relu:不可导,但计算简单常用

- F.softmax

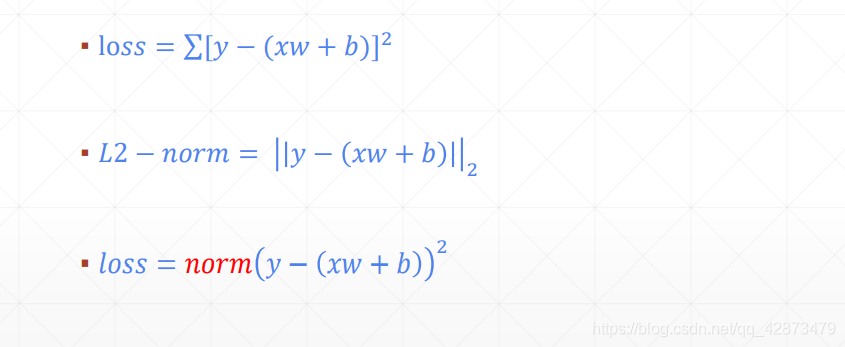

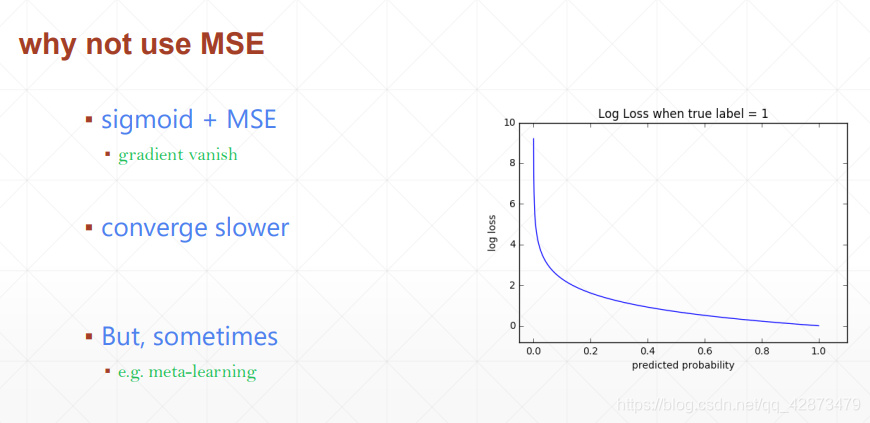

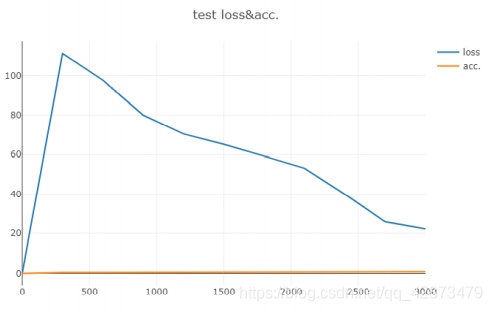

Loss及其梯度

MSE:

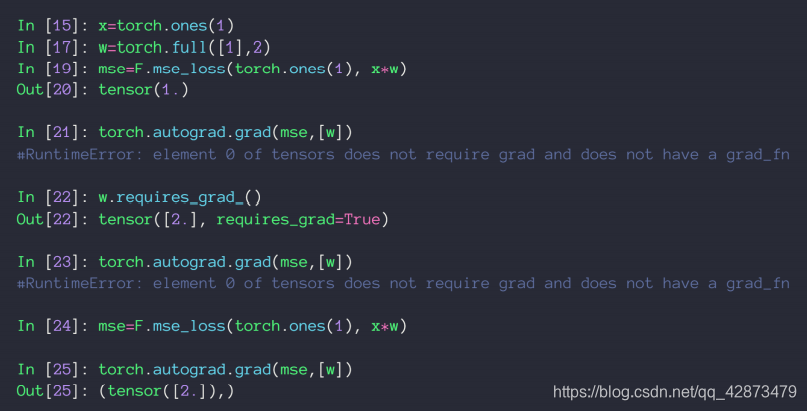

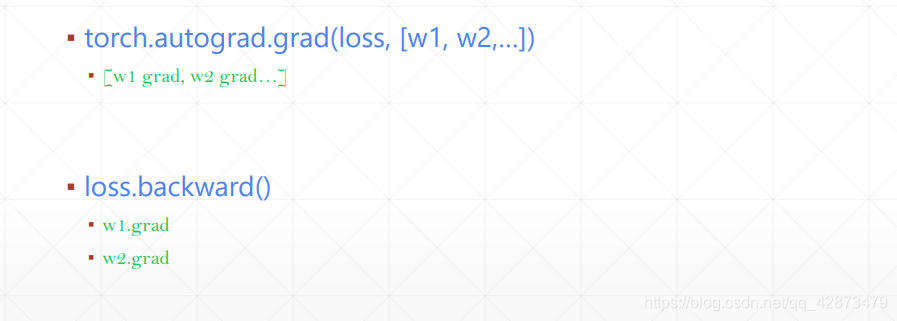

autograd.grad

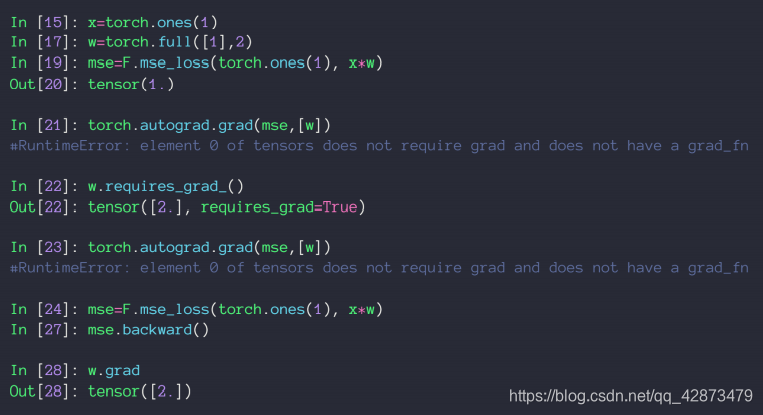

loss.backward

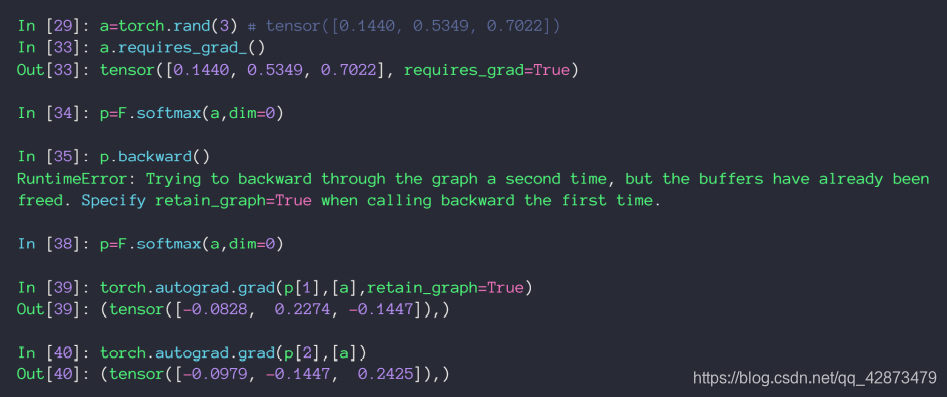

Gradient API

F.softmax

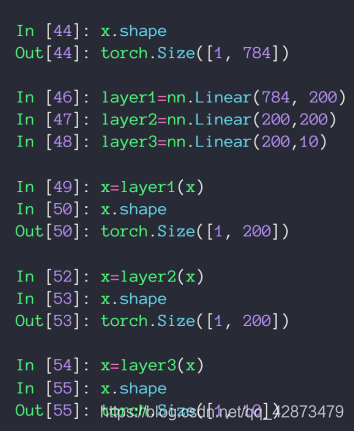

全连接层

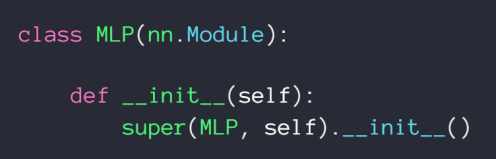

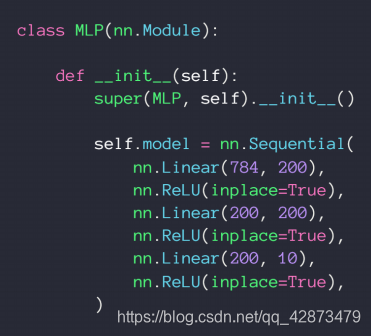

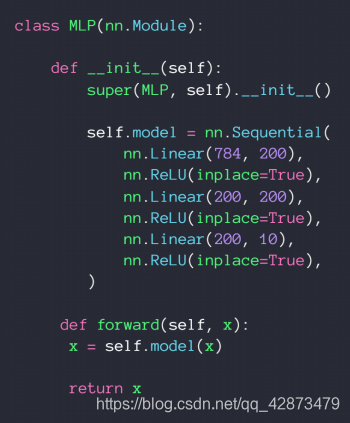

nn.layer

类方法:

step 1:

step 2 :

step 3:

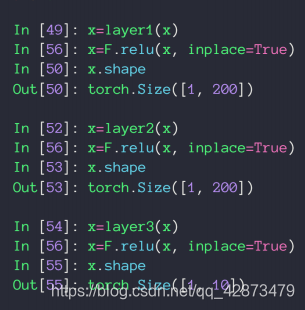

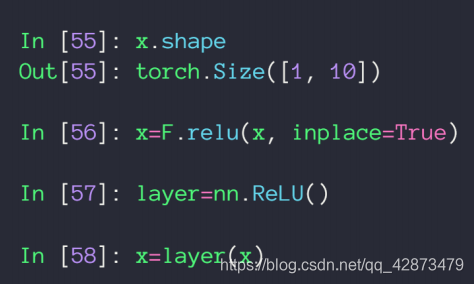

nn.ReLU VS F.relu()

nn.ReLU:class-style API 需要类实例化后使用,参数w和b由内部管理,不能私自访问,.parameters可以访问。

F.relu():function-style API 自己管理参数和运算过程。

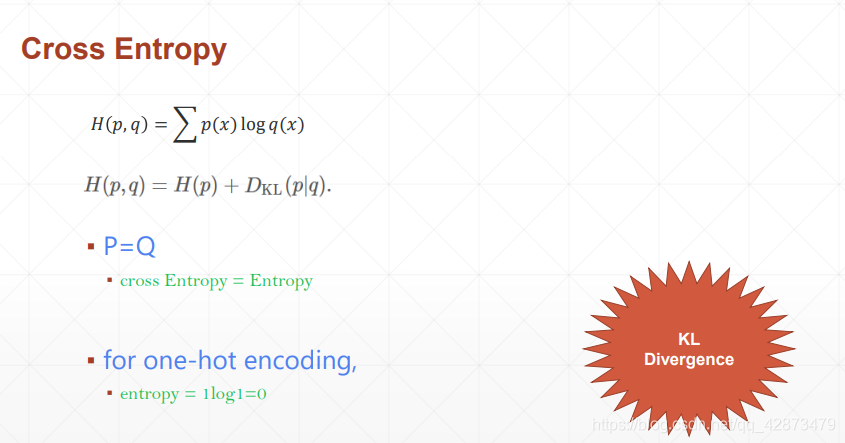

交叉熵

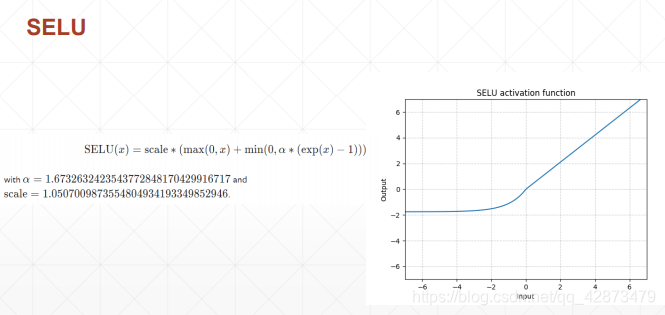

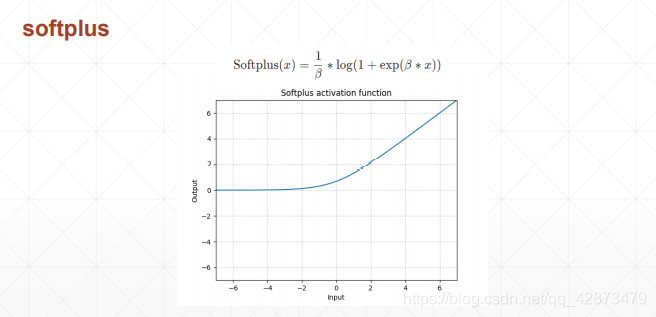

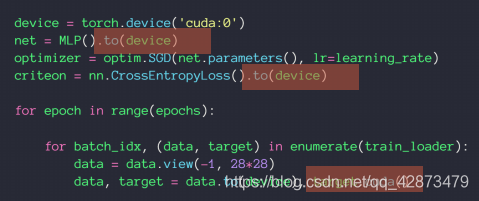

激活函数与GPU加速

GPU加速

Crossentropy:softmax,log,nn-loss

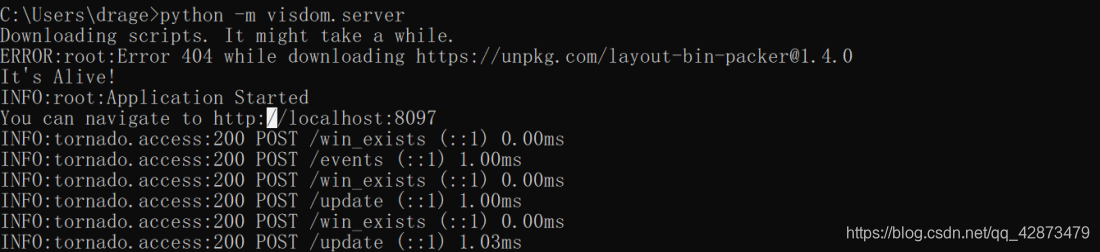

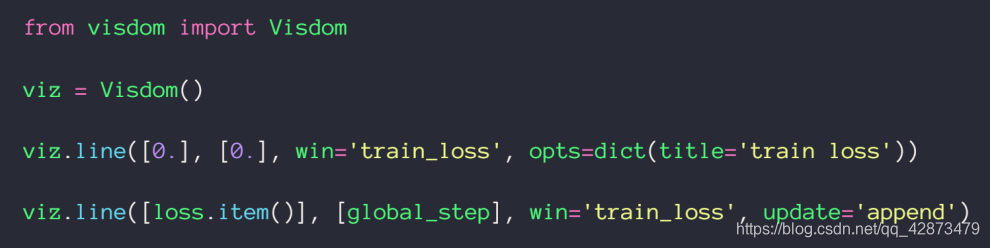

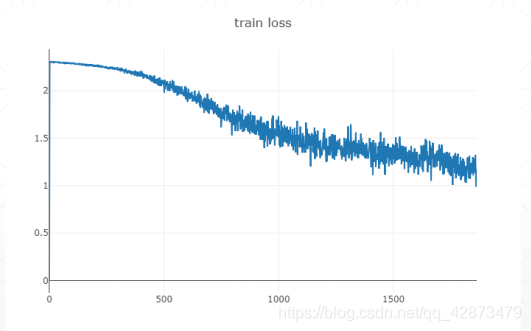

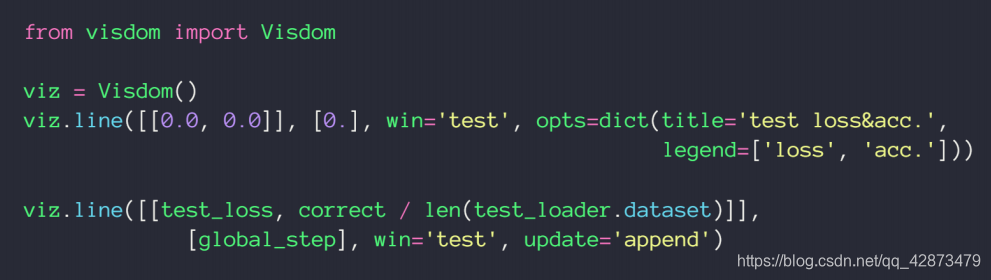

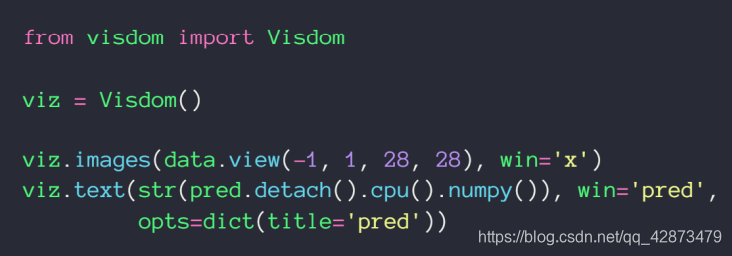

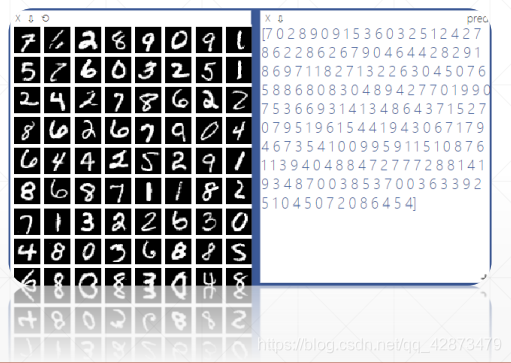

可视化

- pip install visdom

- run server damon

单线:

多线:

visual X:

1033

1033

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?