Zhang 等 - 2024 - Replacement Learning Training Vision Tasks with Fewer Learnable Parameters

全文摘要

本文介绍了一种名为“替换学习”的创新训练方法,旨在解决传统深度学习模型中参数冗余和资源低效的问题。该方法通过完全替换所有冻结层的参数为仅有两个可学习参数的方式来缓解这些问题,并利用相邻层的信息更新这些参数。实验结果表明,该方法不仅减少了参数数量、训练时间和内存消耗,还完全超越了端到端训练的性能表现。该方法在四个基准数据集上进行了验证,包括CIFAR-10、STL-10、SVHN和ImageNet,并使用了各种架构如CNN和ViT。

论文速读

论文方法

方法描述

本文提出的替换学习(Replacement Learning)是一种新的训练深度神经网络的方法。该方法通过周期性地冻结某些层的参数,并利用相邻层的参数更新这些被冻结的参数,从而减少了参数数量和计算复杂度,提高了模型性能。

具体来说,在传统的端到端训练中,所有层都参与优化过程,这导致了大量参数和高计算资源的需求。而替换学习则通过引入两个可学习的参数来平衡历史上下文和新输入之间的关系,同时只使用相邻层的参数来更新被冻结的层的参数,以达到减少参数数量和计算复杂度的目的。

方法改进

替换学习的核心思想是利用相邻层的参数来更新被冻结的层的参数。具体来说,对于每个被冻结的层,我们引入两个可学习的参数ai和bi,用于动态调整相邻层的贡献程度。在前向传播过程中,我们将被冻结层的参数替换为相邻层参数的整合结果;在反向传播过程中,被冻结层不参与梯度下降,而是将误差传递给相邻层并更新ai和bi的值。

解决的问题

替换学习解决了传统端到端训练中的三个主要问题:大量的参数、高的计算复杂度和GPU内存消耗。通过周期性地冻结某些层的参数,替换学习有效地减少了参数数量和计算复杂度,从而提高了模型性能。此外,替换学习还具有很强的适应性,可以无缝应用于不同深度和复杂度的架构,并在各种数据集上表现出色。这种适应性对于高效训练更深层次和更复杂的深度学习模型非常重要。

论文实验

本文主要介绍了使用四种广泛采用的图像数据集(CIFAR-10、SVHN、STL-10和ImageNet)进行实验的方法,并比较了使用替换学习和端到端训练的效果。具体来说,作者进行了以下对比实验:

-

CIFAR-10、SVHN和STL-10数据集上的实验:在这些数据集上,作者使用了不同的网络架构(ViT-B、ViT-L、ResNet-32和ResNet-110),并比较了替换学习和端到端训练的效果。结果表明,在所有情况下,替换学习都显著提高了测试准确性,并且可以减少GPU内存使用和训练时间。

-

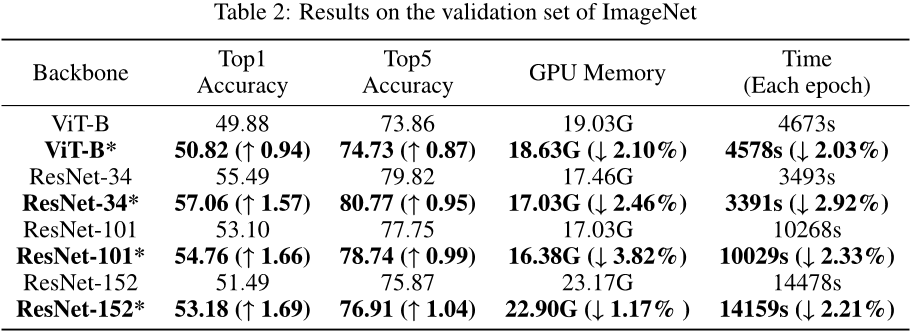

ImageNet数据集上的实验:在ImageNet数据集上,作者使用了四个不同深度的网络架构(ViT-B、ResNet-34、ResNet-101和ResNet-152),并比较了替换学习和端到端训练的效果。结果表明,替换学习可以提高Top1和Top5准确率,并且可以节省GPU内存和训练时间。

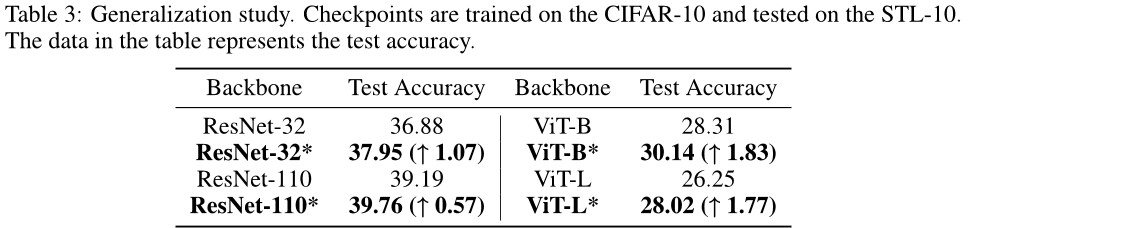

此外,作者还进行了特征分析、相似度分析和参数分析等实验,以进一步验证替换学习的有效性。最后,作者通过将CIFAR-10模型的检查点应用于STL-10数据集来评估替换学习的泛化能力,并发现替换学习可以显著提高测试准确性。

总之,本文通过多个实验得出了替换学习的有效性,并为未来的研究提供了参考。

论文总结

文章优点

该论文提出了一种名为“替换学习”的新颖学习方法,旨在解决深度学习模型在训练过程中计算时间和资源消耗的问题。通过冻结特定层并利用相邻层的参数更新这些层,替换学习可以有效地减少参数数量,并允许冷冻层从邻近层中获取信息。此外,该方法还引入了两个可学习的参数来平衡历史上下文和新输入,从而提高了模型的整体性能。实验结果表明,替换学习不仅减少了训练时间、GPU使用率,而且在整体性能方面优于端到端训练。

该论文的优点在于提出了一种新的学习方法,该方法可以在保持模型性能的同时降低计算成本和资源消耗。作者还通过实验证明了替换学习的有效性和优越性,这为其他类似问题的研究提供了启示。

方法创新点

该论文的主要创新点是提出了替换学习这一新颖的学习方法。替换学习的核心思想是将特定层冻结,并利用相邻层的参数更新这些层。这种机制可以通过两个可学习的参数来平衡历史上下文和新输入,从而提高模型的整体性能。此外,该方法还可以优化间隔设置以避免中断连续特征提取过程。这种方法与传统的反馈连接或前向梯度学习等替代反向传播技术不同,因为它能够更好地融合低级和高级信息,同时还能防止全局信息被丢弃。

未来展望

尽管替换学习已经在多个基准图像分类数据集上进行了广泛测试,并且在各种深度网络结构中表现出了强大的适应性,但仍然有一些限制需要在未来的工作中加以克服。例如,替换学习目前仅适用于图像任务,尚未扩展到自然语言处理或多模态设置中的大型模型。因此,在未来的工作中,研究人员计划探索替换学习在其他任务上的影响,以实现对其效果的更全面评估。此外,还需要进一步研究如何在替换学习中平衡历史上下文和新输入的比例,以及如何在不同的深度网络结构中调整替换学习的间隔设置。这些改进可能会使替换学习成为一种更加通用和有效的训练方法。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?