U-Net:用于生物医学图像分割的卷积网络

文章目录

前言

记录医学图像分割领域看的第一篇文章U-Net,包括翻译和知识点。

一、论文翻译

摘要:人们普遍认为,成功的深层网络训练需要数千个带注释的训练样本。在这篇文章中,我们提出了一个网络和训练策略,它依赖于强大的数据扩充来更有效地使用可用的注释样本。该体系结构包括一个用于捕获上下文的收缩路径(下采样)和一个支持精确定位的对称扩展路径(上采样)。我们证明这样的网络可以从很少的图像中进行端到端的训练,并且在电子显微镜堆栈中神经元结构分割的ISBI挑战方面优于先前的最佳方法(滑动窗口卷积网络)。利用同样的网络,我们在透射光显微镜图像(相衬度和DIC)上获得了2015年ISBI细胞跟踪挑战赛的冠军。而且,网络很快。在最近的GPU上,512x512图像的分割只需不到一秒钟的时间。全面实施(基于Caffe)和经过训练的网络可在原作者代码连接上获得。

(可以利用少量的数据学习到一个对边缘提取十分鲁棒的模型)

1 介绍

在过去的两年中,深卷积网络在许多视觉识别任务中的表现都超过了现有技术,例如[7,3]。虽然卷积网络已经存在很长一段时间了[8],但由于可用训练集的大小和所考虑的网络的大小,它们的成功是有限的。Krizhevsky等人的突破[7] 这是由于在ImageNet数据集上对一个有8层和数百万个参数的大型网络的监督训练,该数据集有100万个训练图像。从那时起,甚至更大更深的网络也得到了训练[12].

卷积网络的典型用途是分类任务,在分类任务中,图像的输出是一个单一的类标签。然而,在许多视觉任务中,特别是在生物医学图像处理中,期望的输出应该包括定位,也就是说,应该为每个像素分配一个类标签。此外,在生物医学任务中,成千上万的训练图像通常是遥不可及的。因此,Ciresan等人[1] 用滑动窗口训练网络,通过提供像素周围的局部区域(patch)来预测每个像素的类标签作为输入。首先,这个网络可以完成定位工作。其次,训练数据的patches方面远远大于训练图像的数目。由此产生的网络在2012年ISBI大会上以较大优势赢得了EM细分挑战赛。

显然,Ciresan等人的策略[1] 有两个缺点。首先,它非常慢,因为每个patch必须单独运行网络,并且由于重叠的patches,存在大量冗余。其次,在定位精度和上下文使用之间存在一个折衷。较大的patches需要更多的最大池化层,这会降低定位精度,而小patches只允许网络看到很少的上下文。最近的方法[11,4]提出了一种考虑多层特征的分类器输出。良好的定位和上下文的同时使用是可能的。

在本文中,我们构建了一个更优雅的体系结构,即所谓的“完全卷积网络”[9]。我们改进和扩展了这个体系结构,使得它只使用很少的训练图像,并产生更精确的分割;见图1。[9]FCN中的主要思想是用连续的层来补充通常的收缩网络,其中池操作被上采样操作符代替。因此,这些层提高了输出的分辨率。为了定位,收缩路径的高分辨率特征与上采样输出相结合。随后,一个连续的卷积层可以学习根据这些信息组装更精确的输出。

收缩路径用于获取上下文信息(context),扩张路径用于精确的定位(localization),且两条路径相互对称。收缩路径仍然是利用传统卷积神经网络的卷积池化组件,其中经过一次下采样之后,channels变为原来的2倍。扩张路径由2 * 2的反卷积,反卷积的输出通道为原来通道数的一半,再与原来的feature map(裁剪之后)串联,得到和原来一样多的通道数的feature map,再经过2个尺寸为3 * 3的卷积和ReLU的作用。裁剪特征图是必要的,因为在卷积的过程中会有边界像素的丢失。在最后一层通过卷积核大小为1 * 1的卷积作用得到想要的目标种类。在Unet中一共有23个卷积层。但是这个网络需要谨慎的选择输入图片的尺寸,以保证所有的Max Pooling操作作用于长宽为偶数的feature map。

每经过一个池化层就一个尺度,包括原图尺度一共有5个尺度。

我们架构中的一个重要改进是,在上采样部分,我们还有大量的特征通道,允许网络将上下文信息传播到更高分辨率的层。因此,扩展路径或多或少与收缩路径对称,并产生一个u形结构。该网络没有任何完全连接的层,只使用每个卷积的有效部分,即分割图仅包含在输入图像中可获得完整上下文信息的像素。此策略允许通过重叠-切片(overlap-tile)策略对任意大的图像进行无缝分割(参见图2)。为了预测图像边界区域的像素,通过对输入图像进行镜像操作来推断缺失的上下文信息。这种切片策略对于将网络应用于大图像非常重要,否则分辨率将受到GPU内存的限制。

数据集可以用数据量较少 对于我们的任务来说,训练数据很少,我们通过对可用的训练图像应用弹性变形来进行数据增强。使得网络能够学习这种形变的不变性,无需提供带注释的图像语料库(the annotated image corpus)供网络学习。这在生物医学分割中尤其重要,因为变形曾经是组织中最常见的变化,并且可以有效地模拟真实的变形。Dosovitskiy等人[2]在无监督特征学习的范围内已经证明了数据增强对于学习不变性的价值。

相同物体间的间隔不容易分割出来 许多细胞分割任务中的另一个挑战是分离同一类的接触目标;请参见图3。本文提出了一种利用加权损失的方法,其中接触单元之间的分离背景标签在损失函数中获得大的权重。以此方法提升对于相互接触的相同物体之间缝隙的分割效果。

所得网络适用于各种生物医学分割问题。在这篇论文中,我们展示了EM堆栈中神经元结构分割的结果(ISBI 2012年开始的一项持续竞争),我们的表现超过了Ciresan等人的网络[1] 。此外,我们展示了ISBI细胞跟踪挑战赛2015的光镜图像中的细胞分割结果。在这两个最具挑战性的二维透射光数据集上,我们以较大的优势获胜。

2 网络体系结构

网络体系结构如图1所示。它由收缩路径(左侧)和扩展路径(右侧)组成。收缩路径遵循卷积网络的典型结构。它包括重复应用两个3x3卷积(无填充卷积,unpadded convolution),每个卷积后面都有一个校正的线性单元(ReLU)和一个2x2最大池化操作,步长为2,用于下采样。在每个下采样步骤中,我们将特征通道的数量加倍。扩展路径中的每一步都包括对特征图进行上采样,然后进行2x2卷积(“上卷积”up-convolution),将特征通道数量减半,接着级联收缩路径中相应的裁剪后的特征图;再用两个3x3卷积,每个卷积后面都有一个ReLU。由于每次卷积都会丢失边界像素,因此有必要对特征图进行裁剪。在最后一层,使用1x1卷积将每个64维特征向量映射到所需数量的类。网络总共有23个卷积层。

为了允许输出分割映射的无缝拼接(请参见图2),选择输入切片(tile)的大小非常重要,这样所有2x2最大池操作都应用于具有偶数x和y大小的层。

3 训练

利用输入图像及其相应的分割图,利用Caffe的随机梯度下降实现训练网络[6]。由于未填充的卷积,输出图像比恒定边界宽度的输入图像小。为了最大限度地减少开销并最大限度地利用GPU内存,我们倾向于使用大的输入切片而不是大的批处理大小,从而将批处理减少到单个图像。相应地,通过使用高动量(high momentum,0.99)使得大量先前的训练样本在当前的优化步骤中更新。

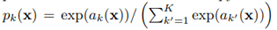

能量函数由最终特征图上的像素级soft-max结合交叉熵损失函数来计算。soft-max定义为

其中ak(x)表示在第x像素点上第k个特征通道的激活函数x∈Ω,具有Ω⊂Z2。K是类的数目,pk(x)是近似的

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1640

1640

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?