论文《Simplifying Temporal Heterogeneous Network for Continuous-Time Link Prediction》阅读

论文概况

本文是2023年CKIM上的一篇论文,该篇文章聚焦于使用简化的THN(时间异构网络)解决连续时间链路预测问题,提出了STHN( Simplifying THN for continuous-time link prediction)模型。

Introduction

作者提出了几个问题

- 现有动态异构图学习方法中采用的流行方法是基于捕获不同时间戳的图快照,尽管取得了进步(例如,在有效性方面),但大多数工作仍然仅限于离散时间设置。

- 由于维护多个快照所固有的高空间使用率和冗余,使用离散快照学习图动态无法扩展到大型网络。

- 静态异构网络研究已经研究了特定类型设计的效果,并且结果表明特定类型嵌入仅带来了微小的改进。然而,没有研究检验这些设计对动态异构的影响。

作者的发现:

(1)将历史交互拆分为不同的子网络打破了交互序列中最初存在的顺序,阻碍了模型捕获不同但邻近的关系之间的相关性。

(2)自注意力机制是关键的特征提取器,但在处理长交互序列时,其性能和有效性会下降。

作者的贡献:

(1)确定了预测时间异构网络上的链接的挑战,并提出了一种连续动态图学习方法。

(2)提出了STHN,一种不使用常见的特定类型设计并通过隐式合并结构异质性和时间信息来简化邻域聚合的新颖方法。

(3)为了增强STHN学习长交互序列的能力,应用了一种块技术,该技术可以保持局部语义邻近性,同时降低计算成本。

(4)提供了广泛的实验评估,将 STHN 与三个数据集的七个基线(来自三个不同类别)进行比较,并凭经验证明 STHN 在传导和归纳设置中收敛得更快,并且更准确地预测链接。

Method

STHN 模型由三个主要模块组成:

(1) 异构链路编码器:在将不同的连接特征(例如连接特征、连接类型和连接时间戳)编码到嵌入中。

(2) 语义块融合:总结时间交互序列的信息;

(3) 连接预测器:根据学习到的时间节点表示来预测两个节点之间是否存在连接。

A.异构链路编码器

类型编码

引入了隐式类型信号作为链接嵌入的一部分。链接类型集 R是类型的集合。因此,使用one-hot 编码 xR (𝑟) 作为产生和区分类型编码的方式,这种方式简单且易于泛化。

时间编码

相对时间编码函数 Φ : 𝑡 ′ → R 𝑑𝑡 将时间戳纳入训练中。目的是将相对时间戳值 𝑡 ′ = 𝑡𝑛 − 𝑡 从时域映射到 𝑑𝑡 维向量空间。

其中 𝑑𝑡 是时间编码的维度,并且 𝛼 = 𝛽 = √ 𝑑𝑡 。

映射函数 Φ 首先将相对时间 𝑡 ′ 映射到单调指数递减向量 𝑡 ′ × 𝜔 ε (0, 𝑡],然后使用余弦函数将向量 𝑡 ′ ×𝜔 的所有值投影到 [-1, 1] 。

对于以秒为单位的时间戳,需进行归一化:

𝑡 ′ = [𝑡 ′−Min(𝑡 ′ ) ] / [Max(𝑡 ′ )−Min(𝑡 ′ )]

在编码方程中引入一个超参数𝜇——时间戳的最大数值差: Φ(𝑡 ′ ) = cos(𝜇𝑡′ × 𝜔) 来区分时间编码。

给定类型嵌入和时间嵌入的输出,将它们与原始边缘特征 x edge (𝑒𝑖,𝑗 (𝑡), 𝑟) 连接成一个向量,并使用单层 Mlp 生成混合链接嵌入,如下所示:

编码器允许链路编码器接收和消化单个构建块中的隐式异构特征和时间信息,这在概念上更简单,并且可以简化网络设计,进而带来更好的通用性。

B.语义块融合

在传统的异构网络学习方法中,序列模型通常用于聚合相邻链接嵌入,其中逐点输入标记被馈送到训练网络中。然而,在处理长序列时,这种方法的效率和有效性可能会受到质疑。由于与远处的标记相比,附近的标记通常表现出更强的相关性,因此我们建议从专注于单个点级别进行转变,并在块(Patching)级别集成本地语义信息。

节点𝑢的输入交互序列S𝑢(𝑡𝑛)首先被划分为可以重叠或不重叠的块。

交互序列。对于节点𝑣,其在时间戳𝑡𝑛之前按时间顺序呈现的聚合历史时间信息被定义为交互序列: S𝑣 (𝑡𝑛) = {(𝑒𝑖,𝑗 (𝑡), 𝑟)|𝑣 = 𝑣𝑖 或 𝑣 = 𝑣𝑗 , 𝑡<𝑡𝑛}。

令 S𝑢 (𝑡𝑛) 的链接嵌入表示为 X𝑢 (𝑡𝑛) ∈ R |X𝑢 (𝑡𝑛 ) |×𝑑𝑆 ,其中块长度为 𝑝。整个序列将被分为 𝑝 长度的块,每个块都配备 𝑁 = |S𝑢 (𝑡𝑛 ) | /𝑝 互动。

最后,生成块X 𝑝 𝑢 (𝑡𝑛) ∈ R 𝑝×𝑁 ·𝑑𝑆 的序列嵌入。(交互序列一块的嵌入)

Transformer

使用 Transformer 编码器来提取重塑的块特征并将它们聚合在潜在表示空间中。

块 X 𝑝 𝑢 (𝑡𝑛) 的序列嵌入:首先通过 Transformer 输入 Sinput = LN(X 𝑝 𝑢 (𝑡𝑛)) 的层归一化 [1] 进行归一化

然后通过三个投影矩阵 W𝑄 映射到 Q、K、V 、W𝐾 和 W𝑉 ∈ R 𝑁 ·𝑑𝑆 ×𝑑𝑘 以及附加位置编码 W𝑝𝑒 ∈ R 𝑃×𝑑𝑘

矩阵 Q、K 和 V 是 Transformer 输入的中间表示,它们的行可以分别视为查询、键和值。

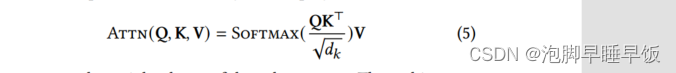

然后采用缩放的点积注意力层用公式5生成值向量的加权和。

Transformer编码器的架构由两部分组成:自注意力层和通道前向层,它们通过跳跃连接起来,其执行方式为:

其中 Soutput ∈ R 𝑃×𝑑𝑘 是 Transformer 编码器的输出。在这里,我们使用均值池化将 Soutput 压缩为单个向量 s 𝑢,𝑡𝑛 link ∈ R 𝑑𝑘 作为节点 𝑢 的链接表示。

块操作的应用实际上将 Transformer 中的令牌数量减少了 𝑁 倍,这反过来又使其适用于更长的序列输入。这种设计显着降低了计算成本,同时保留了模型的有效性。

C.时间链路预测器

在对链路进行预测之前,我们首先聚合节点特征并从节点的邻域捕获节点身份信息。与之前利用多跳邻居信息的模型不同,我们将 N (𝑢;𝑡𝑛, 𝑡) 定义为节点 𝑢 的 1 跳邻居,链接时间从 𝑡 到 𝑡𝑛。使用以下方法收集 1 跳邻域信息:

其中 𝑡𝑛 是对 𝑢 进行预测的时间戳。在这项工作中,不会从给定节点的所有邻居中提取信息。为了降低空间成本(即内存限制),对链接和邻居数量的最大值设置了界限。

在获得时间链接和节点的嵌入后,连接这些嵌入来预测时间 𝑡𝑛 处的链接存在性和链接类型。节点 𝑢 的表示是通过连接链接和节点嵌入获得的:

可以通过基于 MLP 的链接预测器检查两个链接时间嵌入来进行预测:

实验

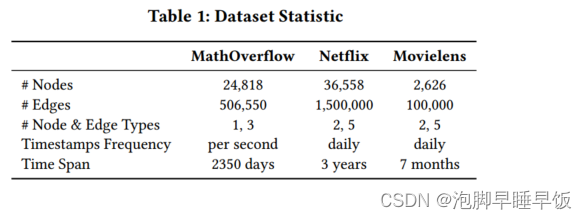

数据集

baseline

我们考虑两种不同的评估规则:

(1)传导链路预测任务允许训练后的模型使用训练后的所有传入链接进行验证和测试。

(2)归纳链路预测任务重点关注与训练阶段未观察到的节点相关的链接。

任务设计,有两种类型的链接:(i)新链接与新链接——即两个未观察到的节点之间的链接; (ii) 新链接与旧链接——即观察到的节点和未观察到的节点之间的链接。

STHN 与三组不同的 GNN 进行了比较。

(1)同质静态图神经网络方法。GraphSAGE [8] 是第一个归纳图学习方法,它利用邻域采样和消息传递来支持大规模 GNN 学习。 GAT [27] 将自注意力机制内化到 GNN 邻居聚合中。它通过计算注意力来研究邻居之间的相似性和权重。

(2)同质时间网络。 JODIE [16] 提出了一个连续同质时间网络,并引入了耦合 RNN,该 RNN 从一系列时间交互中学习节点的动态嵌入。 TGAT [35]提出解决时间相关图上的归纳表示学习问题,并概括了时间网络中的功能时间编码,从而消除了额外的序列模型(如 RNN)来捕获时间信息的需要。 TGN [22] 保持与 TGAT 相同的时间图建模,但在训练阶段涉及内存更新策略,该策略保存节点的历史状态并在每次新交互后更新其状态,并且还使得长期记忆成为可能图中节点的依赖关系。

(3)基于快照的动态异构网络。 DyHATR [39] 和 HTGNN [6] 将动态异构图划分为不同的快照,并应用两步策略(图编码器后跟序列模型)来提取这些快照之间的时空相关性。需要注意的是,DyHATR中使用的目标函数通过增加邻居的相似度来训练模型,这无法获得未见过节点的表示。因此,在归纳实验中省略了 DyHATR。

模型变体

提出了 STHN 的三个版本。

STHN-Type 是指在图编码器中集成了特定于类型的设计。

STHNTrans 是指原始交互序列被设置为 vanilla Transformer 的令牌输入,而无需块。

STHN-Patches 表示我们将交互序列划分为块,并通过语义块融合获得节点时间嵌入。

参数设置

所有模型都遵循相同的实验设置,使用 100 个隐藏维度进行时间编码、变压器编码器、Layernorm 和链接预测器。在提前停止之前,最多允许 20 个 epoch 的验证损失增加。

当达到最佳验证损失时,报告测试集 AUROC 和 AUPRC。

我们使用 PyTorch 1.13.0 和 128GB RAM 的 NVIDIA RTX 3090 实现了所有同构时间网络以及 STHN。

我们将小批量大小设置为600,最大训练周期为500。对于语义块融合模块,注意力头的数量为2,学习率的搜索范围为[1e-2,1e-4]。考虑到数据集的规模,MathOverflow、Netflix 和 Movielens 的交互序列的默认长度 𝐾 分别设置为 100、50 和 100,默认块长度 𝑁 为 5。

实验结果

消融实验

设计了两种变体

(a) 没有时间编码(STHN - w/o Time)

(b) 没有类型编码(STHN - w/o Type)

图 3 显示我们的模型优于其他变体。

STHN -w/o 类型变体带来了最显着的性能下降,表明时间信息的重要性。与此互补的是,类型信息对链接存在预测的贡献不大,但在链接类型预测中起着重要作用.该比较证明了时间链接编码器从历史交互序列中收集类型和时间信息的有效性。

影响性能的因素(参数实验)

分类不平衡的影响

在比较指标结果时,必须指出的是,对于链路类型预测任务,AUPRC 指标始终具有低于 AUROC 的值,而对于传统(即存在性)链路预测任务,它们的值接近。一般来说,这两个指标(AUROC 和 AUPRC)在分类任务中都很有用。然而,它们在分类器性能的评估方面有所不同。

AUROC 是精确召回曲线下的面积,用于衡量模型区分类别的能力。

AUPRC 评估不同阈值下精确率和召回率之间的权衡。在宏观平均模式下,独立计算每个类别的精度和召回率,然后进行平均。

它不考虑类别的权重,这使得 AUPRC 指标对类别不平衡更加敏感。

在图 4 中提供了 Movielens 数据集上的类分布和正确预测的比例。可以看出,不同类的预测精度值是不平衡的。例如,数据集所占比例较大的链接类型,例如 Movielens 中的链接类型 4,链接类型预测的准确度为 55.8%,而只有大约 1000 个数据点的链接类型 1 的链接类型预测准确度为 12.9%预言。尽管该模型在大多数类别上表现良好,但在对少数群体的分析上表现不佳,可能会降低平均准确率和召回率,从而降低 AUPRC 分数。

与Movielens相比,MathOverflow在链接类型预测任务中获得了更好的AUPRC分数,这也可以从图4中看出,表明STHN对于MathOverflow链接类型2和3获得相对较高的准确率。

交互序列和块的长度对结果的影响

系统地分析 STHN 块步骤中使用的超参数的影响,包括最近邻居数量 𝐾 和块长度 𝑁,如表 4 所示。实验在 AUROC 度量上使用模型 STHN-Patch 和 STHN-Trans 的三个数据集上进行,结果总结在表 4 中。在所有情况下,我们在 {50, 100, 200} 内搜索 𝐾,并在 {5, 10} 内搜索补丁长度 𝑁。首先,我们观察到,当交互序列的长度增加时,vanilla Transformer 的性能往往会下降,例如,当 𝐾 增加到 200 时,Netflix 数据集上的 STHN-Trans 的 AUROC 分数将下降到 92.06。

Transformer 由于它完全连接的注意力机制,被设计为对全局依赖关系进行建模。但在实践中,它很难处理长序列,并且可能与某一特定点建立紧密的联系,而忽视了长期依赖性。然而,STHN-Patch 将长序列划分为块,其中信息以块级别收集。它帮助 Transformer 编码器捕获全面的语义信息。。

效率问题

为了比较模型训练的实际计算效率,收集了本研究涉及的模型的模型参数、平均历元训练/预测时间和 GPU 内存使用情况,并在表 5 中显示了统计数据。

由于同构网络的模型设计相似,他们获得相似的可训练参数以及训练时间。

由于TGN配备了内存更新器来存储长期信息,因此TGN的预测时间明显长于其他模型。

与相比STHN-Type和STHN-Trans、STHN-Patch通过放弃常用的特定类型设计并将块技术与Transformer信息融合相结合,简化了架构设计。由于简单性,GPU 内存使用数据表明我们的 STHN 使用最少的 GPU 内存,并且在所有时间网络中享有最快的预测速度。

HTGNN 表现出快速的训练和预测时间,因为它是一种基于快照的模型。然而,其内存要求仍然高于 STHN-Patch,并且如前所述(参见表 2 和表 3),其有效性低于 STHN-Patch。

为了进一步比较模型在训练效率和有效性方面的性能,在图 6 中,我们显示了 MathOverflow 数据集上时间网络的平均 epoch 训练时间和测试 AUROC 分数。如图所示,STHN 是模型性能和训练速度之间的最佳权衡。

从效率和效果的角度来看,DyHATR 未能完成链路预测任务。最后,图 5 比较了 STHN 和基线模型的收敛速度。由于我们采用 20 时期的提前停止正则化,因此训练时期的数量因模型而异。从图 5 的顶行可以看出,STHN 具有很快的收敛速度,并且在训练过程的一开始就实现了较低的损失值。异构链接编码器将 STHN 与其他时间网络分开,使其能够提取有意义的信息并更快地收敛于链接预测任务。

相关工作

动态异构图学习是更广泛的图学习范式中的一个热门话题,其结果对于大量下游任务非常有用,例如不断发展的 Android 恶意软件检测 [5]、引文预测 [7,13,36]、金融时间序列预测[34]、阿片类药物过量预测[32]、实时事件预测[17]——仅举几例。为了获得更广泛的概述,我们建议读者参阅最近关于动态图学习的调查[25,28,38]。根据更新方式,动态异构图方法可以分为离散模型和连续模型(参见[38])。

离散动态异构网络

离散时间动态异构图学习受到最初为静态设置开发的 GNN 的启发。为了嵌入图更新之间的时间依赖性并捕获图结构的演化模式,最直观的方法是将变化的图分割成不同的快照,并从一系列演化的异构图快照中学习节点表示。离散异构图学习中使用的方法[change2vec,HTGNN,DGNI,HINTS,DySAT,THGNN]可以被认为源于两个角度:图编码器和序列模型。具体来说,同构 GNN(例如 GCN [15] 和 GAT [27])首先被用作图编码器,为每个快照嵌入具有特定时间戳的图结构信息。然后,模型通过使用序列模型(例如 RNN 或注意力)收集指定时间戳的节点表示来获得节点嵌入。然而,离散动态模型有两个主要缺点。首先,时间戳 {1, . 。 。分割快照的 , 𝑡 } 是预定义的,并且仅在特定的第 (𝑡 +1) 个快照上进行链接是否出现的预测,这限制了模型必须基于时间戳 {2 的数据重新训练, . 。 。 , 𝑡, 𝑡 +1} 如果我们尝试预测第 (𝑡 + 2) 个快照。大多数离散异构图方法缺乏归纳学习能力,只能处理传导任务,因为它们需要重新训练来推断未见节点的嵌入[35]。其次,特定类型的聚合器通常以离散模型设计,以组合来自属于同一类型的链接的信息。这意味着聚合器的数量等于链接类型的数量。

堆叠聚合器给异构图学习带来了高昂的计算成本[28],并且对于具有多种链接类型的演化图来说,这些成本很快就会变得过高。

连续动态图学习

连续时间图学习(例如,时间网络[20])方法通常局限于同质设置,其中边缘由时间标记。与离散时间图学习相比,在连续时间动态图学习中,时间图是通过以流式方式添加的新节点和边来构造的[37, 38]。每个交互(边缘)都用特定的时间戳进行注释。 CTDNE [20] 是第一个基于时间随机游走学习时间相关图表示的框架。 JODIE [16] 通过耦合 RNN 学习用户和物品的嵌入轨迹。然而,上述模型仅在最终状态下生成图的嵌入,这对于归纳图学习任务来说是不可扩展的。为了解决这个问题,TGAT [35]和TGN [22]通过混合GraphSAGE [8]和GAT [27]引入了时间图注意力层。如前所述,这些类型的时间网络专注于对同质图进行建模,忽略节点和/或链接中异质性的情况。我们注意到DDHGNN将连续动态与异构图学习结合起来,目标是阿片类药物过量预测,并在这项任务上展示了强大的性能。我们的 STHN 更通用,重点关注转导和归纳设置中链接预测的存在和类型。 STHN的主要区别在于它如何简化架构设计并提高有效性和效率.

总结

论文提出了STHN——一种结合节点和链路的异构性以及时间维度的连续粒度的新颖方法,用于在不断演化的异构网络中进行链路预测。假设节点和链路类型的同质性可能对许多实际领域产生限制,并且离散时间演化模型阻碍了连续推理的可能性。结构异质性和时间信息的隐式结合使得 STHN 很容易推广到不同的领域/设置。作为未来工作的一部分,将研究不仅预测链接的出现,而且预测其(最小)持续时间。

3581

3581

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?