1.动态注意网络(DCN):

1.1 encoder

查询术语序列向量表示(GloVe): (

x

x

x

Q

^Q

Q

1

_1

1,

x

x

x

Q

^Q

Q

2

_2

2,…,

x

x

x

Q

^Q

Q

n

_n

n)

文档术语序列向量表示(GloVe):(

x

x

x

D

^D

D

1

_1

1,

x

x

x

D

^D

D

2

_2

2,…,

x

x

x

D

^D

D

m

_m

m)

使用LSTM编码文档:

d

d

d

t

_t

t=

L

L

L

S

S

S

T

T

T

M

M

M

e

_e

e

n

_n

n

c

_c

c(

d

d

d

t

_t

t

−

_-

−

1

_1

1,

x

x

x

D

^D

D

t

_t

t)。文档编码矩阵:

D

D

D = [

d

1

d_1

d1…

d

m

d_m

dm,

d

∅

d_∅

d∅] ∈

R

R

R

l

^l

l

×

^×

×

(

^(

(

m

^m

m

+

^+

+

1

^1

1

)

^)

)。

d

∅

d_∅

d∅为哨兵向量,它允许模型不关注输入中的任何特定单词。

question编码:

q

q

q

t

_t

t=

L

L

L

S

S

S

T

T

T

M

M

M

e

_e

e

n

_n

n

c

_c

c(

q

q

q

t

_t

t

−

_-

−

1

_1

1,

x

x

x

Q

^Q

Q

t

_t

t)。question编码矩阵:

Q

Q

Q

’

^’

’= [

q

1

q_1

q1…

q

n

q_n

qn,

q

∅

q_∅

q∅] ∈

R

R

R

l

^l

l

×

^×

×

(

^(

(

n

^n

n

+

^+

+

1

^1

1

)

^)

),考虑到question编码空间和文档编码空间之间的差异,引入了非线性投影层映射question:

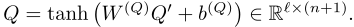

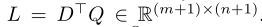

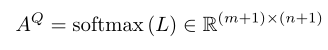

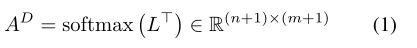

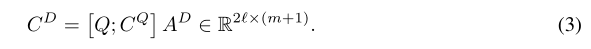

1.2coattention encoder

1.计算相似度矩阵:

2.document-to-question (行)注意力权重

A

A

A

Q

^Q

Q:

3.question-to-document(列)注意力权重

A

D

A^D

AD:

4.接下来,根据question的每个单词计算文档的摘要或注意上下文:

5.同样根据文档中的每个单词来计算问题的摘要:

C

D

C^D

CD =

Q

Q

Q

A

A

A

D

^D

D,还根据文档中的每个单词计算先前注意上下文的摘要

C

Q

C^Q

CQ

A

A

A

D

^D

D。这两个操作可以并行完成:

6.最后的

C

D

C^D

CD就为共同感知的question和document表示,然后通过bi-lstm融合时间信息:

所以有:

这为选择哪个跨度可能是最好的可能答案提供了基础。

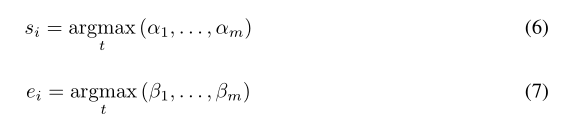

1.3动态指向解码器

给定一个问题-文档对,文档中可能存在几个直观的答案区间,每个对应于一个局部最大值。本文提出了一种迭代技术,通过在预测起点和预测终点之间交替来选择答案跨度。如图三所示

它类似于一个状态机,其状态由基于LSTM的顺序模型来维护。在每次迭代期间,解码器考虑到对应于开始和结束位置的当前估计的潜在编码来更新其状态,并通过多层神经网络产生开始和结束位置的新估计。让

h

i

h_i

hi、

s

i

s_i

si和

e

i

e_i

ei分别表示为迭代

i

i

i期间LSTM的隐藏状态、初始位置的估计和结束位置的估计。然后LSTM状态更新为:

它类似于一个状态机,其状态由基于LSTM的顺序模型来维护。在每次迭代期间,解码器考虑到对应于开始和结束位置的当前估计的潜在编码来更新其状态,并通过多层神经网络产生开始和结束位置的新估计。让

h

i

h_i

hi、

s

i

s_i

si和

e

i

e_i

ei分别表示为迭代

i

i

i期间LSTM的隐藏状态、初始位置的估计和结束位置的估计。然后LSTM状态更新为:

其中

u

u

u

s

_s

s

i

_i

i

−

_-

−

1

_1

1和

u

u

u

e

_e

e

i

_i

i

−

_-

−

1

_1

1是对应于前一次估计的编码

u

u

u的开始和结束位置的表示,给定当前隐藏状态

h

i

h_i

hi、先前开始位置

u

u

u

s

_s

s

i

_i

i

−

_-

−

1

_1

1和先前结束位置

u

u

u

e

_e

e

i

_i

i

−

_-

−

1

_1

1,我们估计当前开始位置和结束位置:

其中

α

α

α和

β

β

β代表对应于文档中第一个单词的开始分数和结束分数。用单独的神经网络计算

α

α

α和

β

β

β。这些网络具有相同的体系结构,但不共享参数。

本文提出了Highway Maxout Network (HMN)来计算由等式描述的

α

α

α和

β

β

β:

这里,

u

u

u

t

_t

t对应于文档中第

t

t

t个单词的字符编码。结束分数

β

t

β_t

βt的计算类似于开始分数

α

t

α_t

αt,但使用单独的

H

H

H

M

M

M

N

N

N

e

_e

e

n

_n

n

d

_d

d。

HMN模型:

结果

SQuAD:

1.DCN

EM:66.2 F1:75.9

2.BiDAF:

EM:73.3 F1: 81.1

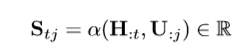

BiDAF的双向attention

1.建立相似度矩阵

S

S

S∈

R

R

R

T

^T

T

×

^×

×

J

^J

J(

H

H

H:context(

T

T

T长)

U

U

U:question(

J

J

J长)):

2.Context-to-query Attention.:

a a a t _t t = softmax( S t S_t St : _: :)∈ R J R^J RJ

U ’ U^’ U’= a a a U U U∈ R R R d ^d d × ^× × T ^T T

3.Query-to-context Attention:

b b b = softmax( m m m a a a x x x c _c c o _o o l _l l( S S S)) ∈ R T R^T RT

H

’

H^’

H’=

b

b

b

H

H

H∈

R

R

R

d

^d

d

最后扩展为

T

T

T行:

H

’

H^’

H’∈

R

R

R

d

^d

d

×

^×

×

T

^T

T

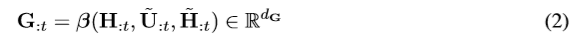

4.融合上下文:

β

β

β计算为:

model

encoder

1.300维的GloVe+200维的char。

2.连接送入两层高速公路网络

Embedding Encoder Layer

上图右:

总共一个block:[convolution-layer×

n

n

n + self-attention-layer + feed-forward-layer]

Context-Query Attention Layer

1.构建相似度矩阵(方法同BiDAF)

2.计算attention(方法同DCN)

Model Encoder Layer

3个Model encoder block ,每个Model encoder block 由7个encoder block堆叠而成。

output layer

与BiDAF相同

结果

速度更快,EM/F1更高。

2770

2770

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?