文章目录

正文

Performance analysis

本节将展示该算法的结果,该算法的平均时间惩罚在最优性的 O ( 1 / V ) O (1/V) O(1/V)以内,并且在平均队列大小上有相应的 O ( V ) O (V) O(V)权衡。

Average penalty analysis 平均惩罚分析

Average queue size analysis 平均队列大小分析

Probability 1 convergence

Application to queues with finite capacity

Treatment of queueing systems

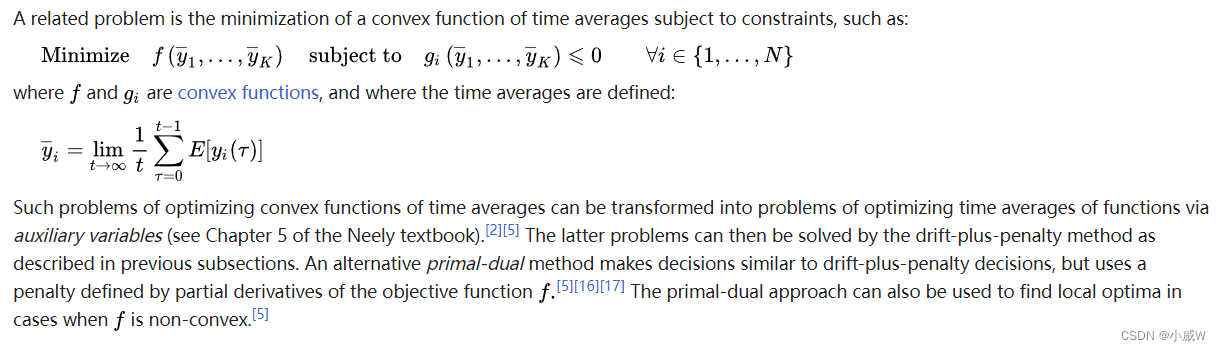

Convex functions of time averages

Delay tradeoffs and related work

Extensions to non-i.i.d. event processes

Extensions to variable frame length systems

Application to convex programming

Drift-plus-penalty algorithm for convex programming

Drift-plus-penalty algorithm for linear programming

1421

1421

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?