安装

以下是必要安装的东西链接:

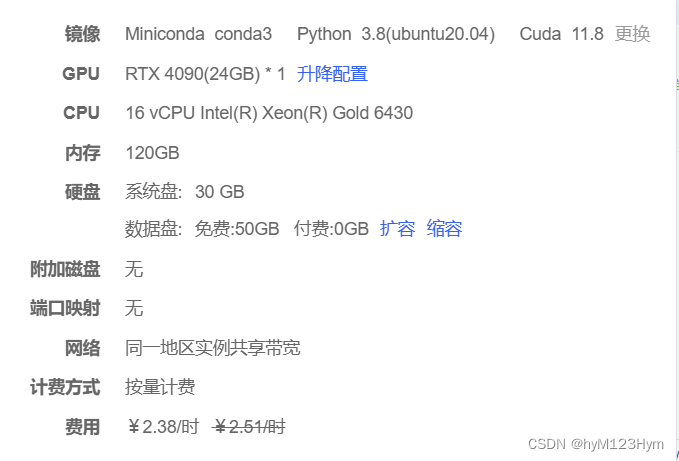

首先,我是在autodl上跑的,最初所选环境如下

然后就开始愉快的按照原文指引步骤开始装包,直到这一步踩进第一个坑:

python setup.py install`

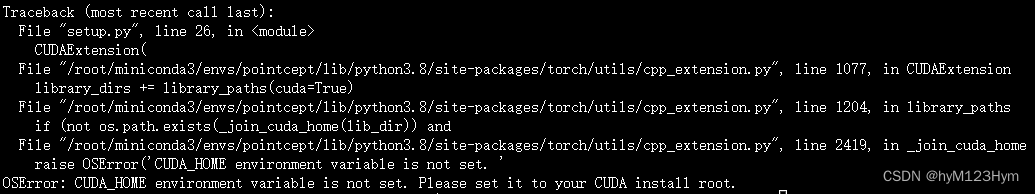

我的报错如下:

最开始以为是环境变量的问题,我寻思autodl是自带cuda和cudnn的,不应该啊,我也自行添加了但没用,后面也试了很多方法都没用,后面再autodl里把环境换了就好了,如下所示:

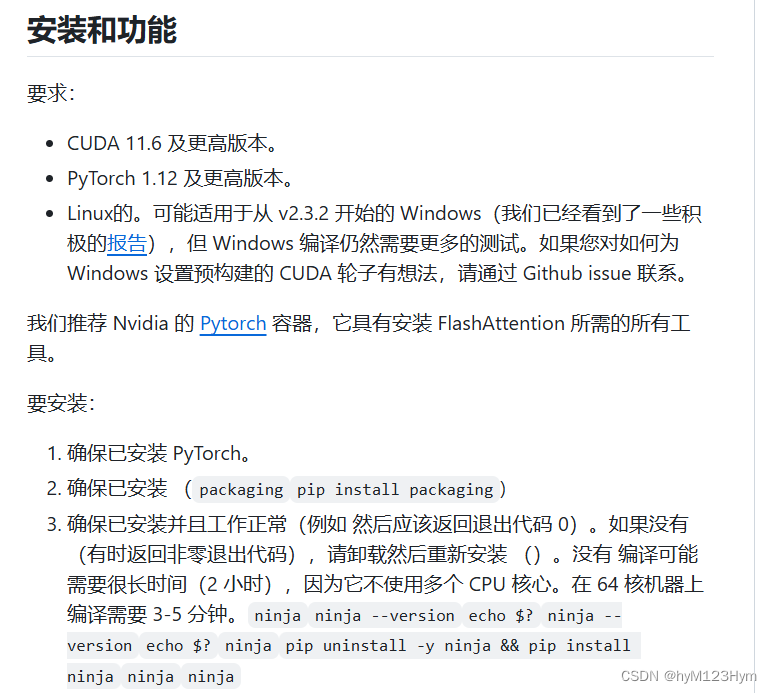

好了,接下来两个包都没问题,到了下Flash-attention这里开始踩第二个坑!!

首先看清楚他的要求,务必严格执行!

这里要注意的是如果要照着他这个下的话,一定要下ninja,且需要以下两个命令进行检查(第二命令输出是0才正常)!

ninja --version

echo $?

然后我在准备工作都齐全,以为不会出错的时候,它还是来了,这里我没有截出错的图,大概是它一直build,给我build了几个小时都没反应,后来查了才知道是代理问题,因为我不知道怎么在autodl上开梯子,所以直接在https://github.com/Dao-AILab/flash-attention/releases上找到适合自己环境的whl文件进行下载,再上传autodl。

数据集准备

跑PTv3的话,要先注意作者他们有没有配对应的配置文件!!!

我是配完了SemanticKITTI,才发现他没给v3的配置文件,就很难受,不知道后续会给不

这里有作者pointcept代码库里的说明:https://github.com/Pointcept/Pointcept#data-preparation

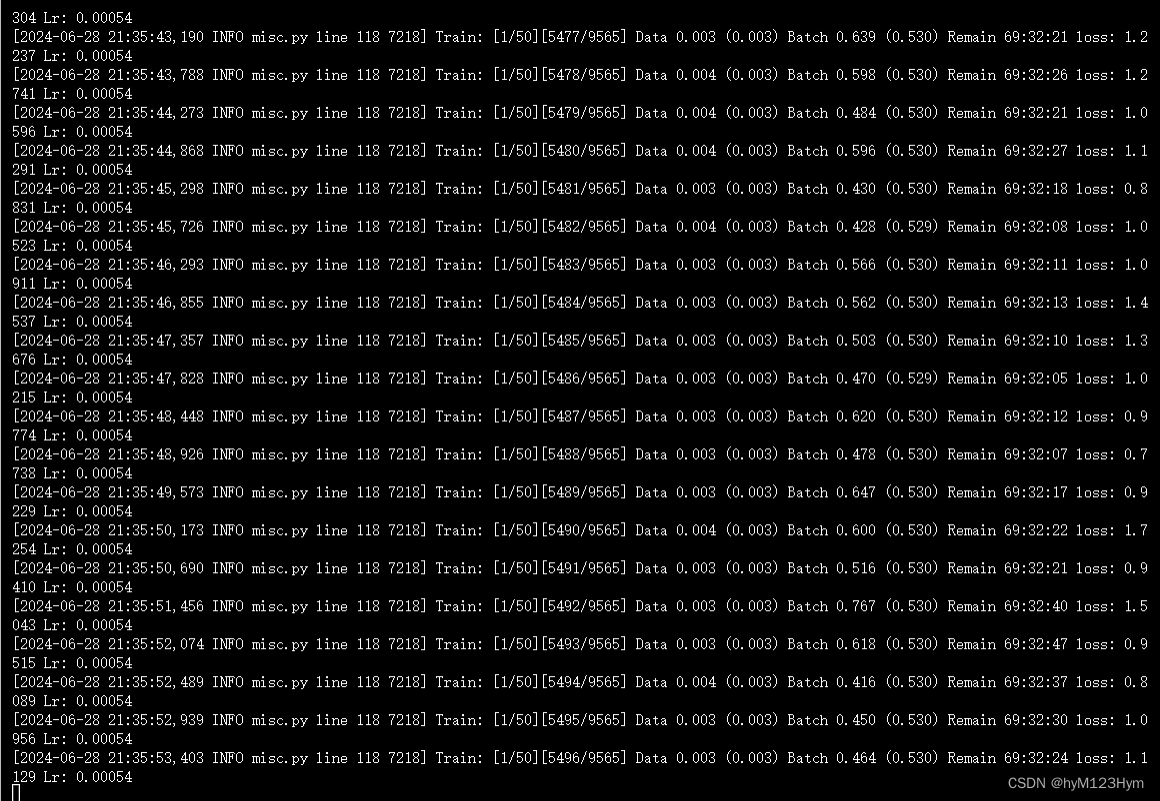

训练

按照他给的如下进行运行:

export CUDA_VISIBLE_DEVICES=0,1

# Script (Recommended)

# 这里配置文件是用的v2的,只是测试是否可以跑

sh scripts/train.sh -p /root/miniconda3/envs/pointcept/bin/python -g 2 -d semantic_kitti -c semseg-pt-v2m2-0-base -n PTv3_SemanticKITTI_test1

我这里只有两张gpu,所以CUDA_VISIBLE_DEVICES设置为0,1,建议按照他跑的样式给4或8张,我用的两张,batch_size设的12。

4007

4007

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?