【开篇】HA概述与实现

HDFS 是一个分布式文件系统,有namenode和datanode,我们都知道,

一旦namenode荡机,整个集群就会瘫痪,那么这个问题怎么处理?

一般我们都会有两个namenode,我们知道有一个secondary namenode,但是我们知道这个namenode并不能执行namenode的功能,他只是帮namenode做操作日志的合并,所以我们需要另一种部署模式,即HA部署模式

HA部署模式,是一种高可用部署模式,也就是一天24小时都在工作,他有两个namenode。namenode记录的是元数据,这个元数据放在内存中, 在磁盘上有一个镜像文件,这个镜像文件是fsimage+编号,还有大量的操作日志叫做edits+编号,两个编号都是对应起来的,而且内存里面的元数据都是齐全的,两个namenode只有一个是对客户端服务的,另外一个用来备份,对外服务的状态成为active,备份的是standby,如果有一天active namenode荡机了,standby要接管对外服务,但是它还没有元数据,那么这个问题怎么解决的。

如果active namenode荡机,standby要立马接管,意味着这两个的元数据必须要时刻同步,如果是standby namenode经常性的去active拷贝元数据信息,那么这样对active namenode的压力是很大的,所以首先,一开始格式化的时候,生成一个最初的元数据,先给standby拷贝一份,在运行的过程中,日志不仅在自己的磁盘上,还放在一个 日志存储 系统中,standby定期的去从日志存储系统中拿取日志文件,并且和最初的元数据fsimage进行合并,生成一个新的镜像,如果差下那么一点日志没有合并到,就在这一瞬间,active namenode荡机了,然后standby namenode会从日志存储系统拿取缺少的那一块日志,与原来的元数据进行合并,进行更新,这样状态就和active namenode的状态是一致的,这样就可以很快的接手对外服务。

日志存储系统:

这是个很重要的,这个系统是不能挂掉的,这个系统不是一个单节点,这个系统也是一个集群,里面有很多台机器,这个集群也是基数台,而且每台之间会同步日志,这样一来,日志存储系统的可用性就会很高了,数据同步的算法和zookeeper是一样的,即数据在多个节点之间同步,采用的是paxos算法,多数成立则成立,所以这个日志存储系统最多可以挂掉半数以下的机器,这个系统叫做QJournal,底层的功能依赖zookeeper集群,这两个集群在业务上没关系,只是利用zookeeper,就像hbase依赖zookeeper一样。

但是现在有一个问题,就是active namenode这台机器挂掉之后,standby namenode这台机器是怎么知道的,active namenode 可以在zookeeper上记载东西,然后standby去监听,一旦这个active namenode不见了,那么就说明挂了,这是一种方法。

官方是这么做的,提供了一个额外的程序,叫做zkfc,就是基于zookeeper实现的failover controller,故障控制器,运行在namenode机器上监控namenode的进程并且把监控信息记录在zookeeper中,standby 机器也会运行zkfc,监控自己机器上的进程,也会监听zookeeper里面的另一个zkfc写的东西,一旦发生变化,得到zookeeper的通知,就可以调用方法,将自己的状态从standby切换成active状态,然后开始对外服务,但是问题没有那么简单,有时候JVM会冻结这个namenode,zkfc以为namenode挂掉了,其实只是清理以及维护,但是这样的话,zkfc将将状态提交给zookeeper,然后standby namenode会收到zookeeper的通知,那就切换状态了,这就完了,就将存在两个active namenode,这样系统会错乱。

这里还有一个机制,就是当standby namenode收到通知切换状态的时候,先不着急切换,而是先采取措施确保防止这种系统的紊乱,首先会做两件事。

1.通过SSH远程指令,杀掉active namenode 的进程,但是如果不仅仅是namenode挂了,而是整个机器挂了,那发送的指令

就不会有反应,也不会有反馈信息,

2.那么如果SSH没有响应,则帮用户调用一个用户所指定的脚本,脚本运行成功,则切换状态

做完这两件事,状态就切换成功了,这就是HA高可用集群运行机制。

一、准备工作

1.在四台节点上安装JDK以及Hadoop

2.在node02、node03、node04节点上安装Zookeeper

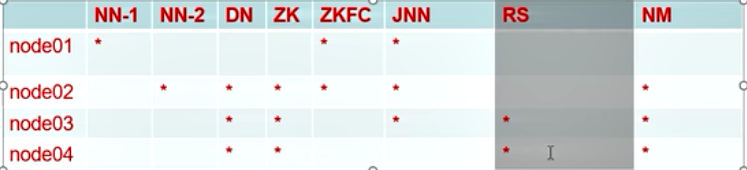

3.节点配置分布如下👇

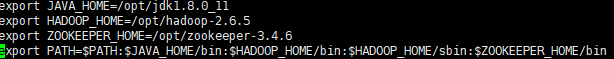

二、配置JDK、Hadoop、以及Zookeeper环境变量

在四台节点上配置好JDK、Hadoop以及ZookeeperZookeeper环境变量并重新加载profile文件

三、配置免密钥

免密钥场景1:

将node01作为管理节点的启动脚本,需要配置node01节点免密钥登录其他三台节点

免密钥场景2:

node01节点发生故障时,需要node02代替node01继续运行,所以需要node02节点免密钥登录node01

1)在node01节点执行以下操作:

ssh-keygen -t dsa -P '' -f /root/.ssh/id_dsa

cd ~/.ssh

scp id_dsa.pub node02:`pwd`/node01.pub

scp id_dsa.pub node03:`pwd`/node01.pub

scp id_dsa.pub node04:`pwd`/node01.pub

2)再到node02执行以下操作:

cd ~/.ssh

cat node01.pub >> authorized_key

3)在node03和node04中重复第二步步骤

4)在node02节点执行以下操作:

ssh-keygen -t dsa -P '' -f /root/.ssh/id_dsa

cd ~/.ssh

cat id_dsa.pub >> authorized_key

三、配置Zookeeper

1.进入Zookeeper目录下得到conf目录,拷贝zoo_sample.cfg文件改名为zoo.cfg

2.vim zoo.cfg 按照下图进行修改

3.在每个zookeeper的DataDIr中添加一个文件myid,里面写一个唯一的数字,用来进行选举时的比较

4.使用命令zkServer.sh start 在node02、node03、node04启动Zookeeper

四、在node01节点配置Hadoop

1.修改 hadoop-env.sh / mapred-env.sh / yarn-env.sh

cd $HADOOP_HOME

cd etc/hadoop

vim hadoop-env.sh

按照下图修改JDK绝对路径

mapred-env.sh 和 yarn-env.sh同理修改文件里的JAVA_HOME

2.修改hdfs-site.xml 根据下图以及自己的节点名称进行修改

-----------------------------------上面的配置文件内容开始---------------------------------------

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.nameservices</name>

<value>mycluster</value>

</property>

<property>

<name>dfs.ha.namenodes.mycluster</name>

<value>nn1,nn2</value>

</property>

<property>

<name>dfs.namenode.rpc-address.mycluster.nn1</name>

<value>node01:8020</value>

</property>

<property>

<name>dfs.namenode.rpc-address.mycluster.nn2</name>

<value>node02:8020</value>

</property>

<property>

<name>dfs.namenode.http-address.mycluster.nn1</name>

<value>node01:50070</value>

</property>

<property>

<name>dfs.namenode.http-address.mycluster.nn2</name>

<value>node02:50070</value>

</property>

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://node01:8485;node02:8485;node03:8485/mycluster</value>

</property>

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/opt/modules/hadoop/ha/jn</value>

</property>

<property>

<name>dfs.client.failover.proxy.provider.mycluster</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<property>

<name>dfs.ha.fencing.methods</name>

<value>sshfence</value>

</property>

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/用户家目录/.ssh/id_rsa</value>

</property>

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

-----------------------------------上面的配置文件内容结束---------------------------------------

3.修改core-site.xml 根据下图以及自己的节点名称进行修改

-------------------------------------------------上面的配置文件内容开始------------------------------------------------------

<property>

<name>fs.defaultFS</name>

<value>hdfs://mycluster:8020</value>

</property>

<property>

<name>ha.zookeeper.quorum</name>

<value>node01,node02,node03</value>

</property>

<property>

<name>hbase.zookeeper.property.clientPort</name>

<value>2181</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/mudoles/hadoop/ha</value>

</property>

-------------------------------------------------上面的配置文件内容结束------------------------------------------------------

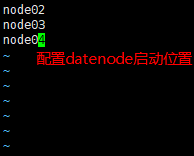

4.修改slaves文件,配置datenode启动的节点

5.拷贝mapred-site.xml.template 改名为 marpred-site.xml ,然后 vim marpred-site.xml ,添加如下配置

-----------------------------------上面的配置文件内容开始---------------------------------------

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.job.ubertask.enable</name>

<value>true</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>node01:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node01:19888</value>

</property>

-----------------------------------上面的配置文件内容结束---------------------------------------

6.vim yarn-site.xml 根据下图及自己节点名称添加如下配置

-----------------------------------上面的配置文件内容开始---------------------------------------

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property>

<property>

<name>yarn.resourcemanager.cluster-id</name>

<value>cluster1</value>

</property>

<property>

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm1</name>

<value>node02</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm2</name>

<value>node03</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address.rm1</name>

<value>node02:8088</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address.rm2</name>

<value>node03:8088</value>

</property>

<property>

<name>yarn.resourcemanager.zk-address</name>

<value>node01:2181,node02:2181,node03:2181</value>

</property>

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 日志保留时间设置7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

-----------------------------------上面的配置文件内容结束---------------------------------------

7.从node01节点拷贝hdfd-site.xml、core-site.xml以及slaves文件到其他三台节点上

scp hdfs-site.xml core-site.xml slaves mapred-site.xml yarn-site.xml node02:`pwd`

scp hdfs-site.xml core-site.xml slaves mapred-site.xml yarn-site.xml node03:`pwd`

scp hdfs-site.xml core-site.xml slaves mapred-site.xml yarn-site.xml node04:`pwd`

五、部署

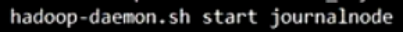

1.在node01、node02、node03分别启动journalnode hadoop-daemon.sh start journalnode

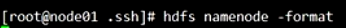

2.在node01格式化 hdfs namenode -format

3. 查看结果,successful表示成功

4.在node01节点启动namenode hadoop-daemon.sh start namenode

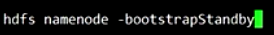

5.在node02节点将namenode同步数据 hdfs namenode -bootstrapStandby

6.在node01节点让zkfc格式化 Zookeeper hdfs zkfc -formatZK

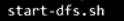

7.启动hdfs!!! start-dfs.sh

8.使用jps查看是否启动成功/或使用 主机名:50070 查看web界面,active表示启动成功!!!

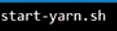

9.启动yarn!!! start-yarn.sh

10.在node03和node04手动启动resourcemanager yarn-daemon.sh start resourcemanager

11.使用jps查看启动的进程

12.在网址输入node03:8088进入yarn web界面,能看到则表示启动成功!

六、项目经验

【1】HDFS存储多目录

1)在hdfs-site.xml文件中配置多目录,最好提前配置好,否则更改目录需要重新启动集群

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///${hadoop.tmp.dir}/dfs/data1,file:///hd2/dfs/data2,file:///hd3/dfs/data3,file:///hd4/dfs/data4</value>

</property>

2)增加磁盘后,保证每个目录数据均衡

开启数据均衡命令:

bin/start-balancer.sh -threshold 10

对于参数10,代表的是集群中各个节点的磁盘空间利用率相差不超过10%,可根据实际情况进行调整

停止数据均衡命令:

bin/stop-balancer.sh

[2】基准测试

1) 测试HDFS写性能

测试内容:向HDFS集群写10个128M的文件

hadoop jar /opt/modules/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-2.7.2-tests.jar TestDFSIO -write -nrFiles 10 -fileSize 128MB

运行完成后查看结果

20/05/02 11:45:23 INFO fs.TestDFSIO: ----- TestDFSIO ----- : write

20/05/02 11:45:23 INFO fs.TestDFSIO: Date & time: Thu May 02 11:45:23 CST 2019

20/05/02 11:45:23 INFO fs.TestDFSIO: Number of files: 10

20/05/02 11:45:23 INFO fs.TestDFSIO: Total MBytes processed: 1280.0

20/05/02 11:45:23 INFO fs.TestDFSIO: Throughput mb/sec: 10.69751115716984

20/05/02 11:45:23 INFO fs.TestDFSIO: Average IO rate mb/sec: 14.91699504852295

20/05/02 11:45:23 INFO fs.TestDFSIO: IO rate std deviation: 11.160882132355928

20/05/02 11:45:23 INFO fs.TestDFSIO: Test exec time sec: 52.315

2)测试HDFS读性能

测试内容:读取HDFS集群10个128M的文件

hadoop jar /opt/modules/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-2.7.2-tests.jar TestDFSIO -read -nrFiles 10 -fileSize 128MB

运行完成后查看结果

20/05/02 11:56:36 INFO fs.TestDFSIO: ----- TestDFSIO ----- : read

20/05/02 11:56:36 INFO fs.TestDFSIO: Date & time: Thu May 02 11:56:36 CST 2019

20/05/02 11:56:36 INFO fs.TestDFSIO: Number of files: 10

20/05/02 11:56:36 INFO fs.TestDFSIO: Total MBytes processed: 1280.0

20/05/02 11:56:36 INFO fs.TestDFSIO: Throughput mb/sec: 16.001000062503905

20/05/02 11:56:36 INFO fs.TestDFSIO: Average IO rate mb/sec: 17.202795028686523

20/05/02 11:56:36 INFO fs.TestDFSIO: IO rate std deviation: 4.881590515873911

20/05/02 11:56:36 INFO fs.TestDFSIO: Test exec time sec: 49.116

20/05/02 11:56:36 INFO fs.TestDFSIO:

3)删除测试生成数据

hadoop jar /opt/modules/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-client-jobclient-2.7.2-tests.jar TestDFSIO -clean

4)使用Sort程序评测MapReduce

(1)使用RandomWriter来产生随机数,每个节点运行10个Map任务,每个Map产生大约1G大小的二进制随机数

hadoop jar /opt/modules/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar randomwriter random-data

(2)执行Sort程序

hadoop jar /opt/modules/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar sort random-data sorted-data

(3)验证数据是否真正排好序了

hadoop jar /opt/modules/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar testmapredsort -sortInput random-data -sortOutput sorted-data

【3】Hadoop参数调优

1)HDFS参数调优hdfs-site.xml

(1)dfs.namenode.handler.count=20 * log2(Cluster Size),比如集群规模为8台时,此参数设置为60

The number of Namenode RPC server threads that listen to requests from clients. If

dfs.namenode.servicerpc-address is not configured then

Namenode RPC server threads listen to requests from all nodes.

NameNode有一个工作线程池,用来处理不同DataNode的并发心跳以及客户端并发

的元数据操作。对于大集群或者有大量客户端的集群来说,通常需要增大参数

dfs.namenode.handler.count的默认值10。

设置该值的一般原则是将其设置为集群大小的自然对数乘以20,即20logN,N为集群大小。

(2)编辑日志存储路径dfs.namenode.edits.dir设置与镜像文件存储路径dfs.namenode.name.dir尽量分开,达到最低写入延迟

2)YARN参数调优yarn-site.xml

(1)情景描述:总共7台机器,每天几亿条数据,数据源->Flume->Kafka->HDFS->Hive

面临问题:数据统计主要用HiveSQL,没有数据倾斜,小文件已经做了合并处理,开启的JVM重用,而且IO没有阻塞,内存用了不到50%。但是还是跑的非常慢,而且数据量洪峰过来时,整个集群都会宕掉。基于这种情况有没有优化方案。

(2)解决办法:

内存利用率不够。这个一般是Yarn的2个配置造成的,单个任务可以申请的最大内存大小,和Hadoop单个节点可用内存大小。调节这两个参数能提高系统内存的利用率。

(a)yarn.nodemanager.resource.memory-mb

表示该节点上YARN可使用的物理内存总量,默认是8192(MB),注意,如果你的节点内存资源不够8GB,则需要调减小这个值,而YARN不会智能的探测节点的物理内存总量。

(b)yarn.scheduler.maximum-allocation-mb

单个任务可申请的最多物理内存量,默认是8192(MB)

3)Hadoop宕机

(1)如果MR造成系统宕机。此时要控制Yarn同时运行的任务数,和每个任务申请的最大内存。调整参数:yarn.scheduler.maximum-allocation-mb(单个任务可申请的最多物理内存量,默认是8192MB)

(2)如果写入文件过量造成NameNode宕机。那么调高Kafka的存储大小,控制从Kafka到HDFS的写入速度。高峰期的时候用Kafka进行缓存,高峰期过去数据同步会自动跟上。

【4】支持LZO压缩

3)将编译好后的hadoop-lzo-0.4.20.jar

放入hadoop-2.7.2/share/hadoop/common/

4)同步hadoop-lzo-0.4.20.jar到其他节点

5)core-site.xml增加配置支持LZO压缩

<property>

<name>io.compression.codecs</name>

<value>

org.apache.hadoop.io.compress.GzipCodec,

org.apache.hadoop.io.compress.DefaultCodec,

org.apache.hadoop.io.compress.BZip2Codec,

org.apache.hadoop.io.compress.SnappyCodec,

com.hadoop.compression.lzo.LzoCodec,

com.hadoop.compression.lzo.LzopCodec

</value>

</property>

<property>

<name>io.compression.codec.lzo.class</name>

<value>com.hadoop.compression.lzo.LzoCodec</value>

</property>

5)同步core-site.xml到其他节点

6)创建 LZO 文件的索引

LZO 压缩文件的可切片特性依赖于其索引,故我们需要手动为LZO 压缩文件创建索引。若无索引,则 LZO 文件的切片只有一个

hadoop jar /path/to/your/hadoop-lzo.jar

com.hadoop.compression.lzo.DistributedLzoIndexer /test/big_file.lzo

937

937

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?