本文的整体流程如下:

- 第一章首先简要介绍一下EM算法的目的是为了求解带有隐变量的参数估计问题,并给出E步和M步的数学形式;

- 第二章证明了EM算法的收敛性;

- 第三章从ELBO+KL散度的角度,对EM算法进行推导,并给出图示以便理解EM的迭代流程;

- 第四章通过对E步的改进,将上述的狭义EM拓展到广义的EM;

- 第五章点明广义EM的本质其实就是坐标上升法,并提到了它的几个变种。

一、概述

假设有如下数据:

X : observed data

Z : latent variable

(X,Z) : complete data

θ \theta θ : parameter

首先我们明确一下为什么需要EM算法?从本质上来说,EM算法的目的是为了学习参数 θ \theta θ,那么MLE也是学习参数 θ \theta θ 的一个方法,为什么还需要引出EM算法呢?

这是因为数据分布 P ( X ) P(X) P(X) 有时候非常复杂,我们没办法直接通过MLE去求得令似然最大的 θ \theta θ,因此引入隐变量 Z,假定 X 是由 Z 产生的,而 Z 的分布是我们自己可以假设的,从而引入归纳偏置,简化了参数的求解。即是说,EM算法解决了概率生成模型/带有隐变量的参数估计问题。

公式表示为:

其中,①即为E步,②即为M步

二、收敛性证明

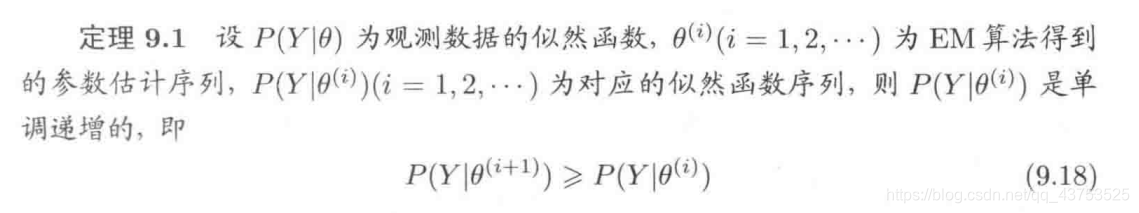

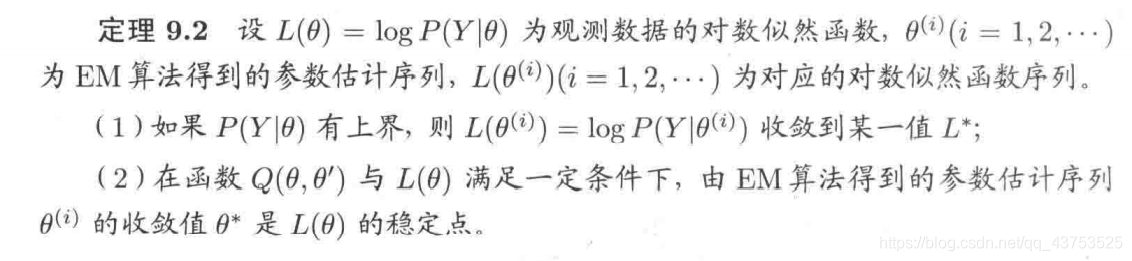

以下两个定理能够保证EM算法的收敛性:

这里主要证明一下定理9.1:

三、算法的导出

这里主要从 ELBO + KL散度的角度进行EM算法的推导:

下图形象解释了E步和M步的流程:

四、广义EM

上述的EM其实是狭义的EM:在E步中,我们令 q ( z ) = P ( z ∣ x , θ ) q(z)=P(z|x,\theta) q(z)=P(z∣x,θ),使得 KL散度为0,但是有时候后验 P ( z ∣ x , θ ) P(z|x,\theta) P(z∣x,θ)是无法求解的,因此我们只能对条件做一点松弛,即由 KL散度等于零 转变为 argmin KL(q||p),相当于argmax ELBO

因此我们将狭义EM推广到了广义的EM,其流程如下:

可以发现,狭义的EM其实只是广义EM的一种特例(当KL散度可以为0的时候),而广义EM其实就是变分推断的起源。

五、EM的推广

5.1 EM的本质

从广义EM我们知道,E步是固定 θ \theta θ求解q,M步是固定q求解 θ \theta θ,这里的思想其实就是坐标上升法。因此,在广义EM中,对E步和M步的顺序其实是没有要求的

5.2 EM的推广

EM更应该说是一种思想,而非某个具体的模型。在广义EM中,我们无法直接求出后验 P ( z ∣ x , θ ) P(z|x,\theta) P(z∣x,θ),因此只能通过变分推断或者MCMC去找到一个尽量接近后验 P ( z ∣ x , θ ) P(z|x,\theta) P(z∣x,θ) 的 q ( z ) q(z) q(z)。因此EM有诸多变种,例如:

- 基于平均场理论的变分推断的EM:VBEM/VEM

- 基于蒙特卡洛的EM:MCEM

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?