问题

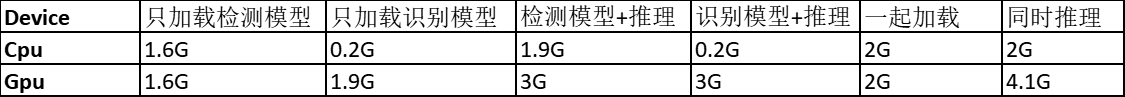

这次做了一个人脸检测加识别的项目,由于开发在服务器上开发,没发现问题,但是当部署到jetson盒子上时发现内存会异常增高。以下是

记录总结

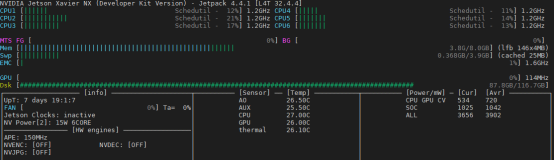

在使用pytorch gpu运行时,会开辟额外的空间,网上有理论说在gpu上pytorch有自己的函数等,所以会异常占用,另外在cpu上检测模型加载时内存也很高的问题,还没有比较合理的解释,不过我在 后面转换为tensorrt之后发现及时只在开头引入了pytorch序列化函数,后面内存也会多占用2个g左右。

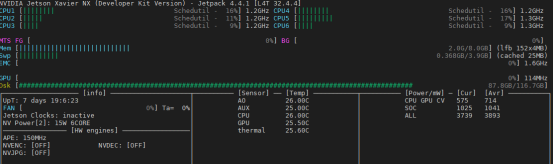

解决办法

坦白说,并没有找到什么解决办法,最好的办法就是不用pytorch,诚然在训练时确实码代码比较方便,但是部署的内存占用确实让人难以接受,另外如果需要实时推理,在硬件功能稍弱的情况下,这个推理速度也是跟不上的。所以建议大家还是转成 tensorrt进行推理。

记录

GPU测试

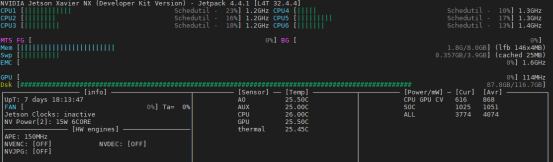

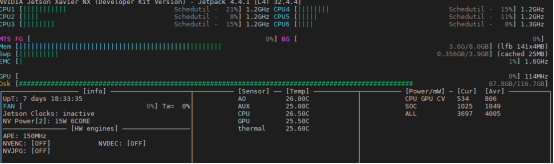

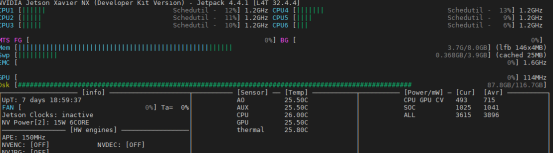

未开始前 内存占用1.8G

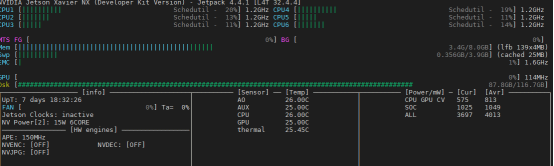

只加载检测模型 占用3.4G(我用的检测模型特别小!)

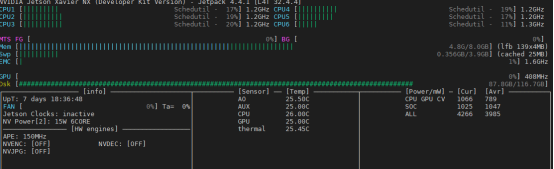

只加载检测模型+推理 占用4.8G

只加载识别模型 占用3.7G

只加载识别模型+推理 占用 4.8G

两个模型一起加载 占用3.8G

两个模型一起加载并推理 占用5.9G

搜索了以下问题,有盆友说是因为在pytorch内部使用了自己的cuda核函数,所以内存会很高,如果使用cpu推理就会小很多,这里也测试了以下cpu下的内存占用。

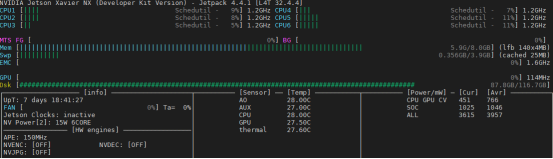

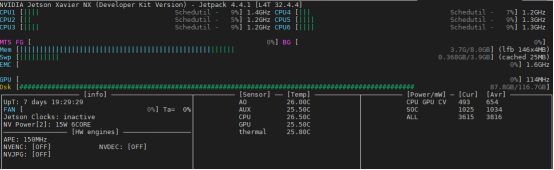

加载检测模型 3.4G

使用cpu 只加载检测模型+推理 3.8G

Cpu只加载识别模型

使用cpu 只加载识别模型+推理 3.7G

Cpu两个加载 3.7G

4555

4555

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?