逻辑斯谛回归(logistic regression)是统计学习中的经典分类方法。最大熵是概率模型学习的一个准则,将其推广到分类问题得到最大熵模型(maximum entropy model)。逻辑斯谛回归模型与最大熵模型都属于对数线性模型。

对数线性模型(Log-linear model)是一种统计模型,通常用于分析离散数据的关系,特别是在分类和回归问题中。这种模型的名称来源于其基本形式,其中自变量的对数与因变量之间的关系是线性的。

对数线性模型通常用于以下两个主要领域:

- 多项式回归分析:在这种情况下,对数线性模型用于建立自变量和多项式回归函数之间的关系。多项式回归函数是一个多项式表达式,其中自变量的幂次可以是任意正整数。通过对这些幂次进行取对数操作,可以将模型转化为对数线性模型,以便更容易估计参数。

- 泊松回归分析:泊松回归是一种对数线性模型,通常用于建模计数数据,如事件发生的次数。在泊松回归中,因变量是计数数据,自变量可以是连续的或离散的,而模型的结果是事件发生的概率或期望次数的对数。

对数线性模型的一般形式如下:

ln ( Y ) = β 0 + β 1 X 1 + β 2 X 2 + … + β p X p \ln(Y) = \beta_0 + \beta_1X_1 + \beta_2X_2 + \ldots + \beta_pX_p ln(Y)=β0+β1X1+β2X2+…+βpXp

其中:

- Y Y Y 是因变量的对数;

- ln \ln ln 是自然对数;

- β 0 , β 1 , … , β p \beta_0, \beta_1, \ldots, \beta_p β0,β1,…,βp 是模型的参数;

- X 1 , X 2 , … , X p X_1, X_2, \ldots, X_p X1,X2,…,Xp 是自变量。

对数线性模型的主要优点之一是,它允许建模非线性关系,同时仍然保持线性模型的一些优点,例如参数的解释性和易于估计。这使得对数线性模型在实际数据分析和统计建模中具有广泛的应用。

本章首先介绍逻辑斯谛回归模型,然后介绍最大熵模型,最后讲述逻辑斯谛回归与最大熵模型的学习算法,包括改进的迭代尺度算法和拟牛顿法。

6.1逻辑斯谛回归模型

6.1.1逻辑斯谛分布

定义6.1(逻辑斯谛分布)设X是连续随机变量,X服从逻辑斯谛分布是指X具有下列分布函数和密度函数

F

(

X

)

=

P

(

X

≤

x

)

=

1

1

+

e

−

(

x

−

μ

)

/

γ

F(X)=P(X≤x)=\frac{1}{1+e^{-(x-\mu)/ \gamma }}

F(X)=P(X≤x)=1+e−(x−μ)/γ1

f

(

X

)

=

F

′

(

x

)

=

e

−

(

x

−

μ

)

/

γ

)

γ

(

1

+

e

−

(

x

−

μ

)

/

γ

)

2

f(X)=F^{'} (x)=\frac{e^{-(x-\mu)/ \gamma }) } {\gamma(1+e^{-(x-\mu)/ \gamma })^2}

f(X)=F′(x)=γ(1+e−(x−μ)/γ)2e−(x−μ)/γ)

式中,

μ

\mu

μ为位置参数,

γ

>

0

\gamma>0

γ>0为形状参数。

逻辑斯谛分布的密度函数f(x)和分布函数如下图所示。分布函数属于逻辑斯谛函数,其图形是一条S形曲线(sigmoid curve)。该曲线以点

(

μ

,

1

2

)

(\mu,\frac{1}{2})

(μ,21)为中心对称,即满足

F

(

−

x

+

μ

)

−

1

2

=

−

F

(

x

+

μ

)

+

1

2

F(-x+\mu)-\frac{1}{2}=-F(x+\mu)+\frac{1}{2}

F(−x+μ)−21=−F(x+μ)+21

曲线在中心附近增长速度较快,在两端增长速度较慢。形状参数

γ

\gamma

γ的值越小,曲线在中心附近增长得越快。

6.1.2二项逻辑斯谛回归模型

二项逻辑回归模型(binomial logistics regression model)是一种分类模型,由条件概率分布P(Y|X)表示,形式为参数化得逻辑斯谛分布。这里,随机变量X取值为实数,随机变量Y取值为1或0。我们通过监督学习的方法来估计模型参数。

定义6.2(逻辑斯谛回归模型)二项逻辑斯谛回归模型是如下的条件概率分布:

P

(

Y

=

1

∣

x

)

=

e

x

p

(

w

⋅

x

+

b

)

1

+

e

x

p

(

w

⋅

x

+

b

)

P(Y=1|x)=\frac{exp(w \cdot x+b)}{1+exp(w \cdot x+b)}

P(Y=1∣x)=1+exp(w⋅x+b)exp(w⋅x+b)

P

(

Y

=

0

∣

x

)

=

1

1

+

e

x

p

(

w

⋅

x

+

b

)

P(Y=0|x)=\frac{1}{1+exp(w \cdot x+b)}

P(Y=0∣x)=1+exp(w⋅x+b)1

这里, x ∈ R n x \in R^n x∈Rn是输入, Y ∈ { 0 , 1 } Y \in\{0,1\} Y∈{0,1}是输出, w ∈ R n w \in R^n w∈Rn和 b ∈ R b \in R b∈R是参数, w w w称为权值向量, b b b称为偏置, w ⋅ x w \cdot x w⋅x为 w w w和 x x x的内积。

对于给定的输入实例x,按照上面两式可以求得 P ( Y = 1 ∣ x ) P(Y=1|x) P(Y=1∣x)和 P ( Y = 0 ∣ x ) P(Y=0|x) P(Y=0∣x)。逻辑斯谛回归比较两个条件概率值的大小,将实例x分到概率值较大的那一类。

有时为了方便,将权值向量和输入向量加以扩充,仍记作w,x,即

w

=

(

w

(

1

)

,

w

(

2

)

,

.

.

.

,

w

(

n

)

,

b

)

T

w=(w^{(1)},w^{(2)},...,w^{(n)},b)^T

w=(w(1),w(2),...,w(n),b)T,

x

=

(

x

(

1

)

,

x

(

2

)

,

.

.

.

,

x

(

n

)

,

1

)

T

x=(x^{(1)},x^{(2)},...,x^{(n)},1)^T

x=(x(1),x(2),...,x(n),1)T。这是,逻辑斯谛回归模型如下:

P

(

Y

=

1

∣

x

)

=

e

x

p

(

w

⋅

x

)

1

+

e

x

p

(

w

⋅

x

)

P(Y=1|x)=\frac{exp(w \cdot x)}{1+exp(w \cdot x)}

P(Y=1∣x)=1+exp(w⋅x)exp(w⋅x)

P

(

Y

=

0

∣

x

)

=

1

1

+

e

x

p

(

w

⋅

x

)

P(Y=0|x)=\frac{1}{1+exp(w \cdot x)}

P(Y=0∣x)=1+exp(w⋅x)1

现在考查逻辑斯谛回归模型的特点。一个事件的几率(odds)是指该事件发生的概率与该事件不发生的概率的比值。如果事件发生的概率是p,那么该事件的几率是

p

1

−

p

\frac{p}{1-p}

1−pp,该事件的对数几率(log odds)或logit函数是

l

o

g

i

t

(

p

)

=

l

o

g

p

1

−

p

logit(p)=log\frac{p}{1-p}

logit(p)=log1−pp

对数几率(log-odds)是指事件发生的概率与不发生的概率之比的自然对数。在统计学和机器学习中,对数几率通常用来描述二元分类问题中的概率关系,特别是在逻辑回归(Logistic Regression)中。

对数几率的公式如下:

logit ( p ) = ln ( p 1 − p ) \text{logit}(p) = \ln\left(\frac{p}{1-p}\right) logit(p)=ln(1−pp)

其中:

- logit ( p ) \text{logit}(p) logit(p) 是事件发生概率 p p p 的对数几率;

- p p p 是事件发生的概率;

- 1 − p 1-p 1−p 是事件不发生的概率。

对数几率的值可以在负无穷到正无穷之间取值,因此它可以描述概率在0到1之间的任何可能取值。

逻辑回归是一种常用的统计方法,用于建立分类模型,通常用于解决二元分类问题。在逻辑回归中,对数几率被建模为自变量的线性函数,然后通过逆变换(即逻辑函数或sigmoid函数)将其映射到0到1之间的概率值。逻辑函数的形式如下:

logit ( p ) = ln ( p 1 − p ) = β 0 + β 1 X 1 + β 2 X 2 + … + β p X p \text{logit}(p) = \ln\left(\frac{p}{1-p}\right) = \beta_0 + \beta_1X_1 + \beta_2X_2 + \ldots + \beta_pX_p logit(p)=ln(1−pp)=β0+β1X1+β2X2+…+βpXp

其中:

- β 0 , β 1 , … , β p \beta_0, \beta_1, \ldots, \beta_p β0,β1,…,βp 是模型的参数;

- X 1 , X 2 , … , X p X_1, X_2, \ldots, X_p X1,X2,…,Xp 是自变量。

逻辑回归模型中的对数几率可以用来估计事件发生的概率,也可以用来进行分类,通常在0.5的阈值上进行分类决策,即如果估计的概率大于0.5,则将样本分类为正类,否则分类为负类。逻辑回归在许多领域中都有广泛的应用,包括医学、社会科学、自然语言处理和机器学习等。

对逻辑斯谛回归而言,由上面式子

P

(

Y

=

1

∣

x

)

=

e

x

p

(

w

⋅

x

)

1

+

e

x

p

(

w

⋅

x

)

P(Y=1|x)=\frac{exp(w \cdot x)}{1+exp(w \cdot x)}

P(Y=1∣x)=1+exp(w⋅x)exp(w⋅x)和

P

(

Y

=

0

∣

x

)

=

1

1

+

e

x

p

(

w

⋅

x

)

P(Y=0|x)=\frac{1}{1+exp(w \cdot x)}

P(Y=0∣x)=1+exp(w⋅x)1可得

l

o

g

P

(

Y

=

1

∣

x

)

1

−

P

(

Y

=

1

∣

x

)

=

w

⋅

x

log\frac{P(Y=1|x)}{1-P(Y=1|x)}=w \cdot x

log1−P(Y=1∣x)P(Y=1∣x)=w⋅x

这就是说,在逻辑斯谛回归模型中,输出Y=1的对数几率是输入x的线性函数。或者说,输出Y=1的对数几率是由输入x的线性函数表示的模型,即逻辑斯谛回归模型。

换一个角度看,考虑对输入x进行分类的线性函数

w

⋅

x

w \cdot x

w⋅x,其值域为实数域。注意,这里

x

∈

R

n

+

1

x \in R^{n+1}

x∈Rn+1,

w

∈

R

n

+

1

w \in R^{n+1}

w∈Rn+1。通过逻辑斯谛回归模型定义式

P

(

Y

=

1

∣

x

)

=

e

x

p

(

w

⋅

x

)

1

+

e

x

p

(

w

⋅

x

)

P(Y=1|x)=\frac{exp(w \cdot x)}{1+exp(w \cdot x)}

P(Y=1∣x)=1+exp(w⋅x)exp(w⋅x)可以将线性函数

w

⋅

x

w \cdot x

w⋅x转换为概率:

P

(

Y

=

1

∣

x

)

=

e

x

p

(

w

⋅

x

)

1

+

e

x

p

(

w

⋅

x

)

P(Y=1|x)=\frac{exp(w \cdot x)}{1+exp(w \cdot x)}

P(Y=1∣x)=1+exp(w⋅x)exp(w⋅x)

这时,线性函数的值越接近正无穷,概率值就越接近1;线性函数的值越接近负无穷,概率值就越接近0(如图6.1所示)。这样的模型就是逻辑斯谛回归模型。

对输入 x 进行分类的线性函数 w ⋅ x w \cdot x w⋅x 是一种数学表示,用于对样本进行二元分类。这里我将详细解释这个概念:

- 输入 x x x: x x x 代表输入的特征向量,通常包含多个特征。每个特征可以看作是一个样本的属性或者描述。例如,在图像分类中, x x x 可能表示图像的像素值;在文本分类中, x x x 可能表示文本的词频向量。 x x x) 是一个 n + 1 n+1 n+1 维向量,其中 n n n 是特征的数量,而额外的一维通常设置为1,用于表示偏置项(bias term),这有助于模型更好地拟合数据。

- 权重 w w w: w w w是与输入特征 x x x 相关联的权重向量,它决定了每个特征在分类决策中的重要性。每个特征都有一个对应的权重。通过调整这些权重,模型学习如何将不同的特征组合以进行分类。

- 线性函数 w ⋅ x w \cdot x w⋅x: w ⋅ x w \cdot x w⋅x 表示权重向量 w w w 和特征向量 x x x 之间的内积(dot product),它是一个实数值。内积是将每个特征与其对应的权重相乘,并将结果相加,从而得到一个线性组合的值。这个线性组合的值将作为输入特征的线性函数。

- 分类决策:线性函数 w ⋅ x w \cdot x w⋅x 的值并不能直接用于分类。为了进行分类决策,通常会将线性函数的输出转化为概率,如前面所提到的逻辑斯谛回归中的方式。通过逻辑斯谛回归或其他类似的方法,将 w ⋅ x w \cdot x w⋅x 映射到一个在0到1之间的概率值,表示样本属于某一类的概率。然后,可以根据这个概率值来进行分类决策,通常使用一个阈值(例如0.5)来判断。

总之, w ⋅ x w \cdot x w⋅x 是一个线性函数,将输入特征 x x x 和权重 w w w 结合起来得到一个实数值,该值经过适当的转换可以用于进行二元分类决策。这种线性分类模型的目标是找到适当的权重 w w w,以最好地分离不同类别的样本。

6.1.3模型参数估计

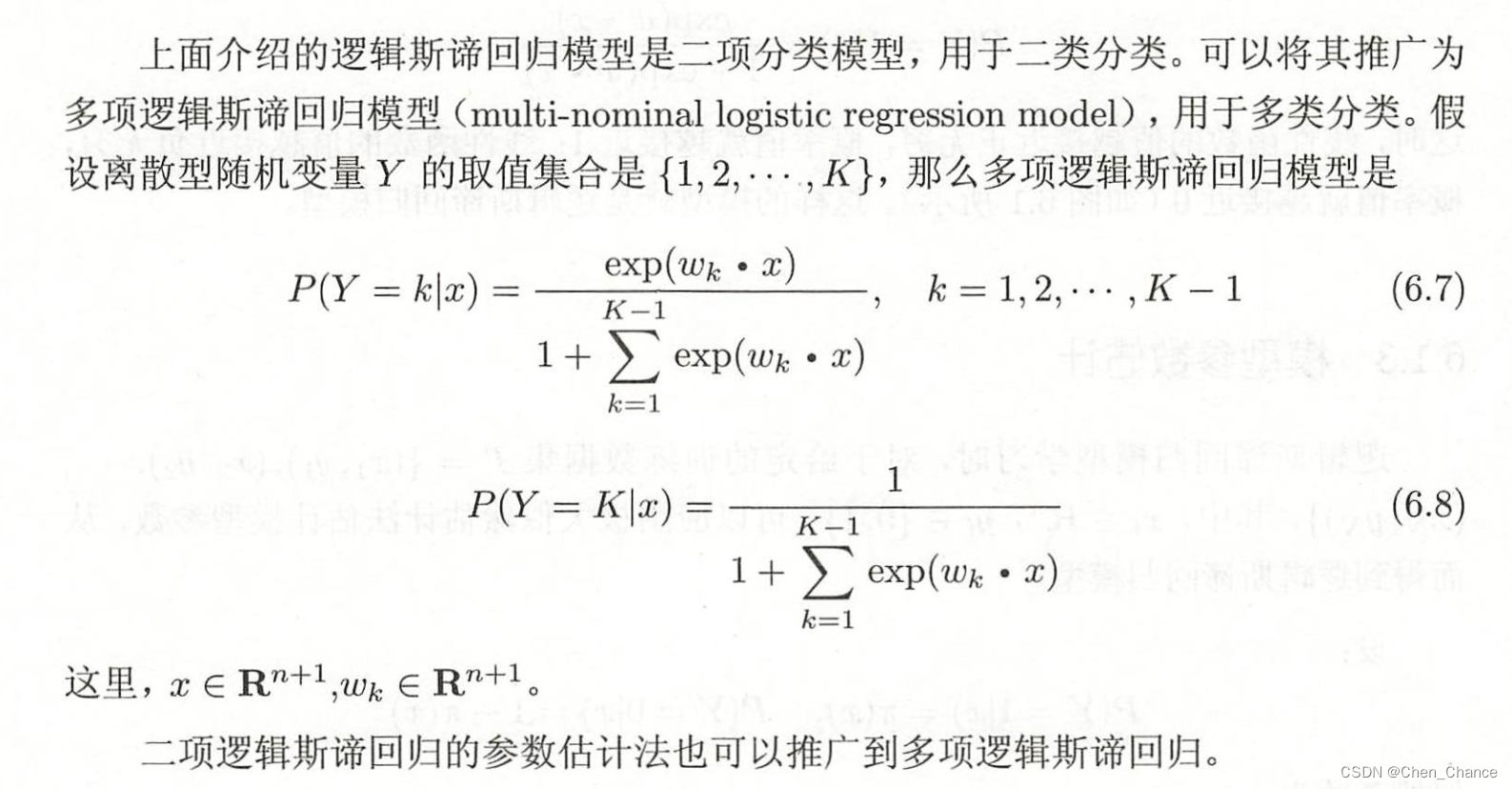

6.1.4多项逻辑斯谛回归

二项逻辑斯谛回归的参数估计法也可以推广到多项逻辑斯谛回归

这句话的意思是二项逻辑斯谛回归的参数估计方法可以扩展到多项逻辑斯谛回归中。

首先,让我们理解二项逻辑斯谛回归和多项逻辑斯谛回归的基本概念:

- 二项逻辑斯谛回归(Binary Logistic Regression):用于解决二元分类问题的统计模型。它通过建立一个线性函数,并将该函数的输出映射到0到1之间的概率值,以确定样本属于哪个类别。通常使用逻辑函数(sigmoid函数)将线性函数的输出映射到概率值上。

- 多项逻辑斯谛回归(Multinomial Logistic Regression):用于解决多元分类问题的统计模型。与二项逻辑斯谛回归不同,多项逻辑斯谛回归可以处理具有多个类别的分类问题。它使用一个与类别数量相关的逻辑斯谛函数来估计每个类别的概率,并最终选择概率最高的类别作为预测结果。

现在,关于那句话的含义:

这句话表明,二项逻辑斯谛回归中使用的参数估计方法,通常是最大似然估计(Maximum Likelihood Estimation,MLE),可以推广到多项逻辑斯谛回归中。也就是说,我们可以使用与二项逻辑斯谛回归相似的统计估计方法来估计多项逻辑斯谛回归中的模型参数。

在实际操作中,估计多项逻辑斯谛回归的参数通常涉及到最大化多项逻辑斯谛分布的似然函数,类似于二项逻辑斯谛回归中最大化伯努利分布的似然函数。虽然在数学细节上存在一些差异,但基本的估计思想仍然是最大化似然函数,找到使观测到的数据在模型下出现的概率最大化的参数值。

总之,这句话强调了参数估计方法在二项逻辑斯谛回归和多项逻辑斯谛回归之间的通用性,使得我们可以应用相似的思想和技术来估计不同类型的分类模型中的参数。

6.2最大熵模型

最大熵模型(maximum entropy model)由最大熵原理推导实现。这里首先叙述一般的最大熵原理,然后讲解最大熵模型的推导,最后给出最大熵模型学习的形式。

最大熵原理、最大熵模型和最大熵模型学习是相关的概念,它们之间有着密切的关系。下面我将解释它们之间的关系:

- 最大熵原理:

最大熵原理是一个信息论中的概念,它是由克劳德·香农(Claude Shannon)提出的。最大熵原理的核心思想是在不失真地表示已知信息的前提下,对未知信息保持最大的不确定性。也就是说,当我们知道一些信息,但对其他信息一无所知时,我们应该选择最均匀(最不偏倚)的概率分布。最大熵原理是一种在不确定性建模中的原则,它强调了信息的均衡性。- 最大熵模型:

最大熵模型是基于最大熵原理构建的概率模型。它是一种用于分类和回归等机器学习任务的模型。最大熵模型的关键思想是,在给定已知约束条件下,选择概率分布,使得熵最大。熵在信息论中表示不确定性或信息量,最大熵模型的目标是在满足已知信息的条件下,使模型对未知信息保持最大的不确定性,从而达到最均衡的概率估计。- 最大熵模型学习的形式:

最大熵模型学习是指通过已知的约束条件,从训练数据中估计模型参数的过程。这个过程可以使用最大熵原理来推导。具体来说,最大熵模型学习的目标是找到一个概率模型,使得在已知的约束条件下,模型的熵最大。这通常涉及到使用拉格朗日乘子法来求解。最大熵原理提供了一种合理的方式来选择概率分布,使其满足已知信息的条件,同时保持最大的不确定性。最大熵模型是将最大熵原理应用于实际问题中的一种方法。最大熵模型学习则是通过优化方法来估计模型参数,以满足已知约束条件,同时最大化熵。

因此,最大熵原理是最大熵模型的理论基础,最大熵模型是最大熵原理在机器学习领域的应用,最大熵模型学习是通过数学方法来实现最大熵模型的参数估计。这些概念共同构成了一个与概率建模和机器学习密切相关的领域。

2437

2437

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?