Scrapy的安装

Anaconda3中安装Scrapy,并在Pycharm中配置环境

#一个小白,想将博客内容作为自己的项目和学习记录,其中会借鉴到很多大佬的经验,也会加上一些自己的理解,希望能给别人带来一点点帮助。此外,要是文章内容在术语上使用不规范的地方,还望各位多多指教

Anaconda3安装后的path路径配置问题

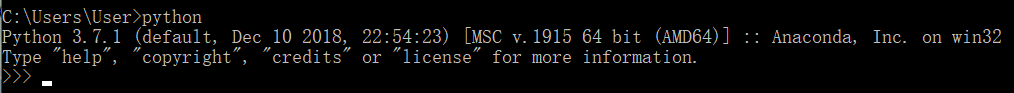

小白最早在电脑上安装Anaconda3是为了写一些Python程序,利用Spyder和Jupyter便得以完成,但是始终没有在cmd中进入Python的交互环境进行操作。直至今日,在测试时才发现,输入Python命令后,并没有运行Python,反而是跳转到应用商店(挠头)。

我的电脑属性–高级系统设置–环境变量 查看发现并未配置环境变量,需要根据Anaconda的安装路径

1.在用户变量path中分别添加:

D:\Anaconda

D:\Anaconda\Scripts

2.在系统变量path中添加:

D:\Anaconda\anaconda;D:\Anaconda\anaconda\Scripts;D:\Anaconda\anaconda\Library\bin

注意:路径中的符号均为英文符号!!!安装完Anaconda后记得及时配置path路径!!!

但是配置完后再次测试发现,仍跳转至应用商店(挠头x2)。查询资料后发现,是因为在用户变量path中,

第一条"%USERPROFILE%\AppData\Local\Microsoft\WindowsApps"在影响,删除后即可。

参考链接

在Anaconda3中下载安装Scrapy框架

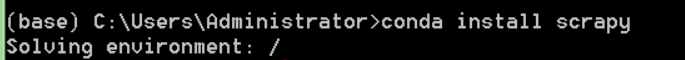

1.在Anaconda Prompt中输入conda install Scrapy

输入命令后其会自动进行环境检查,然后自动下载所需的包

下载成功后,会提示done,并对Scrapy框架的内容给出解释

省去了Anaconda3的安装过程,可以参考链接:Anaconda官网 下载相应版本,安装即可。

在Pycharm中设置Anaconda的Python环境

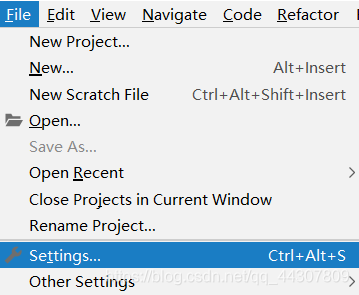

1.运行Pycharm,点击files,选择settings

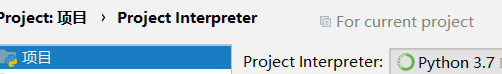

2.选择Project–Project Interpret 选择Anaconda的Python

选中后下滑看所安装的包 发现Scrapy已经安装完成

至此,Anaconda3中下载Scrapy并在Pycharm中配置已全部完成,为后面的爬虫做好了前期准备工作。

2427

2427

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?