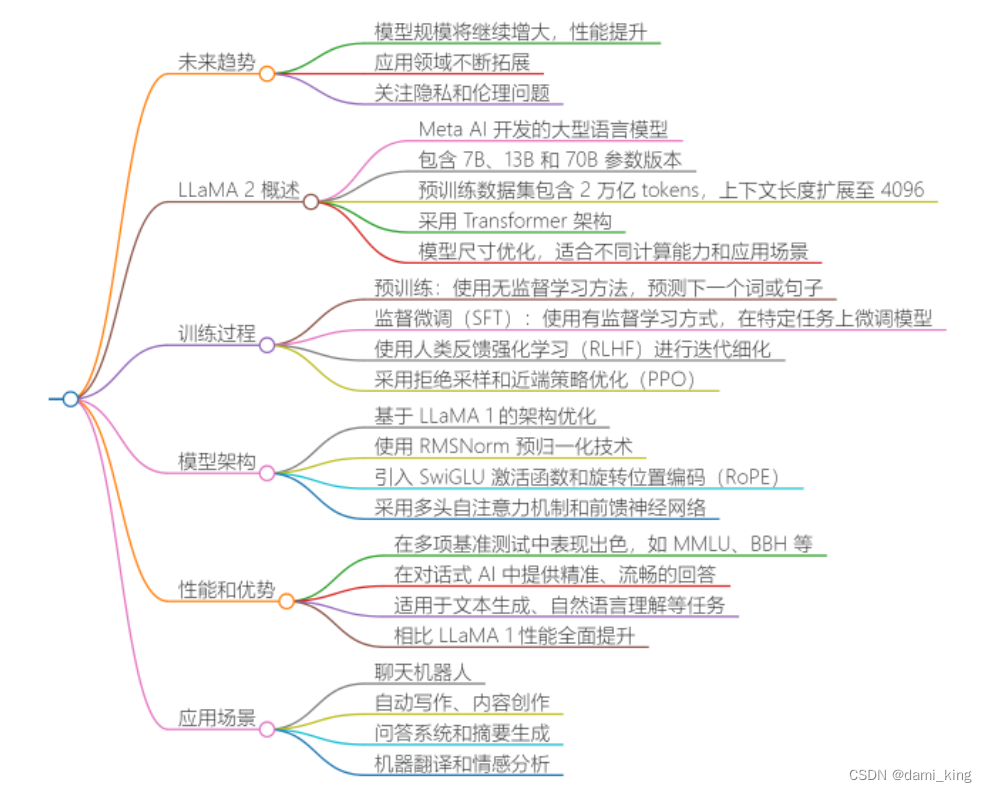

LLaMA 2的原理

LLaMA 2是Meta AI开发的大型语言模型,它基于Transformer架构,采用了自注意力机制来处理输入序列中的长期依赖关系。LLaMA 2的核心原理包括自注意力机制、多头注意力、层归一化和残差连接等,这些技术共同使得模型能够捕捉到输入数据中不同位置单词的关系,从而更好地理解上下文.

LLaMA 2的模型结构

LLaMA 2的模型结构包括编码器和解码器两个模块,其中编码器负责将输入的自然语言文本编码成一系列隐藏表示,解码器则基于编码器生成的隐藏表示,生成相应的输出文本。LLaMA 2在模型架构上进行了优化,包括使用RMSNorm归一化函数、SwiGLU激活函数和旋转位置编码(RoPE)等,这些优化提升了模型的效率和性能.

LLaMA 2的训练方法

LLaMA 2的训练过程包括预训练和微调两个阶段。在预训练阶段,模型使用大规模的无监督学习方法,通过预测给定上下文的下一个单词来学习语言模型。微调阶段则通过有监督学习的方式,在特定任务上的数据集上进行微调,以提高模型在这些任务上的表现。此外,LLaMA 2还采用了人类反馈强化学习(RLHF)来进一步优化模型的性能.

*LLaMA 2-发展应用

深入研究

LLaMA 2的主要改进点是什么?

LLaMA 2是Meta AI团队开发的大型语言模型,它是LLaMA 1的升级版本。与LLaMA 1相比,LLaMA 2在多个方面进行了改进:

-

训练数据和模型规模:LLaMA 2在2万亿个标记上进行训练,相比LLaMA 1的上下文长度增加了一倍,达到4096。此外,LLaMA 2提供了7B、13B和70B三种不同大小的模型版本,以适应不同的需求和资源条件。

-

模型架构:LLaMA 2采用了深度学习的技术,通过大量的文本数据进行训练,从而学会了理解和生成自然语言。其核心在于一个庞大的神经网络,这个网络由数以亿计的神经元连接而成,形成了复杂的计算图。

-

性能提升:LLaMA 2在众多外部基准测试中都优于其他开源的语言模型,包括推理、编程、熟练程度与知识测验。Meta表示,LLaMA 2在包括推理、编码、精通性和知识测试等许多外部基准测试中都优于其他开源语言模型。

-

可访问性:相较于一些封闭的大型语言模型,LLaMA 2提供了更为友好的接口和开源的模型权重,使得更多的研究者和开发者能够轻松地利用这一强大工具进行研究和应用。

-

安全性和实用性:LLaMA 2-Chat模型已使用基于人类反馈的强化学习(RLHF)技术针对对话场景进行了优化。在相当广泛的有用性和安全性测试基准中,LLaMA 2-Chat模型的表现优于大多数开放模型,且其在人类评估中表现出与ChatGPT相当的性能。

LLaMA 2在训练数据、模型规模、模型架构、性能提升、可访问性以及安全性和实用性等方面都有所改进,使其成为一个更加强大和灵活的大型语言模型。

LLaMA 2在训练时使用了哪些数据集和技术?

LLaMA 2的数据集和技术

LLaMA 2是Meta开源的大型语言模型,它在训练时使用了来自公开可用来源的2万亿tokens数据进行预训练。这些数据包括了多种类型的文本,如网络数据、科学文献、社区问答、新闻等。此外,还有一些英文语料,如SlimPajama、RefinedWeb等数据集,用于平衡训练数据分布,避免模型遗忘已有的知识。还有中英文平行语料,用于对齐中英文模型的表示,将英文模型学到的知识快速迁移到中文上。

在技术方面,LLaMA 2采用了Transformer网络结构,这是一种自注意力机制和循环神经网络相结合的深度学习模型。在LlaMA 2中,Transformer的编码器和解码器都由多个相同的层堆叠而成,每一层都包含一个多头自注意力子层和一个前馈神经网络子层。此外,LlaMA 2还采用了残差连接和规范化技术,以提高模型的稳定性和泛化能力。

在训练策略上,LLaMA 2采用了预训练和微调相结合的训练策略。首先,模型在大量文本数据上进行预训练,学习文本的内在规律和表示。然后,针对特定的任务和数据集进行微调,使得模型能够更好地适应特定场景。优化器方面,LLaMA 2采用了Adam优化器,这是一种自适应学习率的优化算法。通过调整学习率,Adam优化器可以更好地平衡模型参数的更新和收敛速度。

在模型压缩方面,为了减小模型的大小和提高推理速度,可以对LlaMA 2进行模型压缩。常见的压缩方法包括剪枝、量化、知识蒸馏等。通过去除冗余的模型参数和降低模型精度,可以显著减小模型大小并提高推理速度。

在硬件加速方面,为了提高训练和推理速度,可以利用GPU或TPU等硬件加速器对LlaMA 2进行加速。通过将计算任务卸载到硬件加速器上,可以显著提高计算效率并减少训练和推理时间。

在混合精度训练方面,混合精度训练是一种将单精度浮点数(FP32)和半精度浮点数(FP16)相结合的训练方法。通过使用半精度浮点数代替单精度浮点数进行计算,可以减少内存占用和提高计算速度。同时,为了保证计算的精度和稳定性,可以在关键的网络层或操作中使用单精度浮点数进行计算。

LLaMA 2相比于其他大语言模型有哪些优势?

LLaMA 2是Meta AI公司推出的大型语言模型,相比于其他大语言模型,它具有以下几个显著优势:

-

开源性:LLaMA 2是一个开源模型,这意味着研究者和开发者可以自由地查看、修改和分发模型,促进了模型的广泛应用和社区的发展。

-

高性能:LLaMA 2在多项自然语言处理任务中表现出色,其性能甚至超越了一些知名的闭源模型,如GPT-3。

-

灵活性:LLaMA 2提供了多种不同参数规模的模型,以适应不同的应用场景和计算资源需求。

-

多语言支持:LLaMA 2支持多种语言的处理和生成,适应全球用户的需求。

-

微调特性:LLaMA 2支持微调,使得模型能够更好地适应特定的应用场景和任务需求。

-

计算效率:LLaMA 2采用了一系列优化技术,如梯度累积、混合精度训练和分布式训练,提高了模型的训练和推理效率。

-

应用广泛:LLaMA 2可以应用于对话系统、内容生成、翻译、数据分析等多个领域,具有广泛的实用性。

LLaMA 2凭借其开源性、高性能、灵活性、多语言支持、微调特性、计算效率和广泛的应用场景,成为了自然语言处理领域的一个重要竞争者。

917

917

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?