Linux系统从零搭建本地大模型

搭建本地大模型教程

1.下载源码和模型并存到到指定文件夹

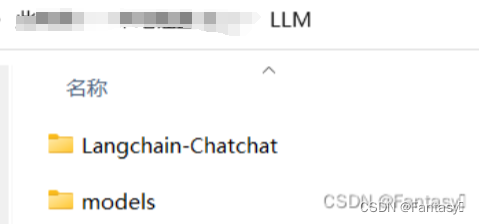

1.1 创建文件夹存放源码和模型

创建一个LLM文件夹,用来存放源码和模型。

1.2 下载源码和模型(建议模型直接拷贝,因为服务器不稳定)

1)如果在终端中下载时,可以使用下列语句

模型下载:

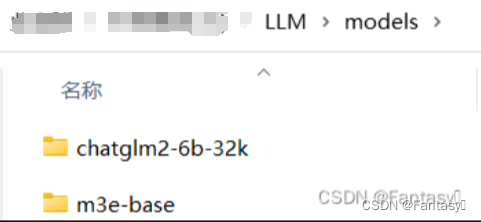

git clone https://huggingface.co/THUDM/chatglm2-6b-32k

git clone https://huggingface.co/moka-ai/m3e-base

源码下载:

git clone https://github.com/chatchat-space/Langchain-Chatchat.git;

(源码需要放到刚才创建的LLM文件夹,模型需要放到LLM的models文件夹内,最终效果如下图表示)

2.创建anaconda环境

2.1 安装anaconda

参照以下文章链接进行安装配置:

https://blog.csdn.net/ShenSeKyun/article/details/128346584

2.2 创建虚拟环境

1)打开终端,输入以下命令,创建虚拟环境(LLM为环境名称,python版本建议3.8以上)

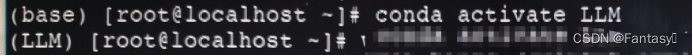

conda create -n LLM python=3.10

然后输入 yes 确认创建,成功之后输入以下命令激活虚拟环境

conda activate LLM

终端前方(base)变为(LLM)即表示激活成功。

3.安装依赖包

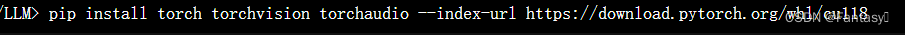

3.1 安装torch

1)在LLM目录下使用下面命令安装torch:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

也可以切换清华源(https://pypi.tuna.tsinghua.edu.cn/simple)

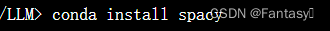

3.2 安装spacy库

1)在LLM目录下使用 conda install spacy 命令安装spacy库

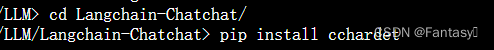

3.3 安装cchardet库

1)进入Langchain-Chatchat目录下使用pip install cchardet安装cchardet库

3.4 安装accelerate库

1)在Langchain-Chatchat目录下使用pip install accelerate安装accelerate库

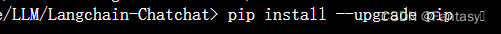

3.5 更新pip

1)在Langchain-Chatchat目录下使用pip install --upgrade pip更新pip

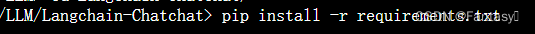

3.6 下载一大堆包

1)在Langchain-Chatchat目录下使用pip install -r requirements.txt下载源码依赖库,这个下载的包很多,需要一点时间,不要着急。(requirements.txt文件里面都是项目所依赖的包以及版本)

4.修改配置

4.1 修改文件

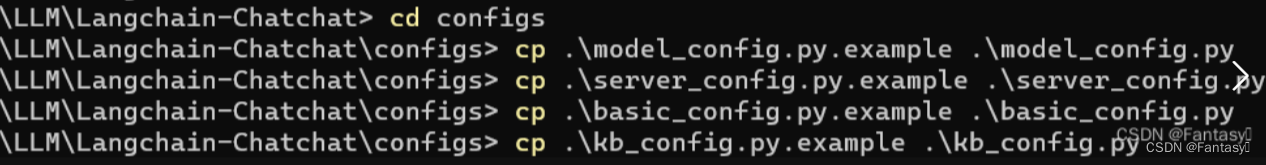

1)进入cofigs目录下,使用命令行模式修改文件

cp .\model_config.py.example .\model_config.py

cp .\server_config.py.example .\server_config.py

cp .\basic_config.py.example .\basic_config.py

cp .\kb_config.py.exmaple .\kb_config.py

cp .\prompt_config.py.example .\prompt_config.py

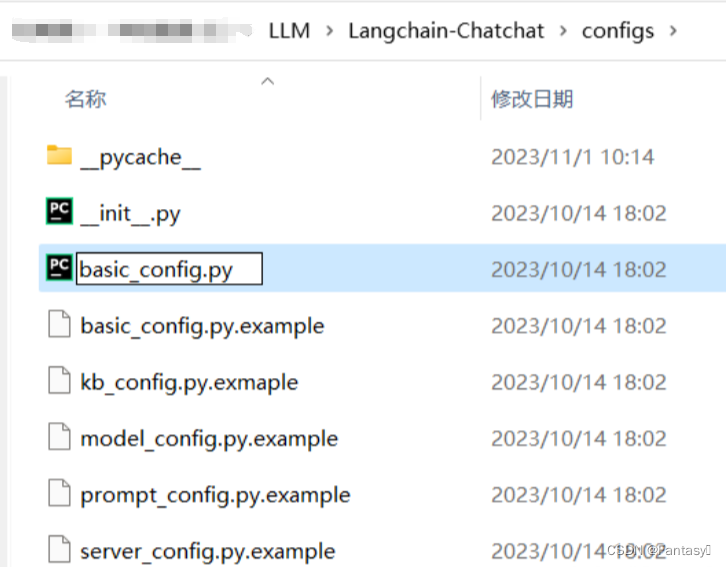

2)直接用鼠标打开文件夹,复制粘贴重命名(用“1步骤”就无需使用此步骤,跳过该步骤)。

(PS:下图以window的目录展示,Linux相同)

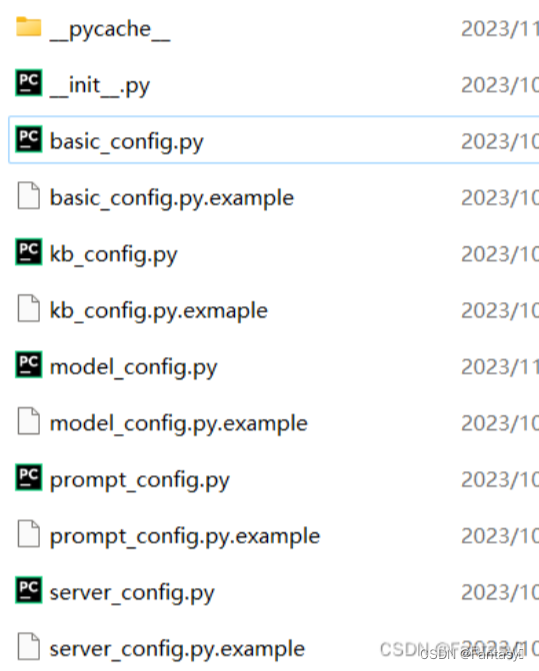

最终效果如下:

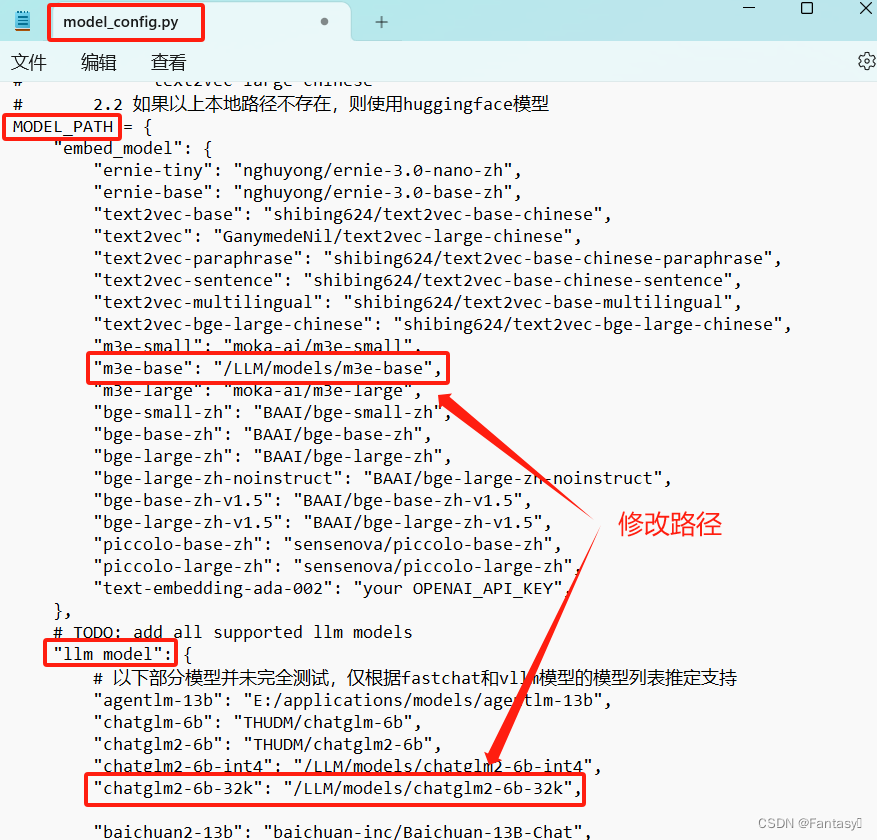

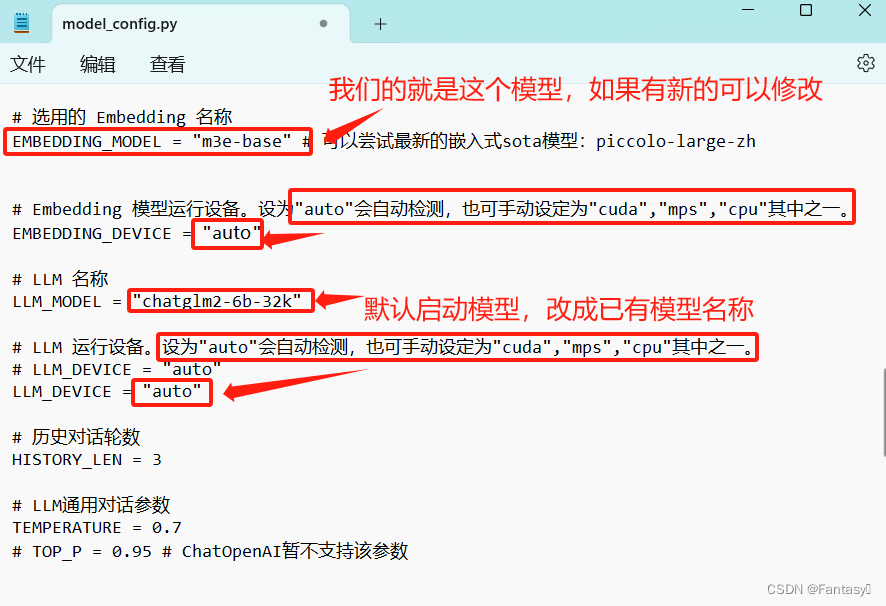

4.2 修改模型路径

1)鼠标打开Langchain-Chatchat目录中configs目录下的model_config.py文件或者使用vim打开,将m3e-base和chatglm2-6b-32k的路径修改为我们存放模型的位置。(我的是/LLM/models/m3e-base和/LLM/models/chatglm2-6b-32k,具体位置根据自己存放为主)

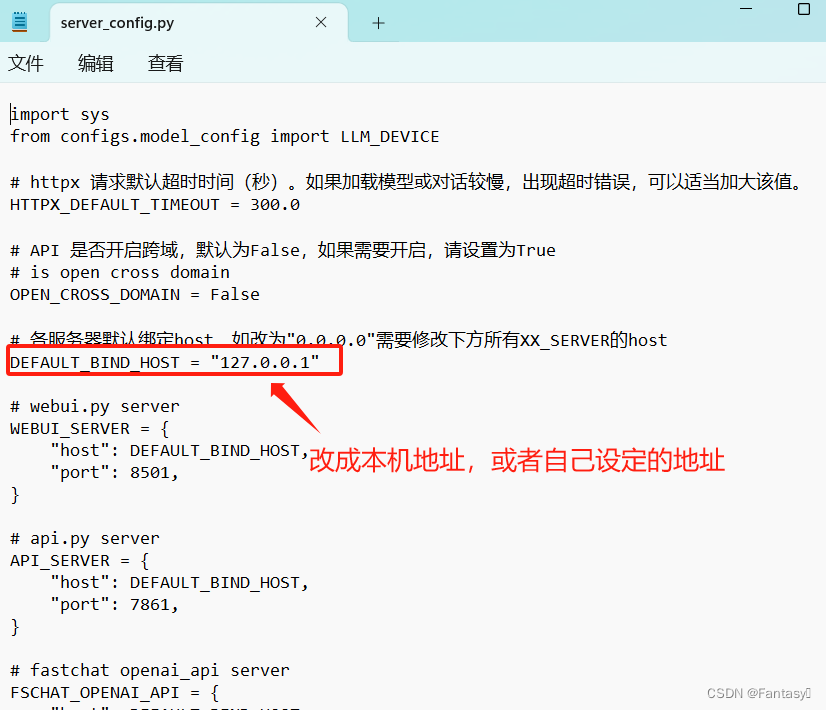

4.3 修改端口

1)鼠标打开Langchain-Chatchat目录中configs目录下的server_config,py文件修改服务地址

5.启动模型

5.1 本次启动

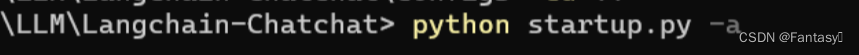

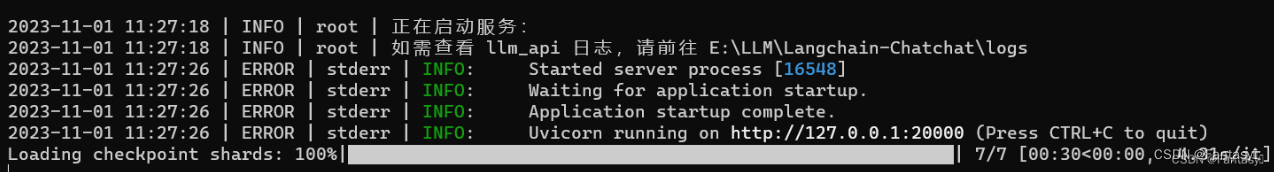

1)在Langchain-Chatchat目录下使用python startup.py -a或者python startup.py --all-webui启动模型。如下图:

5.2 模型启动完整步骤

1)先输入 conda activate LLM 激活虚拟环境

2)再进入 Langchain-Chatchat 目录

3)在 Langchain-Chatchat 目录下,输入 python startup.py -a 或者 python startup.py --all-webui 启动模型即可

5805

5805

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?